語義分割--PANet和Understanding Convolution for Semantic Segmentation

語義分割

PAN Pyramid Attention Network for Semantic Segmentation

FCN作為backbone的結構對小型目標預測不佳,論文認為這存在兩個挑戰。

- 物體因為多尺度的原因,造成難以分類。針對這個問題,PSPNet和DeepLab引入了PSP和ASPP模組引入多尺度資訊。論文引入了畫素級注意力用於幫助提取精準的high-level 特徵。

- **high-level的特徵偏向於對類別分類,缺乏空間資訊.**針對這個問題,常見的操作是採用U-shape結構網路,例如SegNet、Refinenet等。使用low-level幫助high-level恢復圖片細節。然後這些都是很耗時的,論文提出了有效的decoder結構,稱之為Global Attention Upsample(GAU),可以提取high-level的全域性上下文用於對low-level資訊加權。

Contributuions

- 提出了Feature Pyramid Attention module(FPA)將不同尺度上下文特徵嵌入到現存的FCN結構上

- 提出了Global Attention Upsample(GAU),一個有效的decoder模組

- 基於FPA和GAU,提出了Pyramid Attention Network(PAN)網路,在VOC2012 and cityscapes上獲得了先進表現

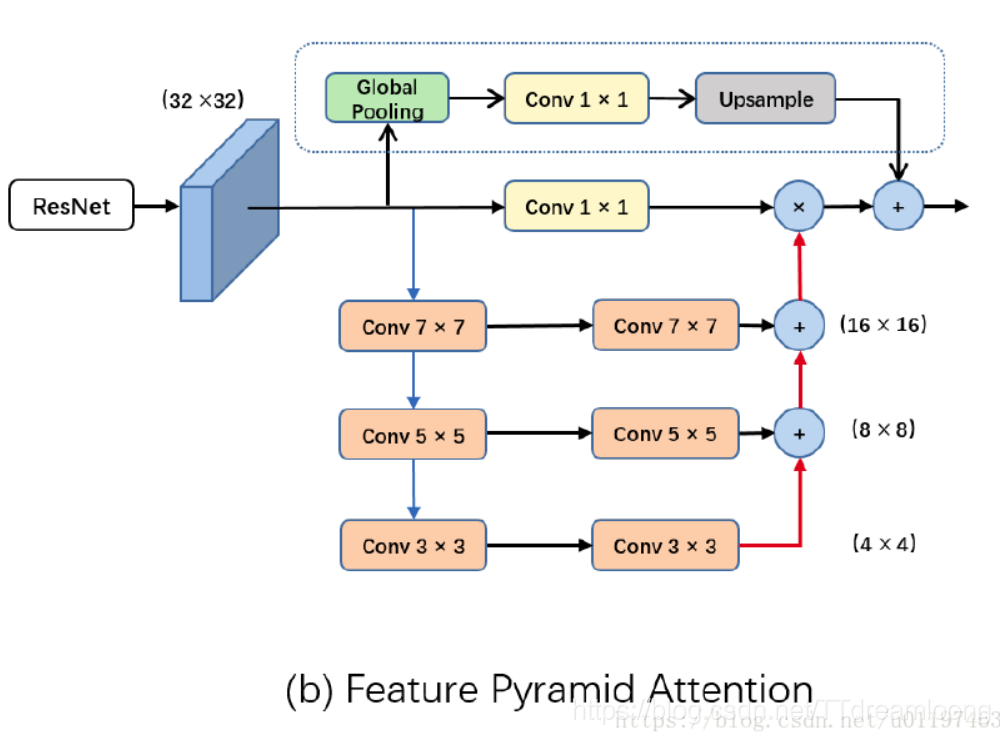

Feature Pyramid Attention

PSPNet和DeepLab使用的PSP或ASPP結構結構如下:

PSPNet使用池化操作會有空間資訊上的損失。DeepLab使用擴張卷積會存在缺少區域性資訊和”griding”(卷積核退化)現象。

受到注意力機制的啟發,論文認為可使用注意力機制,將全域性上下文資訊作為先驗知識引入到通道選擇。但是僅僅有通道注意力機制是不夠的,這依舊缺乏逐畫素資訊。論文提出了FPA模組,該模組融合了多尺度資訊,以3×3,5×5,7×7三個卷積做金字塔結構,因為high-level的特徵解析度較小,故使用大的卷積核帶來的計算負擔不會太多。同時論文引入了全域性池化分支用於進一步提升效能。如圖所示:

得益於金字塔結構,FPA可以融合多尺度資訊,產生更佳的畫素級注意力應用於high-level特徵。不同於PSPNet或ASPP需要做通道降維,論文的做法是上下文資訊與原始的特徵做逐畫素乘。

Global Attention Upsample

現存的decoder結構上,如PSPNet和Deeplab都是直接雙線性差值上取樣得到預測結果,這可以看成是一個naive decoder。

DUC使用了多通道做reshape操作得到預測結果。這兩類都缺乏多尺度資訊,難以恢復空間資訊。常見的encoder-decoder架構主要考慮使用使用多尺度資訊逐步恢復邊界,但是這些結構都較為複雜,帶了較大的計算消耗。

因為high-level中有著豐富的語義資訊,這可以幫助引導low-level的選擇,從而達到選擇更為精準的解析度資訊。論文提出了GAU結構,通過全域性池化提供的全域性資訊作為指引選擇low-level特徵。其結構如下:

具體來講,使用3×3卷積用於對低階特徵做通道處理,然後使用全域性池化後的資訊做加權,得到加權後的low-level特徵,再上取樣,然後再與high-level資訊相加。

Network Architecture

基於PFA和GAU, 論文提出了完整的PAN架構.

使用帶有擴張卷積策略的Resnet101作為backbone,res5b使用dialted rate=2,最初的7×7卷積換成了3個3×3卷積。使用FPA模組去獲取密集的畫素級注意力資訊,結合全域性上下文,通過GAU模組最終產生了預測圖。

本文來自 DFann 的CSDN 部落格 ,全文地址請點選:https://blog.csdn.net/u011974639/article/details/82222866?utm_source=copy

Understanding Convolution for Semantic Segmentation

Abstract

本文介紹了兩種操控捲積相關運算(convolution-related operations)方法用於提高語義分割效果:

- 設計密集上取樣卷積(dense upsampling convolution,DUC)生成預測結果,這可以捕獲在雙線性上取樣過程中丟失的細節資訊。

- 設計混合空洞卷積框架(hybrid dilated convolution,HDC),用於減輕擴張卷積產生的”gidding issue”影響,擴大接收野聚合全域性資訊。

Introduction

大部分應用在語義分割任務上的CNN系統可分為三類:

- **全卷積神經網路。**例如FCN. 使用卷積層代替FC層,提高訓練和推斷效率,並可接收任意大小輸入;

- 使用CRF. 結構預測用於捕獲圖片內的本地和長距離依賴,用於細化分割結果;

- **使用空洞卷積。**增加中間featue map的解析度,可在保持相同計算成本的同時提高預測精度。

大部分提高預測準確率的系統可分為兩類:

- **使用更優秀的特徵提取模型。**即使用VGG16、ResNet等預訓練架構。這些更深的模型可對更復雜的資訊建模,學習更有區分力的feature並可更好的區分類別。

- **使用CRF作為後端處理,**整合CRF到模型內構成end2end訓練,並將額外的資訊例如邊緣合併到CRF內。

本文以另一個角度來提升效能,考慮到現在大多數模型分為encoding和decoding兩部分:

- 對於decoding:大多數模型在最終預測圖的基礎上,採用雙線性插值上取樣直接獲得與輸入同分辨率的輸出,雙線性插值沒有學習能力並且會丟失細節。本文提出了密集上取樣卷積(dense upsampling convolution,DUC),取代了簡單的雙線性插值,學習一組上取樣濾波器用於放大低解析度的feature。DUC支援end2end,便於融入FCN網路架構中。

- 對於encoding:使用擴張卷積可以擴大感受野,減少使用下采樣(下采樣丟失細節比較嚴重)。本文指出空洞卷積存在”girdding”問題(卷積核退化),即空洞卷積在卷積核兩個取樣畫素之間插入0值,如果擴張率過大,卷積會過於稀疏,捕獲資訊能力差。 本文提出了混合擴展卷積架構(hybrid dilation convolution,HDC): 使用一組擴充套件率卷積串接一下構成block,可擴大感受野的同時減輕”gridding”弊端。

從另一個角度想:DUC將整個label map(H,W,L)分為為d^2個等大小的子圖(subparts),每個子圖和大小和Fout輸出的feature map大小相同。也就是說將label map切分為(h,w,d2×L).

模型的整體結構如下,DUC應用在輸出部分:

DUC以原始解析度畫素級解碼,並且能夠自然的整合到FCN框架中,使得整個編碼和解碼能以end2end方式訓練。

作者:DFann

來源:CSDN

原文:https://blog.csdn.net/u011974639/article/details/79460893?utm_source=copy

版權宣告:本文為博主原創文章,轉載請附上博文連結!