scrapyd部署爬蟲遇到的問題

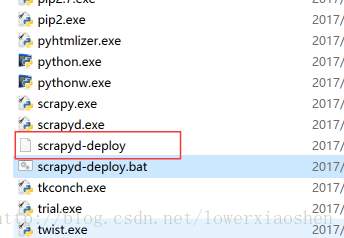

1.windows下 scrapyd-deploy無後綴檔案不能啟動:

執行命令pip install scrapy-client,安裝完成後,在虛擬環境的scripts中會出現scrapyd-deploy無後綴檔案,這個scrapyd-deploy無後綴檔案是啟動檔案,在Linux系統下可以執行,在windows下是不能執行的,所以我們需要編輯一下使其在windows可以執行。

新建一個scrapyd-deploy.bat檔案,右鍵選擇編輯,輸入以下配置,注意:兩個路徑之間是空格

@echo off

“E:\Envs\py2Scrapy\Scripts\python.exe” “E:\Envs\py2Scrapy\Scripts\scrapyd-deploy” %*

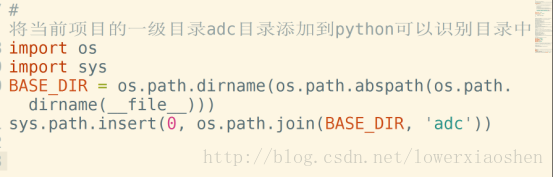

2.執行 scrapy list 命令的時候出現錯誤

執行 scrapy list 命令的時候很有可能出現錯誤,如果是python無法找到scrapy專案,需要在scrapy專案裡的settings.py配置檔案裡設定成python可識別路徑

將當前專案的一級目錄TotalSpider目錄新增到python可以識別目錄中

BASE_DIR = os.path.dirname(os.path.abspath(os.path.dirname(__file__)))

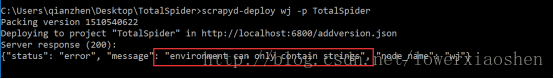

sys.path.insert(0, os.path.join(BASE_DIR, “TotalSpider”))3.遠端計算機拒絕

如果錯誤提示,什麼遠端計算機拒絕,說明你的scrapy專案有連結遠端計算機,如連結資料庫或者elasticsearch(搜尋引擎)之類的,需要先將連結伺服器啟動

4.windows下打包失敗

不用管,多提交幾次,直到你的egg資料夾中有專案即可。然後重啟服務,就可以去開啟爬蟲。

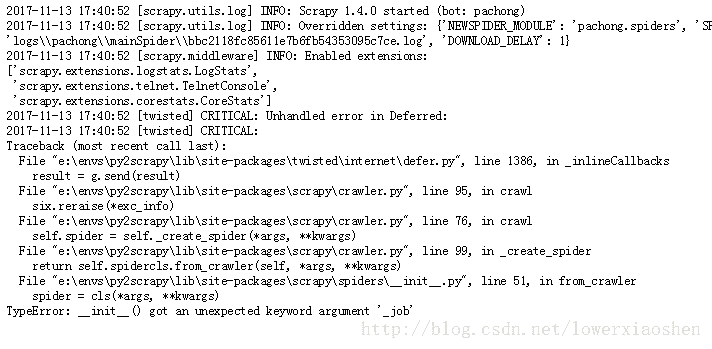

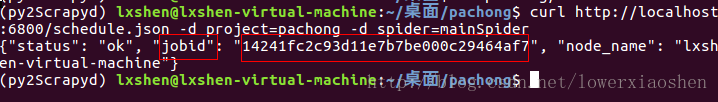

5.啟動爬蟲後出現TypeError‘_job’錯誤

這是因為在用scrapyd啟動爬蟲是,會向爬蟲類中傳入一個關鍵字引數

{‘_job’: ‘14241fc2c93d11e7b7be000c29464af7’}

在啟動的時候生成有一個jobid的,而傳進去的就是這個

爬蟲類新增

def 另外,需新增str函式,否則也會報錯

def __str__(self):

return “ProductSpider” 相關推薦

Scrapyd部署爬蟲檔案

Scrapyd部署爬蟲專案 1、開啟命令列工具執行“pip install scrapyd” 2、安裝成功啟動scrapyd服務 3、瀏覽器輸入127.0.0.1:6800即可檢視 4、連線成功後在非c盤目錄下新建一個資料夾,shift加右鍵開啟命令列工具,輸入scra

win10如何使用scrapyd部署爬蟲

win10如何使用scrapyd部署爬蟲 官方文件:http://scrapyd.readthedocs.io/en/stable/ scrapy爬蟲寫好後,一般需要用命令列執行。scrapyd部署能夠在網頁端檢視正在執行的任務,也能新建爬蟲任務,和終止爬蟲任務。優點:

scrapyd部署爬蟲專案

功能:它就相當於是一個伺服器,用於將自己本地的爬蟲程式碼,打包上傳到伺服器上,讓這個爬蟲在伺服器上執行,可以實現對爬蟲的遠端管理。(遠端啟動爬蟲,遠端關閉爬蟲,遠端檢視爬蟲的一些日誌。) 1.服務端Scrapd的安裝:Pip install scrapyd(版本

ubuntu下scrapyd部署爬蟲專案

scrapyd部署爬蟲的優勢: 1、方便監控爬蟲的實時執行狀態,也可以通過介面呼叫開發自己的監控爬蟲的頁面 2、方便統一管理,可以同時啟動或關閉多個爬蟲 3、擁有版本控制,如果爬蟲出現了不可逆的錯誤,可以通過介面恢復到之前的任意版本 注意:在安裝scrapyd之前要確保你的環境能夠執行scrapy(無論整合

如何使用scrapyd部署爬蟲專案

功能:相當於一個伺服器,用於將自己本地的爬蟲程式碼,打包上傳到伺服器上,讓這個爬蟲在伺服器上執行,可以實現對爬蟲的遠端管理。(遠端啟動爬蟲、關閉爬蟲、檢視爬蟲的一些日誌) 1.scrapyd的安裝:在cmd中,輸入指令 :pip install scrapyd

python之Scrapyd部署爬蟲專案(虛擬環境)

1、新建虛擬環境(方便管理),在虛擬環境中安裝scrapy專案需要使用到的包 進入虛擬環境使用pip將所需包安裝完成 2、開啟命令列工具執行pip install scrapyd 3、輸入scrapyd啟動scrapyd服務,在瀏覽器輸入127.0.0

scrapyd部署爬蟲專案所需配置

scrapyd部署爬蟲專案 1,安裝scrapy包 pip install scrapyd 在終端輸入scrapyd 檢視是否成功 所在埠為6800即為成功(建議不要將這個關掉,後面需要這個服務,關掉會連線不到主機) 在瀏覽器上輸入127.0

詳述Scrapyd部署爬蟲專案

Scrapyd部署爬蟲專案 部落格目的: 本部落格介紹瞭如何安裝和配置Scrapyd,以部署和執行Scrapy spider。 Scrapyd簡介 : Scrapyd是一個部署和執行Scrapy spide

scrapyd部署爬蟲遇到的問題

1.windows下 scrapyd-deploy無後綴檔案不能啟動: 執行命令pip install scrapy-client,安裝完成後,在虛擬環境的scripts中會出現scrapyd-deploy無後綴檔案,這個scrapyd-deploy無後綴檔案

基於Python的-scrapyd部署爬蟲流程

1. 開啟命令視窗,新建一個虛擬環境:Mkvirtualenv --python=D:\python36\python.exe 虛擬環境名2. 安裝scrapy專案中所需要的包:例如pip install scrapy如果缺少win32 要進行pip install pywi

scrapyd 部署爬蟲專案

1.cmd進入虛擬環境下載scrapyd,即pip install scrapyd,安裝完成後輸入scrapyd,啟動scrapyd服務 在瀏覽器輸入127.0.0.1:6800 即可檢視 2. 如果連線成功先關閉服務,自己在非C盤下新建一個資料夾,名稱自定義如:sc

scrapyd部署分散式爬蟲

1.首先我們需要安裝scrapyd這個模組,安裝命令:pip install scaprd 2.然後啟動scrapyd,通過瀏覽器開啟127.0.0.1:6800 這個網址,有以下介面即可: 3.如果連線成功,那你可以關閉scrapyd了,在非C盤裡面建立一個資料夾,

python分散式爬蟲scrapyd部署以及gerapy的使用流程

新建虛擬環境(方便管理),也可以直接執行第一步。注意:windows系統和虛擬環境要分清,進入指定的環境下進行操作,否則會出現錯誤 1、開啟命令列工具執行pip install scrapyd 2、 等待安裝完成 , 輸入scrapyd啟動s

scrapyd部署(遠端管理爬蟲專案)

1. 需要安裝scrapyd=1.2.0 scrapyd-client=1.2.0a1 首先進入虛擬環境 2. 啟動scrapyd服務 3. 配置爬蟲專案: 4.開始向scrapyd中部署 檢視當前可用於部署到scrapyd 服務

scrapyd分散式爬蟲部署

需要安裝scrapyd=1.2.0 scrapy-client=1.2.0a1 啟動scrapyd服務 配置爬蟲專案 開始向scrapyd中部署專案 通過scrapyd-deploy命令測試scrapyd-deploy是否可用。 檢視當前可用於部署到scr

使用selenium+谷歌瀏覽器在centeos7無GUI部署爬蟲cookie更新

highlight 防止 為我 tab info mys 關於 配置 root 環境安裝 python3 安裝selenium pip3 install selenium 安裝chrome瀏覽器+chromedriver驅動 一.配置yum源 1.在目

mac 系統編寫的 scpayd部署爬蟲 sh指令碼 伺服器上報錯:syntax error: unexpected end of file / no active project\n\nUnknown

一. 報錯描述 sh指令碼: sh指令碼報錯: 報錯一: no active project\n\nUnknown (scrapy_env) [[email protected] FFF]$ sh run_base.sh run_base.sh: line 2: $

jenkins 自動打包部署爬蟲專案

最近因工作需要,負責看護公司的生產環境,有16臺生產服務節點,所以必須得引入自動化管理工具,不然我可不得累死啊。本文記錄一下在使用Jenkins釋出過程的整個過程。 1.啟動Jenkins服務 2.登陸網頁 3.配置

scrapy入門教程()部署爬蟲專案

scrapyd部署爬蟲專案 1、scrapyd介紹 它就相當於是一個伺服器,用於將自己本地的爬蟲程式碼,打包上傳到伺服器上,讓這個爬蟲在伺服器上執行,可以實現對爬蟲的遠端管理(遠端啟動爬蟲,遠端關閉爬蟲,遠端檢視爬蟲的一些日誌等)。 2、scrapyd安裝

部署爬蟲

安裝scrapyd: pip install scrapyd 安裝scrapyd-client : pip install scrapyd-client 安裝curl:[安裝地址](http://ono60m7tl.bkt.clouddn.com/curl.exe),安裝完