1*1卷積層的作用

Ref:

https://www.zhihu.com/question/56024942

http://m.blog.csdn.net/chaipp0607/article/details/60868689

1*1卷積的主要作用有以下幾點:

1、降維( dimension reductionality )。比如,一張500 * 500且厚度depth為100 的圖片在20個filter上做1*1的卷積,那麼結果的大小為500*500*20。

2、加入非線性。卷積層之後經過激勵層,1*1的卷積在前一層的學習表示上添加了非線性激勵( non-linear activation ),提升網路的表達能力;

當1*1卷積出現時,在大多數情況下它作用是升/降特徵的維度,這裡的維度指的是通道數(厚度),而不改變圖片的寬和高。

舉個例子,比如某次卷積之後的結果是W*H*6的特徵,現在需要用1*1的卷積核將其降維成W*H*5,即6個通道變成5個通道:

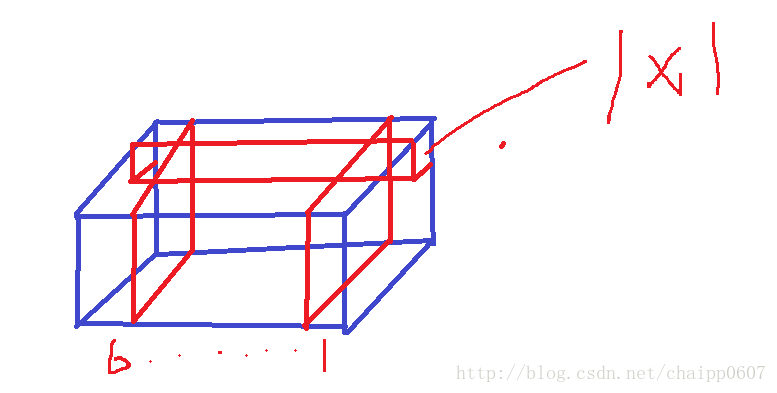

如下圖就是一個W*H*6的特徵,而1*1的卷積核在圖上標出,卷積核自身的厚度也是6(圖畫的好難看!!)

通過一次卷積操作,W*H*6將變為W*H*1,這樣的話,使用5個1*1的卷積核,顯然可以卷積出5個W*H*1,再做通道的串接操作,就實現了W*H*5。

在這裡先計算一下引數數量,一遍後面說明,5個卷積核,每個卷積核的尺寸是1*1*6,也就是一種有30個引數。

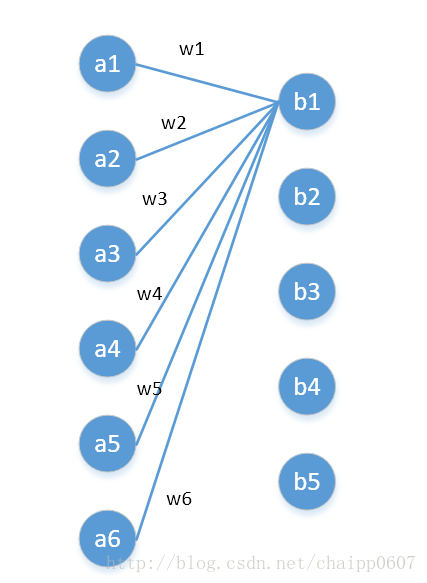

我們還可以用另一種角度去理解1*1卷積,可以把它看成是一種全連線,如下圖:

第一層有6個神經元,分別是a1—a6,通過全連線之後變成5個,分別是b1—b5,第一層的六個神經元要和後面五個實現全連線,本圖中只畫了a1—a6連線到b1的示意,可以看到,在全連線層b1其實是前面6個神經元的加權和,權對應的就是w1—w6,到這裡就很清晰了:

第一層的6個神經元其實就相當於輸入特徵裡面那個通道數:6,而第二層的5個神經元相當於1*1卷積之後的新的特徵通道數:5。

w1—w6是一個卷積核的權係數,如何要計算b2—b5,顯然還需要4個同樣尺寸的核。

最後一個問題,影象的一層相比於神經元還是有區別的,這在於是一個2D矩陣還是一個數字,但是即便是一個2D矩陣的話也還是隻需要一個引數(1*1的核),這就是因為引數的權值共享。

相關推薦

1×1的卷積的作用

1×1的卷積大概有兩個方面的作用吧:1. 實現跨通道的互動和資訊整合2. 進行卷積核通道數的降維和升維下面詳細解釋一下:1. 這一點孫琳鈞童鞋講的很清楚。1×1的卷積層(可能)引起人們的重視是在NIN的結構中,論文中林敏師兄的想法是利用MLP代替傳統的線性卷積核,從而提高網

第一問:1×1卷積層的作用?

1×1卷積層在實現全卷積神經網路中經常用到,即使用1*1的卷積層替換到全連線層,這樣可以不限制輸入圖片大小的尺寸,使網路更靈活。 實現跨通道的互動和資訊整合。 1×1 的卷積層(可能)引起人們的重視是在 NIN 的結構中,論文中林敏師兄的想法是利用 MLP 代替傳統的線性卷積核

1*1卷積層的作用

Ref: https://www.zhihu.com/question/56024942 http://m.blog.csdn.net/chaipp0607/article/details/60868689 1*1卷積的主要作用有以下幾點: 1、降維( dimens

1*1卷積的作用

尺度 ati 出現 卷積 表達 Dimension 通道數 不變 做的 1*1卷積的主要作用有以下幾點: 1、降維( dimension reductionality )。比如,一張500 * 500且厚度depth為100 的圖片在20個filter上做1*1的卷積,那麽

[ 1 x 1 ] Convolution-1*1卷積的作用

一、卷積神經網路中的卷積(Convolution in a convoluted neural network) 具體內容親參考《深度學習》。 二、1*1卷積(one by one convolution)的作用 1*1卷積過濾器 ,它

【讀書1】【2017】MATLAB與深度學習——卷積層(4)

圖6-13 當影象矩陣與濾波器不匹配時,較大的重要元素不會起到顯著的作用Whenthe image matrix does not match the filter, the significant elements are notaligned 這是因為影象矩陣與濾波器不匹配,影象矩

1*1卷積層

from mxnet import gluon,init from mxnet import autograd,nd from mxnet.gluon import nn,loss as gloss from mxnet.gluon import data as gdata

1*1卷積核作用,卷積引數計算,卷積計算量計算

記錄一下吳恩達老師深度學習的第二週的筆記,全是文字記錄推薦繼續擼視訊... .. .新增截圖了,增加瓶頸層的解釋(聽說是某面試題,,,)一般的卷積運算可以壓縮輸入的長度和寬度,1*1卷積核可以整合各個資料通道資訊縮小資料尺寸的深度,同時減小計算量卷積核引數計算:卷積核的長度*

1*1卷積核作用分析

1*1卷積核,這種小巧的卷積核從GoogLeNet,ResNet之後得到了廣泛的使用,其在理論上和時間上都被證明了針對特定的問題可以一定程度地提升神經網路的效率。 關於1*1卷積核的作用,總體而言主要有如下兩個方面的內容: 進行升維與降維並減少網路引數。關

tensorflow實現1維卷積

函數 class amp lte .org same and ide result 官方參考文檔:https://www.tensorflow.org/api_docs/python/tf/nn/conv1d 參考網頁: http://www.riptutorial.com

吳恩達《深度學習》第四門課(1)卷積神經網絡

圖像分割 1.5 共享 信號處理 soft 沒有 樣本 填充 單元 1.1計算機視覺 (1)計算機視覺的應用包括圖像分類、目標檢測、圖像分割、風格遷移等,下圖展示了風格遷移案例: (2)圖像的特征量非常之大,比如一個3通道的1000*1000的照片,其特征為3*1000*

1. CNN卷積網絡初識

非線性 識別 mage 每一個 alt file img 重要 http 1. 前言 卷積神經網絡是一種特殊的深層的神經網絡模型,它的特殊性體現在兩個方面, 它的神經元間的連接是非全連接的, 同一層中某些神經元之間的連接的權重是共享的(即相同的)。 它的非全連接和權值共

Coursera吳恩達《卷積神經網路》課程筆記(1)-- 卷積神經網路基礎

《Convolutional Neural Networks》是Andrw Ng深度學習專項課程中的第四門課。這門課主要介紹卷積神經網路(CNN)的基本概念、模型和具體應用。該門課共有4周課時,所以我將分成4次筆記來總結,這是第一節筆記。 1. Compu

人工智慧初學- 1.3 卷積神經網路

卷積知識 卷積就是:一個函式(如:單位響應)在另一個函式(如:輸入訊號)上的加權疊加。 神經網路(NN) 下面這個是典型的神經網路三層模型:Layer L1是輸入層,Layer L2是隱含層,Layer L3是隱含層 參考下面的部落格可以詳細知道這個模型是

4.1 Tensorflow:卷積函式

卷積 卷積神經網路的結構 其中,input為輸入,conv為卷積層,由卷積核構成,pool為池層,由池化函式構成最後是全連線層與輸出層,其負責對卷積層提取的特徵進行處理以獲得我們需要的結果 卷積函式 卷積函式是本篇文章要講解的內容,在Tens

對卷積層dilation膨脹的作用的理解,caffe-ssd dilation Hole演算法解析

下面是caffe-ssd的vgg16輸出後的變化,減少了一個pooling,stride=1,然後下一層採用了 dilation方法,作用按上面部落格說是既想利用已經訓練好的模型進行fine-tuning,又想改變網路結構得到更加dense的score map.即想讓輸出的f

tensorflow1.1/構建卷積神經網路人臉識別

環境:tensorflow1.1,python3,matplotlin2.02 olivettifaces是紐約大學的一個比較小的人臉庫,由40個人的400張圖片構成,即每個人的人臉圖片為10張。每張圖片的灰度級為8位,每個畫素的灰度大小位於0-255之間,每

深入理解卷積層,全連線層的作用意義

有部分內容是轉載的知乎的,如有侵權,請告知,刪除便是,但由於是總結的,所以不一一列出原作者是who。再次感謝,也希望給其他小白受益。首先說明:可以不用全連線層的。理解1:卷積取的是區域性特徵,全連線就是把以前的區域性特徵重新通過權值矩陣組裝成完整的圖。因為用到了所有的區域性特

深度學習基礎--卷積--1*1的卷積核與全連線的區別

1*1的卷積核與全連線的區別 11的卷積核是輸入map大小不固定的;而全連線是固定的。 11卷積的主要作用有以下兩點: 1)降維( dimension reductionality ),inception中就是這個用。 2)加入非線性,畢竟有啟用

【TensorFlow】tf.nn.conv2d是怎樣實現卷積的?有1*1(1×1)卷積介紹

除去name引數用以指定該操作的name,與方法有關的一共五個引數: 第一個引數input:指需要做卷積的輸入影象,它要求是一個Tensor,具有[batch, in_height, in_width, in_channels]這樣的shape,具體含義是[訓練時一個batch的圖片數量, 圖片