kettle 6.0安裝並連線ORACLE,HADOOP CDH5.3.0以及hadoop客戶端配置

阿新 • • 發佈:2019-01-27

到官網下載

下載完畢後解壓,記得本機要有java環境並配置好

執行spoon.bat在linux下執行spoon.sh,親測win7/centos6可以用

新建轉換,選擇輸入拖出表輸入,輸出拖出表輸出

雙擊設定

點選新建,建立一個oracle新連線

配置好後點擊測試可以測試一下

顯示測試成功

點選獲取sql語句,可以檢視現有的表

之後shift從表輸入拖出箭頭到表輸出,然後點選播放鍵,表就可以匯出了

hadoop檔案傳輸,新建作業,右鍵hadoop cluster

配置hadoop的埠號預設是8020,我這裡改成了自定義的54310,使用者名稱密碼不填寫,填寫了也沒有作用,也就是說填錯了也沒有關係,這個和ssh的使用者密碼不一樣

點選測試,hdfs沒問題,其他環境伺服器沒有配置,就不管了

如圖拖出從start到hadoop copy files 的箭頭,然後雙擊hadoop copy files,設定源和目標

源位本地一個隨意檔案,目標為hdfs,填寫完destination environment後,點選目標檔案/目錄中的...,可以預覽hdfs檔案系統結構

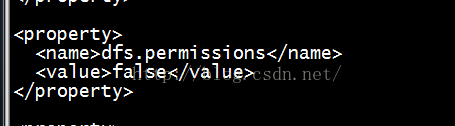

配置完後開始執行,如果報錯,permission denied 的話,原因是伺服器端hdfs配置了許可權檢查

在hdfs-site.xml中增加或者修改為

就可以了

另hadoop客戶端配置

http://blog.csdn.net/j3smile/article/details/7887826

客戶端系統:ubuntu12.04

客戶端使用者名稱:mjiang

伺服器使用者名稱:hadoop

下載hadoop安裝包,保證和伺服器版本一致(或直接copy伺服器的hadoop安裝包)

到 http://mirror.bjtu.edu.cn/apache/hadoop/common/ 下載tar.gz安裝包,解壓。

tar zxvf hadoopx.x.x.tar.gz

配置

系統配置

修改 ~/.bashrc 檔案

新增 export PATH=/path/to/hadoop/homePATH

hadoop配置檔案修改

在客戶端只需配置叢集namenode 和 jobtracker 的相關資訊,以及java安裝目錄。即修改conf目錄下檔案:

hadoop-env.sh:

export JAVA_HOME=/home/mjiang/hadoop_work/jrockit-jdk1.6.0_29

core-site.xml:

<property>

<name>fs.default.name</name>

<value>hdfs://master:8020<alue>

</property>

mapred-site.xml:

<property>

<name>mapred.job.tracker</name>

<value>master:8021<alue>

</property>

現在hadoop客戶端已經配置好,可以執行基本的命令如:

hadoop fs -lsr /

但是由於伺服器端還沒有設定許可權,所以向hdfs系統上傳檔案等命令還不能執行。 公司級應用時許可權配置:

這裡只進行簡單的許可權配置,遠端使用者能正常提交執行作業即可,更加專業、高階的許可權配置暫時還用不到,也沒有做過多研究。

在解決許可權配置問題時,我們對hadoop多使用者許可權配置的問題,轉移成單純的hdfs檔案的使用者許可權配置問題:

在伺服器主機上新增客戶端使用者以及hadoop預設組名:

sudo /usr/sbin/groupadd supergroup

sudo /usr/sbin/useradd -e 20130630 -g supergroup -n -r mjiang

修改hadoop叢集中hdfs檔案的組許可權使屬於supergroup組的所有使用者都有讀寫許可權

hadoop fs -chmod 773 /