Linux下Spark的安裝和配置

阿新 • • 發佈:2019-02-04

一.安裝JDK(略)

二.安裝Scala(l略)

三.安裝Spark

1.上傳安裝包到叢集節點

2.解壓安裝包

3.修改配置檔案

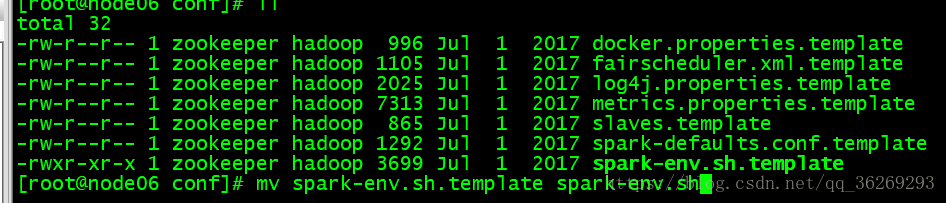

a.spark-env.sh

vi spark-env.sh

b.slaves

vi slaves

c.修改master ui埠(ambari佔用8080埠所以修改,如果8080埠沒有被佔用不需要修改)

vi start-master.sh

修改成自定義的一個埠號

4.將修改後的conf目錄複製到其他節點上

5.啟動叢集

也可以啟動另外一個master

6.啟動測試

7.test

/usr/local/apps/spark-2.2.0-bin-hadoop2.7/bin/spark-submit --class org.apache.spark.examples.SparkPi --master spark://node00:7077,node06:7077 --executor-memory 1G --total-executor-cores 2 /usr/local/apps/spark-2.2.0-bin-hadoop2.7/examples/jars/spark-examples_2.11-2.2.0.jar