百萬級數據插入的優化

插入分析

MySQL中插入一個記錄需要的時間由下列因素組成,其中的數字表示大約比例:

- 連接:(3)

- 發送查詢給服務器:(2)

- 分析查詢:(2)

- 插入記錄:(1x記錄大小)

- 插入索引:(1x索引)

- 關閉:(1)

如果我們每插入一條都執行一個SQL語句,那麽我們需要執行除了連接和關閉之外的所有步驟N次,這樣是非常耗時的,優化的方式有一下幾種:

- 在每個insert語句中寫入多行,批量插入

- 將所有查詢語句寫入事務中

- 利用Load Data導入數據

每種方式執行的性能如下。

Innodb引擎

InnoDB 給 MySQL 提供了具有事務(commit)、回滾(rollback)和崩潰修復能力(crash recovery capabilities)的事務安全(transaction-safe (ACID compliant))型表。InnoDB 提供了行鎖(locking on row level)以及外鍵約束(FOREIGN KEY constraints)。

InnoDB 的設計目標是處理大容量數據庫系統,它的 CPU 利用率是其它基於磁盤的關系數據庫引擎所不能比的。在技術上,InnoDB 是一套放在 MySQL 後臺的完整數據庫系統,InnoDB 在主內存中建立其專用的緩沖池用於高速緩沖數據和索引。

測試環境

Macbook Air 12mid apache2.2.26 php5.5.10 mysql5.6.16

總數100W條數據

插入完後數據庫大小38.6MB(無索引),46.8(有索引)

- 無索引單條插入 總耗時:229s 峰值內存:246KB

- 有索引單條插入 總耗時:242s 峰值內存:246KB

- 無索引批量插入 總耗時:10s 峰值內存:8643KB

- 有索引批量插入 總耗時:16s 峰值內存:8643KB

- 無索引事務插入 總耗時:78s 峰值內存:246KB

- 有索引事務插入 總耗時:82s 峰值內存:246KB

- 無索引Load Data插入 總耗時:12s 峰值內存:246KB

- 有索引Load Data插入 總耗時:11s 峰值內存:246KB

MyIASM引擎

MyISAM 是MySQL缺省存貯引擎。設計簡單,支持全文搜索。

測試環境

Macbook Air 12mid apache2.2.26 php5.5.10 mysql5.6.16

總數100W條數據

插入完後數據庫大小19.1MB(無索引),38.6(有索引)

- 無索引單條插入 總耗時:82s 峰值內存:246KB

- 有索引單條插入 總耗時:86s 峰值內存:246KB

- 無索引批量插入 總耗時:3s 峰值內存:8643KB

- 有索引批量插入 總耗時:7s 峰值內存:8643KB

- 無索引Load Data插入 總耗時:6s 峰值內存:246KB

- 有索引Load Data插入 總耗時:8s 峰值內存:246KB

總結

我測試的數據量不是很大,不過可以大概了解這幾種插入方式對於速度的影響,最快的必然是Load Data方式。這種方式相對比較麻煩,因為涉及到了寫文件,但是可以兼顧內存和速度。

引用:http://www.codeceo.com/article/mysql-insert-compare.html

二、PHP+MySQL百萬數據插入

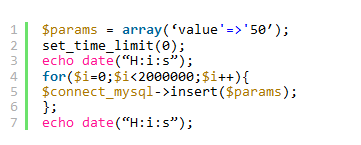

第一種方法:使用insert into 插入,代碼如下:

最後顯示為:23:25:05 01:32:05 也就是花了2個小時多! 這是時間擼幾把 都行。。。

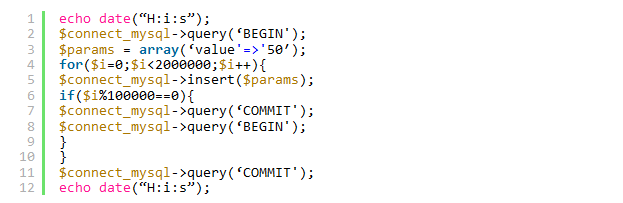

第二種方法:使用事務提交,批量插入數據庫(每隔10W條提交下)

最後顯示消耗的時間為:22:56:13 23:04:00 ,一共8分13秒 ,代碼如下:

時間是一下縮短不少但還是有點長。

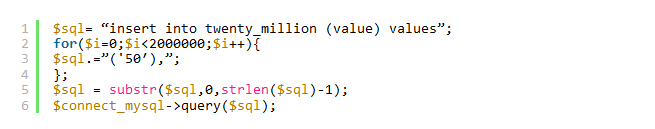

第三種方法:使用優化SQL語句:將SQL語句進行拼接,使用 insert into table () values (),(),(),()然後再一次性插入,如果字符串太長,

則需要配置下MYSQL,在mysql 命令行中運行 :set global max_allowed_packet = 2*1024*1024*10;消耗時間為:11:24:06 11:24:11;

我擦 插入200W條測試數據僅僅用了不到6秒鐘!代碼如下:

可能這裏又會有人說數據不大 sql文件導出來也是小200M 5秒鐘 對一表格 進行200萬條數據 速度已經不錯了。

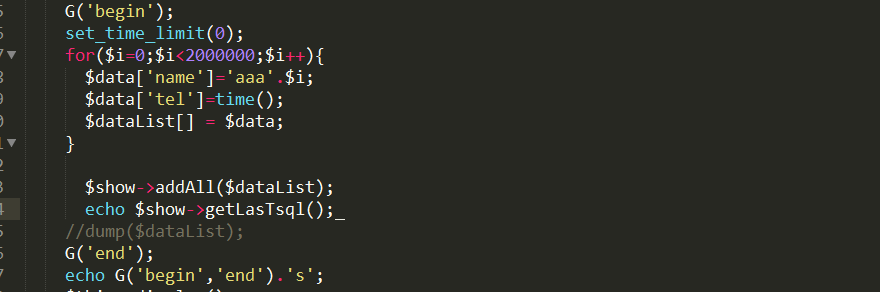

這個再跟大家說一個 TP框架了的 addall方法

速度也很快 但是還不如原生。

著了說一下其中可能會遇到的問題 比如試驗時可能會出現PHP內存限制 和mysql的SQL語句溢出甚至宕機

這裏數幾個方案

1、可以進行相關的配置php.ini my.ini 等

2、大家可以用隊列進行分批處理

3、或者自己的一些方法

好了數據的插入就到這裏 大家有覺得不對的 盡請評論 或留言。

百萬級數據插入的優化