Windows下安裝Spark

1. 安裝Scala, 下載鏈接 https://downloads.lightbend.com/scala/2.12.3/scala-2.12.3.msi

創建系統變量 SCALA_HOME為C:\Program Files (x86)\scala, 然後添加%SCALA_HOME%\bin到系統PATH變量中

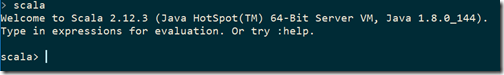

然後打開cmd窗口,運行scala,你應該看到如下信息

2. 安裝JDK,下載鏈接,http://www.oracle.com/technetwork/java/javase/downloads/index.html, spark2.2要求jdk8,所以下載

Java SE 8u144

創建系統變量JAVA_HOME為C:\Program Files\Java\jdk1.8.0_144, 然後添加%JAVA_HOME%\bin到系統PATH變量中

創建系統變量CLASSPATH,內容為%JAVA_HOMT%\lib;%JAVA_HOMT%\lib\tools.jar;

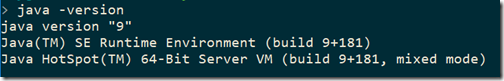

打開cmd窗口,輸入 java -version,

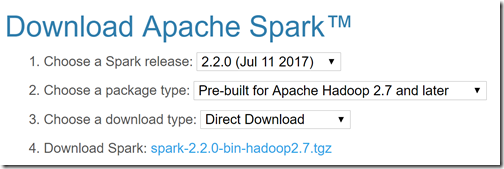

3. 安裝spark, 下載鏈接 http://spark.apache.org/downloads.html

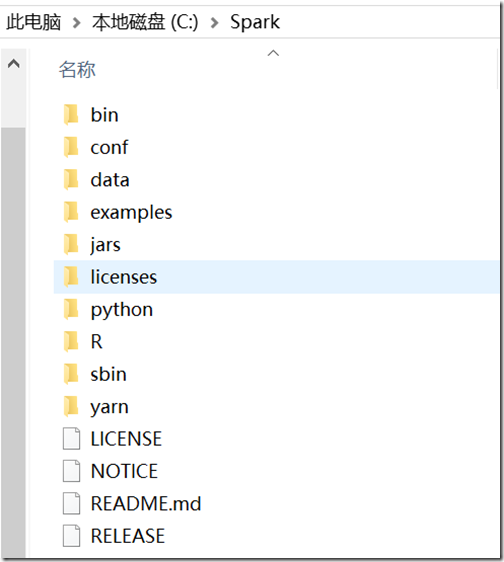

點擊第4步的鏈接下載,之後把裏面的內容解壓縮到C:\Spark文件夾中,

創建系統變量SPARK_HOME,內容為C:\Spark\bin,添加%SPARK_HOME% 和 %SPARK_HOME%\sbin到系統變量PATH中

4. 安裝hadoop winutils,下載鏈接https://github.com/steveloughran/winutils, 選擇你要的hadoop版本號,比如2.8.1,你只需要下載winutils.exe,然後拷貝到C:\Hadoop\bin文件夾中。

創建系統變量HADOOP_HOME,為C:\Hadoop,添加%HADOOP_HOME%\bin到PATH變量中

5. 以管理員身份打開cmd,運行spark-shell,如果遇到訪問權限等錯誤的話,運行 winutils.exe chmod 777 –R C:\tmp\hive

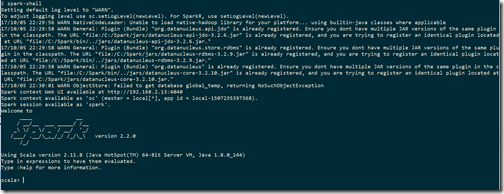

6. 以管理員身份打開cmd,運行spark-shell,你應該看到如下界面

最重要的,你要看到Spark context available as ‘sc‘ (master = local[*], app id = local-1507235397368).字樣

7. spark hello world example

在Scala>提示符後依次輸入運行

val textFile = sc.textFile(file:///Spark/README.md)

val tokenizedFileData = textFile.flatMap(line=>line.split(" "))

val countPrep = tokenizedFileData.map(word=>(word,1))

val counts = countPrep.reduceByKey((accumValue, newValue)=>accumValue+newValue)

var sortedCounts = counts.sortBy(kvPair=>kvPair._2,false)

sortedCounts.saveAsTextFile(file:///OutputData/ReadMeWordCount)

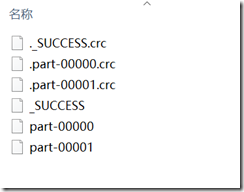

打開C盤,你應該看到OutputData文件夾,裏面有ReadMeWordCount文件夾,裏面的內容為

查看文件part-00000和part-00001,裏面就是各個單詞在README.md文件中出現的次數。

Windows下安裝Spark