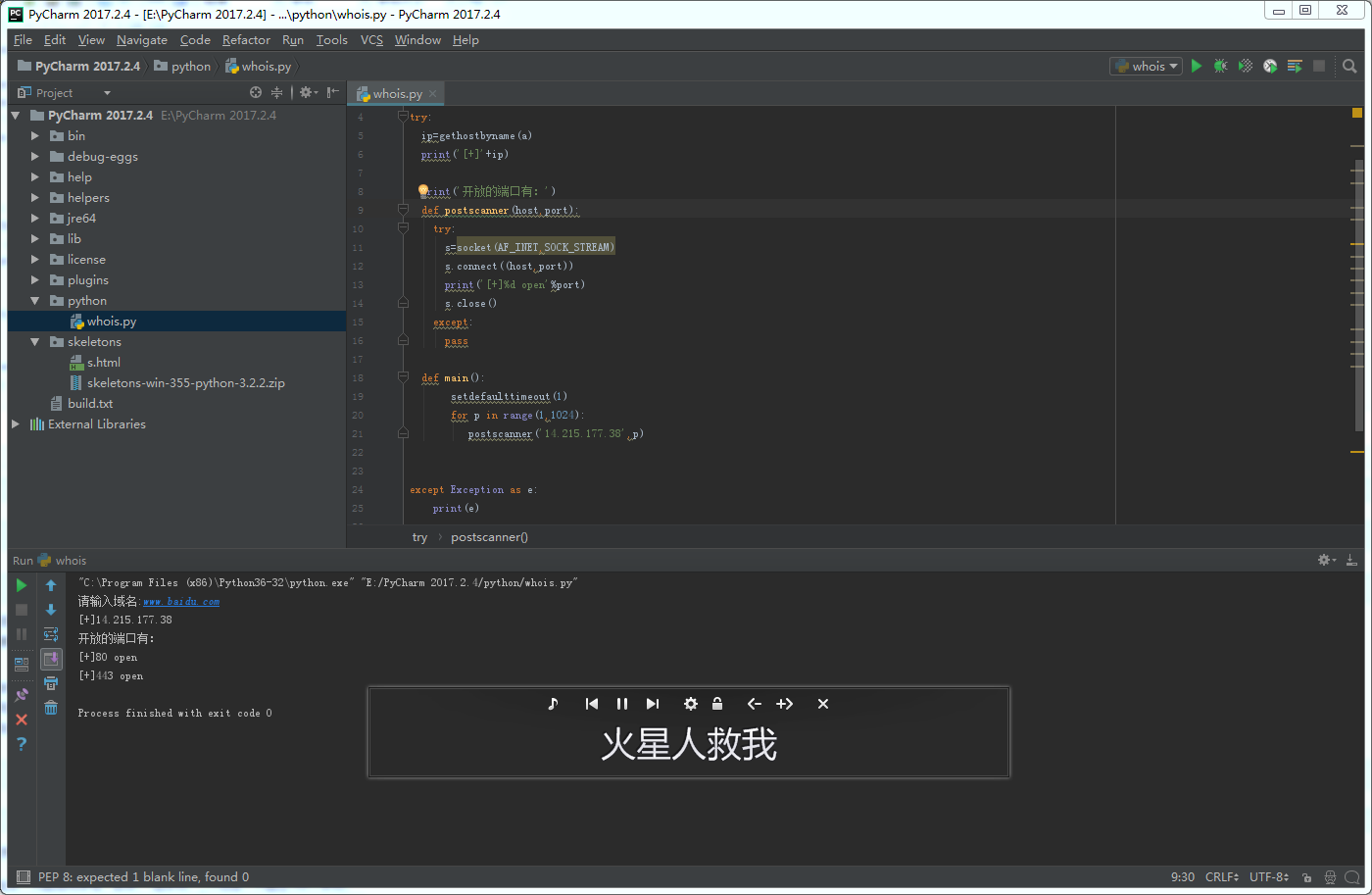

python寫外網收集信息器

簡單化,知道IP去掃描ip

import socket from socket import * a=input(‘請輸入域名:‘) try: ip=gethostbyname(a) print(‘[+]‘+ip) print(‘開放的端口有:‘) def postscanner(host,port): try: s=socket(AF_INET,SOCK_STREAM) s.connect((host,port)) print(‘[+]%d open‘%port) s.close() except:pass def main(): setdefaulttimeout(1) for p in range(1,1024): postscanner(‘14.215.177.38‘,p) except Exception as e: print(e) if __name__ == ‘__main__‘: main()

python寫外網收集信息器

相關推薦

python寫外網收集信息器

ges scan .cn efault open exce 端口 name img 簡單化,知道IP去掃描ip import socket from socket import * a=input(‘請輸入域名:‘) try: ip=gethostbyname(a)

MSF魔鬼訓練營-3.1.1信息收集-通過DNS和IP地址挖掘目標網絡信息

詳細 root https earch 滲透測試 出發 .com 域名查詢 測試 情報搜集環境站滲透測試全過程的80%~90% 一、外圍信息搜集(公開渠道信息搜集OSINT open source intelligence) 3.1.1信息收集-通過DNS和IP地址挖

python 爬蟲2-正則表達式抓取拉勾網職位信息

headers mode data .cn 保存 time exc href ace import requestsimport re #正則表達式import time import pandas #保存成 CSV #header={‘User-Agent‘:‘M

Python爬蟲項目--爬取自如網房源信息

xml解析 quest chrom 當前 b2b cal 源代碼 headers 判斷 本次爬取自如網房源信息所用到的知識點: 1. requests get請求 2. lxml解析html 3. Xpath 4. MongoDB存儲 正文 1.分析目標站點 1. url:

Python的scrapy之爬取鏈家網房價信息並保存到本地

width gif pat lse idt ext tst maximum spa 因為有在北京租房的打算,於是上網瀏覽了一下鏈家網站的房價,想將他們爬取下來,並保存到本地。 先看鏈家網的源碼。。房價信息 都保存在 ul 下的li 裏面 ? 爬蟲結構: ? 其中封裝了一

python使用requests庫和re庫寫的京東商品信息爬蟲

fin 搜索 goods tle 爬取 val timeout stat for 1 import requests 2 import re 3 4 def getHTMLText(url): 5 try: 6 r = reques

python練習_module02-1-員工信息表

註意 最大 空格 n) 輸入 找到 true 之間 進行 python 操作 員工信息表 要求: 可進行模糊查詢,語法至少支持下面3種: select name,age from staff_table where age > 22select * from

4、Python將采集的信息保存

enc lis iter names for utf8 option res esp 一、引言 前面小編已和各位童鞋分享了如何爬去歷史天氣網站的城市信息,下面將和大家分享如何將采集到的信息保存下來。 1、將采集到的信息保存在csv文件中

python 之獲取對象信息

call rfi space subclass 創建 contain 告訴 語句 func 當我們拿到一個對象的引用時,如何知道這個對象是什麽類型、有哪些方法呢? 使用type() 首先,我們來判斷對象類型,使用type()函數: 基本類型都可以用type()判斷: >

Node.js爬蟲-爬取慕課網課程信息

reac 分享 function apt txt sta eject 賦值 find 第一次學習Node.js爬蟲,所以這時一個簡單的爬蟲,Node.js的好處就是可以並發的執行 這個爬蟲主要就是獲取慕課網的課程信息,並把獲得的信息存儲到一個文件中,其中要用到cheerio

查看網卡信息

網卡查看網卡是千兆網卡還是萬兆網卡lspci -vvv | grep Ethernet千兆網卡Gigabit(萬兆網卡顯示為10-Gigabit)出來幾行代表 幾塊網卡具體查看每塊網卡信息本文出自 “磚家博客” 博客,請務必保留此出處http://wsxxsl.blog.51cto.com/9085838/1

Python+selenium之獲取驗證信息

button pytho sleep 代碼 ive click gin body spa 通常獲取驗證信息用得最多的幾種驗證信息分別是title,URL和text。text方法用於獲取標簽對之間的文本信息。 代碼如下: from selenium import webdri

python 爬取微博信息

微博 爬蟲 python cookie 新浪微博爬取的話需要設計到登錄,這裏我沒有模擬登錄,而是使用cookie進行爬取。獲取cookie:代碼:#-*-coding:utf8-*- from bs4 import BeautifulSoup import requests impor

shell腳本:查看KVM虛擬機中的網卡信息(不需要進入啟動或進入虛擬機)

腳本 虛擬化 shell kvm # Author:丁丁歷險(Jacob) # 該腳本使用guestmount工具,可以將虛擬機的磁盤系統掛載到真實機文件系統中 # Centos7.2中安裝libguestfs-tools-c可以獲得guestmount工具 # 虛擬機可以啟動或者不啟動都不影

Magnostics Image-based Search of Interesting Matrix Views for Guided Network Exploration(一種基於網絡信息矩陣圖像的網絡探索方法)

希望 組合 cad 區分 加權 rest 結果 xpl ati 網絡、關系等數據變成如圖的鄰接矩陣時(紅色代表兩個節點也就是人,之間有聯系),但是得到的矩陣會因為順序的問題而出現不同的排列方式,在第一種中會發現因為有聚集的塊狀區域而很容易地把數據分為兩個部分,然後根據數據的

Weave 如何與外網通信?- 每天5分鐘玩轉 Docker 容器技術(66)

ont 地址空間 是個 地址 title size lis ubuntu 微軟雅黑 上一節我們學習了 Weave 網絡內部如何通信,今天討論 Weave 如何與外界通信。 weave 是一個私有的 VxLAN 網絡,默認與外部網絡隔離。外部網絡如何才能訪

結對-爬取大麥網演唱會信息-設計文檔

.com ref lock beautiful 模塊 有用 pytho spa pil 結對編程成員:閻大為,張躍馨 搭建環境: ?1.安裝python2.7 ?2.安裝beautifulsoup4等相關模塊 編寫程序階段: ?1.分析html代碼以及了解相

九眼智能:用大數據技術為網絡信息加層“濾網”

技術 智能 公開 噪音 爭奪 新聞 群組 同時 新聞媒體 隨著信息傳播技術的快速發展和各類互聯網平臺的興起,個人、機構均可通過註冊公眾賬號借助平臺公開發布信息,成為新聞媒體等專業內容生產機構之外的重要內容生產者,互聯網平臺成為用戶獲取信息的重要渠道。互聯網平臺的興起及公

獲取本地計算機的網絡信息

mixed comm windows 數據大小 一個 等待 ast 聲明 ffi Windows網絡編程第六章探測網絡中的在線設備 實驗:獲取本地計算機的網絡信息 實驗分析:主要練習對GetAdaptersInfo()、GetNetworkParams()、GetInter

Python-根據已有的行政區域信息,自動生成exl文件

pac pda play for Coding ted gre sci none 最近接到個小任務,需要從下圖這樣的信息中找出社區、行政村並且分類。事後我計算了一下,只是行政村就有500+,這樣的重復性勞動果斷選擇Python來執行。 為了方便其他和我遇到同樣問題的人,我