matplotlib.pyplot可視化訓練結果

阿新 • • 發佈:2018-03-25

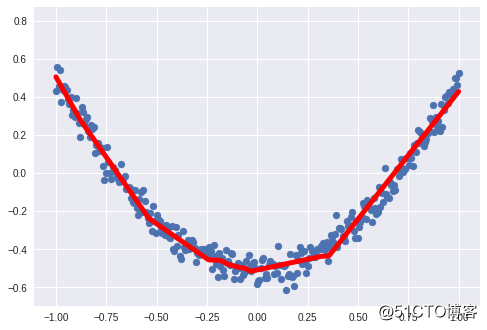

tensorflowmatplotlib.pyplot可視化訓練結果

註:程序和數據來自上篇blog#定義激勵函數 並 定義一個添加神經層函數 import tensorflow as tf import numpy as np import matplotlib.pyplot as plt def add_layer(inputs,in_size,out_size,activation_function): Weights=tf.Variable(tf.random_normal([in_size,out_size]))#定義一個in_siz行,out_size列的矩陣。 #註:矩陣相乘輸出為:前面項的行數,後面項的列數。 biases=tf.Variable(tf.zeros([1,out_size])+0.1)#定義一個偏置 Wx_plus_b=tf.matmul(inputs,Weights)+biases if activation_function is None: outputs=Wx_plus_b else: outputs=activation_function(Wx_plus_b) return outputs x_data=np.linspace(-1,1,300)[:,np.newaxis]##這一行中的[:,np.newxis]是將數據在行上增加n多行,列數為1 noise=np.random.normal(0,0.05,x_data.shape) y_data=np.square(x_data)-0.5+noise xs=tf.placeholder(tf.float32,[None,1])#數據為float32形式 ys=tf.placeholder(tf.float32,[None,1]) l1=add_layer(xs,1,10,activation_function=tf.nn.relu)#用placeholder中傳來的值 prediction=add_layer(l1,10,1,activation_function=None) loss=tf.reduce_mean(tf.reduce_sum(tf.square(ys-prediction),reduction_indices=[1])) train_step=tf.train.GradientDescentOptimizer(0.1).minimize(loss) init=tf.initialize_all_variables() sess=tf.Session() sess.run(init) #####畫出真實值#### fig=plt.figure()#先生成一個畫框 ax=fig.add_subplot(1,1,1)###總共一行一列,選第一個畫圖 ax.scatter(x_data,y_data)#用點的形式將真實數據plot出來 #plt.ion() #plt.show() for i in range(1000): sess.run(train_step,feed_dict={xs:x_data,ys:y_data}) if i%100==0: #每100次顯示一下 ####畫出預測#### try: #這裏是為了抹除上100次得到的預測結果的線 ax.lines.remove(lines[0]) except Exception: pass prediction_value=sess.run(prediction,feed_dict={xs:x_data}) lines=ax.plot(x_data,prediction_value,‘r-‘,lw=5)#用線畫出預測值 #plt.pause(0.1) print("第%d次:"%(i),sess.run(loss,feed_dict={xs:x_data,ys:y_data}))

輸出:

第0次: 0.06378379

第100次: 0.0045252806

第200次: 0.003339286

第300次: 0.0029212094

第400次: 0.0027737075

第500次: 0.0027111543

第600次: 0.0026785966

第700次: 0.0026464972

第800次: 0.002620993

第900次: 0.0026080923

matplotlib.pyplot可視化訓練結果