I/O復用的理解

假設你是一個機場的空管, 你需要管理到你機場的所有的航線, 包括進港,出港, 有些航班需要放到停機坪等待,有些航班需要去登機口接乘客。

你會怎麽做?

最簡單的做法,就是你去招一大批空管員,然後每人盯一架飛機, 從進港,接客,排位,出港,航線監控,直至交接給下一個空港,全程監控。

那麽問題就來了:

· 很快你就發現空管塔裏面聚集起來一大票的空管員,交通稍微繁忙一點,新的空管員就已經擠不進來了。

· 空管員之間需要協調,屋子裏面就1, 2個人的時候還好,幾十號人以後 ,基本上就成菜市場了。

· 空管員經常需要更新一些公用的東西,比如起飛顯示屏,比如下一個小時後的出港排期,最後你會很驚奇的發現,每個人的時間最後都花在了搶這些資源上。

他們用這個東西

·

· 這個東西叫flight progress strip. 每一個塊代表一個航班,不同的槽代表不同的狀態,然後一個空管員可以管理一組這樣的塊(一組航班),而他的工作,就是在航班信息有新的更新的時候,把對應的塊放到不同的槽子裏面。

這個東西現在還沒有淘汰哦,只是變成電子的了而已。。

是不是覺得一下子效率高了很多,一個空管塔裏可以調度的航線可以是前一種方法的幾倍到幾十倍。

如果你把每一個航線當成一個Sock(I/O 流), 空管當成你的服務端Sock管理代碼的話.

第一種方法就是最傳統的多進程並發模型 (每進來一個新的I/O流會分配一個新的進程管理。)

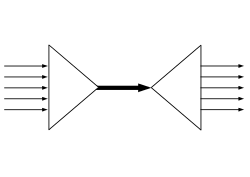

其實“I/O多路復用”這個坑爹翻譯可能是這個概念在中文裏面如此難理解的原因。所謂的I/O多路復用在英文中其實叫 I/O multiplexing. 如果你搜索multiplexing啥意思,基本上都會出這個圖:

· 於是大部分人都直接聯想到"一根網線,多個sock復用" 這個概念,包括上面的幾個回答, 其實不管你用多進程還是I/O多路復用, 網線都只有一根好伐。多個Sock復用一根網線這個功能是在內核+驅動層實現的。

重要的事情再說一遍: I/O multiplexing 這裏面的 multiplexing 指的其實是在單個線程通過記錄跟蹤每一個Sock(I/O流)的狀態(對應空管塔裏面的Fight progress strip槽)來同時管理多個I/O流. 發明它的原因,是盡量多的提高服務器的吞吐能力。

****

****

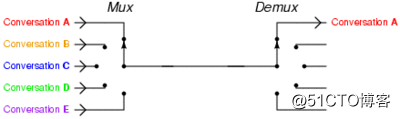

在同一個線程裏面, 通過撥開關的方式,來同時傳輸多個I/O流, (學過EE的人現在可以站出來義正嚴辭說這個叫“時分復用”了)。

什麽,你還沒有搞懂“一個請求到來了,nginx使用epoll接收請求的過程是怎樣的”, 多看看這個圖就了解了。提醒下,ngnix會有很多鏈接進來, epoll會把他們都監視起來,然後像撥開關一樣,誰有數據就撥向誰,然後調用相應的代碼處理。

了解這個基本的概念以後,其他的就很好解釋了。

select, poll, epoll 都是I/O多路復用的具體的實現,之所以有這三個鬼存在,其實是他們出現是有先後順序的。

I/O多路復用這個概念被提出來以後, select是第一個實現 (1983 左右在BSD裏面實現的)。

select 被實現以後,很快就暴露出了很多問題。

· select 會修改傳入的參數數組,這個對於一個需要調用很多次的函數,是非常不友好的。

· select 如果任何一個sock(I/O stream)出現了數據,select 僅僅會返回,但是並不會告訴你是那個sock上有數據,於是你只能自己一個一個的找,10幾個sock可能還好,要是幾萬的sock每次都找一遍。

· select 只能監視1024個鏈接,linux 定義在頭文件中的,參見FD_SETSIZE。

· select 不是線程安全的,如果你把一個sock加入到select, 然後突然另外一個線程發現,尼瑪,這個sock不用,要收回。對不起,這個select 不支持的,如果你喪心病狂的竟然關掉這個sock, select的標準行為是。。呃。。不可預測的, 這個可是寫在文檔中的哦.

“If a file descriptor being monitored by select() is closed in another thread, the result is unspecified”

霸不霸氣

於是14年以後(1997年)一幫人又實現了poll, poll 修復了select的很多問題,比如

· poll 去掉了1024個鏈接的限制,於是要多少鏈接呢, 主人你開心就好。

· poll 從設計上來說,不再修改傳入數組,不過這個要看你的平臺了,所以行走江湖,還是小心為妙。

其實拖14年那麽久也不是效率問題, 而是那個時代的硬件實在太弱,一臺服務器處理1千多個鏈接簡直就是神一樣的存在了,select很長段時間已經滿足需求。

但是poll仍然不是線程安全的, 這就意味著,不管服務器有多強悍,你也只能在一個線程裏面處理一組I/O流。你當然可以那多進程來配合了,不過然後你就有了多進程的各種問題。

於是5年以後, 在2002, 大神 Davide Libenzi 實現了epoll.

epoll 可以說是I/O 多路復用最新的一個實現,epoll 修復了poll 和select絕大部分問題, 比如:

· epoll 現在是線程安全的。

· epoll 現在不僅告訴你sock組裏面數據,還會告訴你具體哪個sock有數據,你不用自己去找了。

epoll 當年的patch,現在還在,下面鏈接可以看得到:

/dev/epoll Home Page

可是epoll 有個致命的缺點。。只有linux支持。比如BSD上面對應的實現是kqueue。

而ngnix 的設計原則裏面, 它會使用目標平臺上面最高效的I/O多路復用模型咯,所以才會有這個設置。一般情況下,如果可能的話,盡量都用epoll/kqueue吧。

詳細的在這裏:

PS: 上面所有這些比較分析,都建立在大並發下面,如果你的並發數太少,用哪個,其實都沒有區別。 如果像是在歐朋數據中心裏面的轉碼服務器那種動不動就是幾萬幾十萬的並發,不用epoll我可以直接去撞墻了。

Linux下實現I/O復用的系統調用有select、poll、epoll。

select系統調用的用途:在一段時間內,監聽用戶感興趣的文件描述符上的可讀,可寫和異常等事件

poll系統調用:在制定時間內輪詢一定數量的文件描述符,已測試其中是否有就緒者

epoll系列系統調用:

epoll是linux特有的I/O復用函數

文件描述符(用來標識內核中的事件表)的創建有epoll_creat來完成

I/O復用的理解