基於centos7部署hadoop集群的準備環境部署

阿新 • • 發佈:2018-09-12

vpd disabled jdk1.8 per process 環境部署 conf 查看 51cto 由於工作需要,需要搭建hadoop+zookeeper+hbase+storm+kafka集群

準備了三臺服務器(一臺8核+32G內存+300G硬盤充當master,一臺8核+16G內存+300G硬盤充當slave01,一臺8+16G+500G硬盤充當slave02,並且都能上網),具體如下:

Master 根據情況定義 Hadoop、zookeeper、hbase、storm、kafka、

Slave01 根據情況定義 Hadoop、zookeeper、hbase、opentsdb、storm、kafka

Slave02 根據情況定義 Hadoop、zookeeper、hbase、opentsdb、storm、kafka

一、安裝前準備工作。【三臺機器需要準備環境】

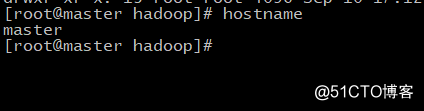

(1)修改主機名。

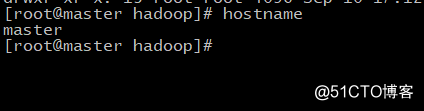

使用命令:hostnamectl set-hostname master 【在master主機上執行】

hostnamectl set-hostname slave01 【在slave01主機上執行】

hostnamectl set-hostname slave02 【在slave02主機上執行】

執行完命令後查看,如下圖:

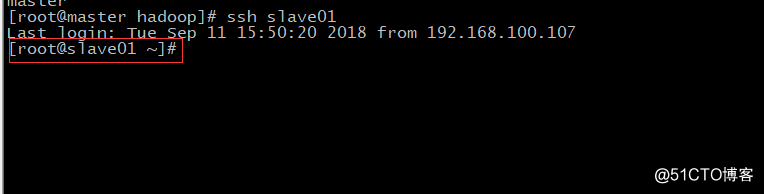

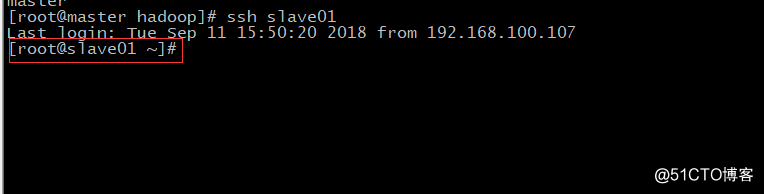

(2)配置免密鑰登錄

ssh-keygen #一路回車即可

ssh-copy-id master

ssh-copy-id slave01

ssh-copy-id slave02

驗證是否正確,如下圖:

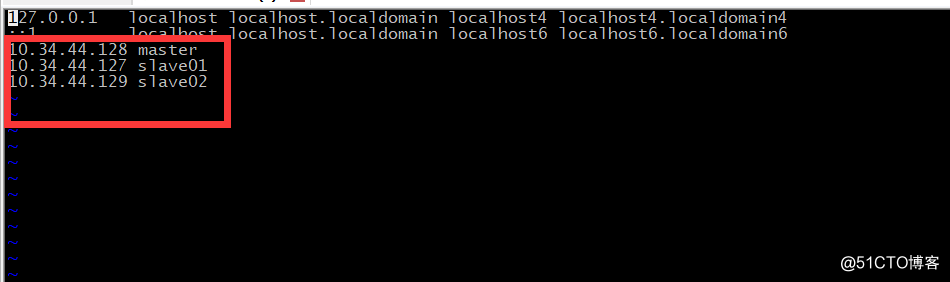

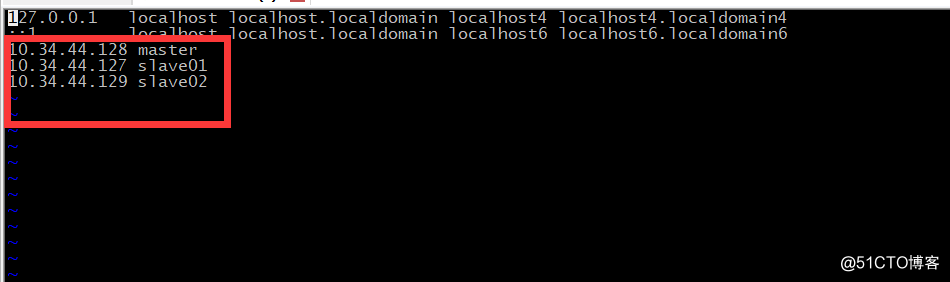

(3)配置hosts文件

vim /etc/hosts

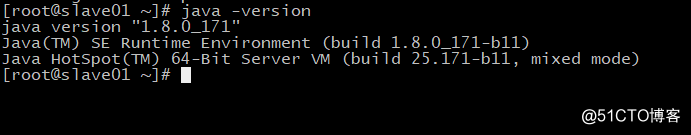

(4)安裝jdk1.8

①下載安裝包

wget http://s***.hc-yun.com:10081/down/jdk-8u171-linux-x64.tar.gz

②解壓到目錄 (目錄隨意)

tar zxvf jdk-8u171-linux-x64.tar.gz -C /usr/local

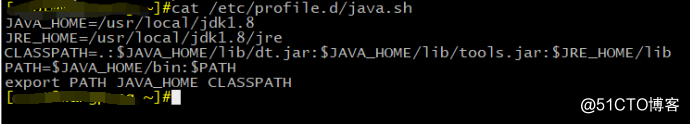

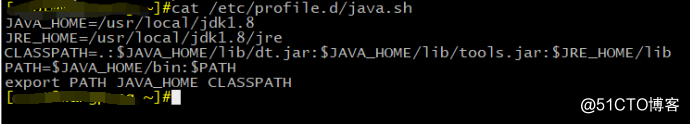

③添加jdk環境變量

vim /etc/profile.d/java.sh

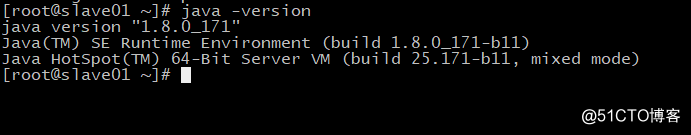

驗證是否安裝jdk成功,如下圖:

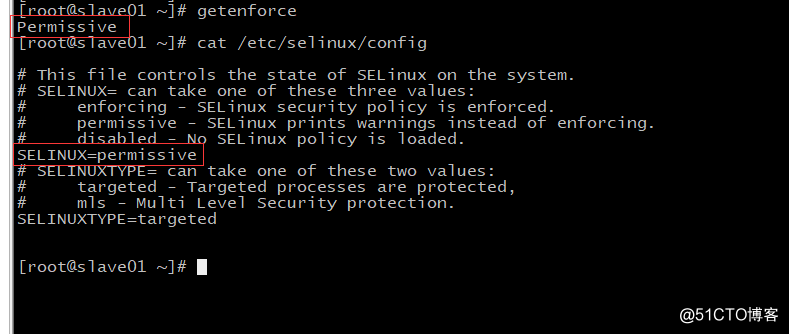

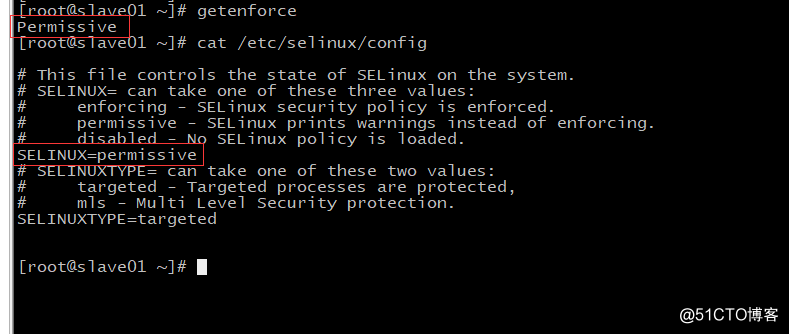

(5)關閉防火墻和selinux

setenforce 0

sed -i "s/^SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config

systemctl stop firewalld

systemctl disable firewalld

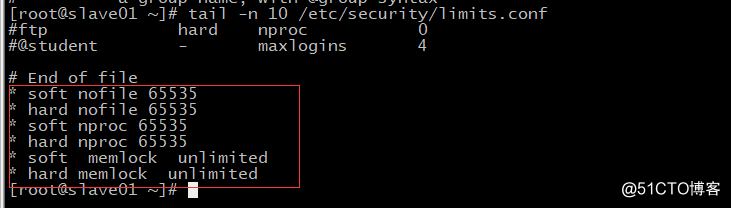

(6)修改環境變量

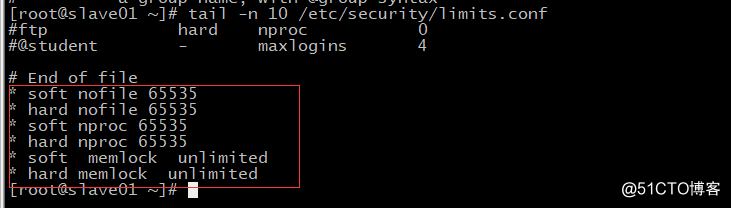

echo " soft nofile 65535" >> /etc/security/limits.conf

echo " hard nofile 65535" >> /etc/security/limits.conf

echo " soft nproc 65535" >> /etc/security/limits.conf

echo " hard nproc 65535" >> /etc/security/limits.conf

echo " soft memlock unlimited" >> /etc/security/limits.conf

echo " hard memlock unlimited" >> /etc/security/limits.conf

(7)創建統一文件夾,後期把程序都放到該文件夾下 【根據磁盤狀況】

mkdir -p /home/hadoop

添加各個服務變量

cat <<EOF > /root/.bashrc

準備了三臺服務器(一臺8核+32G內存+300G硬盤充當master,一臺8核+16G內存+300G硬盤充當slave01,一臺8+16G+500G硬盤充當slave02,並且都能上網),具體如下:

Master 根據情況定義 Hadoop、zookeeper、hbase、storm、kafka、

Slave01 根據情況定義 Hadoop、zookeeper、hbase、opentsdb、storm、kafka

Slave02 根據情況定義 Hadoop、zookeeper、hbase、opentsdb、storm、kafka

一、安裝前準備工作。【三臺機器需要準備環境】

(1)修改主機名。

使用命令:hostnamectl set-hostname master 【在master主機上執行】

hostnamectl set-hostname slave01 【在slave01主機上執行】

hostnamectl set-hostname slave02 【在slave02主機上執行】

執行完命令後查看,如下圖:

(2)配置免密鑰登錄

ssh-keygen #一路回車即可

ssh-copy-id master

ssh-copy-id slave01

ssh-copy-id slave02

驗證是否正確,如下圖:

(3)配置hosts文件

vim /etc/hosts

(4)安裝jdk1.8

①下載安裝包

wget http://s***.hc-yun.com:10081/down/jdk-8u171-linux-x64.tar.gz

②解壓到目錄 (目錄隨意)

tar zxvf jdk-8u171-linux-x64.tar.gz -C /usr/local

③添加jdk環境變量

vim /etc/profile.d/java.sh

驗證是否安裝jdk成功,如下圖:

(5)關閉防火墻和selinux

setenforce 0

sed -i "s/^SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config

systemctl stop firewalld

systemctl disable firewalld

(6)修改環境變量

echo " soft nofile 65535" >> /etc/security/limits.conf

echo " hard nofile 65535" >> /etc/security/limits.conf

echo " soft nproc 65535" >> /etc/security/limits.conf

echo " hard nproc 65535" >> /etc/security/limits.conf

echo " soft memlock unlimited" >> /etc/security/limits.conf

echo " hard memlock unlimited" >> /etc/security/limits.conf

(7)創建統一文件夾,後期把程序都放到該文件夾下 【根據磁盤狀況】

mkdir -p /home/hadoop

添加各個服務變量

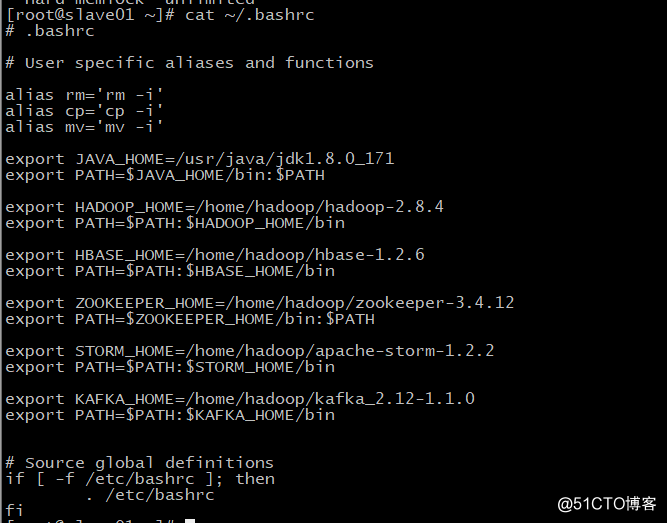

cat <<EOF > /root/.bashrc

.bashrc

alias rm=‘rm -i‘

alias cp=‘cp -i‘

alias mv=‘mv -i‘

export JAVA_HOME=/usr/java/jdk1.8.0_171

export PATH=$JAVA_HOME/bin:$PATH

export HADOOP_HOME=/home/hadoop/hadoop-2.8.4

export PATH=$PATH:$HADOOP_HOME/bin

export HBASE_HOME=/home/hadoop/hbase-1.2.6

export PATH=$PATH:$HBASE_HOME/bin

export ZOOKEEPER_HOME=/home/hadoop/zookeeper-3.4.12

export PATH=$ZOOKEEPER_HOME/bin:$PATH

export STORM_HOME=/home/hadoop/apache-storm-1.2.2

export PATH=$PATH:$STORM_HOME/bin

export KAFKA_HOME=/home/hadoop/kafka_2.12-1.1.0

export PATH=$PATH:$KAFKA_HOME/bin

if [ -f /etc/bashrc ]; then

. /etc/bashrc

fi

EOF

如下圖:

基礎環境已經布置完成,後續......

基於centos7部署hadoop集群的準備環境部署