利用logrotate對Tomcat日誌進行切分

最近在做伺服器資源釋放的時候發現有一臺伺服器的find命令無法使用(原因不詳),所以之前利用cronolog對Tomcat日誌進行切分之後。是基於包含find命令的shell指令碼做的自動清理。這時就想到了用logrotate對Tomcat日誌進行切分。

1、指令碼如下:

/usr/local/www/tomcat/logs/catalina.out {

rotate 3

daily

copytruncate

notifempty

missingok

dateext

}

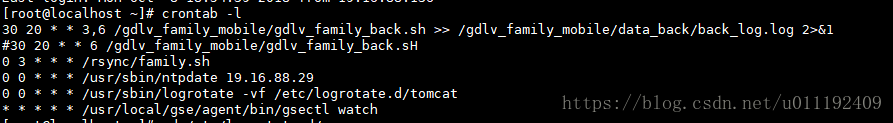

2、將命令/usr/sbin/logrotate -vf /etc/logrotate.d/tomcat編輯到crontab裡。讓其自動執行,下如圖所示

3、效果如下圖所示:

相關推薦

利用logrotate對Tomcat日誌進行切分

最近在做伺服器資源釋放的時候發現有一臺伺服器的find命令無法使用(原因不詳),所以之前利用cronolog對Tomcat日誌進行切分之後。是基於包含find命令的shell指令碼做的自動清理。這時就想到了用logrotate對Tomcat日誌進行切分。 1、指令碼如下: /usr/lo

利用logrotate對nginx日誌進行切分

1、指令碼如下: /gdsfapps/flgw/logs/nginx/*.log{ missingok dateext notifempty daily rotate 7 sharedscripts postrotate if [ -f /usr/local/nginx/logs/nginx

[Linux] 利用logrotate對MySQL日誌進行輪轉

日誌輪轉特別適用於具有固定檔名的日誌檔案,比如MySQL的出錯日誌、常規查詢日誌、慢查詢日誌等。Linux系統有一個非常好用的根據logratate可以實現自動輪轉,本文介紹它的原理和用法。 預設情況下,logrotate部署為每天執行的cron job,你可以在目錄/et

django 利用ORM對單表進行增刪改查

man api light 賦值 連接 取出 簡單 extern follow 牛小妹上周末,一直在嘗試如何把數據庫的數據弄到界面上。畢竟是新手,搞不出來,文檔也看不懂。不過沒關系,才剛上大學。今晚我們就來解釋下,要把數據搞到界面的第一步。先把數據放到庫裏,然後再把數據從庫

logstash對nginx日誌進行解析

eat sent bytes list min oat try port log logstash對nginx日誌進行解析過濾轉換等操作;配置可以用於生產環境,架構為filebeat讀取日誌放入redis,logstash從redis讀取日誌後進行操作;對user_agen

利用opencv對圖片大小進行修改

執行環境:ubuntu16.04 + opencv 2.4.13 + c++ (系統g++版本5.4.0) #include <iostream> #include <fstream> #include <opencv2/core/core.hpp> #inc

對mysqlbinlog日誌進行操作的總結包括 啟用,過期自動刪除 等

操作命令: show binlog events in ‘binlog.000016’ limit 10; reset master 刪除所有的二進位制日誌 flush logs 產生一個新的binlog日誌檔案 show master logs; / show binary log

利用Comparator對列舉型別進行排序的實現(ComparatorChain、BeanComparator、FixedOrderComparator)

背景: 工作中遇到按照類的某個屬性排列,這個屬性是個列舉型別(完全是自定義的,沒有明顯的比較標誌),現要按照要求的優先順序排列。 如一個蘋果類有大小和甜度屬性,大小有“特大”,“大”,“中”,“小”,“很小”的等級,甜度有“很甜”,“甜”

資料處理-------利用jieba對資料集進行分詞和統計頻數

一,對txt檔案中出現的詞語的頻數統計再找出出現頻率多的 二,程式碼: import re from collections import Counter import jieba def cut_word(datapath): with open(

圖解利用Jira對Scrum專案進行跟蹤管理(一)

1.建立Scrum專案 會在面板中生成對應的看板 2.編輯專案 編輯專案資訊 設定專案版本 新增功能模組 關聯工作流 可以對不同型別的問題關聯自定義

利用lucene對檔案內容進行關鍵字檢索

一、概述 關於lucene的具體介紹,請自行百度。 二、例項講解 在具體實現之前,請根據自己的要求,建立對應的路徑及檔案。 例如,我這邊建立的路徑及檔案是: D:/tools/LearningByMyself/lucene/sou

利用CNN對股票“圖片”進行漲跌分類——一次嘗試【附原始碼】

首先解釋一下標題: CNN:卷積神經網路(Convolutional Neural Network), 在影象處理方面有出色表現,不是被川普怒懟的那個新聞網站; 股票漲跌:大家都懂的,呵呵; 股票圖片:既然使用CNN,那麼如果輸入資料是股票某個週期的K線圖片就太

linux下使用awk,wc,sort,uniq,grep對nginx日誌進行分析和統計

通過對awk, wc, uniq, grep, sort等命令的組合,分析nginx的access和error日誌。 統計各種總量、單位時間量。 access.log日誌格式(見下圖) 說明: a). 按照Tab鍵拆分每項資料 b). 欄位含義(如下說明)

利用LSTM對腦電波訊號進行分類

最近我們在做利用LSTM網路對腦電波訊號(紡錘體)進行分類的相關工作。我們的資料集是來自於美國開源的睡眠資料集(national sleep research resource)https://sleepdata.org 我們獲得資

myeclipse下對tomcat專案進行debug斷點除錯

轉自:http://www.cnblogs.com/keyi/p/6022436.html 對於eclipse或myeclipse除錯J2SE專案或小應用進行斷點除錯,大家都不陌生,只要設定斷點,debug執行就OK了。但是如果是web專案,而專案是在容器中執行的,比如tomcat,resin等

Flume原始碼分析—利用Eclipse對Flume原始碼進行遠端除錯分析環境搭建(一)

一、引言 最近在學習瞭解大資料分析相關的工作,對於其中用到的收集部分用到了flume,特意花了點時間瞭解了一下flume的工作原理及工作機制。個人瞭解一個新的系統首先從概略上了解一下其基本原理後,接著從原始碼入手瞭解其部分關鍵實現部分,最後會嘗試去修改部分內容

【自然語言處理入門】01:利用jieba對資料集進行分詞,並統計詞頻

一、基本要求 使用jieba對垃圾簡訊資料集進行分詞,然後統計其中的單詞出現的個數,找到出現頻次最高的top100個詞。 二、完整程式碼 # -*- coding: UTF-8 -*- fr

利用pandas對初創公司進行資料分析

資料來源 Kesci的CrunchBase 初創公司資料集 資料集內容 acquisitions.csv: 初創公司被收購的記錄 acquisitions 初創公司被收購的記錄 company_permalink company_name

利用python對大量圖片進行重新命名

說明 在進行深度學習的過程中,需要對圖片進行批量的命名處理,因此利用簡單的python程式碼實現圖片的命名格式處理 # -*- coding:utf8 -*- import os class B

在IDEA中搭建SSM框架,利用maven對jar包進行依賴管理

本教程作為一個學習的記錄過程,讓大家快速學會在IDEA中利用maven搭建一個SSM框架。1.準備工作首先開啟IDEA建立一個maven專案,如下所示。點選下一步點選下一步最後一步專案建立好了之後的結構是這樣的:開啟這個專案的pom.xml檔案,刪除<b