Kafka概述以及安裝配置

一、Kafka概述

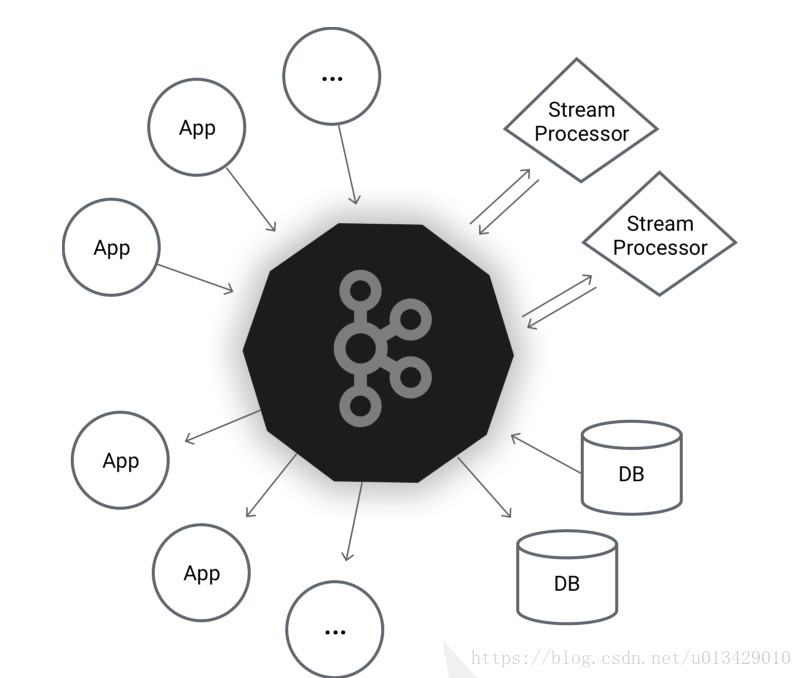

PUBLISH & SUBSCRIBE

Read and write streams of data like a messaging system.

釋出和訂閱

讀取和寫入資料流,類似訊息傳遞系統。

PROCESS

Write scalable stream processing applications that react to events in real-time.

編寫可擴充套件的流處理應用程式,以實時響應事件。

STORE

Store streams of data safely in a distributed, replicated, fault-tolerant cluster.

儲存

將資料流安全地儲存在分散式、多副本、容錯的群集中。

Kafka® is used for building real-time data pipelines and streaming apps.

It is horizontally scalable, fault-tolerant, wicked fast,

and runs in production in thousands of companies.

Kafka®用於構建實時資料管道和流應用程式。 它具有橫向可擴充套件性、容錯性、快速性,並在數千家公司的生產中執行。

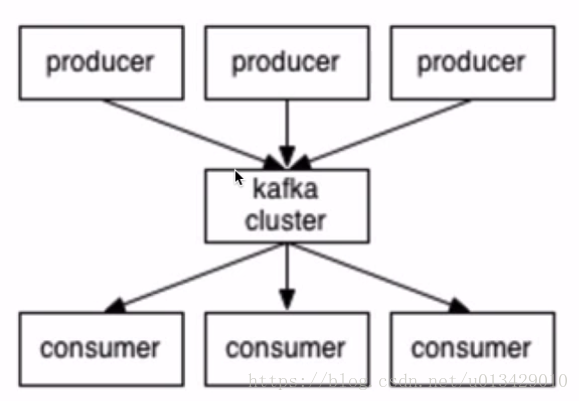

二、Kafka架構及核心概念

1)生產者

2)消費者

3)broker

4)topic

消費者和生產者約定指定的topic來傳遞特定資料

三、Kafka部署及使用

由於kafka使用scala開發

1、下載jdk1.8

到這裡檢視jdk得安裝,基本所有的編譯好的包,linux都是下載包後將路徑新增到PATH中

https://blog.csdn.net/u013429010/article/details/81744749

2、下載安裝scala

這裡我們使用scala2.11

https://downloads.lightbend.com/scala/2.11.12/scala-2.11.12.tgz

解壓tar -xzvf scala-2.11.12.tgz -C /app/cdh/

路徑新增到環境變數中

vim /etc/profile (如果有使用者的就是 vim ~/.bash_profile)

export SCALA_HOME=/app/cdh/scala-2.11.12

export PATH=$SCALA_HOME/bin:$PATH

source /etc/profile 生效後

使用scala -version檢視是否成功

3、下載安裝zookeeper

這裡我們使用cdh的zookeeper-3.4.5-cdh5.15.0.tar.gz版本,以防止版本不相容造成的問題

http://archive.cloudera.com/cdh5/cdh/5/zookeeper-3.4.5-cdh5.15.0.tar.gz

解壓tar -xzvf zookeeper-3.4.5-cdh5.15.0.tar.gz -C /app/cdh/

路徑新增到環境變數中

vim /etc/profile (如果有使用者的就是 vim ~/.bash_profile)

export ZOOKEEPER_HOME=/app/cdh/zookeeper-3.4.5-cdh5.15.0

export PATH=$ZOOKEEPER_HOME/bin:$PATH

source /etc/profile 生效後

cd $ZOOKEEPER_HOME/conf

cp zoo_sample.cfg zoo.cfg

vim zoo.cfg

dataDir=/app/tmp/zookeeper

zkServer.sh start

啟動zookeeper

4、下載安裝kafka

下載scala2.11版本對應的kafka

https://mirrors.tuna.tsinghua.edu.cn/apache/kafka/2.0.0/kafka_2.11-2.0.0.tgz

解壓tar -xzvf kafka_2.11-2.0.0.tgz -C /app/cdh/

路徑新增到環境變數中

vim /etc/profile (如果有使用者的就是 vim ~/.bash_profile)

export KAFKA_HOME=/app/cdh/kafka_2.11-2.0.0

export PATH=$KAFKA_HOME/bin:$PATH

source /etc/profile 生效

總結:

linux應用中但凡是有已經編譯的版本,就可以下載編譯完的版本,按照以上套路進行安裝

5、cd $KAFKA_HOME/config 配置 vim server.properties

單節點單broker:

# The id of the broker. This must be set to a unique integer for each broker.

broker.id=0

#這個引數是broker的id,必須設定成數字並且,多個broker之間不重複

listeners=PLAINTEXT://DEV2:9092 #當前機器hostname

log.dirs=/data/kafka/server-0

zookeeper.connect=DEV2:2181

配置完畢後啟動kafka

kafka-server-start.sh -daemon $KAFKA_HOME/config/server.properties

建立topics

kafka-topics.sh --create --zookeeper DEV2:2181 --replication-factor 1 --partitions 1 --topic test

檢視topics:

kafka-topics.sh --list --zookeeper DEV2:2181

傳送訊息:

kafka-console-producer.sh --broker-list DEV2:9092 --topic test

消費訊息:

kafka-console-consumer.sh --bootstrap-server DEV2:9092 --topic test --from-beginning

kafka-topics.sh --describe --zookeeper DEV2:2181

kafka-topics.sh --describe --zookeeper DEV2:2181 --topic test

注意:

如果在引數中新增–from-beginning ,則每次重啟kafka-console-consumer.sh後都會從頭開始消費