爬蟲工具--Beautifusoup

import requests

from bs4 import BeautifulSoup

s=requests.Session()

r=s.get('https://www.tumblr.com/login')

htmldoc=r.text

test=BeautifulSoup(htmldoc)

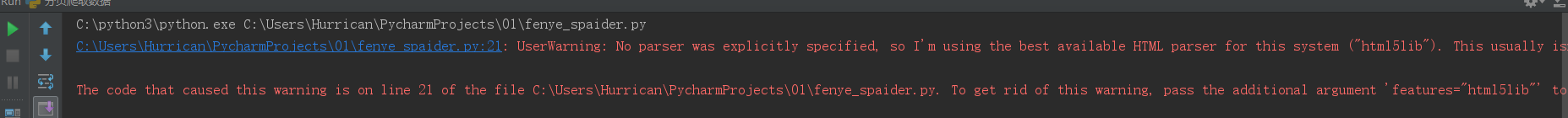

報錯資訊

首先這不是錯,是警告,引發原因是你的操作雖然沒有錯,但卻不合規範。

BeautifulSoup(content, "html5lib")安裝 html5lib

才符合規範相關推薦

爬蟲工具--Beautifusoup

import requests from bs4 import BeautifulSoup s=requests.Session() r=s.get('https://www.tumblr.com/login') htmldoc=r.text test=BeautifulSoup(htmldoc)報錯資訊

簡單實現nodejs爬蟲工具

headers 被拒絕 被拒 jee windows agent 網頁 模塊 require 約30行代碼實現一個簡單nodejs爬蟲工具,定時抓取網頁數據。 使用npm模塊 request---簡單http請求客戶端。(輕量級) fs---nodejs文件模塊。

【Python3~爬蟲工具】使用requests庫

python3 爬蟲 requestsurllib使用方式參考如下網址:http://blog.51cto.com/shangdc/2090763 使用python爬蟲其實就是方便,它會有各種工具類供你來使用,很方便。Java不可以嗎?也可以,使用httpclient工具、還有一個大神寫的webmagic框架

最新的爬蟲工具requests-html

rom 聽說 {} 推薦 接口 人員 查找 python 2 日子 使用Python開發的同學一定聽說過Requsts庫,它是一個用於發送HTTP請求的測試。如比我們用Python做基於HTTP協議的接口測試,那麽一定會首選Requsts,因為它即簡單又強大。現在作者

【爬蟲工具】嗶哩嗶哩外掛姬(bilibili-plugin)

完整原文(含原始碼):http://exp-blog.com/2018/09/09/pid-2223/ (轉載請註明出處,僅供分享學習,嚴禁用於商業用途) 宣告 寫這個外掛純粹是出於學習目的,此博文主要作用是功能展示 之後會圍繞這個外掛,寫一個系

python爬蟲工具集合

python爬蟲工具集合 大家一起來整理吧!強烈建議PR。這是初稿,總是有很多問題,而且考慮不全面,希望大家支援! 原始檔 主要針對python3 常用庫 urllib - Urllib是python提供的一個用於操

爬蟲工具【Fiddler學習】Fiddler教程,比較經典全面-----------四

https://blog.csdn.net/persistencegoing/article/details/84376427 簡介 Fiddler(中文名稱:小提琴)是一個HTTP的除錯代理,以代理伺服器的方式,監聽系統的Http網路資料流動,Fiddler可以也可以讓你

爬蟲工具【Fiddler學習】Fiddler面板的詳細介紹-----------三

https://blog.csdn.net/persistencegoing/article/details/84376427 下面開始分析主介面的功能區: 1、Fiddler選單欄,上圖黑色部分,包括捕獲http請求,停止捕獲請求,儲存http請求,載入本地session

爬蟲工具【Fiddler學習】Fiddler抓包HTTPS請求和手機抓包-----------二

https://blog.csdn.net/persistencegoing/article/details/84376427 一、安裝Fiddler 百度搜索:Fiddler抓包工具,然後安裝即可。 然後開

爬蟲工具【Fiddler學習】Fiddler簡介和Web抓包應用-----------一

https://blog.csdn.net/persistencegoing/article/details/84376427 一、Fiddler是什麼? Fiddler是一個http協議除錯代理工具,它能夠記錄並檢查所有你的電腦和網際網路之間的http通訊,設定

Windows下安裝配置爬蟲工具Scrapy及爬蟲環境

爬蟲工具Scrapy在Mac和Linux環境下都相對好裝,但是在Windows上總會碰到各種莫名其妙的問題。本文記錄下Scrapy在Window上的安裝過程。 本文是基於Python2.7及Windows 10安裝Scrapy及各種爬蟲相關庫。 下載安裝Sc

移動端爬蟲工具與方法介紹

本文來自網易雲社群 作者:王濤 本文主要介紹了移動端爬蟲的工具與方法,作為一個入門的大綱。沒有詳細介紹的也給出了本人學習過程中借鑑的資料的連結,適合對移動端爬蟲感興趣的同學入門。 一、抓包模擬 基本原理(中間人攻擊) 中間人攻擊:在中間人攻擊中,攻擊主機通常截斷客戶端和伺服器的加密通訊。攻擊機以自己的證書

【爬蟲】python爬蟲工具scrapy的安裝使用

關於使用方法及教程參考如下: Scrapy中文官方入門教程 本文章的安裝環境如下 window10 python3.X 文中使用的是python3.5,安裝方法如下 第一步,安裝pypiwin32 pip install pypiwin32 第二步,安裝Twisted

安利一個輕量級爬蟲工具node-crawler

地址 實質 爬蟲無非就是分析網頁, 分析介面, 取得你想要的資料, 取得資料有兩種方式: 對於直接請求得到的是靜態頁面, 直接分析 html, 取得自己需要的資料 還有就是通過 api 介面獲取到的

吃貨必看:如何用爬蟲工具快速獲取當地1000+5星網紅餐廳資訊?

人們都說,認識一座城,從認識它的美食開始。 作為一名妥妥的吃貨,小八做旅行攻略時,最最最愛的就是美食PART啦! 小八最常用的是大眾點評網,簡直吃貨神器。(小八木有收廣告費哦) 話說做攻略也是很花時間的哦,需要一個個點選進去,篩選,記錄,一晃神2個小

友盟頁面爬蟲工具

Device_Rank_Spider.py #coding=utf-8 #--------------------------------------- # 程式:友盟爬蟲 # 作者:ewang # 日期:2016-7-13 # 語言:Python 2.

關於爬蟲工具。

請求獲取網頁資訊類工具:urllib,urllib3,requests注:在python2.x裡面有urllib和urllib2;在python3.x裡面就把urllib和urllib2合成一個urllib;urllib3是在python3.x了裡面新增的第三方擴充套件.Re

wget 爬蟲工具 遞迴下載網址

wget -r -l 3 -p -np -k xxx.com/xxx 不可以寫 http wget加上引數之後,即可成為相當強大的下載工具。 wget命令詳解 wget -r -l 3 -p -np -k http://xxx.com/xxx -r, -

HtmlParser 一個不錯的網站爬蟲工具

有時候我們需要在網上獲取自己需要的內容時,而且需求量達到一定程度時,就要通過程式碼來實現重複的操作。 當用Java來幫我們解決這個問題時,我們又如何通過Java來過濾掉多餘的內容,剩餘自己想要的資訊呢,這時HtmlParser會是一個不錯的選擇。 HtmlParser是一個

GitHub上Python的爬蟲工具

網路相關 通用 urllib - 網路庫(標準庫)grab - 網路庫(基於pycurl)urllib3 - 具有執行緒安全連線池、檔案psot支援、高可用的Python HTTP庫RoboBrowser - 一個無需獨立瀏覽器即可訪問網頁的簡單、pythonic的