hive 日誌配置/表頭配置

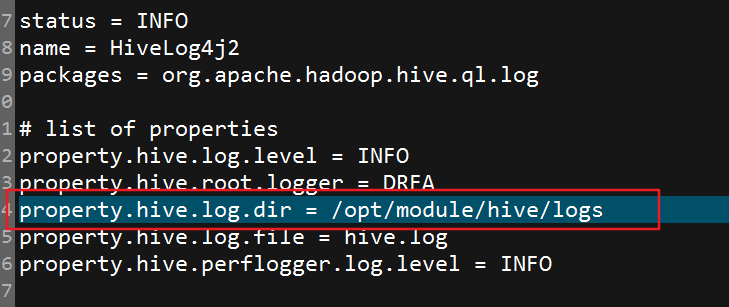

1.日誌配置,拷貝hive/conf下的hive-log4j2.properties.template為hive-log4j2.properties,修改日誌目錄,接下來在建立hive/logs,目錄即可

2.表頭配置,在hive-site,xml中增加如下屬性

1 <property>

2 <name>hive.cli.print.header</name>

3 <value>true</value>

4 </property>

5

6 <property>

7 <name>hive.cli.print.current.db</name>

8

重啟hive即可

相關推薦

hive 日誌配置/表頭配置

1.日誌配置,拷貝hive/conf下的hive-log4j2.properties.template為hive-log4j2.properties,修改日誌目錄,接下來在建立hive/logs,目錄即可 2.表頭配置,在hive-site,xml中增加如下屬性 1 <pr

[轉]django 日誌logging的配置以及處理

handler mat exc 管理 系統 critical bdn ecs 自己的 http://davidbj.blog.51cto.com/4159484/1433741 日誌在程序開發中是少不了的,通過日誌我們可以分析到錯誤在什麽地方,有什麽異常。在生產環境

日誌slf4j+log4j配置問題

root -- output onf 類名.class 新的 是否 cati ring 簡介slf4j 相當於抽象類log4j 相當於實現,當然還有其他的實現,如logback,jdk自帶的logging等 具體配置maven 配置 pom.xml加入 <

Hive的安裝和配置

jdk com ado ast utf-8 desc onf ava font 前提是:hadoop必須已經啟動了*** 1°、解壓hive的安裝包 [[email protected] soft]# tar -zxvf ap

MySQL慢查詢日誌相關的配置和使用。

其他 進制 數據 mps 執行 不存在 時間 tex http MySQL慢查詢日誌提供了超過指定時間閾值的查詢信息,為性能優化提供了主要的參考依據,是一個非常實用的功能,MySQL慢查詢日誌的開啟和配置非常簡單,可以指定記錄的文件(或者表),超過的時間閾值等就可以記

log4j 日誌分類級別配置

class col %d ger app 輸出 分類 ogg code 將日誌的error和info分別打印輸出,以便於查看### set log levels ### log4j.rootLogger=info,error,info log4j.appender.st

debian安裝ELK日誌服務器配置apt鏡像源

debian安裝ELK日誌服務器apt elk鏡像源;elk 網上有很多寫Ubantua安裝ELK日誌服務的文檔資料,但是很少有Debian安裝的文檔。因為前期對ELK接觸很少,使用Debian安裝總是在配置apt安裝源的時候無法進行安裝。經過扒翻資料,終於找到ELK官網給出的正解。如下:1、安裝ja

Apache日誌輪詢配置詳解

Apache日誌輪詢介紹 Apache日誌輪詢配置 Apache虛擬主機日誌輪詢 Apache日誌輪詢配置詳解1、apache日誌輪詢作用隨著服務器的不斷運行,日誌文件會越來越大,如果不小心把日誌文件放到了/var之類位置,日誌文件可能寫滿分區,從而導致服務器被迫停止運行。這種事情確實曾經發生過。

Hadoop 2.0中的日誌收集以及配置方法

命名 tail his als 作業 fix enable 決定 RM Hadoop中的日誌包含三個部分,Application Master產生的運行日誌和Container的日誌。 一、ApplicationMaster產生的作業運行日誌 Application Mas

訪問日誌不記錄靜態文件、配置訪問日誌切割、配置靜態元素過期時間

Linux訪問日誌不記錄指定類型的文件 一個網站會有很多元素,尤其是圖片、js、css等靜態的文件非常多,用戶每請求一個頁面就會訪問諸多的圖片、js等靜態元素,這些元素的請求都會被記錄在日誌中。如果一個站點訪問量很大,那麽訪問日誌文件增長會非常快,這不僅對於服務器的磁盤空間造成影響,更重要的是會影響磁盤的讀寫

統一日誌ELK部署配置(1)——filebeat

日誌收集一、整體架構 二、filebeat介紹fielbeat是基於logstash-forwarder的源碼改造而來,換句話說:filebeat就是最新版的logstash-forwarder。他負責從當前服務器獲取日誌然後轉發給Logstash或Elasticserach進行處理。Filebeat是一個日

統一日誌ELK部署配置(2)——kafka

日誌收集前提:你服務器上已經安裝並配置了java運行環境; 一、zookeeper安裝1、從zookeeper官網:http://zookeeper.apache.org/ 下載;我這裏下載的是zookeeper-3.4.9.tar.gz;2、解壓到你安裝目錄:tar-zxvf zookeeper-3.4.9

統一日誌ELK部署配置(3)——logstash

日誌收集一、下載從官網下載:https://www.elastic.co/downloads/logstash ;二、配置1、修改config下的jvm.options:1??根據需要修改最大堆和最小堆2??我這裏使用的jdk1.8,gc使用G1,所以需要重新配置;-XX:+UnlockDiagnosticV

統一日誌ELK部署配置(5)——kibana

iba 需要 gem 字段 服務 nag mes max 根據 kibana的配置非常簡單,只需要在kibana.yml中配置一下Elasticsearch集群地址。下面介紹一下查看索引的配置:在Management中的Advanced Setting:1、時間:1??時間

Hive metastore三種配置方式

org erro connect 其中 art ont failed log hive Hive的meta數據支持以下三種存儲方式,其中兩種屬於本地存儲,一種為遠端存儲。遠端存儲比較適合生產環境。Hive官方wiki詳細介紹了這三種方式,鏈接為:Hive Metastore

日誌格式的配置

格式 日誌格式 優先 類目 所在 換行 行數 回車換行 err 常用的內置環境信息: %p : 輸出日誌的優先級,即 debug、info、warn、error、fatal %d : 輸出日誌時間點的日期或時間,在其後指定格式,如 %d{yyy MMM dd HH:mm:s

CDH5.15.1 hive 連接mongodb配置及增刪改查

uri str prope upd info with oot ODB ble 1. 下載 wget http://repo1.maven.org/maven2/org/mongodb/mongo-hadoop/mongo-hadoop-hive/2.0.2/mongo-h

Java日誌使用slf4j 配置log4j後,有日誌文件 但日誌文件內容為空

actor 輸出 ole sym ack 拼接 world 輸出參數 %d SLF4J的全稱是Simple Logging Facade for Java,即簡單日誌門面。 SLF4J並不是具體的日誌框架,而是作為一個簡單門面服務於各類日誌框架,如java.util.log

Hadoop之Hive的安裝與配置

Hive目前底層還是用MapReduce,以後可能會用Spark,Tez。Hive差不多是一個查詢介面,你的SQL語句還是會翻譯成MapReduce任務的,你用explain就可以看到這些任務的執行計劃。下面介紹下hive的基礎安裝過程以及簡單的使用。 環境資訊: 虛擬機器數量:

【Java日誌】log4j配置詳解

#設定日誌的級別,以及日誌所使用的appender log4j.rootLogger=all, console, file ### 控制檯 ### log4j.appender.console=org.apache.log4j.ConsoleAppender log4j.appender.cons