Spark集群搭建

Spark集群搭建

一、環境說明

1、機器:3臺虛機(hadoop01/hadoop02/hadoop03)

2、Linux版本:CentOS 6.5

3、JDK版本:1.8

4、Hadoop版本:hadoop-2.5.2

5、Spark版本:Spark-1.3.1

6、Scala版本:scala-2.10.6

二、安裝步驟

1、安裝Hadoop,這裏不做具體講解

172.16.1.156 hadoop01

172.16.1.157 hadoop02

172.16.1.158 hadoop03

2、下載Spark

如果是基於Hadoop部署spark,可以對應hadoop的版本下載spark

下載地址:http://spark.apache.org/downloads.html

3、下載Scala

下載地址:http://www.scala-lang.org/download/2.10.6.html

4、安裝Scala

解壓:tar -zxvf scala-2.10.6.tgz

5.安裝spark

解壓:tar -zxvf spark-1.3.1-bin-hadoop2.4.tgz

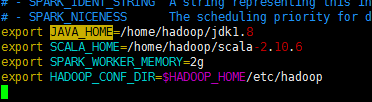

6、在~/.bash_profile中配置環境變量

QQ截圖20160427162720.png

7、配置spark_env.sh(Spark運行的環境變量)

修改spark_env.sh.template復制為spark_env.sh

mv spark_env.sh.template spark_env.sh

配置以上環境變量

export JAVA_HOME=/home/hadoop/jdk1.8

export SPARK_MASTER_IP=spark01

export SPARK_MASTER_PORT=7077

export SPARK_WORKER_CORES=1

export SPARK_WORKER_INSTANCES=1

8、復制hadoop01節點配置好的spark到其他節點

scp -r ~/spark-1.3.1-bin-hadoop2.4/ hadoop@hadoop02:~/

scp -r ~/spark-1.3.1-bin-hadoop2.4/ hadoop@hadoop03:~/

9.spark的web管理界面 :http://172.16.1.156:8080/

spark WEBUI界面:http://172.16.1.156:4040/jobs/

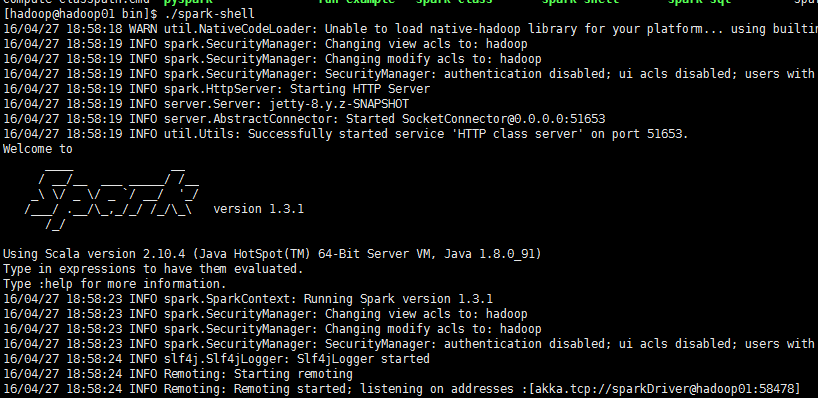

spark-shell啟動:

到spark的bin目錄下執行 ./spark-shell

Spark集群搭建