Hadoop解決WARN hdfs.DFSClient: DataStreamer Exception org.apache.hadoop.ipc.RemoteException問題

昨天配置完Hadoop環境搭建了集群后,今天跟著視訊操作叢集,啟動叢集沒啥問題,然操作叢集的時候出了問題(上傳檔案失敗)

由於本人是剛學,是個新手,這篇文章有問題之處請大家指出

自己在解決這個問題的時候左弄弄右弄弄被自己解決了,詳細步驟也無法給出。

總結如下:

1、看自己是否關閉防火牆了,防火牆沒關可能導致這個原因(我是跟著老師的視訊來學的,老師的視訊之前關閉過防火牆,我由於昨天關過電腦,再開Linux的時候防火牆是預設開啟的)

2、在core-site.xml中沒有配置hadoop執行時產生的檔案的儲存目錄(老師的視訊中只配置了NameNode,沒有配置hadoop的儲存目錄 )

我的防火牆沒有關閉,我關了後還是不行,後面看別人說是使用hadoop namenode -format格式化時格式化了多次造成那麼spaceID不一致

這是別人的解決步驟:

我當時看到這裡的時候一直找data目錄,沒找到,,然後看老師的筆記才發現

我少配置了這個

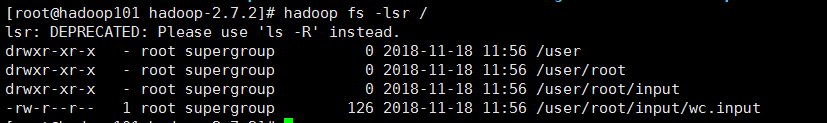

我重新配置完後,重啟叢集:

1、stop-dfs.sh

2、start-dfs.sh

就可以了

![]()

相關推薦

Hadoop解決WARN hdfs.DFSClient: DataStreamer Exception org.apache.hadoop.ipc.RemoteException問題

昨天配置完Hadoop環境搭建了集群后,今天跟著視訊操作叢集,啟動叢集沒啥問題,然操作叢集的時候出了問題(上傳檔案失敗) 由於本人是剛學,是個新手,這篇文章有問題之處請大家指出 自己在解決這個問題的時候左弄弄右弄弄被自

WARN hdfs.DFSClient: DataStreamer Exception org.apache.hadoop.ipc.RemoteException(java.io.IOExcept

使用web UI執行pi例項驗證hadoop叢集是否啟動成功 報如下錯誤: Number of Maps = 10 Samples per Map = 10 18/09/29 19:32:55 WARN hdfs.DFSClient: DataStreamer Ex

Hadoop異常 hdfs.DFSClient: DataStreamer Exception: org.apache.hadoop.ipc.RemoteException

機器環境:ubuntu 11.10 64位 hadoop版本:1.0.1 [email protected]:~/sse/hadoop/hadoop-1.0.1# bin/hadoop fs -put conf input 12/03/15 20:45:37

HDFS上傳文件錯誤--hdfs:DFSClient:DataStreamer Exception

.cn .com ges xxx -h 分享 p地址 str exce 今天上傳文件的時候發現傳上去的文件為空,錯誤提示如上述所示,原來是IP地址改掉了對呀應etc/hosts下面的IP地址也要改變,永久改ip命令-ifconfig eth0 xxx·xxx·xxx·xxx

訪問HDFS報錯:org.apache.hadoop.security.AccessControlException: Permission denied

import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; public class TestHDFS { publ

【已解決】ERROR:"Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient"

狀況:將hive的元資料庫換為Mysql時發生的錯誤 配置:ubuntu16.04+hive3.0.0+mysql8.0.0 原因:換資料庫時沒有和hive成功通訊。 在命令列執行: 1.

win下使用hadoop,報錯內容擷取如下UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0

##解決:在根路徑下建立類 \org\apache\hadoop\io\nativeio\NativeIO.java ##用此類替換預設原始碼中的類即可(只需建立類) /** Licensed to the Apache Software Foundation

hadoop解決Exception in thread "main" java.lang.NoClassDefFoundError: org/apache/hadoop/yarn/util/Apps

linux+eclipse+本地執行WordCount丟擲下面異常: Exception in thread "main" java.lang.NoClassDefFoundError: org/apache/hadoop/yarn/util/Apps。 解決:沒有把yar

解決DataNode不能全部啟動問題 org.apache.hadoop.hdfs.server.datanode.DataNode: Initialization failed for Block

問題描述: FATAL org.apache.hadoop.hdfs.server.datanode.DataNode: Initialization failed for Block pool <registering> (Datanode Uu

錯誤: 找不到或無法載入主類 org.apache.hadoop.hdfs.server.namenode.NameNode 問題解決

問題描述: 執行指令 在hadoop安裝路徑下執行 bin/hdfs namenode -format 時,出現“錯誤:找不到或無法載入主類org.apache.hadoop.hdfs.server.namenode.NameNode" 問題分析: 此問題是由於在

解決kylin報錯 ClassCastException org.apache.hadoop.hive.ql.exec.ConditionalTask cannot be cast to org.apache.hadoop.hive.ql.exec.mr.MapRedTask

conf lan exe hive oop ann 關於 .exe map 方法:去掉參數SET hive.auto.convert.join=true; 從配置文件$KYLIN_HOME/conf/kylin_hive_conf.xml刪掉 或 kylin-gui的cu

解決kylin查詢報錯:org.apache.kylin.rest.exception.InternalErrorException

name tex ada dha from 異常 bstr sca lap 報錯信息: 2017-06-26 20:06:58,925 ERROR [Query 12e9c054-760c-4615-9699-b1f06724c9b6-328] service.Que

Exception in thread "main" java.lang.UnsatisfiedLinkError: org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Ljava/lang/String;I)Z

檢查 post source 系統 RM 方法 internal .com 2.6 1、window操作系統的eclipse運行wordcount程序出現如下所示的錯誤: Exception in thread "main" java.lang.Unsatisfied

執行HBase shell時出現ERROR: org.apache.hadoop.hbase.ipc.ServerNotRunningYetException: Server is not running yet錯誤解決辦法(圖文詳解)

cep ESS 關註 align comm util code ade dap 不多說,直接上幹貨! [kfk@bigdata-pro01 bin]$ jps 1968 NameNode 2385 ResourceManager 2259 Jou

org.apache.hadoop.mapred.FileAlreadyExistsException 解決方案

Exception in thread “main” org.apache.hadoop.mapred.FileAlreadyExistsException: Output directory temp/preparePreferenceMatrix/itemIDIndex

解決org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Ljava/lang/String;I)Z

首先 對於操作的目的資料夾許可權做檢查,如沒有則: hadoop fs -chmod -R a+rwx /tmp/hadoop-yarn/staging 其次把這個檔案包括進來,可以從hadoop原始碼包裡面找,本文也附下載 其中access方法做了如下修改: public stat

問題org.apache.hadoop.io.nativeio.NativeIO$Windows.createDirectoryWithMode0(Ljava/lang/String;I)V的解決方案

編號001(這一行為我自己為了方便起的標識,你們可以忽略……) 最近編寫了一個mapreduce程式,在eclipse中執行發現出現這個問題,百度各種方案都不行,花了好久才解決,現在把最近看過和親測過的方案整理如下,希望能讓別人早日出坑。 前提條件: Hadoop叢集(had

ERROR org.apache.hadoop.hdfs.server.datanode.DataNode: localhost:50010:DataXceiver error processing

ERROR org.apache.hadoop.hdfs.server.datanode.DataNode: localhost:50010:DataXceiver error processing WRITE_BLOCK operation src: /192.168.0

ERROR org.apache.hadoop.hdfs.server.datanode.DataNode: java.io.IOException: Incompatible namespaceID

問題的產生: 今天遇到了一個問題 我執行了 https://blog.csdn.net/lzc4869/article/details/Hadoop namenode -format 之後 啟動hadoop: https://blog.csdn.net/lzc4869/art

Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.tez.TezTask問題解決

發現這個報錯後,就網上查資料嘍。目前看下來兩種情況比較常見,不排除其他可能。一般排查方式也是檢視hive日誌,job日誌在你的HIVEHOME/conf的hive?log4j.properties下的hive.log.dir={java.io.tmpdir}/u