寫簡單的爬蟲都需要什麽

阿新 • • 發佈:2018-11-24

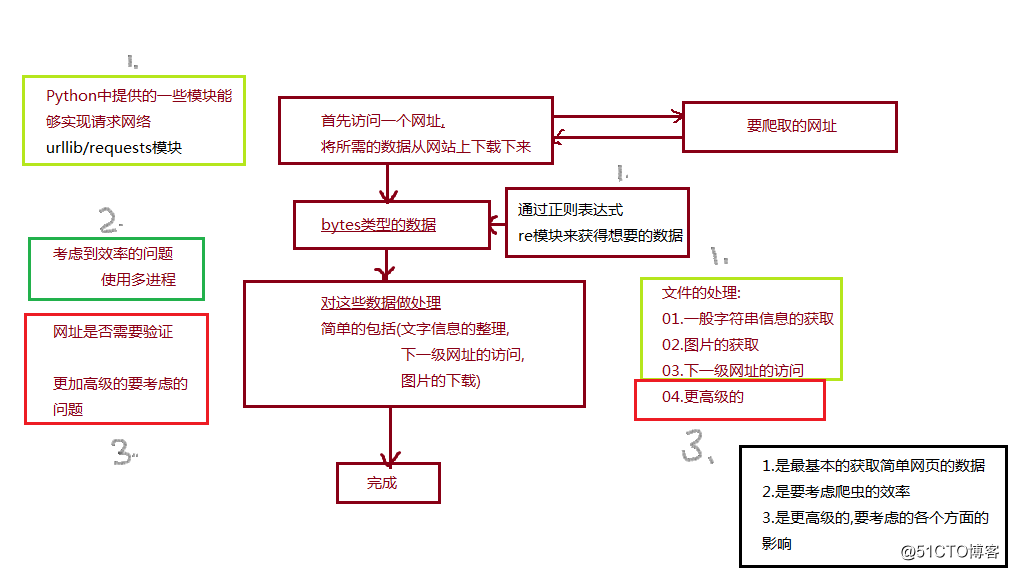

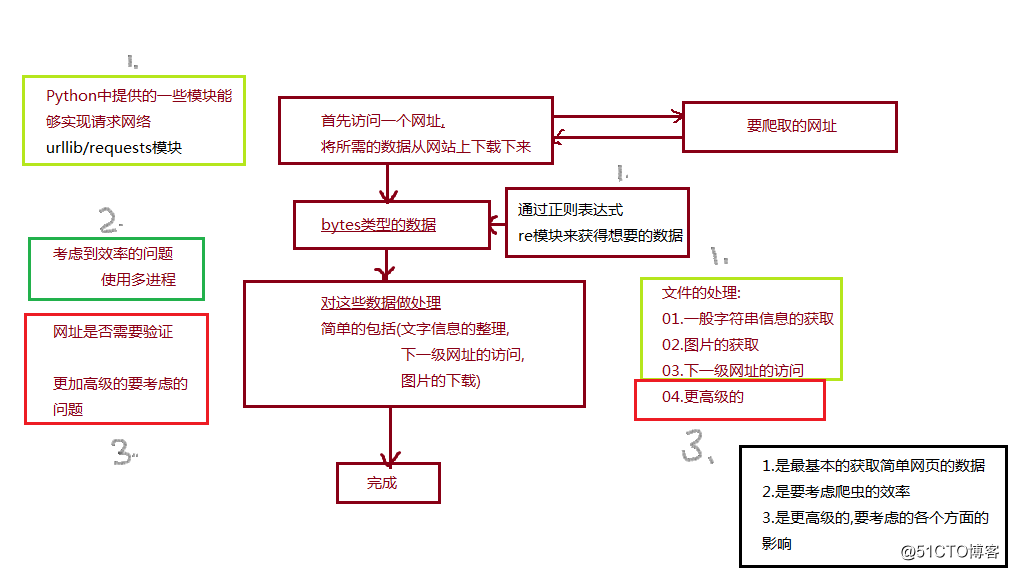

charm -a user ima dac 爬蟲 apple 無聊 app 寫爬蟲都需要些什麽呢,

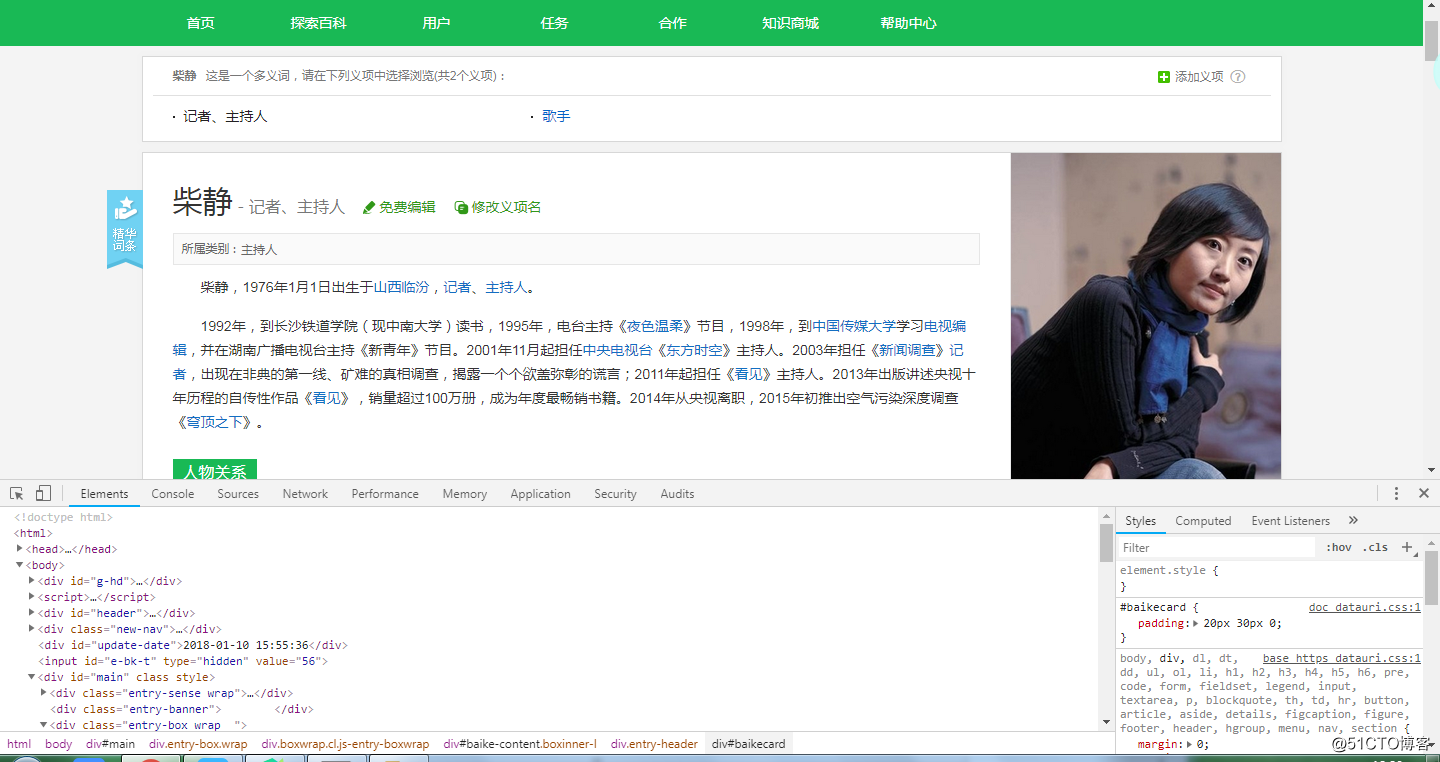

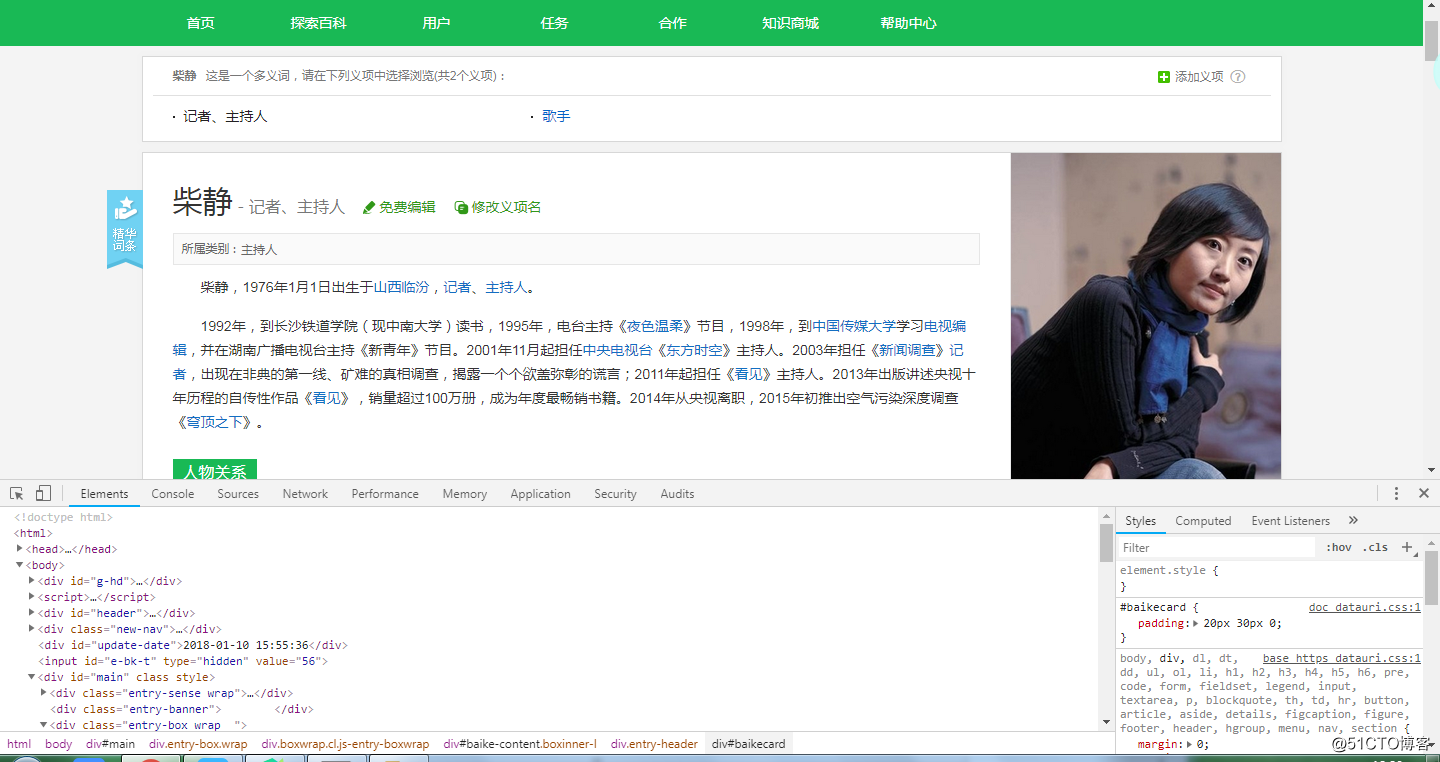

A 要爬取的網址難度的大小 (選擇谷歌對要爬取的網址源代碼進行分析)

B 借用Python中的模塊urllib與requests 對網址進行請求與訪問

以requests為例:(requests模塊的導入見:http://blog.51cto.com/13747953/2321389)

a 下載圖片

A 要爬取的網址難度的大小 (選擇谷歌對要爬取的網址源代碼進行分析)

B 借用Python中的模塊urllib與requests 對網址進行請求與訪問

以requests為例:(requests模塊的導入見:http://blog.51cto.com/13747953/2321389)

a 下載圖片

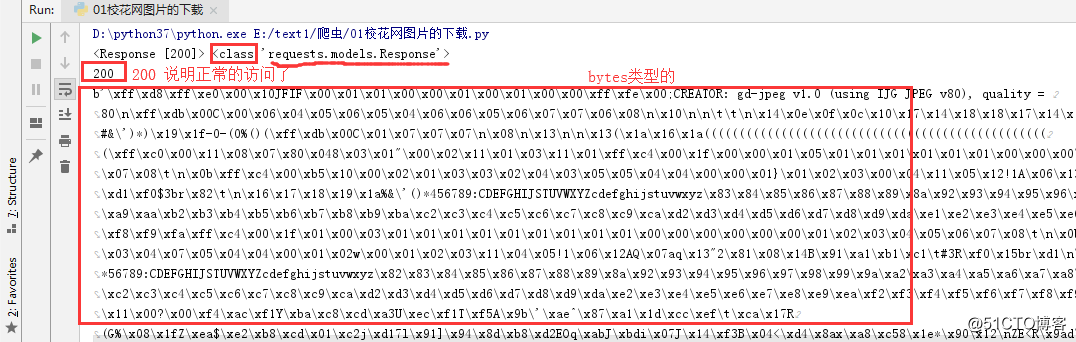

import requests ret=requests.get(‘http://×××w.xiaohuar.com/d/file/20180724/40d83a6709eca21137dcdd80ee28c31b.jpg‘) print(ret,type(ret)) print(ret.status_code) print(ret.content) with open(r‘E:\text1\爬蟲\text_png\p1.png‘,‘wb‘) as f: f.write(ret.content)

b 基本文字信息的獲取

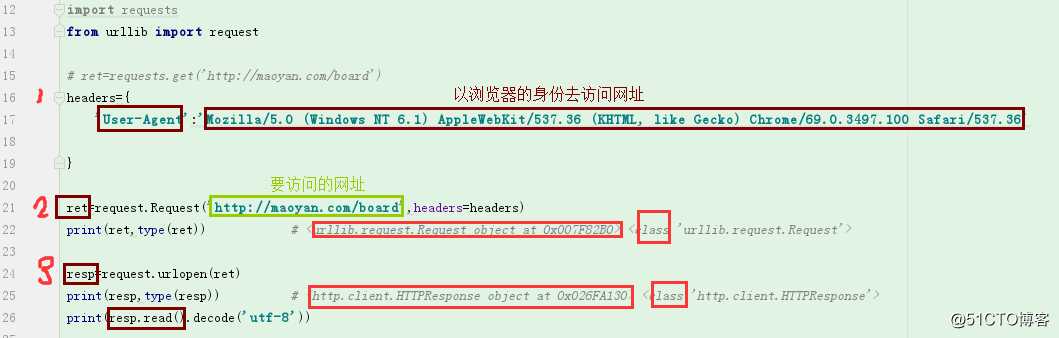

import requests from urllib import request # ret=requests.get(‘http://maoyan.com/board‘) headers={ ‘User-Agent‘:‘Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36‘ } ret=request.Request(‘http://maoyan.com/board‘,headers=headers) resp=request.urlopen(ret) print(resp,type(resp)) print(resp.read().decode(‘utf-8‘))

這裏不用requests 模塊是因為在請求的過程中返回了403的錯誤

猜想可能的原因是:網址的反爬蟲機制發現了來自pycharm的請求;

所以可以用urllib(Python自帶的模塊)提供的request模塊

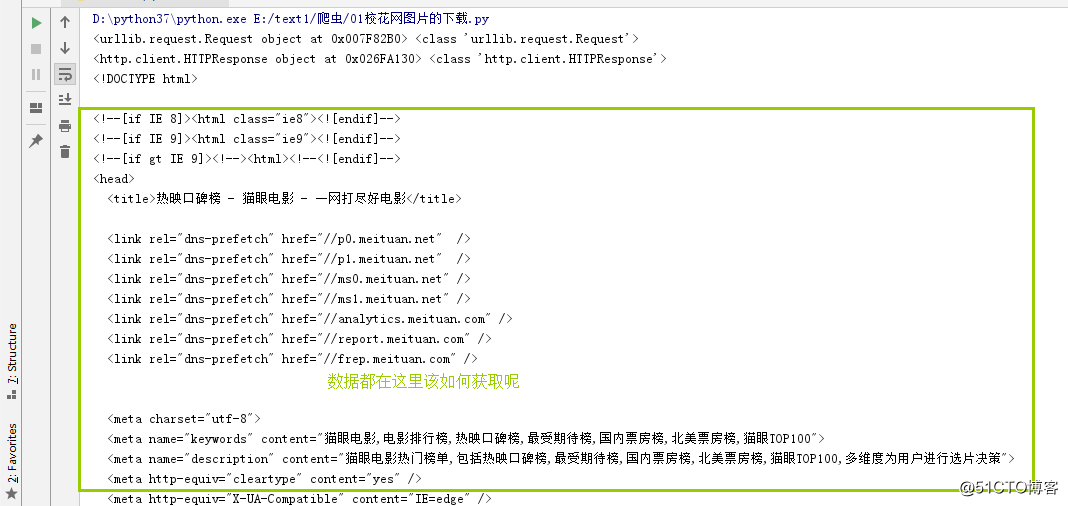

結果如下:

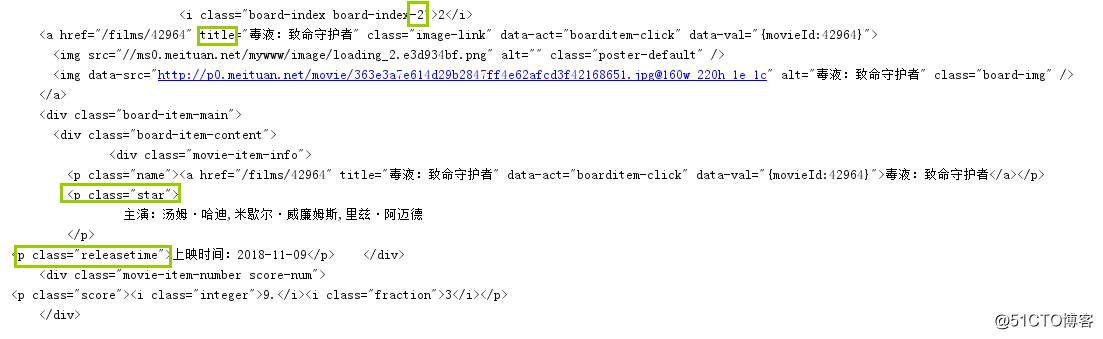

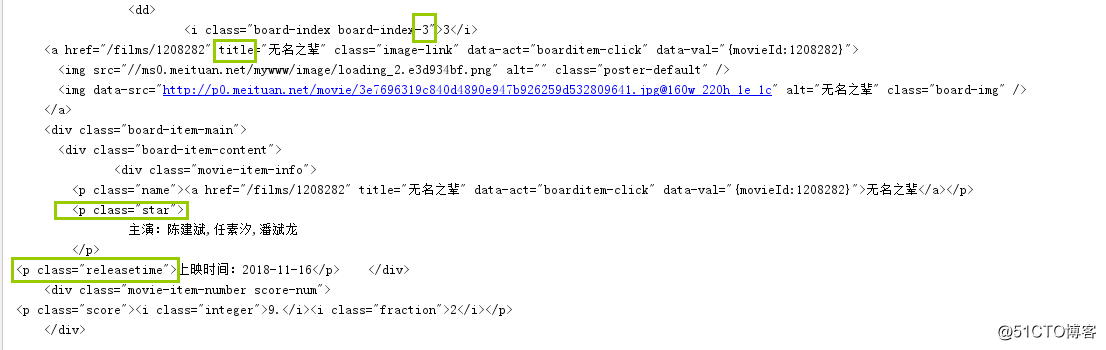

C 如何從B-b中獲取的文字數據中提取出自己想要的數據呢

a 分析數據的相同點

利用正則表達式與re模塊

詳見:(未完)

(程序猿很無聊多多指教交流)

寫簡單的爬蟲都需要什麽