Hadoop windows本地環境安裝

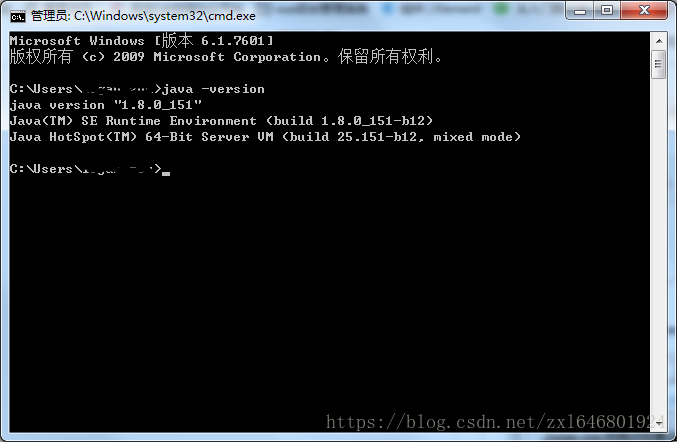

hadoop使用java編寫,所以windows安裝和java一樣也需要配置環境變數。

一、下載所需檔案

- JDK下載地址,jdk1.8下載

- Hadoop下載,hadoop下載,進去後找到一個版本然後點選 Binary download 下載到本地。

- Hadoop windows環境編譯工具,winutils下載 ,下載後解壓出來

二、安裝檔案

- jdk安裝,jdk安裝並不複雜,這裡就不詳細介紹了,我的安裝目錄是 C:\Program Files\Java\jdk1.8.0_151

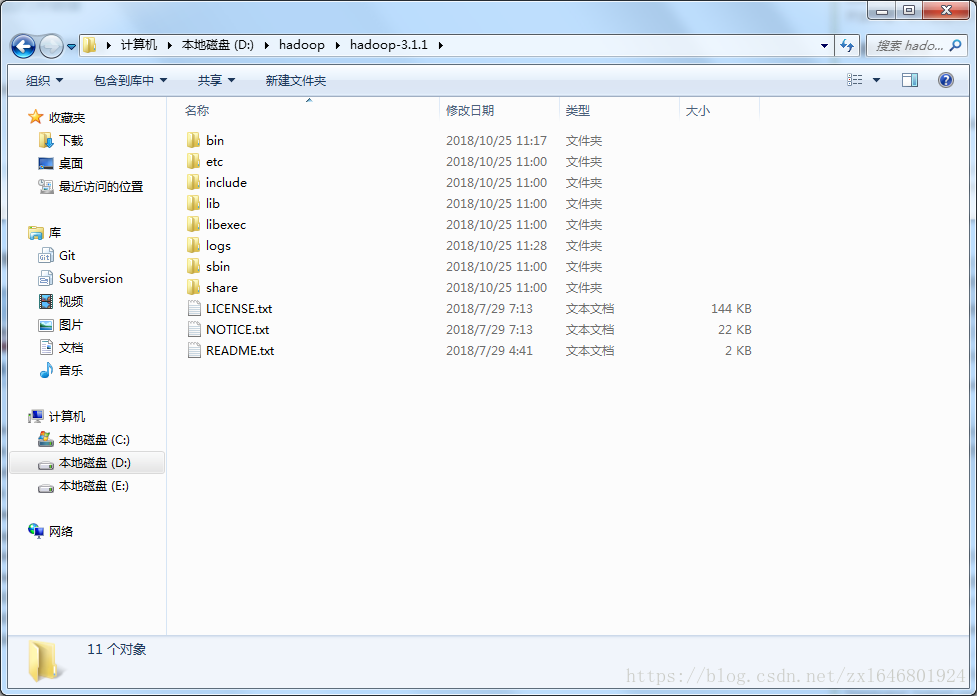

- hadoop安裝,由於下載的hadoop檔案是不用安裝的,我們只需要解壓出來就可以了 解壓目錄 D:\hadoop\hadoop-3.1.1

三、環境變數配置

- jdk環境變數配置,網上很多這裡也就不詳細說了

- Hadoop環境變數安裝,環境變數和java的安裝方式一樣

先新建一個HADOOP_HOME,裡面變數值為 D:\hadoop\hadoop-3.1.1

然後在Path變數值後面追加 %HADOOP_HOME%\bin; ,至此hadoop的環境變數就配置完了。

四、配置hadoop檔案

- 進入hadoop目錄下面的etc D:\hadoop\hadoop-3.1.1\etc\hadoop 找到 core-site.xml檔案並使用編輯器開啟,複製下面內容進去

<configuration> <property> <name>hadoop.tmp.dir</name> <value>/D:/hadoop/workspace/tmp</value> </property> <property> <name>dfs.name.dir</name> <value>/D:/hadoop/workspace/name</value> </property> <property> <name>fs.default.name</name> <value>hdfs://localhost:9000</value> </property> </configuration>

- 在找到 mapred-site.xml 檔案並開啟,複製下面內容進去

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>hdfs://localhost:9001</value>

</property>

</configuration>

- 找到 hdfs-site.xml 檔案並開啟,複製下面內容進去

<configuration>

<!-- 這個引數設定為1,因為是單機版hadoop -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/D:/hadoop/workspace/data</value>

</property>

</configuration>

- 找到 yarn-site.xml 檔案並開啟,複製下面內容進去

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

- 找到 hadoop-env.cmd 檔案並開啟,將JAVA_HOME用 @rem註釋掉,編輯為JAVA_HOME的路徑,然後儲存。

@rem set JAVA_HOME=%JAVA_HOME%

set JAVA_HOME=C:\Program Files\Java\jdk1.8.0_151注意這裡會有個錯誤,由於我jdk安裝在C盤的 program files目錄下,這個資料夾有個空格,後面會報錯

所以這裡我們修改成 ,使用 PROGRA~1 代替

@rem set JAVA_HOME=%JAVA_HOME%

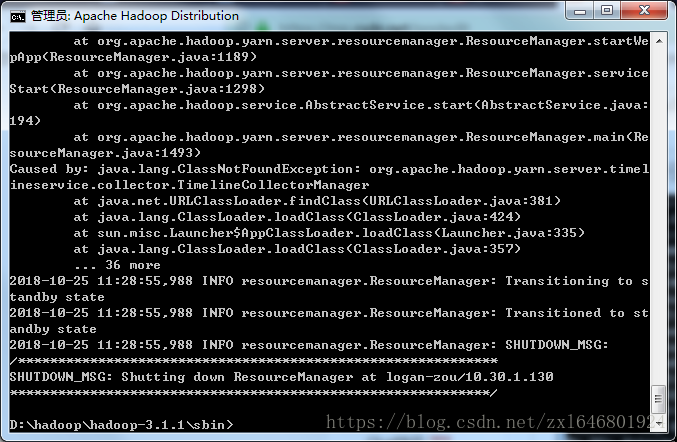

set JAVA_HOME=C:\PROGRA~1\Java\jdk1.8.0_151五、替換檔案

解壓我們之前下載的 winutils-master 檔案,找到符合自己的版本,我這裡找的是 D:\hadoop\winutils-master\hadoop-3.0.0 進入資料夾拷貝整個bin檔案替換掉 hadoop的bin資料夾,即 D:\hadoop\hadoop-3.1.1 下面的bin

六、執行

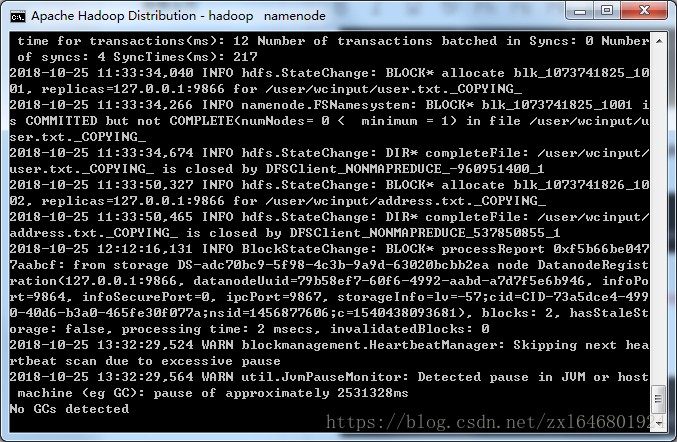

1.執行cmd視窗,執行hdfs namenode -format。

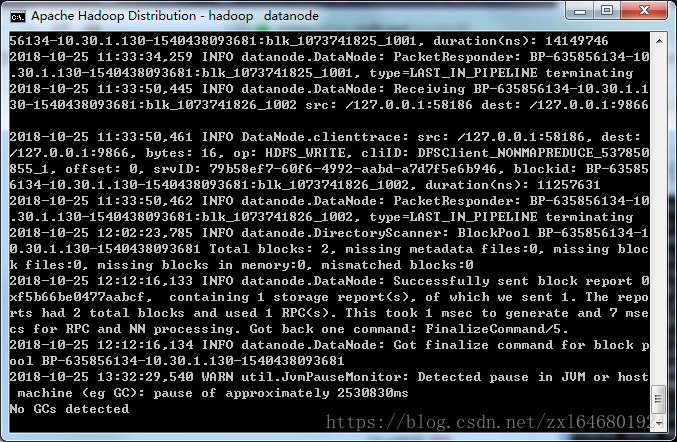

2.執行cmd視窗,切換到hadoop的sbin目錄,執行start-all.cmd,它將會啟動以下4個程序視窗。

七、上傳測試

根據你core-site.xml的配置,接下來你就可以通過:hdfs://localhost:9000 來對hdfs進行操作了。

1.建立輸入目錄

輸入命令,hadoop fs -mkdir hdfs://localhost:9000/user

hadoop fs -mkdir hdfs://localhost:9000/user/wcinput

C:\WINDOWS\system32>hadoop fs -mkdir hdfs://localhost:9000/user/

C:\WINDOWS\system32>hadoop fs -mkdir hdfs://localhost:9000/user/wcinput2.上傳資料到目錄

輸入命令, hadoop fs -put D:\personal\debug.log hdfs://localhost:9000/user/wcinput

hadoop fs -put D:\personal\waz.txt hdfs://localhost:9000/user/wcinput

C:\WINDOWS\system32>hadoop fs -put D:\personal\debug.log hdfs://localhost:9000/user/wcinput

C:\WINDOWS\system32>hadoop fs -put D:\personal\waz.txt hdfs://localhost:9000/user/wcinput3.檢視檔案

輸入命令,hadoop fs -ls hdfs://localhost:9000/user

QA常見問題:

1:啟動hadoop可能提示找不到JAVA_HOME路徑,是因為hadoop讀取JAVA_HOME環境變數存在空格導致。

2:啟動hadoop提示找不到HADOOP,是因為Hadoop環境變數沒有配置好,請檢查Hadoop環境變數配置。

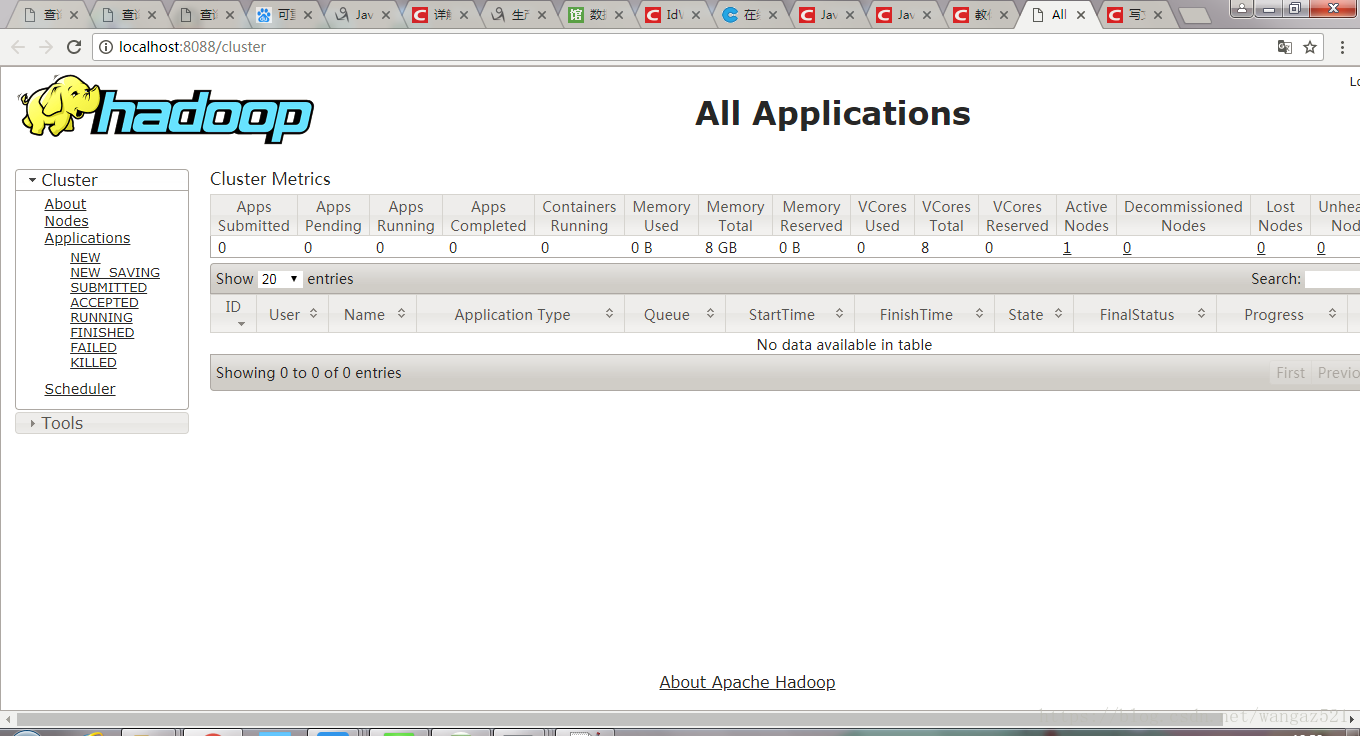

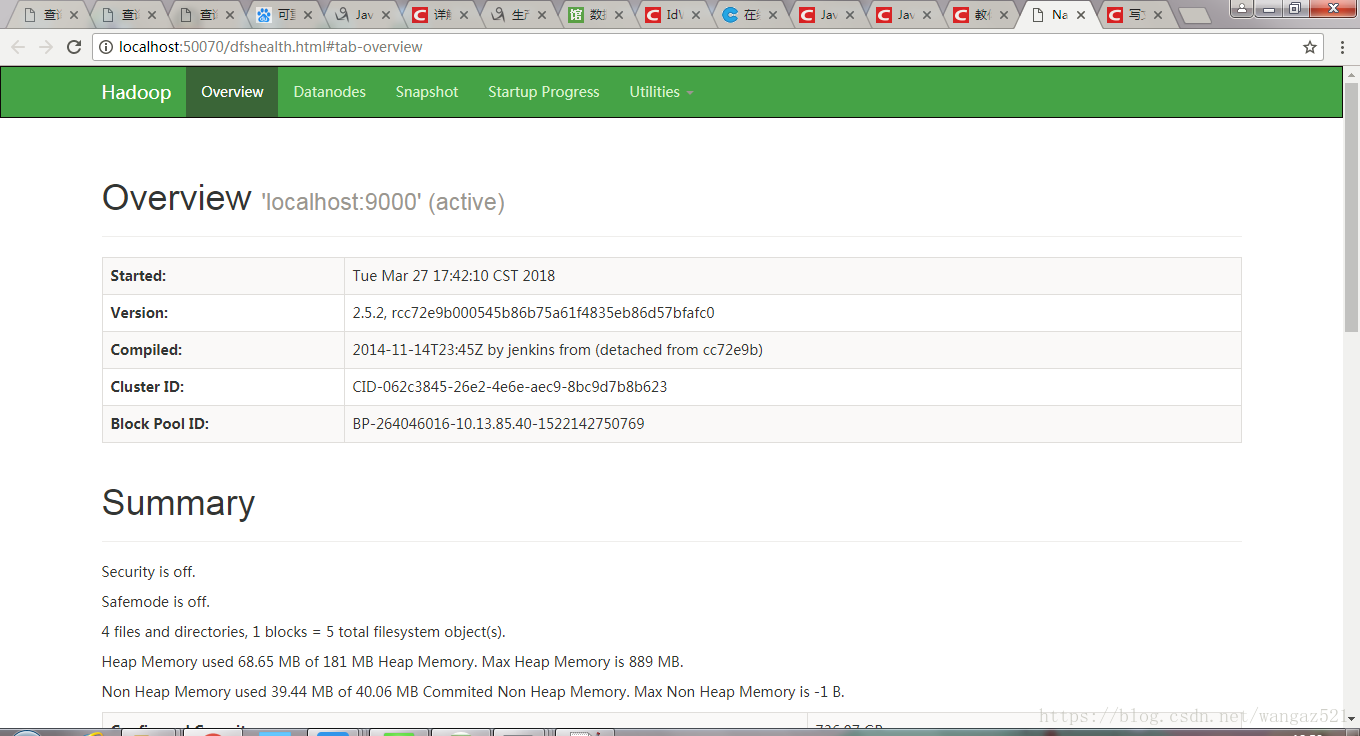

hadoop自帶的web控制檯GUI

1.資源管理GUI:http://localhost:8088/;

2.節點管理GUI:http://localhost:50070/