目標跟蹤方法總結

阿新 • • 發佈:2018-11-29

文章目錄

1 資料集

1.1 OTB

- 最經典的benchmark,有2013的OTB50和2015的OTB100

- OTB包括25%的灰度序列,解析度相對較低

- http://cvlab.hanyang.ac.kr/tracker_benchmark/datasets.html

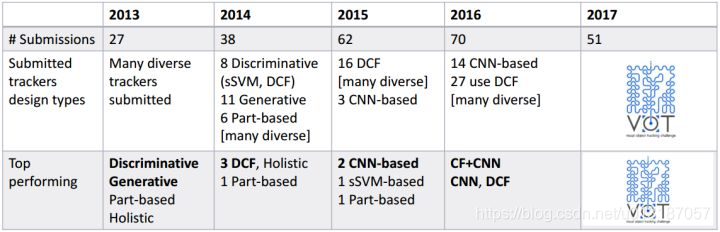

1.2 VOT

- 視覺跟蹤領域國際頂級賽事,自2013年以來每年一屆

- VOT以short-term為主,用第一幀進行初始化,每次跟蹤失敗時,5幀之後再次初始化。認為跟蹤檢測應該在一起永不分離,detecter會多次初始化tracker

- VOT競賽的資料庫是每年更新,還動不動就重新標註,動不動就改變評價指標,對當年演算法是不可見且難度很大的,所以結果更可靠

- http://www.votchallenge.net/challenges.html

- 所以跟蹤演算法前沿基本看VOT競賽就OK了

1.3 UAV123

- 均是通過無人機拍攝的彩色影象

- https://ivul.kaust.edu.sa/Pages/Dataset-UAV123.aspx

1.4 VIVID

- 包含9個序列,均是從高空拍攝的車輛視訊影象,包括灰度影象和彩色影象,相對時間都比較長,目標也比較小,遮擋情況比較多

- http://vision.cse.psu.edu/data/vividEval/datasets/datasets.html

2 幾大難點

- 外觀變形(deformation)

- 光照變化(illumination variation)

- 快速運動及運動模糊(fast motion & blur)

- 相似背景干擾(background clutter)

- 平面內、外旋轉(out-of-plane & in-plane rotation)

- 尺度變化(scale variation)

- 遮擋、出視野(occlusion & out-of-view)

3 分類

3.1生成類(generative)模型方法

- 在當前幀對目標區域建模,下一幀尋找與模型最相似的區域就是預測位置,比較著名的有卡爾曼濾波,粒子濾波,mean-shift等。

- 推薦演算法ASMS(2014),僅用顏色特徵且速度較快,在VOT2015第20名,VOT2016第32名。

ASMS演算法:在經典mean-shift框架下加入了尺度估計,經典顏色直方圖特徵,加入了兩個先驗(尺度不劇變+可能偏最大)作為正則項,和反向尺度一致性檢查。 - 例:從當前幀知道了目標區域80%是紅色,20%是綠色,然後在下一幀,搜尋演算法就像無頭蒼蠅,到處去找最符合這個顏色比例的區域。

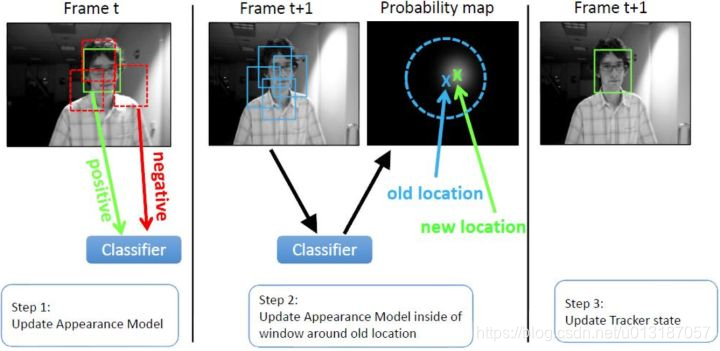

3.2 判別類(discriminative)模型方法

- 這種方法也常被稱tracking-by-detection,CV中的經典套路是影象特徵+機器學習, 當前幀以目標區域為正樣本,背景區域為負樣本,機器學習方法訓練分類器,下一幀用訓練好的分類器找最優區域。

- 經典判別類方法推薦Struck和TLD,實時效能還行,Struck是2012年之前最好的方法,TLD是經典long-term的代表,即使效果差一點但思想非常值得借鑑。

- 判別類方法最新發展就是相關濾波(Correlation Filter)和深度學習(Deep ConvNet based),相關濾波也可以叫做模板類方法,所用的特徵叫做模板類特徵。

- 例:Struck(Haar+SVM),行人檢測(HOG+SVM),人臉檢測(Haar+AdaBoost)。

3.3 兩種方法的區別

- 判別類方法在分類器訓練過程中用到了背景資訊,這樣分類器就能專注區分前景和背景,所以判別類方法普遍都比生成類好。

4 相關濾波

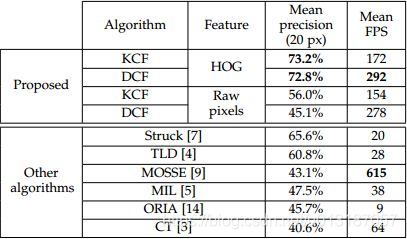

4.1 KCF/DCF

- 作者:(牛津大學 João F. Henrique)

- OTB50上的測試結果(arVix:2014.4)

- Precision和FPS碾壓了OTB50上最好的Struck。

- MOOSE(ICCV 2010)是目標跟蹤領域第一篇相關濾波演算法,採用單通道灰度特徵,在訓練和檢測時都沒有加padding,速度:615FPS,第一次顯示了相關濾波的潛力。

- CSK(與KCF/DCF同一作者)在MOSSE的基礎上擴充套件了密集取樣(加padding)和kernel-trick,速度:362FPS。

- KCF/DCF在CSK基礎上擴充套件了多道通的HOG特徵,速度:KCF–172FPS,DCF–292FPS。

- CN(Martin Danelljan大神–林雪平大學)在CSK的基礎上擴充套件了多通道顏色的Color Names,速度:152FPS。

CN方法是將RGB的3通道影象投影到11個顏色通道,分別對應英語中常用的語言顏色分類,分別是black,blue, brown, grey, green, orange, pink, purple, red, white, yellow(對比漢語中常用的語言顏色分類:赤橙黃綠青藍紫+黑白灰,英語和漢語對顏色的認知還是略有差異的),並歸一化得到10通道顏色特徵。作者還測試了多種顏色特徵在相關濾波中的效果,發現CN最好,其次是LAB; - CN2:CN基礎上採用自適應PCA降維壓縮2通道的顏色特徵,速度:202FPS。

- HOG+CN成為跟蹤演算法中hand-craft特徵的標配

5 VOT2014(尺度自適應)

- 25個測試序列,38個演算法,CF方法獨霸天下

5.1 評估手段

- EFO

5.2 尺度變化

- 尺度變化是跟蹤中比較基礎和常見的問題,注:前面介紹的KCF/DCF和CN都沒有尺度更新

- 如果目標縮小,濾波器就會學習到大量背景資訊,如果目標擴大,濾波器只學習到目標區域性紋理,這兩種情況都很可能出現非預期的結果,導致漂移和失敗。

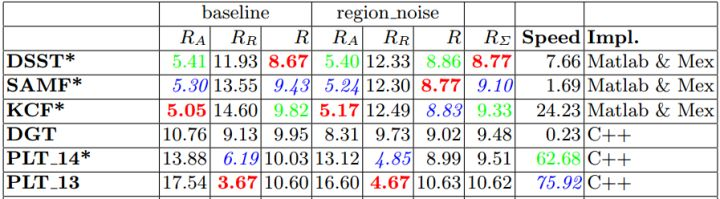

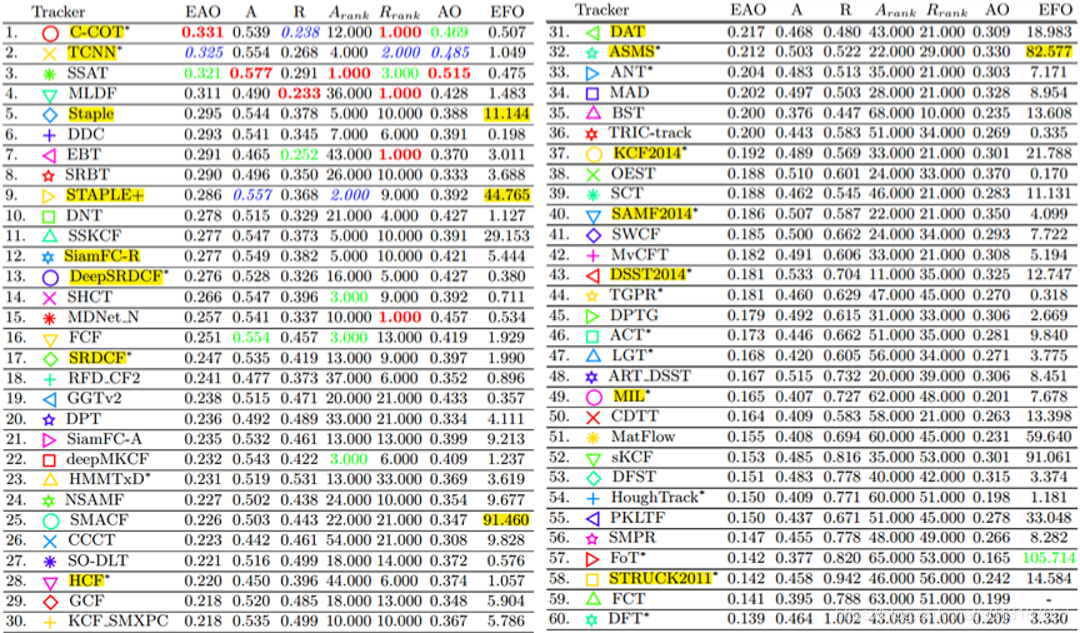

5.3 比賽結果

- SAMF基於KCF,特徵採用HOG+CN,多尺度方法是平移濾波器在多尺度縮放(1.005間隔的7個尺度)的影象塊上進行目標檢測,取響應最大的那個平移位置及所在尺度,速度:4.6FPS

- DSST(Martin Danelljan)只用了HOG特徵,DCF用於平移位置檢測(加padding),類似MOSSE濾波器檢測尺度(1.02間隔的33個尺度)變化(不加padding),開創了採用平移濾波+尺度濾波的方法,速度:21FPS。後來有加速版的fDSST(17個尺度),速度:54.3FPS。

- 前三名都是CF類方法,KCF由於加了多尺度檢測(1.05間隔的3個尺度)和子畫素峰值估計,並且VOT序列解析度比較高,速度:66.6FPS。

6 VOT2015(邊界效應)

- 60個測試序列,62個tracker,最大看點是深度學習開始進入跟蹤領域

6.1 評估手段

- EFO

6.2 邊界效應

- 原因:快速運動

- 結果:當目標部分或全部移出跟蹤區域邊界,導致響應值不是全域性最大,和那些不合理樣本很像,導致跟蹤失敗

6.3 比賽結果

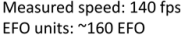

- MDNet採用深度學習方法進行跟蹤,榮獲冠軍,其次DeepSRDCF和SODLT也是深度學習方法,佔比3/62

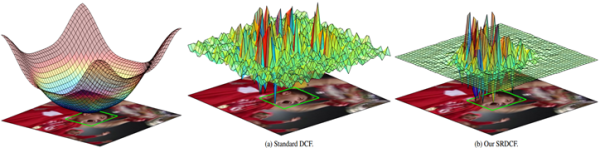

- SRDCF(Martin Danelljan)僅使用HOG特徵來解決邊界效應,排名第四

1.因為邊界效應發生在邊界附近,加入空域正則化,懲罰邊界區域的濾波器係數

2.採用更大的檢測區域(padding 從1.5–>4)

3.由於加正則化破壞了DCF的封閉解,採用高斯-塞德爾方法迭代優化,速度:5PFS

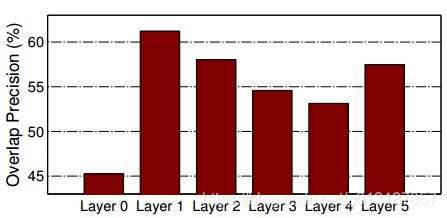

4.實測對快速運動的提升非常明顯 - DeepSRDCF(Martin Danelljan)是結合深度特徵的相關濾波方法,將SRDCF中的HOG特徵替換為用imagenet-vgg-2048網路中單層卷積層的深度特徵,效果有了極大提升,排名第二

- Mean-Shift類顏色演算法ASMS是推薦的實時演算法

7 VOT2016

- 仍是VOT2015的60個測試序列,不過做了重新標註更加公平合理,共70個tracker,深度學習已經獨霸一方了

7.1 評估手段

- EAO:expected average overlap,是對每個跟蹤器在一個短時影象序列上的no-reset average overlap的期望值,是評價跟蹤效果的主要指標

- Accuracy:per-frame overlap,指跟蹤器在單個測試序列下的平均重疊率(兩矩形框的相交部分面積除以兩矩形框的相併部分的面積)

- Robustness:每個tracker在每個序列上執行15次(reset-based),統計平均失敗幀數來計算

- AO:average overlap,僅用第一幀的groundtruth來初始化跟蹤器,然後讓它一直跟下去(no-reset),最後算平均跟蹤重疊率

- EFO:跟蹤器實際執行時間與測試平臺上執行一次規定的濾波運算所需的時間的比值,被認為是與硬體平臺無關的一個度量

7.2 比賽結果

- TCNN (2)、SSAT(3)、MLDF(4) 、DNT(10)、SiamFC-R(12)、MDNet_N(15) 、SiamFC-A(21)、SO-DLT(27)都是深度學習方法,佔比8/72。C-COT、DDC 、 Staple 和 Staple+是複雜特徵結合相關濾波方法

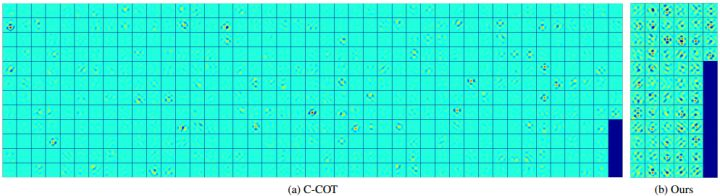

- C-COT(Martin Danelljan)採用多層深度特徵(VGG第1和5層)相結合的相關濾波方法,排名第一,但效率很低

1.綜合了SRDCF的空域正則化和SRDCFdecon的自適應樣本權重

2.將DeepSRDCF的單層卷積的深度特徵擴充套件為多層卷積的深度特徵(VGG第1和5層)

3.應對不同卷積層解析度不同的問題,提出了連續空間域插值轉換操作

4.目標函式通過共軛梯度下降方法迭代優化,比高斯-塞德爾方法要快,檢測中用牛頓法迭代優化目標位置 - TCNN是純CNN方法,與VOT2015冠軍MDNet是同一作者

- Staple(Luca Bertinetto–牛津大學)演算法是推薦的實時演算法,結合顏色統計特徵(積分圖)的相關濾波方法,沒有深度特徵更沒有CNN,因為沒有破壞封閉解,所以速度快

1.相關濾波模板類特徵(HOG)對快速變形和快速運動效果不好,但對運動模糊光照變化等情況比較好

2.顏色統計特徵(顏色直方圖)對變形不敏感,而且不屬於相關濾波框架沒有邊界效應,快速運動當然也是沒問題的,但對光照變化和背景相似顏色不好

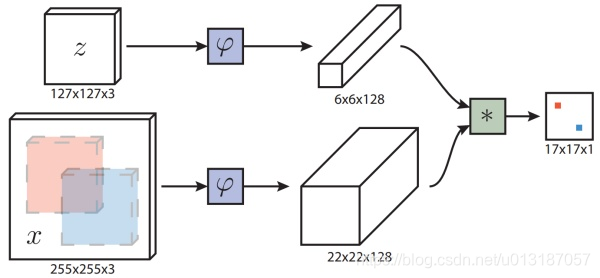

3.Staple演算法將這兩種特徵得到的響應圖進行線性加權(0.7相關濾波響應 + 0.3顏色概率響應)來得到最終響應圖 - SiamFC-R也是Luca Bertinetto的演算法,將孿生網路(基於ResNet)應用於視覺跟蹤,效果還不錯;第21名的SiamFC-A是基於AlexNet

1.目標影象縮放到1271273提取特徵66128,檢測影象縮放到2552553特徵2222128

2.相似度度量是cross-correlation交叉相關,計算每個位置的相似度得到17171的score map

3.將粗糙的score map雙三次插值上取樣,獲得更精確穩定的目標位置

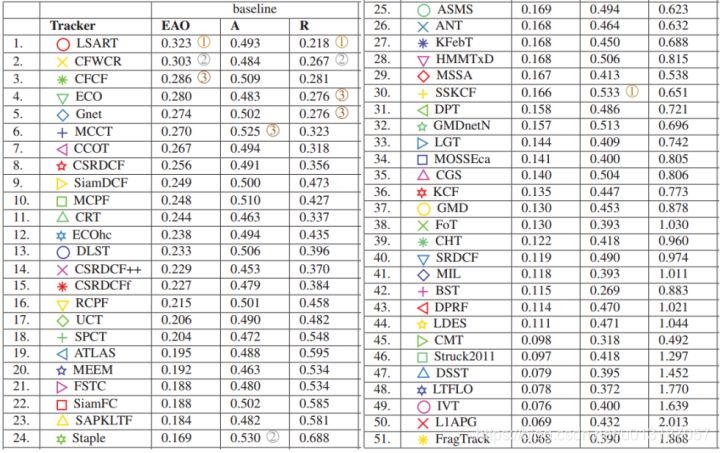

8 VOT2017(相關濾波獨霸天下)

- 將測試分為公測和內測,以內測的結果為最終結果,更加公平公正;

- 60個公測測試集,將VOT2016的60個難度最低的10個序列替換為10個新的難度更大的序列

- 60個內測資料集,除了公測資料集新增的10個序列,還挑選了50個類似屬性但完全不同的序列

- 不允許在公開的OTB、VOT等跟蹤資料集上訓練,導致演算法只有51個,相關CNN的方法集體缺席

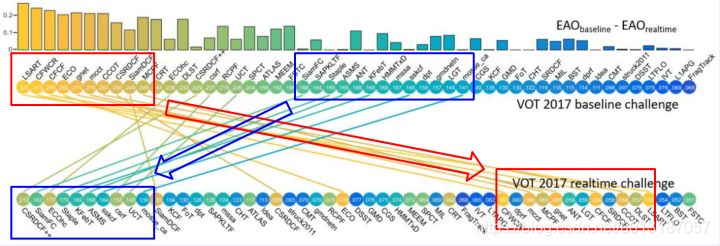

8.1 評估手段

- Real-time Experiment:這是今年新引入的一種評估方式,VOT過去用EFO來評價一個跟蹤器的執行速度,但是後來發現EFO仍然受到硬體平臺效能較大影響,所以今年搞了個實時實驗,具體做法在執行VOT標準評估時,限定跟蹤器的響應時間,如果跟蹤器的未能實時地(25fps,40ms每幀)反饋跟蹤結果,則toolkit將不再等待,而是沿用上一幀的跟蹤結果。當跟蹤失敗時仍然會重啟跟蹤器。

8.2 歷年測試序列數目

8.3 比賽結果

- 公測結果

1.前10名全是相關濾波+多通道特徵,特徵主要是卷積特徵conv feature (VGGNet)和hand-craft feature (HOG+CN),基本都是C-COT或ECO的擴充套件

2.CNN特徵都來自ImageNet上影象分類任務pre-trained的CONVNET,除了CFCF,SiamDCF和SiamFC是在VID資料庫上自己訓練的網路

3.CSRDCF是前10名唯一沒有使用CNN特徵的,由組委會成員提出來的

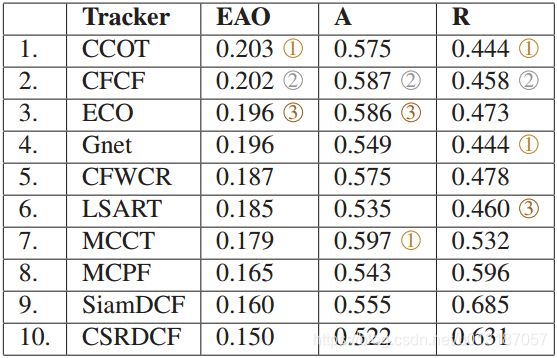

4.SiamFC是少數倖存的端到端的離線訓練tracker,是目前唯一可以與相關濾波抗衡的方向,但2017不允許在跟蹤資料集上訓練後,SiamFC的效果和2016相比明顯差了許多 - 內測結果(公測進入前10)

1.公測資料集完全透明的,大家都可能充分調參,得到一個不錯的結果,雖然一定程度上能反映演算法水平,但內測資料集的結果才是最公平,最可信的。 - 實時測試結果

1.SiamFC和CSR-DCF++是GPU時間,ECO-HC和Staple是CPU時間

2.CSRDCF僅用了HOG+CN特徵,公測第8,內測第10,實時性排名第1

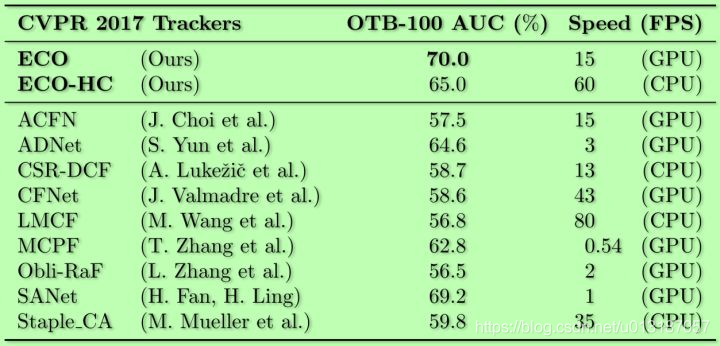

8.4 ECO & ECO-HC(Martin Danelljan)

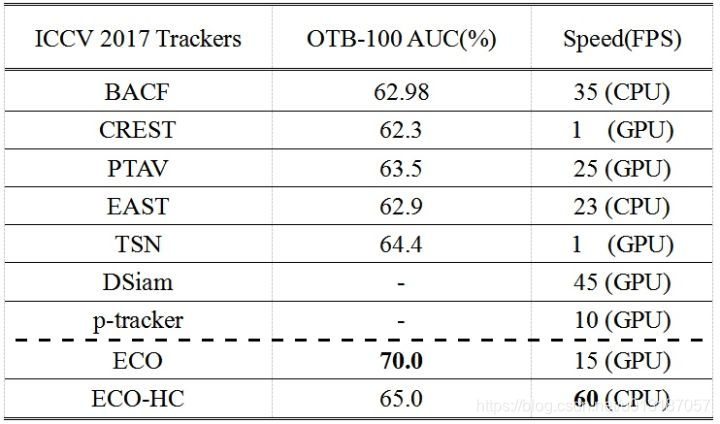

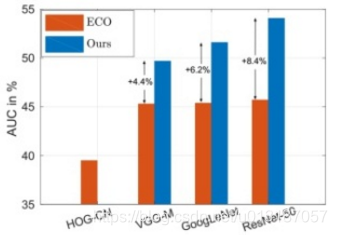

- CVPR及ICCV trackers結果對比

- ECO是C-COT的加速版,從模型大小、樣本集大小和更新策略三個方便加速,速度比C-COT提升了20倍,在公測上效果還更好

1.減少模型引數–factorized convolution operator:用PCA降維,極大減小模型引數,深度特徵時模型引數減少了80%

2.減少樣本數量–compact generative model:採用Gaussian Mixture Model (GMM)合併相似樣本,需要儲存和優化的樣本集數量降到C-COT的1/8

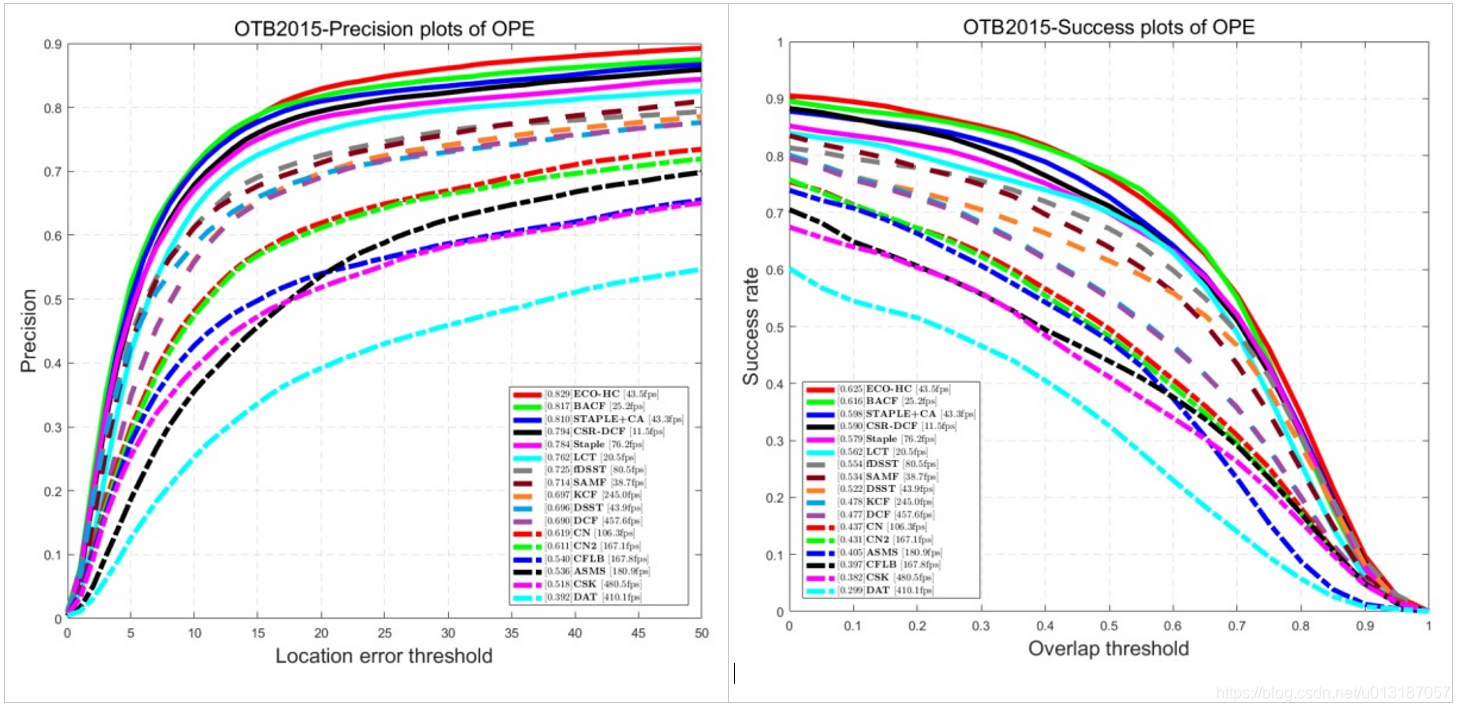

3.改變更新策略–sparser updating scheme:每隔5幀做一次優化更新模型引數,不但提高了演算法速度,而且提高了對突變,遮擋等情況的穩定性。 - ECO-HC是在ECO基礎上去掉CNN特徵,僅使用HOG+CN特徵,並將特徵從41維降到13維,論文中給出速度在CPU上可達到60FPS

1.cpu上達到的實時的tracker(Inter i3 CPU @ 3.70GHz, 8GB,64位,沒有GPU,軟體MATLAB R2016a,OTB-100測試集)

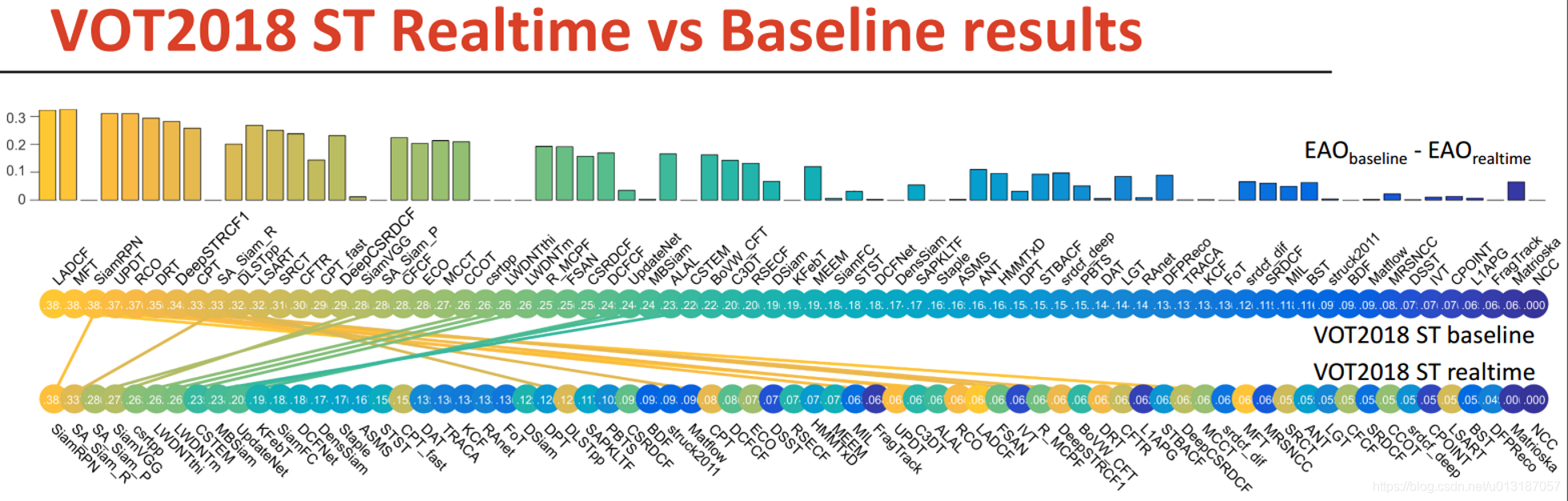

9 VOT2018(DCF+SiamNet)

- 依然是VOT2016的測試序列,共72個tracker

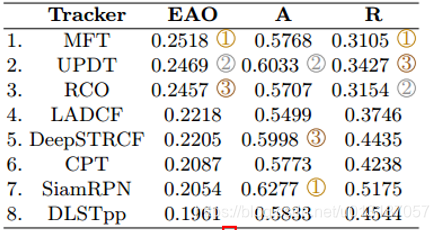

9.1 比賽結果

- 公測結果

1.72個參賽演算法中佔比最高的是DCF類和SiamNet類,其中38個是DCF類方法佔比51%,feature以來自VGGNet的深度特徵為主;14個是SiamNet類佔比18%,backbone以SiamFC中的AlexNet為主,今年SiamNet類佔比大幅提高

2.魯棒性前四名:MFT, LADCF, RCO, UPDT(Martin Danelljan),都是DCF類方法,CNN特徵提取的backbone都是ResNet-50

3.準確性前兩名:SiamRPN(商湯), SA-Siam-R, 都是SiamNet類方法,這兩個演算法都表現出準確性奇高,而魯棒性前十最差的特點 - 內測結果

1.冠軍:MFT是VOT2017年CFWCR的發展,在DCF框架中加multi-resolution和multi-solution,多種特徵Res50, SE-Res50, Hog, 和CN組合

2.UPDT是Martin大神ECCV 2018最新工作,在ECO的基礎上特徵網路換成了ResNet-50,並加入Data Augmentation提取特徵,淺層特徵和深度特徵分治,兩部分自適應融合,是SRDCF到C-COT到ECO之後的又一次飛躍

- 實時測試結果

1.商湯的SiamRPN是Short-term real-time sub-challenge冠軍

2.前10箇中除第5名cdrtpp和第8名CSTEM(CPU速度),其他8個都是SiamNet類方法 (GPU速度)

10 總結

- 跟蹤演算法開始從short-term向long-term及real-time方向過渡

- DCF的方法仍然是目前跟蹤的主流方向,但從最早的MOOSE–>CSK–>KCF到SRDCF、DeepSRDCF再到C-COT–>ECO,相關濾波的高效性一去不復返了;

- 特徵趨向於在傳統的特徵(HOG+CN)上加上CNN特徵,但效率都較低;

- SiamFC是目前唯一可與DCF方法抗衡的跟蹤演算法,但魯棒性較差,應該是與端到端離線訓練,無法線上更新有關

- CNN網路結構用得最多是VGG和ResNet,但出於效率考慮,在嵌入式上也可考慮mobilenet