MIT識物機器人:“秒懂”物體,過目不忘,不用標記資料!

來源 | 新智元

編輯 | 大明

【新智元導讀】MIT團隊打造“密集目標網路”(DON)的機器人系統,能夠讓抓取機器人真正“讀懂”目標,該系統將目標處理生成三維“視覺路線圖”的點集合,讓機器人真正在視覺上理解目標。利用這一系統,科學家們不必再像過去的計算機視覺研究一樣,繁瑣地對大量資料集中的資料進行標記了。

長期以來,人類一直以靈巧著稱,這種特點在很大程度上要歸功於我們的眼睛。不過現在,機器人也逐步迎頭趕上。經過幾十年的發展,現在用於生產線等受控環境中的機器人已經能夠一次又一次地拾起同一個目標了。

最近在計算機視覺方面的突破,讓機器人也能區分出不同的目標。不過即使這樣,機器人還是無法真正理解物體的形狀,因此在拾取目標後,幾乎無法再做什麼別的事。

近日,麻省理工學院電腦科學與人工智慧實驗室(CSAIL)的研究人員在一篇新論文中表示,他們已在這個領域取得了一項重要進展:他們打造的機器人系統可以識別出之前未見過的隨機目標,並能夠在視覺上“理解”這些目標,以完成更豐富的任務。

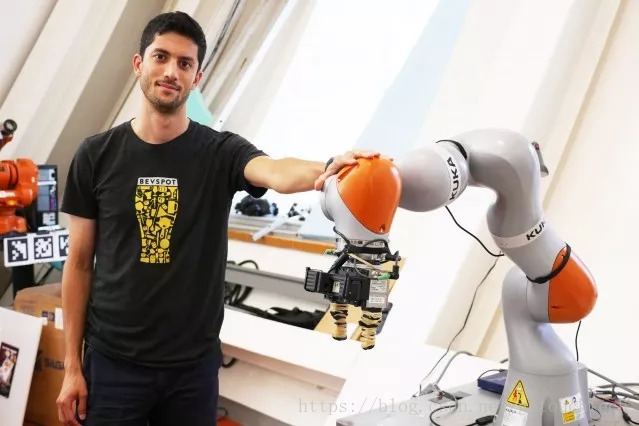

研究人員使用KUKA機器人抓起一隻杯子

“密集物件網路”:讓機器人讀懂抓取目標

該系統名為“密集物件網路”(DON),該網路將物件視為點的集合,當作“視覺路線圖”來使用。這種方法可以讓機器人更好地理解和抓取目標,最重要的是,機器人能夠在大量類似目標中挑出特定的目標。

比如,有人可能會使用DON系統讓機器人抓住目標上的特定位置,比如鞋舌頭。之後,它就能夠看到之前從未見過的鞋子,併成功抓住鞋舌頭。

參與該研究的博士生Lucas Manuelli說道:“許多控制系統和識別方法都無法識別朝多個方向放置的目標的特定部分。”他與該論文另一作者、博士生Pete Florence和MIT教授Russ Tedrake一起撰寫了該論文。 “比如,現有的演算法就無法抓住馬克杯的杯柄,尤其是在馬克杯朝多個方向放置的情況下,比如直立或側放。”

該團隊認為,該技術不僅能用於工業製造,還能走入家庭的日常生活。比如,給系統展示一座整潔的房子的影象,讓機器人在你工作時打掃房間,或向機器人展示菜餚的影象,讓機器人在你度假時把你的餐桌上的盤子收拾好。

DON抓取演算法:訓練無需標註資料集,省時省力

值得注意的一點是,沒有任何資料事先被人類標記過。這個系統是“自我監督的”,因此不需要任何來自人類的資料標註。

機器人抓取目標的兩種常見方法是,建立特定任務的機器學習,建立通用的抓取演算法。這兩種技術都存在障礙:基於特定任務的方法很難推廣到其他任務,而通用的抓取演算法不夠具體,無法顧及處理特定任務時的細微差別,比如將目標放到特定的位置上。

而DON系統基本上是在給定目標上建立一系列座標,作為基於目標的一種“視覺路線圖”,使機器人更好地理解自己需要抓取哪些目標,目標在何處等。

該團隊訓練系統將物件視為構成較大座標系的一系列點。然後將不同的點對映到一起,顯示出物件的三維形狀,這種方式和使用多張照片拼接全景照片的方式有些類似。在訓練之後,如果指定目標上的一個點,機器人可以拍攝該物體的照片,並一系列的點進行識別和匹配,然後就可以指定點拾取目標。

下面是一段演示視訊,一起來看看!

https://v.qq.com/x/page/n1348amrk6z.html

這個系統與加州大學伯克利分校的DexNet系統有所不同,伯克利的系統可以抓取許多不同的目標,但不能滿足抓取特定目標的要求。就好比一個一歲半的嬰兒,他不明白你想要他玩哪個玩具,但仍然可以抓起很多不同的玩具,而一個四歲的孩子,就可以準確地迴應“去抓住那輛紅色小卡車的車尾”的要求。

在形狀對稱毛絨玩具上進行的一組測試中,由DON驅動的Kuka機器人手臂可以從一系列不同的目標位置抓住玩具的右耳。這表明系統具有在對稱物體上區分左右的能力。

在利用不同棒球帽進行測試時,DON可以選擇特定的目標帽子,儘管所有的帽子的設計都非常相似,機器人在之前從未在訓練資料中看到過帽子的照片。

未來,團隊希望將系統進行改進,讓其具備執行特定任務的能力,同時能夠更深入地瞭解相應的目標,例如學習如何抓住目標,並將其移動到最終位置等。

團隊將於下個月在瑞士蘇黎世舉行的機器人學習會議上發表這一成果。

參考連結:

https://www.eurekalert.org/pub_releases/2018-09/miot-rcp090418.php

https://www.csail.mit.edu/news/robots-can-now-pick-any-object-after-inspecting-it

論文地址:

https://arxiv.org/abs/1806.08756

Github資源:

https://github.com/RobotLocomotion/pytorch-dense-correspondence