論文閱讀筆記二十:MULTI-SCALE CONTEXT AGGREGATION BY DILATED CONVOLUTIONS(ICRL2016)

論文源址:https://arxiv.org/abs/1511.07122

tensorflow Github:https://github.com/ndrplz/dilation-tensorflow

摘要

該文提出了空洞卷積模型,在不降低解析度的基礎上聚合影象中不同尺寸的上下文資訊,同時,空洞卷積擴大感受野的範圍。

介紹

語義分割具有一定的挑戰性,因為要進行畫素級的分類,同時,要考慮不同尺寸大小的上下文資訊的推理。通過卷積外加反向傳播的學習演算法,使分類的準確率得到大幅度的提升。由原始的分類到畫素級的分類,本文提出了兩個問題:(1)重新構建的網路的哪一部分是有必要的,同時,哪個操作在進行密集分類時會降低分割結果的準確率。(2)設計一個專門用於進行密集分類的模型結構會提高分割的效果嗎?

分類網路通過連續的卷積池化操作來融合不同尺寸的上下文資訊,此過程中,解析度在不斷的減少,知道得到一個最總的預測分類結果。與之相反,分割任務要求在完整的解析度上進行多尺寸的預測。針對此問題有兩種解決方式:(1)通過反捲積操作恢復丟失的解析度資訊。這就引出一個疑問,中間下采樣的操作是否是真的有必要的。(2)提供多尺寸的輸入圖片,並將這些圖片的預測結果進行組合。同樣,這裡存在一個問題,對不同尺寸輸入的圖片,是否需要對他們的結果單獨進行分析。

該文提出的空洞卷積模型,並未減少分辨率同時,不需要對不同尺寸輸入圖片對輸出結果的影響進行分析。該結構主要用於分割任務,同時,值得注意的是空洞卷積的網路中並未有池化或者下采樣的操作過程。通過空洞卷積即可獲得較大的感受野。

空洞卷積

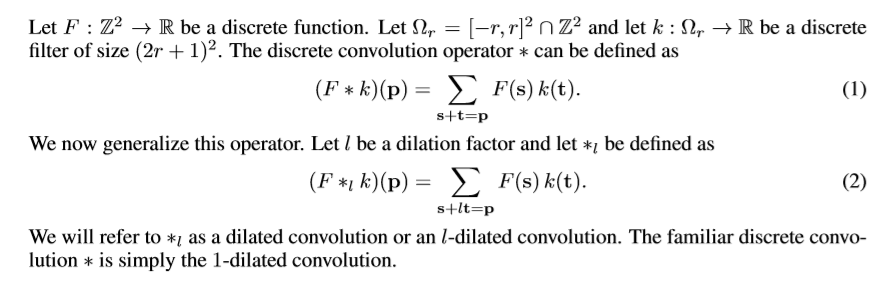

該文重點介紹空洞卷積的影響,而不是空洞卷積的構建,利用空洞卷積進行多尺寸的資訊融合。空洞卷積核感受野的大小成指數增長,如下圖。

卷積核大小kxk,dilation factor:n-推出感受野大小為:(k+1)x n - 1

多尺寸語義資訊融合

語義模型通過融合多尺寸的上下文資訊,來提高密集預測結構的效果。有C通道的輸入feature maps輸入模型後,輸出C通道的feature maps。

該文提出的一種基礎模型,包含7層網路,其中使用了不同dilation factor的3x3的卷積。dilations為【1,1,2,4,8,16】,每層上都有卷積操作,前兩層,每層卷積後都接著一個畫素級的截斷處理,max(,0)。最後一層為1x1xc的卷積,併產生輸出,,結構如下表,輸入為64x64的圖片。

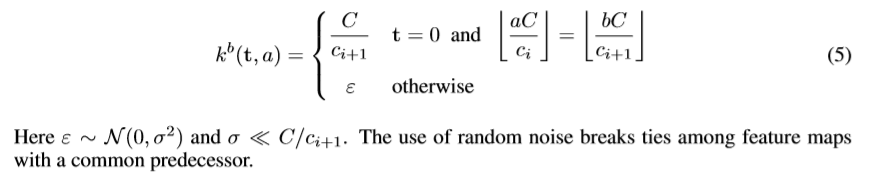

該文該開始用標準的初始化流程訓練網路,結果並不理想。 卷積網路一般使用隨機取樣分佈進行初始化操作。但這種方式對空洞卷積效果甚微,該文轉而用如下Identity初始化方式。

![]()

這種初始化方式,會讓前一層的資訊直接流入下一層中,直覺上感到不利於反向傳播資訊的傳遞,但實驗證明,這種擔心是多餘的。對於不同深度的初始化按如下方式進行。

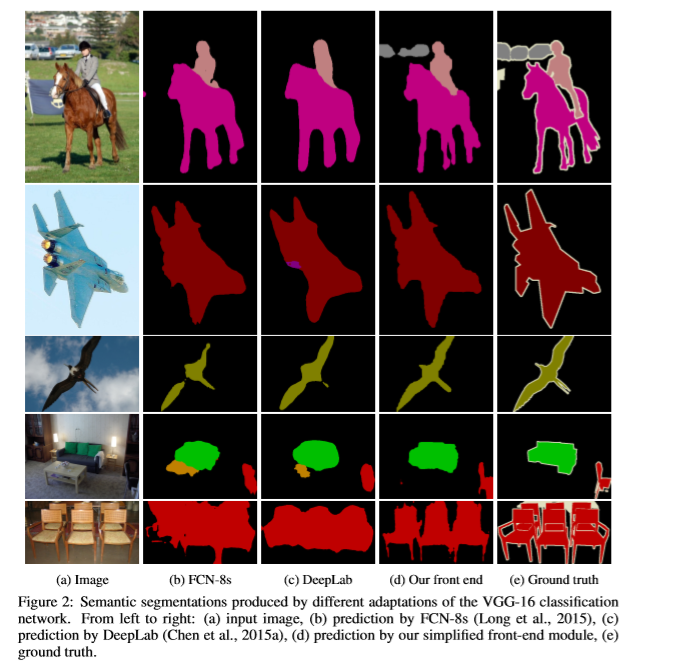

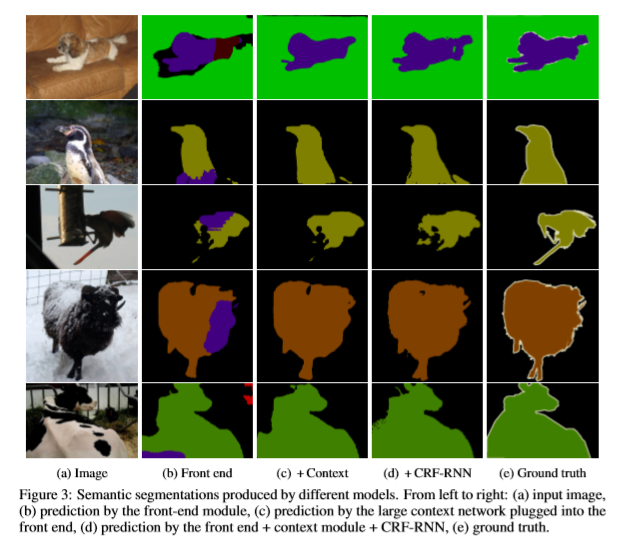

前端

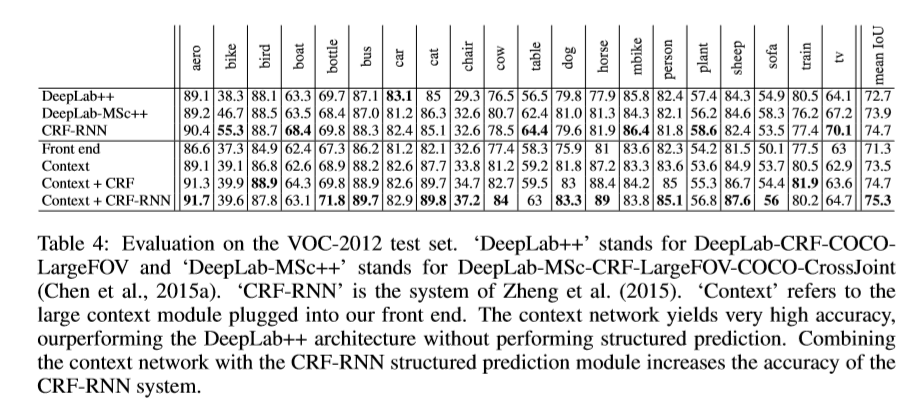

該網路的輸入為三通道的彩色影象,輸出為21通道的特徵圖,基於VGG16進行改進,將其中最後兩層池化層與全連線層。對於移除的池化層後接的卷積層的dilation factor擴大2倍。因此,最後一層的卷積層的的dilated factor擴大為4。通過空洞卷積,可以利用原始分類網路的引數初始化,同時產生更高解析度的輸出。該模型,在Pascal VOC2012資料集上進行訓練,基於SGD優化方法,mini-batch 大小為14,學習率為1e-3,動量大小為0.9,迭代60000次。

實驗

reference

Badrinarayanan, Vijay, Handa, Ankur, and Cipolla, Roberto. SegNet: A deep convolutional encoder-decoder architecture for robust semantic pixel-wise labelling. arXiv:1505.07293, 2015.

Brostow,GabrielJ.,Fauqueur,Julien,andCipolla,Roberto. Semanticobjectclassesinvideo: Ahigh-definition ground truth database. Pattern Recognition Letters, 30(2), 2009.

Chen, Liang-Chieh, Papandreou, George, Kokkinos, Iasonas, Murphy, Kevin, and Yuille, Alan L. Semantic image segmentation with deep convolutional nets and fully connected CRFs. In ICLR, 2015a.