ELK6.5 Nginx 日誌蒐集-02 elasticsearch 安裝

node1:elasticsearch、kibana、logstash

node2:filebeat

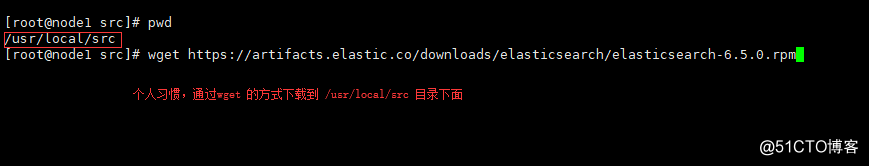

1,下載 elasticsearch 6.5.0 版本

(吐槽一下,我們線上部署的時候是6.5.0,寫文件的時候已經是6.5.2了,官網更新速度實在是太快了。)

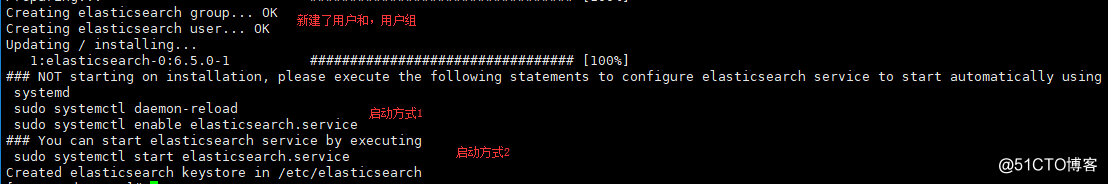

2,安裝

# rpm -ivh elasticsearch-6.5.0.rpm

安裝完成的提示資訊裡面也是有價值的資訊的。

這些,你有發現嗎?

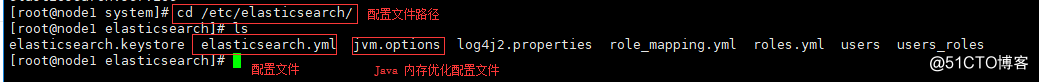

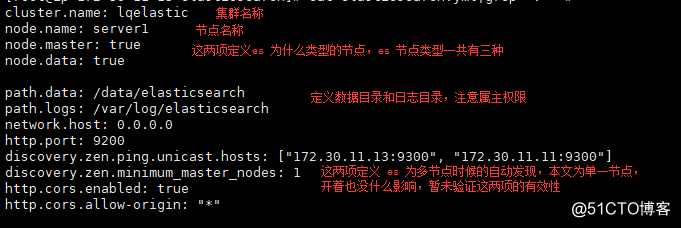

3,編輯配置檔案資訊,嘗試啟動 elasticsearch

# vim elasticsearch.yml

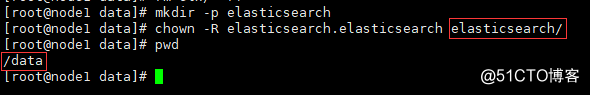

建立資料目錄,設定屬主,日誌目錄保持預設的話,是自動新建的。

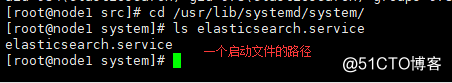

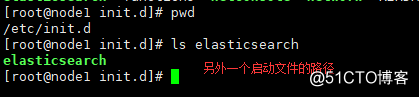

4,嘗試啟動 elasticsearch (前面提到有2中啟動方式)

# /etc/init.d/elasticsearch start 還是使用自己習慣的

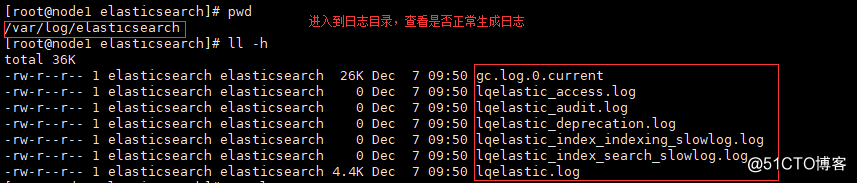

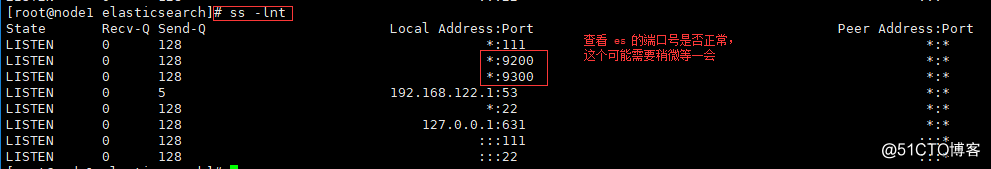

日誌正常,埠號正常,說明 elasticsearch 啟動正常。

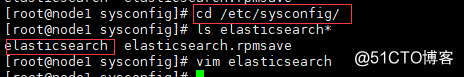

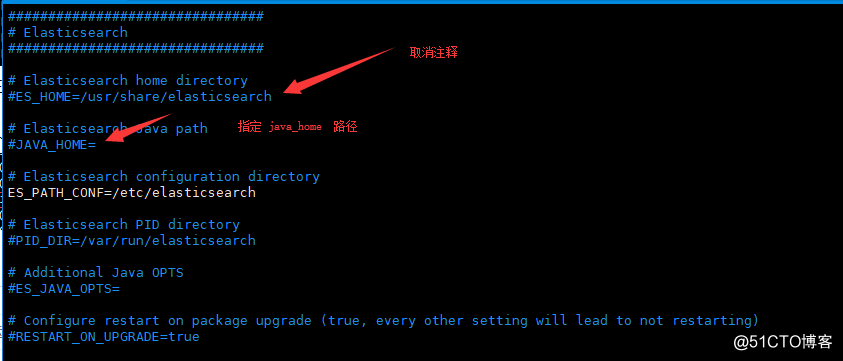

如果個別的啟動失敗,可以嘗試配置這個檔案,看是否解決問題

我這裡啟動成功了,所以沒有開啟這兩項

寫的不好、歡迎指正:VX:85862870

相關推薦

ELK6.5 Nginx 日誌蒐集-02 elasticsearch 安裝

node1:elasticsearch、kibana、logstash node2:filebeat 1,下載 elasticsearch 6.5.0 版本 (吐槽一下,我們線上部署的時候是6.5.0,寫文件的時候已經是6.5.2了,官網更新速度實在是太快了。) 2,安裝 #&

ELK6.5 Nginx 日誌蒐集-03 kibana 安裝

node1:elasticsearch、kibana、logstash node2:filebeat 1、如前文,下載 kibana 6.5.0 版 安裝 # rpm -ivh kibana-6.5.0-x86_64.rpm 進入配置檔案目錄,修改配置檔案 #&

ELK6.5 Nginx 日誌蒐集-04 logstash 安裝

node1:elasticsearch、kibana、logstash node2:filebeat 1、如前文,下載 logstash 6.5.0 版 安裝 # rpm -ivh logstash-6.5.0-x86_64.rpm 進入配置檔案目錄,修改配置檔案

ELK6.5 Nginx 日誌蒐集-05 filebeat 安裝

node1:elasticsearch、kibana、logstash node2:filebeat 1、如前文,下載 filebeat 6.5.0 版 在 node2 節點安裝 filebeat 的安裝,執行,是不需要 jdk 環境的 # rpm -ivh fi

filebeat 獲取nginx日誌 發送給ElasticSearch

filebeat 獲取nginx日誌 發送給elasticsearch目的:通過filebeat獲取nginx日誌,發送給ElasticSearch,filebeat可以解析json格式日誌,所以設置nginx日誌為json格式。1、配置nginx配置文件 log_format jsonTest

ELK6.2.3日誌分析工具elasticsearch x-pack6.2.3許可權管理Security模組和內建角色介紹

啟動elasticsearch 1.自定義設定密碼,三個內建賬號根據提示設定密碼 ./bin/x-pack/setup-passwords interactive 2.自動生成密碼 ./bin/x-pack/setup-passwords auto 3.在kibana通過DSL語句設定密碼

快速搭建ELK6.2.2日誌分析系統及安裝配置

ELK日誌平臺介紹 在搜尋ELK資料的時候,發現這篇文章比較好,於是摘抄一小段: 日誌主要包括系統日誌、應用程式日誌和安全日誌。系統運維和開發人員可以通過日誌瞭解伺服器軟硬體資訊、檢查配置過程中的錯誤及錯誤發生的原因。經常分析日誌可以瞭解伺服器的負荷,效能安全性,從而及時採取措施

ELK6.2.3日誌分析工具搭Elasticsearch-head安裝(二)

安裝Elasticsearch-head 1.切換目錄 cd /usr/local/elk/elasticsearch-6.2.3 2.下載 wget https://codeload.github.com/mobz/elasticsearch-head/zip/master 3.更改

ELK6.2.3日誌分析工具搭建JDK、Elasticsearch、Kibana安裝(一)

Logstash: Logstash服務的元件,用於處理傳入的日誌。 Elasticsearch: 儲存所有日誌 Kibana : 用於搜尋和視覺化的日誌的Web介面,通過nginx反代 Logstash Forwarder: 安裝在將要把日誌傳送到logstash的伺服器上,作為日誌轉發的道

微服務架構日誌集中化 安裝 EFK (Fluentd ElasticSearch Kibana) 採集nginx日誌

首先在nginx伺服器上執行以下操作. 安裝ruby http://blog.csdn.net/chenhaifeng2016/article/details/78678680 安裝Fluentd curl -L https://toolbelt.treasuredat

CentOS7 安裝EFK(elasticsearch、fluent、kibana)進行Docker下日誌蒐集

Fluentd並非是專用於日誌檔案收集的,而是一個通用的資訊收集、整理、轉發的流式資料處理工具,日誌收集只是它十分典型的一個運用場景。重要的是,Fluentd的日誌收集功能對容器支援十分完備,遠遠勝於Logstash等傳統日誌收集工具。一方面得益於Fluentd社群開發

5、nginx日誌切割和刪除

nginx 日誌切割5、Nginx日誌切割和日誌定期刪除LogDir=/data/logs/nginx #日誌存放目錄LogDate=`date +%Y%m%d` #日誌名稱後綴KeepLogDays=30 #保留的天數(看自己的需求)DelDate=`date -d "-${KeepLogD

12.1 LNMP架構介紹 12.2 MySQL安裝 12.3/12.4 PHP安裝 12.5 Nginx介紹

mcrypt .... game post mcr default .tar.gz sta fig Nginx設計的初衷是提供一種快速、高效、多並發的Web服務軟件。在靜態頁面的處理上,Nginx較Apache更勝一籌;但是在動態頁面的處理上,Nginx並不比Apache

12.1 LNMP架構介紹12.2 MySQL安裝12.3/12.4 PHP安裝12.5 Nginx

12.1 LNMP架構介紹12.2 My12.1 LNMP架構介紹 13.12.2 MySQL安裝 [root@martin001 ~]# service mysql stopRedirecting to /bin/systemctl stop mysql.service[root@martin001 ~

ELK 6安裝配置 nginx日誌收集 kabana漢化

restart proc times add-port app pack minimum node cnblogs #ELK 6安裝配置 nginx日誌收集 kabana漢化 #環境 centos 7.4 ,ELK 6 ,單節點 #服務端 Logstash 收集,過濾 E

12.1-12.5 LNMP架構介紹,MySQL安裝,PHP安裝,Nginx介紹

LNMP架構介紹 MySQL安裝 PHP安裝 Nginx介紹 十二周一次課(4月23日)12.1 LNMP架構介紹12.2 MySQL安裝12.3/12.4 PHP安裝12.5 Nginx介紹擴展Nginx為什麽比Apache Httpd高效:原理篇 http://www.toxingwang

ELK6.2.3日誌分析工具搭x-pack破解安裝(三)

一、elasticsearch安裝x-pack 1.切換安裝目錄 [email protected]: cd /usr/local/elk/elasticsearch-6.2.3/bin 2.執行安裝命令 [email protected]:/usr/local/e

docker 部署 ELK (elasticsearch + logstash + kibana) 收集分析 nginx 日誌

git 專案地址 https://github.com/Gekkoou/docker-elk 目錄結構 ├── elasticsearch elasticsearch目錄 │ └── es

elasticsearch+logstash+redis+kibana 實時分析nginx日誌

1. 部署環境 2. 架構拓撲 3. nginx安裝 安裝在192.168.176.128伺服器上 這裡安裝就簡單粗暴了直接yum安裝nginx [[email protected] ~]# yum -y install epel-release [[email

elk+filebeat的安裝 並 分析nginx日誌(推薦)

關於elk及其相關元件的介紹,參看此文https://boke.wsfnk.com/archives/67.html系統規劃 服務型別 OS版本 IP地址 主機名 elk端 centos7.4 192.168.1.26 elk-server log端 centos7.4 192.168.1.40 b