【SPARK】- RDD持久化

因為RDD的惰性求值機制,每次遇到行動操作,都會觸發一次從頭開始的計算。這對於迭代計算而言,代價是很大的,迭代計算經常需要多次重複使用同一組資料。

因此,可以通過持久化(快取)機制避免這種重複計算的開銷

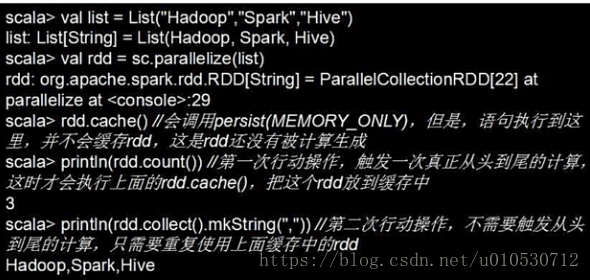

可以使用persist()方法對一個RDD標記為持久化(標記持久化:出現persist()語句的地方,並不會馬上計算生成RDD並把它持久化,而是要等到遇到第一個行動操作觸發真正計算以後,才會把計算結果進行持久化,持久化以後的RDD將會被保留在計算節點的記憶體中被後面的行動操作重複使用)

persist(element) element:

MEMORY_ONLY:表示將RDD作為反序列化的物件儲存在JVM中,如果記憶體不足,就要按照LRU原則替換快取中的內容

MEMORY_AND_DISK:表示將RDD作為反序列化的物件儲存在JVM中,如果記憶體不足,超出的分割槽將會被儲存在硬碟上

一般而言,使用cache()方法時,會呼叫persist(MEMORY_ONLY)

可以使用unpersist()方法手動吧持久化的RDD從快取中移除

如下圖:

相關推薦

【SPARK】- RDD持久化

因為RDD的惰性求值機制,每次遇到行動操作,都會觸發一次從頭開始的計算。這對於迭代計算而言,代價是很大的,迭代計算經常需要多次重複使用同一組資料。 因此,可以通過持久化(快取)機制避免這種重複計算的開銷 可以使用persist()方法對一個RDD標記為持久化(標記持久化:

【Spark】RDD操作具體解釋4——Action算子

() sim comment cat zed ret form sdn order 本質上在Actions算子中通過SparkContext運行提交作業的runJob操作,觸發了RDD DAG的運行。 依據Action算子的輸出空間將Action算子進

【Spark】--Spark中RDD的理解

1.什麼是RDD?RDD:RDD是Spark的計算模型 RDD(Resilient Distributed Dataset)叫做彈性的分散式資料集合,是Spark中最基本的資料抽象,它代表一個不可變、只讀的,被分割槽的資料集。操作RDD就像操作本地集合一樣,資料會被分散到多臺

【spark】Spark運算元:RDD基本轉換操作–map、flagMap、distinct

map將一個RDD中的每個資料項,通過map中的函式對映變為一個新的元素。 輸入分割槽與輸出分割槽一對一,即:有多少個輸入分割槽,就有多少個輸出分割槽。 hadoop fs -cat /tmp/lxw1234/1.txthello worldhello sparkhello

【Spark】彈性分散式資料集RDD概述

彈性分佈資料集RDD RDD(Resilient Distributed Dataset)是Spark的最基本抽象,是對分散式記憶體的抽象使用,實現了以操作本地集合的方式來操作分散式資料集的抽象實現。RDD是Spark最核心的東西,它表示已被分割槽,不可變的並

【spark,RDD,1】彈性分散式資料集RDD介紹

scala> val rdd = sc.textFile("hdfs://yarn1:8020/hmbbs_logs/access_2013_05_31.log") 16/04/27 21:45:41 INFO MemoryStore: ensureFreeSpace(219256) called w

【Spark】DAGScheduler源代碼淺析

under 提交 title 作者 sem lis git lean access DAGScheduler DAGScheduler的主要任務是基於Stage構建DAG,決定每個任務的最佳位置 記錄哪個RDD或者Stage輸出被物化

[Luogu 3919]【模板】可持久化數組(可持久化線段樹/平衡樹)

ins eset blog sta -s ctime it is put tex Description 如題,你需要維護這樣的一個長度為 N 的數組,支持如下幾種操作 在某個歷史版本上修改某一個位置上的值 訪問某個歷史版本上的某一位置的值 此外,每

【模板】可持久化Treap

split getch name 後繼 pan nod sed lose 技術 洛谷3835 1 #include<cstdio> 2 #include<algorithm> 3 #include<cstdlib> 4 #de

【模板】可持久化線段樹 1(主席樹)

base math 一次 數據 mar 指定 das min 第k小 題目背景 這是個非常經典的主席樹入門題——靜態區間第K小 數據已經過加強,請使用主席樹。同時請註意常數優化 題目描述 如題,給定N個正整數構成的序列,將對於指定的閉區間

【Spark】篇---Spark中yarn模式兩種提交任務方式

方式 div -s and clas client 命令 yarn 模式 一、前述 Spark可以和Yarn整合,將Application提交到Yarn上運行,和StandAlone提交模式一樣,Yarn也有兩種提交任務的方式。 二、具體 1、yarn

洛谷P3402 【模板】可持久化並查集(可持久化線段樹,線段樹)

std 樹節點 https case 深度 build eof spa 復雜度 orz TPLY 巨佬,題解講的挺好的。 這裏重點梳理一下思路,做一個小小的補充吧。 寫可持久化線段樹,葉子節點維護每個位置的fa,利用每次只更新一個節點的特性,每次插入\(logN\)個節點,

[解題報告]P3919 【模板】可持久化數組(可持久化線段樹/平衡樹)

版本 持久化 完全 直接 n) ace 思路 efi mes 題目簡述 維護一個長度為N的數組,支持如下幾種操作: 在某個歷史版本上修改某一個位置上的值 訪問某個歷史版本上的某一位置的值 此外,每進行一次操作(對於操作2,即為生成一個完全一樣的版本,不作任何改動),就會

洛谷 P3835 【模板】可持久化平衡樹

正常 發生 using 我沒 持久化 pro 現在 class 小數 這個題也是可以用可持久化線段樹來解決的。 值域線段樹(也有的叫權值線段樹)可以用來維護一個可重集,並實現一些一般情況下平衡樹才能實現的事情。 如果用值來當做區間左右端點,每個葉子節點上存某個值出現的次數,

【刷題】洛谷 P3834 【模板】可持久化線段樹 1(主席樹)

!= tchar 這樣的 信息 reg har mem hair define 題目背景 這是個非常經典的主席樹入門題——靜態區間第K小 數據已經過加強,請使用主席樹。同時請註意常數優化 題目描述 如題,給定N個正整數構成的序列,將對於指定的閉區間查詢其區間內的第K小值。

P3834 【模板】可持久化線段樹 1(主席樹)

lose printf TE article 發現 AC 但是 || amp 題目背景 這是個非常經典的主席樹入門題——靜態區間第K小 數據已經過加強,請使用主席樹。同時請註意常數優化 題目描述 如題,給定N個正整數構成的序列,將對於

P3919 【模板】可持久化數組(可持久化線段樹/平衡樹)

數組 const spa lse 建立 clu reset c++ 包含 題目描述 如題,你需要維護這樣的一個長度為 N 的數組,支持如下幾種操作 在某個歷史版本上修改某一個位置上的值 訪問某個歷史版本上的某一位置的值 此外,每進行一次操作

【spark】dataframe常見操作

all data 通過 sch 兩個 執行計劃 min 內存 就是 spark dataframe派生於RDD類,但是提供了非常強大的數據操作功能。當然主要對類SQL的支持。 在實際工作中會遇到這樣的情況,主要是會進行兩個數據集的篩選、合並,重新入庫。 首先加載數據

洛谷 P3919 【模板】可持久化數組(可持久化線段樹/平衡樹)-可持久化線段樹(單點更新,單點查詢)

map sse 依次 數據規模 操作 str tps () 發現 P3919 【模板】可持久化數組(可持久化線段樹/平衡樹) 題目背景 UPDATE : 最後一個點時間空間已經放大 標題即題意 有了可持久化數組,便可以實現很多衍生的可持久化功能(例如:可持久化並查集

Luogu P3835 【模板】可持久化平衡樹

P3835 【模板】可持久化平衡樹 題意 題目背景 本題為題目普通平衡樹的可持久化加強版。 題目描述 您需要寫一種資料結構(可參考題目標題),來維護一些數,其中需要提供以下操作(對於各個以往的歷史版本): 插入\(x\)數 刪除\(x\)數(若有多個相同的數,因只刪除一個,如果沒有請忽略