【深度學習】線性迴歸(三)使用MXNet深度學習框架實現線性迴歸

阿新 • • 發佈:2018-12-15

文章目錄

概述

這篇文章使用MXNet深度學習框架中的Gluon包實現小批量隨機梯度下降的線性迴歸問題。可以參考我的上一篇文章【深度學習】線性迴歸(二)小批量隨機梯度下降及其python實現。

主要包括:

- Gluon提供了data來讀取資料

- Gluon的nn(neural network)模組定義了大量神經網路的層

- Gluon的initialize模組提供了模型引數初始化的方法

- Gluon的loss模組提供了各種損失函式

程式碼

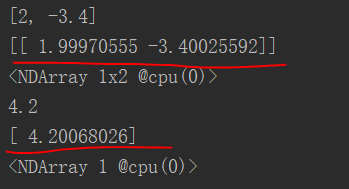

# coding=utf-8 實驗結果如下,紅線標出了我們得到的引數值,很真實值已經很接近了。