快速入門CDH(Cloudera Hadoop)叢集的搭建

在此說明,本人用的是普通使用者(如hadoop)

一、建立三臺虛擬機器

如何建立在本人部落格裡有詳細介紹,這裡就不詳細介紹了。

二、修改IP,以及主機名等

1、修改IP:

sudo vi /etc/sysconfig/network-scripts/ifcfg-eth0

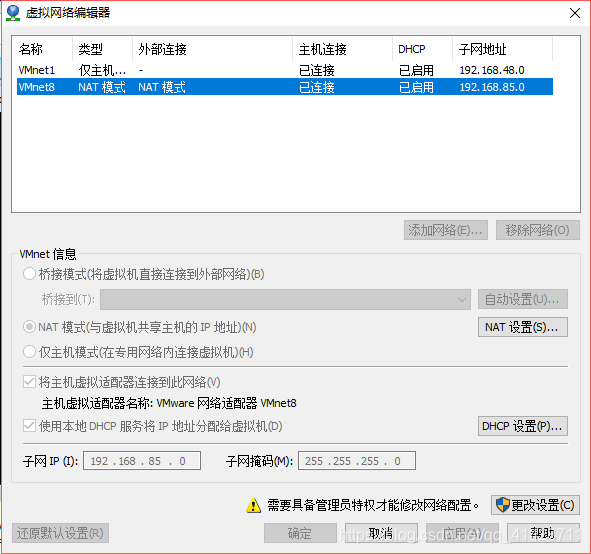

IPADDR:對應自己設定的IP,但是前三個數字要和虛擬網路編輯器中的NAT模式下的子網一樣:

ONBOOT:設定為yes

BOOTPROTO:設定為static

GATEWAY:前上個數和子網一樣,最後一個數為2

DNS1:設定為和GATEWAY一樣,或者設定為8.8.8.8:

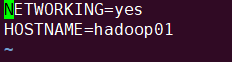

2、修改主機名:

sudo vi /etc/sysconfig/network

修改為自己想設定的名字(如hadoop01)

檢視是否修改成功:

hostname

3、配置IP對應的主機名:

sudo vi /etc/hosts

在配置檔案中新增IP對應的主機名

4、關閉防火牆:

一次關閉:

sudo service iptables status:檢視防火牆的狀態

sudo service iptables stop:關閉防火牆

關閉開機自啟動:

sudo chkconfig iptables off

5、記得重啟下服務:

sudo service network restart

三、實現ssh免密登入

如果三臺機器用來搭建叢集,可以將namenode所在的機器來免密其他兩臺。

在namenode上執行如下命令:

1、進入到:

cd ~/.ssh

2、生成公鑰和金鑰:

ssh-keygen`

然後敲(三個回車),就會生成兩個檔案id_rsa(私鑰),id_rsa.pub(公鑰)

3、將公鑰拷貝到要免密登入的目標機器上:

ssh-copy-id 目標機器IP(如果配置了IP對應的主機名,在此可以寫主機名)

ssh-copy-id 目標機器IP

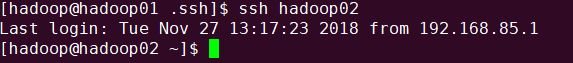

4、測試是否免密成功:

ssh 主機名

第一次需要輸入密碼,但是再次測試,就不需要輸入密碼,直接登入進去

四、實現時間同步

1、檢視當前時間:

date

2、顯示硬體時間:

sudo hwclock

3、調整時區:

sudo ln -sf /usr/share/zoneinfo/Asia/Shanghai /etc//localtime

4、下載Linux時間同步服務軟體(ntpdate):

sudo yum -y install ntpdate

5、同步網路時間:

sudo ntpdate time.nuri.net

6、同步時間成功後調整硬體時間:

sudo hwclock -w

7、同步成功,測試一下:

date

sudo hwclock

五、安裝jdk,三臺都需要安裝

如何進行安裝,本人部落格中有詳細介紹,可前往瀏覽!!!

六、安裝hadoop,配置叢集 叢集部署規劃:

1、新增壓縮包

將hadoop壓縮包放到“/home/hadoop/tools”下,三臺都要放

2、解壓

將壓縮包解壓,並解壓到“/home/hadoop/install/”下

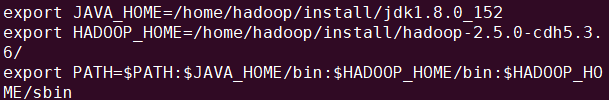

3、配置全域性的hadoop

將hadoop配置到/etc/profile中:

4、修改配置檔案(先修改一臺,改好之後分發)

如何配置在本人的部落格中,還得勞煩讀客前去翻閱!!!

5、配置完成後,使用命令分發

七、使用指令碼,實現同步命令

1、在每臺機器上安裝rsync:

sudo yum -y install rsync

2、將編寫的xsync指令碼放到/usr/local/bin下

3、進入到/usr/local/bin下:

cd /usr/local/bin/

4、為xsync指令碼賦權:

sudo chmod 777 xsync

賦權後,檔案顏色如此:

5、將配置好的機器上的配置檔案分發到其他兩臺機器上:

(1)core-site.xml

xsync /home/hadoop/install/hadoop-2.5.0-cdh5.3.6/etc/hadoop/core-site.xml

xsync /home/hadoop/install/hadoop-2.5.0-cdh5.3.6/etc/hadoop/hadoop-env.sh

(3)hdfs-site.xml

xsync /home/hadoop/install/hadoop-2.5.0-cdh5.3.6/etc/hadoop/hdfs-site.xml

(4)slaves

xsync /home/hadoop/install/hadoop-2.5.0-cdh5.3.6/etc/hadoop/slaves

(5)yarn-env.sh

xsync /home/hadoop/install/hadoop-2.5.0-cdh5.3.6/etc/hadoop/yarn-env.sh

(6)yarn-site.xml

xsync /home/hadoop/install/hadoop-2.5.0-cdh5.3.6/etc/hadoop/yarn-site.xml

xsync /home/hadoop/install/hadoop-2.5.0-cdh5.3.6/etc/hadoop/mapred-env.sh

(8)mapred-site.xml

xsync /home/hadoop/install/hadoop-2.5.0-cdh5.3.6/etc/hadoop/mapred-site.xml

八、叢集搭建完成,啟動測試

1、如果叢集是第一次啟動,需要格式化 namenode :

hdfs namenode -format

2、啟動HDFS:

start-dfs.sh

3、啟動YARN:

start-yarn.sh

注意:Namenode 和 ResourceManger 如果不是同一臺機器,不能在 NameNode 上啟動 yarn,應該在 ResouceManager 所在的機器上啟動yarn。

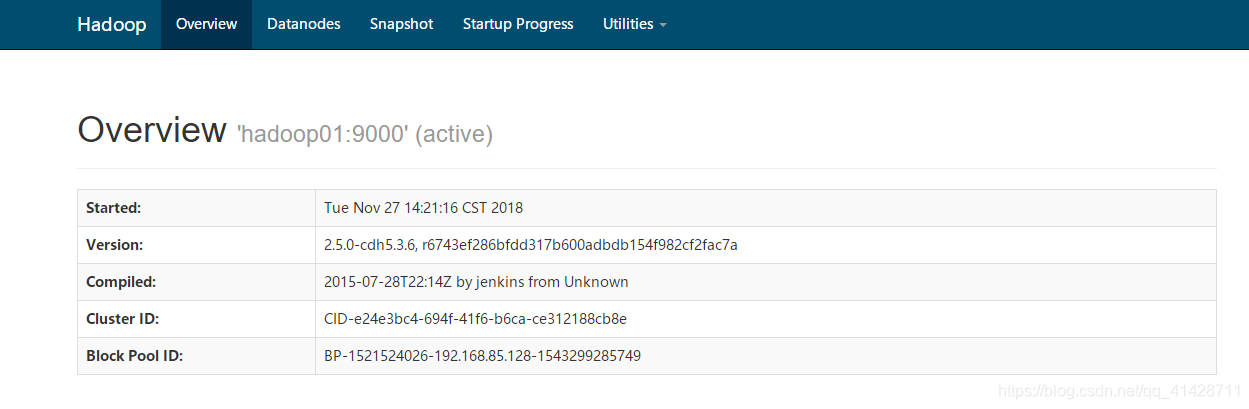

4、通過Web介面檢視是否叢集啟動成功:

(1)HDFS的Web訪問介面:

http://192.168.85.128:50070

顯示此介面表示啟動成功:

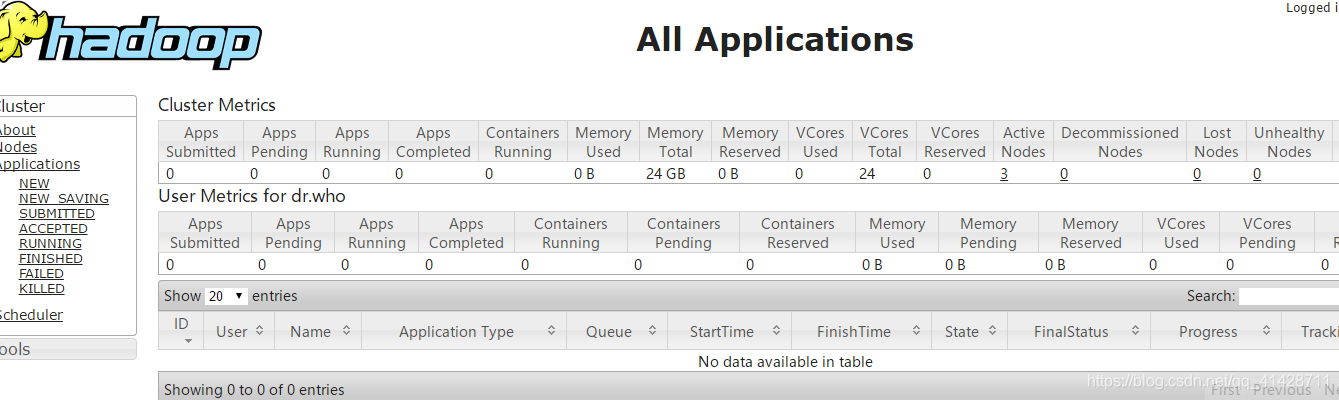

(2)YARN的Web訪問介面:

http://192.168.85.130:8088

顯示此介面表示啟動成功:

望各位大神留下你珍貴的足跡!!!需要的軟體可以去資源中下載。。。