NLP+VS︱深度學習資料集標註工具、影象語料資料庫、實驗室搜尋ing....

一、NLP標註工具

Chinese-Annotator

能不能構建一箇中文文字的標註工具,可以達到以下兩個特點:

標註過程背後含有智慧演算法,將人工重複勞動降到最低;

標註介面顯而易見地友好,讓標註操作儘可能簡便和符合直覺。

答案是可以的。事實上很多標註工具已經做到了這一點,最先進的如Explosion.ai的Prodigy;然而開發了著名的NLP開源包Spacy的explosion.ai選擇了將Prodigy閉源,而Spacy支援中文也仍然遙遙無期。我們希望構建一個開源的中文文字標註工具,而本文很多的技術靈感正是來自Prodigy文件。

流程:

使用者標一個label

主動學習的後臺演算法分為online和offline部分。online部分即時更新模型,可使用諸如SVM、bag of words等儘可能快的傳統方法;offline部分當標註資料積累到一定數量時更新模型,可使用準確度較高的深度學習模型。

模型更新後,對儘可能多的example做預測,將確信度排序,取確信度最低的一個example作為待標註例子。重複1的過程。

可以想象如果模型訓練得好的話,這個過程將直接忽略掉確信度最大的那些例子,而把所有重點放在分類邊界上的那些確信度小的例子。這樣可以盡演算法所能減少使用者端的人工工作量。

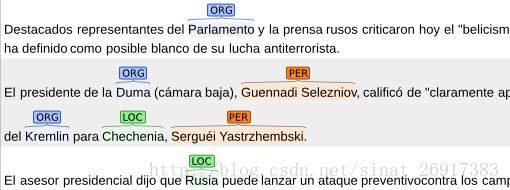

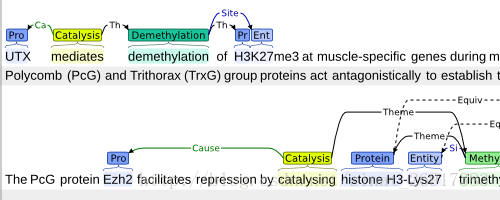

1 BRAT

BRAT是一個基於web的文字標註工具,主要用於對文字的結構化標註,用BRAT生成的標註結果能夠把無結構化的原始文字結構化,供計算機處理。利用該工具可以方便的獲得各項NLP任務需要的標註語料。以下是利用該工具進行命名實體識別任務的標註例子。

WeTest輿情團隊在使用:http://wetest.qq.com/bee/

使用案例:http://blog.csdn.net/owengbs/article/details/49780225

2 Prodigy

Prodigy給了一個非常好的demo,每一次的標註只需要使用者解決一個case的問題。以文字分類為例,對於演算法給出的分類結果,只需要點選“正確”提供正樣本,“錯誤”提供負樣本,“略過”將不相關的資訊濾除,“Redo”讓使用者撤回操作,四個功能鍵以最簡模式讓使用者進行標註操作。

真正應用中,應該還要加入一個使用者自己加入標註的互動方式,比如使用者可以高亮一個詞然後選擇是“公司”,或者連結兩個實體選擇他們的關係等等。

3 IEPY

整個工程比較完整,有使用者管理系統。前端略重,對使用者不是非常友好

4、DeepDive (Mindtagger)

前端比較簡單,使用者介面友好。

將DeepDive的corenlp部分轉為支援中文的程式碼嘗試:

5 SUTDAnnotator

用的不是網頁前端而是pythonGUI,但比較輕量。

支援中文

7 Slate

8 Prodigy

和著名的spacy是一家做的

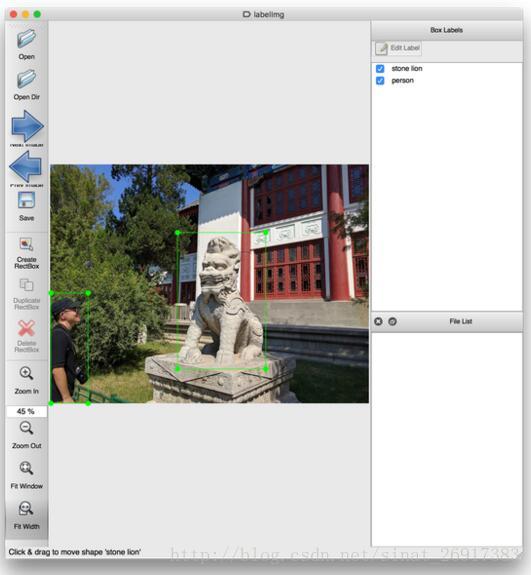

二、VS標註工具——LabelImg

1、PyQt

2、Vatic

參考:人工智慧AI工具-視訊標註工具vatic的搭建和使用

視訊標註工具vatic,Vatic源自MIT的一個研究專案(Video Annotation Tool from Irvine, California)。輸入一段視訊,支援自動抽取成粒度合適的標註任務並在流程上支援接入亞馬遜的眾包平臺Mechanical Turk。

Vatic源自MIT的一個研究專案(Video Annotation Tool from Irvine, California)。輸入一段視訊,支援自動抽取成粒度合適的標註任務並在流程上支援接入亞馬遜的眾包平臺Mechanical Turk。除此之外,其還有很多實用的特性:

1.簡潔使用的GUI介面,支援多種快捷鍵操作

2.基於opencv的tracking,這樣就可以抽樣的標註,減少工作量

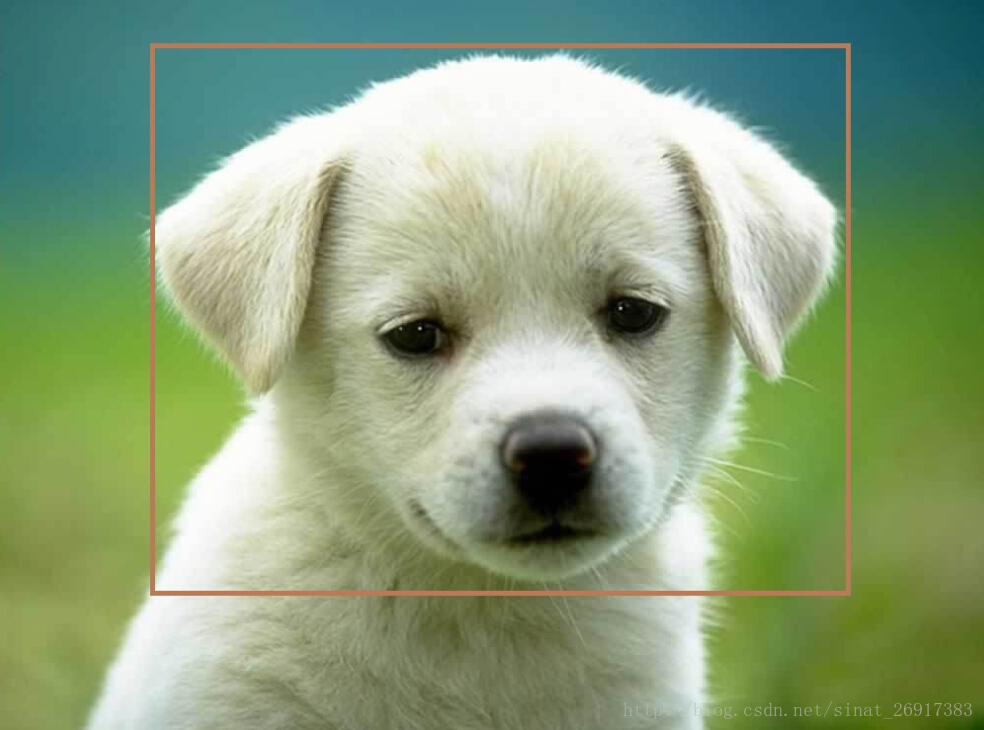

具體使用時,可以設定要標註的物體label,比如:水果,人,車,等等。然後指派任務給到眾包平臺(也可是自己的資料工程師)。現階段支援的標註樣式是框(box)。一個示例,下圖標註了NBA直播比賽中的運動員

.

3、BBox-Label-Tool

.

4、影象標註VS2013專案

有人自己寫了一個版本:

打框的程式碼(c++)我封裝成了dll,下載地址:影象標註VS2013專案 (我的環境是win7vs2013旗艦版,win8 win10好像不能執行)

別人封裝的opencv動態庫,現在修改為opencv2.4.10,64位,vs2013,按網上教程配置好opencv,資源地址:

影象標註EXE-2016-10-18

上面的程式碼好像忘寫操作說明了,這裡寫一下:

(1)圖片顯示出來後,輸入法切換到英文;

(2)在目標的左上角按下滑鼠左鍵,拉一個包圍框到目標右下角,然後鍵盤輸入標籤(一個字元)

(3)繼續(2)操作,直到框完該張圖片上的目標;

(4)按n進入下一張,esc退出。

注意:標籤只能輸入一個字元,你可以在生成的txt檔案中替換成你實際的標籤。

.

5、Yolo_mark

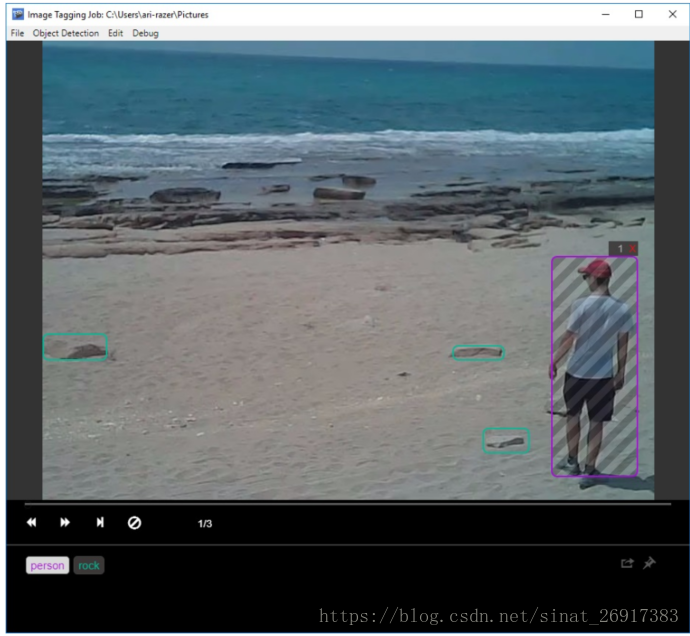

6、視訊標註工具

CDVA(compact descriptor for video analysis),主要是基於CDVS中的緊湊視覺描述子來做視訊分析,之前是緊湊視覺描述子主要應用在影象檢索領域。需要製作新的資料集,對視訊幀進行標註,所以根據網上一個博主的標註工具進行了一定的修改,實現的功能是在每一幀中將需要標註的區域用滑鼠選取4個點,順序是順時針。因為四邊形的範圍更廣,之前的一些人直接標註了矩形,但是在一些仿射變換中,往往矩形的定位效果不好,矩形定位應該比較適合於人臉定位和行人定位之中。

http://www.cnblogs.com/louyihang-loves-baiyan/p/4457462.html

7、微軟釋出的視覺化影象/視訊標記工具 VoTT

該工具支援以下功能:

能夠標記和註釋影象目錄或獨立視訊。

使用 Camshift 跟蹤演算法輔助計算機標記和跟蹤視訊中的物體。

將標籤和資源匯出到 Custom Vision Service CNTK,Tensorflow(PascalVOC)或YOLO 格式,用於訓練物件檢測模型。

在新視訊中使用主動學習與訓練物件檢測模型(本地或遠端)結合生成更強大的模型。

Github 連結:

阿里雲市場上公開售賣的,厲害了!

.

.

三、Amazon’s Mechanical Turk 離線工作框架

一個開源的Amazon’s Mechanical Turk 離線工作框架,基於Django搭建的

github網址:https://github.com/hltcoe/turkle

.

.

四、用已訓練來進行影象標註

《使用深度學習和Fisher向量進行圖片標註》(paper)

主講人Lior Wolf,特拉維夫大學的教員在一次倫敦深度學習會議上的一次公開演講:

為了實現影象標註和搜尋,他們最開始用CNNs將圖片轉換成向量,用Word2Vec將詞語轉換成向量。大部分研究工作都集中於如何將詞語向量結合到語句向量之中,由此產生了基於Fisher向量的模型。一旦他們得到了語句向量,他們使用典型相關分析(CCA)將圖片表示和語句表示投射到同一空間裡,使影象和句子可以匹配,找到最近鄰的部分。

五、snape

人工資料集生成工具,來看一段有趣的獨白:

Snape is primarily used for creating complex datasets that challenge

students and teach defense against the dark arts of machine learning.

專門是針對機器學習領域自動生成資料集。

安裝:

Via Github

git clone https://github.com/mbernico/snape.git

cd snape

python setup.py install- 1

- 2

- 3

.

.

延伸一 國內一些眾包的資料標註服務商

裡面確實有一些影象分類、影象標註的任務。但是也不是很多。

2、小魚兒網

我的技能時間交易平臺小魚兒網成立最晚,但卻走了最具網際網路思維的盈利之路,增值服務盈利,平臺在整個過程交易中不收取費用,提供大資料分析,篩選服務者等增值服務,主動權完全交給使用者,網際網路時代,流量為王,使用者為王,小魚兒網的盈利模式無疑向這個宗旨貼近的,長期來看,這種盈利模式或許最聰明。

挺大的,但是沒有看到有影象的任務。

中國最專業威客網站一品威客網借鑑了豬八戒盈利模式的短板,對使用者劃分普通使用者和vip使用者,對普通使用者實行免費,對VIP使用者收取會員費,在網際網路時代,有效的籠絡住了大批使用者的心,不失為一種好的盈利模式。

國內最大的眾包了吧,但是影象標識專案很少,商家也幾乎沒有看到..

4、資料堂

確確實實有資料標註,而且有文字、語音、圖片採集專案。

5、百度眾包

裡面有很多工與案例,文字、語音、圖片都有。

6、阿里眾包

影象採集任務?

7、薈萃公司——薈萃-薈集人力之萃

語音轉化

可替您將文字轉成語音、文字轉成方言(真人語音),識別語音、歌曲等。

視訊識別

可以為您完成視訊內容收集,字幕識別,視訊內容鑑定等內容。

視訊創作

為您拍攝或收集某一主題的視訊,以小視訊形式上傳。

網頁展示任務

可自定義任意網頁在使用者端展示時間,如新品推廣、廣告觀看等型別。

自定義任務

搶票?秒殺?聯絡上下文?只要你腦洞夠大,任意H5網頁類任務皆可接入。

地平線具有世界領先的深度學習和決策推理演算法開發能力,將演算法整合在高效能、低功耗、低成本的嵌入式人工智慧處理器及軟硬體平臺上。地平線目前提供基於ARM/FPGA等處理器的解決方案,同時開發自主設計研發的Brain Processing Unit (BPU) — 一種創新的嵌入式人工智慧處理器架構IP,提供裝置端上完整開放的嵌入式人工智慧解決方案。

公司核心業務面向智慧駕駛和智慧生活等應用場景,目前已成功推出了面向智慧駕駛應用的“雨果”平臺及面向智慧生活的“安徒生”平臺,與國內國際頂尖的汽車Tier 1、OEMs及家電廠商展開了深入的合作,並在成立僅一年多的時間內成功推出量產產品。地平線也正積極搭建開放的嵌入式人工智慧產業生態,與產業上下游共同合作發展。

2017年1月6日,地平線與英特爾於CES聯合釋出了基於單目攝像頭和FPGA的最新ADAS系統,可實現在高速公路和市區道路場景下,同時對行人、車輛、車道線和可行駛區域的實時檢測和識別。2016年8月1日,地平線與美的聯合釋出了“智慧王”櫃機空調,擁有手勢控制、智慧送風、智慧安防三大新功能。

.

.

六、影象資料集

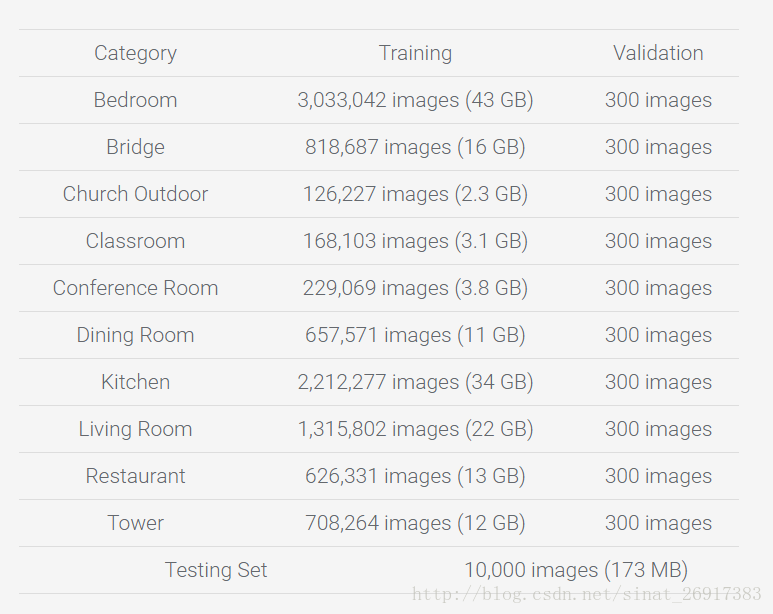

1、LSUN:用於場景理解和多工輔助(房間佈局估計,顯著性預測等)。

2、行人檢測DataSets

(1).基於背景建模:利用背景建模方法,提取出前景運動的目標,在目標區域內進行特徵提取,然後利用分類器進行分類,判斷是否包含行人;

(2).基於統計學習的方法:這也是目前行人檢測最常用的方法,根據大量的樣本構建行人檢測分類器。提取的特徵主要有目標的灰度、邊緣、紋理、顏色、梯度直方圖等資訊。分類器主要包括神經網路、SVM、adaboost以及現在被計算機視覺視為寵兒的深度學習。

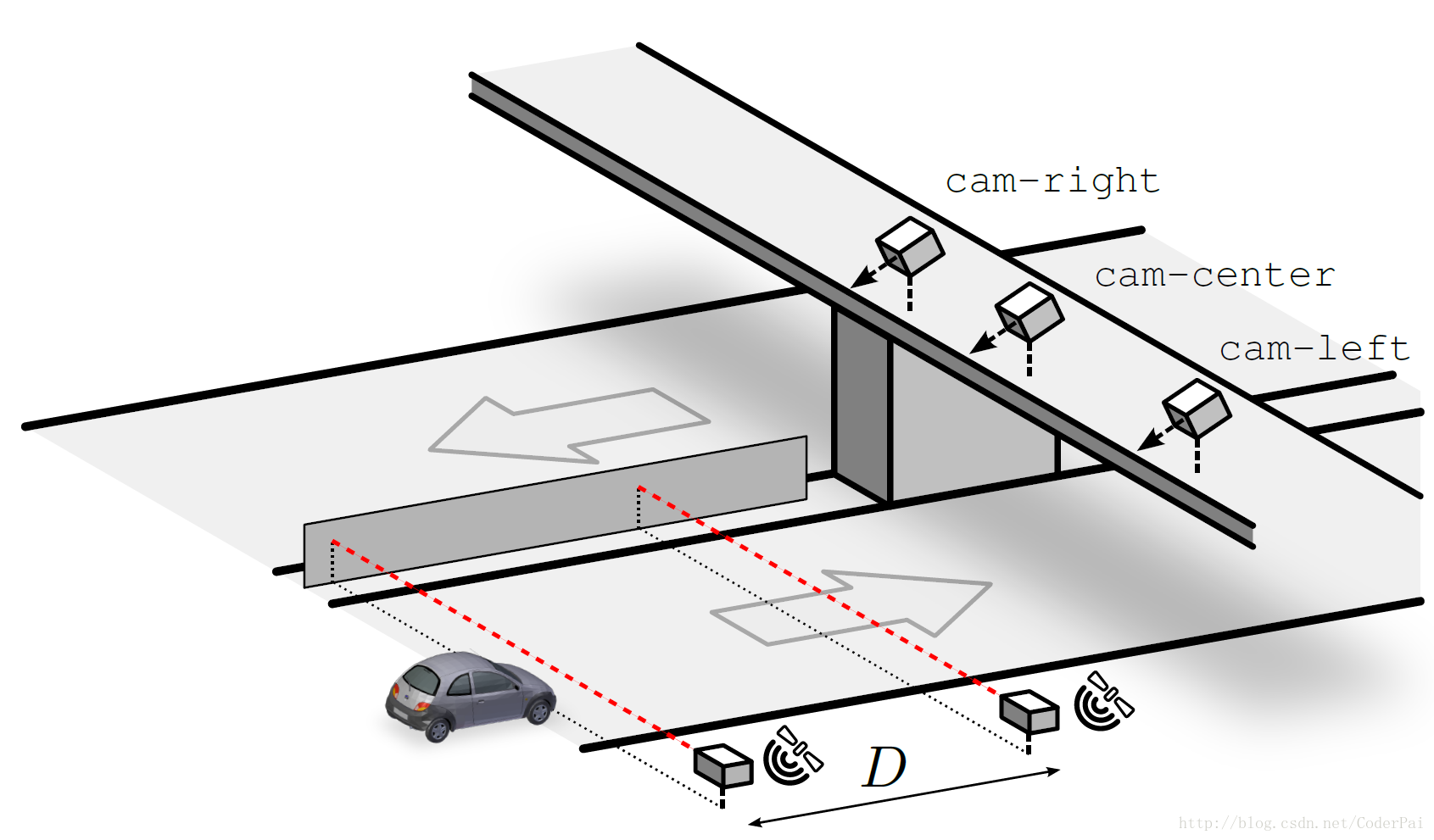

該資料庫是目前規模較大的行人資料庫,採用車載攝像頭拍攝,約10個小時左右,視訊的解析度為640×480,30幀/秒。標註了約250,000幀(約137分鐘),350000個矩形框,2300個行人,另外還對矩形框之間的時間對應關係及其遮擋的情況進行標註。資料集分為set00~set10,其中set00~set05為訓練集,set06~set10為測試集(標註資訊尚未公開)。效能評估方法有以下三種:(1)用外部資料進行訓練,在set06~set10進行測試;(2)6-fold交叉驗證,選擇其中的5個做訓練,另外一個做測試,調整引數,最後給出訓練集上的效能;(3)用set00~set05訓練,set06~set10做測試。由於測試集的標註資訊沒有公開,需要提交給Pitor Dollar。結果提交方法為每30幀做一個測試,將結果儲存在txt文件中(檔案的命名方式為I00029.txt I00059.txt ……),每個txt檔案中的每行表示檢測到一個行人,格式為“[left, top,width, height, score]”。如果沒有檢測到任何行人,則txt文件為空。該資料庫還提供了相應的Matlab工具包,包括視訊標註資訊的讀取、畫ROC(Receiver Operatingcharacteristic Curve)曲線圖和非極大值抑制等工具。

3、人臉資料庫UMDFaces等

(1)UMDFaces

http://www.umdfaces.io/

不僅有人臉的目標檢測資料,還有關鍵點的資料,非常適合做訓練。

就是比較大,總共有三個檔案,一共8000+個類別,總共36W張人臉圖片,全都是經過標註的樣本,標註資訊儲存在csv檔案中,除了人臉的box,還有人臉特徵點的方位資訊,強力推薦!

(2)人臉識別資料庫

1. 李子青組的 CASIA-WebFace(50萬,1萬個人). 需申請.Center for Biometrics and Security Research

2. 華盛頓大學百萬人臉MegaFace資料集. 郵件申請, 是一個60G的壓縮檔案. MegaFace

3. 南洋理工 WLFDB. (70萬+,6,025). 需申請. WLFDB : Weakly Labeled Faces Database

4. 微軟的MSRA-CFW ( 202792 張, 1583人). 可以直接通過OneDrive下載.MSRA-CFW: Data Set of Celebrity Faces on the Web

5. 湯曉歐實驗室的CelebA(20萬+), 標註資訊豐富. 現在可以直接從百度網盤下載 Large-scale CelebFaces Attributes (CelebA) Dataset

6. FaceScrub. 提供圖片下載連結(100,100張,530人). vintage – resources

4、搜狗實驗室資料集:

網際網路圖片庫來自sogou圖片搜尋所索引的部分資料。其中收集了包括人物、動物、建築、機械、風景、運動等類別,總數高達2,836,535張圖片。對於每張圖片,資料集中給出了圖片的原圖、縮圖、所在網頁以及所在網頁中的相關文字。200多G

格式說明:

共包括三個檔案:Meta_Data,Original_Pic,Evaluation_Data。其中Meta_Data儲存圖片的相關元資料;Original_Pic中儲存圖片的原圖;Evaluation_Data是識圖搜尋結果的人工標註集合。

Meta_Data檔案包含所有圖片的相關元資料,格式如下:

<PIC>

<PIC_URL>圖片在網際網路中的URL地址</PIC_URL>

<PAGE_URL>圖片所在網頁的URL地址</PAGE_URL>

<ALT_TEXT>圖片的替換文字</ALT_TEXT>

<ANCHOR_TEXT>以圖片為目標的超連結的顯示文字</ANCHOR_TEXT>

<SUR_TEXT1>頁面中提取的圖片上方的文字</SUR_TEXT1>

<SUR_TEXT2>頁面中提取的圖片下方的文字</SUR_TEXT2>

<PAGE_TITLE>圖片所在網頁的標題</PAGE_TITLE>

<CONTENT_TITLE>圖片所在網頁的正文標題</ CONTENT_TITLE>

<WIDTH>圖片的寬度</WIDTH>

<HEIGHT>圖片的高度</HEIGHT>

<ORIGINAL_PIC_NAME>圖片在Original_Pic下的檔名</ ORIGINAL_PIC_NAME>

</PIC>

圖片原圖儲存在Original_Pic檔案中,每個圖片二進位制資料儲存成一個單獨檔案,檔名在Meta_Data的元資訊中指明。

Evaluation_Data檔案包含所有圖片的相關元資料,格式如下:

<PIC>

<QUERY_URL>查詢圖片在網際網路中的URL地址</QUERY_URL>

<RESULT_URL>搜尋結果的 PIC_URL,多個分號隔開</RESULT_URL>

</PIC>- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

5、Imagenet資料集

業界標杆

Imagenet資料集有1400多萬幅圖片,涵蓋2萬多個類別;其中有超過百萬的圖片有明確的類別標註和影象中物體位置的標註,具體資訊如下:

1)Total number of non-empty synsets: 21841

2)Total number of images: 14,197,122

3)Number of images with bounding box annotations: 1,034,908

4)Number of synsets with SIFT features: 1000

5)Number of images with SIFT features: 1.2 million

Imagenet資料集是目前深度學習影象領域應用得非常多的一個領域,關於影象分類、定位、檢測等研究工作大多基於此資料集展開。Imagenet資料集文件詳細,有專門的團隊維護,使用非常方便,在計算機視覺領域研究論文中應用非常廣,幾乎成為了目前深度學習影象領域演算法效能檢驗的“標準”資料集。

與Imagenet資料集對應的有一個享譽全球的“ImageNet國際計算機視覺挑戰賽(ILSVRC)”,以往一般是google、MSRA等大公司奪得冠軍,今年(2016)ILSVRC2016中國團隊包攬全部專案的冠軍。

Imagenet資料集是一個非常優秀的資料集,但是標註難免會有錯誤,幾乎每年都會對錯誤的資料進行修正或是刪除,建議下載最新資料集並關注資料集更新。

資料集大小:~1TB(ILSVRC2016比賽全部資料)

下載地址:

6、COCO資料集

COCO資料集由微軟贊助,其對於影象的標註資訊不僅有類別、位置資訊,還有對影象的語義文字描述,COCO資料集的開源使得近兩三年來影象分割語義理解取得了巨大的進展,也幾乎成為了影象語義理解演算法效能評價的“標準”資料集。

Google開源的開源了圖說生成模型show and tell就是在此資料集上測試的,想玩的可以下下來試試哈。

資料集大小:~40GB

COCO(Common Objects in Context)是一個新的影象識別、分割和影象語義資料集,它有如下特點:

1)Object segmentation

2)Recognition in Context

3)Multiple objects per image

4)More than 300,000 images

5)More than 2 Million instances

6)80 object categories

7)5 captions per image

8)Keypoints on 100,000 people

7、PASCAL VOC

PASCAL VOC挑戰賽是視覺物件的分類識別和檢測的一個基準測試,提供了檢測演算法和學習效能的標準影象註釋資料集和標準的評估系統。PASCAL VOC圖片集包括20個目錄:人類;動物(鳥、貓、牛、狗、馬、羊);交通工具(飛機、自行車、船、公共汽車、小轎車、摩托車、火車);室內(瓶子、椅子、餐桌、盆栽植物、沙發、電視)。PASCAL VOC挑戰賽在2012年後便不再舉辦,但其資料集影象質量好,標註完備,非常適合用來測試演算法效能。

資料集大小:~2GB

下載地址:

8、Open Image

過去幾年機器學習的發展使得計算機視覺有了快速的進步,系統能夠自動描述圖片,對共享的圖片創造自然語言迴應。其中大部分的進展都可歸因於 ImageNet 、COCO這樣的資料集的公開使用。谷歌作為一家偉大的公司,自然也要做出些表示,於是乎就有了Open Image。

Open Image是一個包含~900萬張影象URL的資料集,裡面的圖片通過標籤註釋被分為6000多類。該資料集中的標籤要比ImageNet(1000類)包含更真實生活的實體存在,它足夠讓我們從頭開始訓練深度神經網路。

谷歌出品,必屬精品!唯一不足的可能就是它只是提供圖片URL,使用起來可能不如直接提供圖片方便。

此資料集,筆者也未使用過,不過google出的東西質量應該還是有保障的。

資料集大小:~1.5GB(不包括圖片)

下載地址:

9、Youtube-8M

Youtube-8M為谷歌開源的視訊資料集,視訊來自youtube,共計8百萬個視訊,總時長50萬小時,4800類。為了保證標籤視訊資料庫的穩定性和質量,谷歌只採用瀏覽量超過1000的公共視訊資源。為了讓受計算機資源所限的研究者和學生也可以用上這一資料庫,谷歌對視訊進行了預處理,並提取了幀級別的特徵,提取的特徵被壓縮到可以放到一個硬碟中(小於1.5T)。

此資料集的下載提供下載指令碼,由於國內網路的特殊原因,下載此資料經常斷掉,不過還好下載指令碼有續傳功能,過一會兒重新連線就能再連上。可以寫一個指令碼檢測到下載中斷後就sleep一段時間然後再重新請求下載,這樣就不用一直守著了。(截至發文,斷斷續續的下載,筆者表示還沒下完呢……)

資料集大小:~1.5TB

10、深度學習資料集收集網站

收集大量的各深度學習相關的資料集,但並不是所有開源的資料集都能在上面找到相關資訊。

11、CoPhIR

雅虎釋出的超大Flickr資料集,包含1億多張圖片。

12、MirFlickr1M

Flickr資料集中挑選出的100萬影象集。

13、SBU captioned photo dataset

Flickr的一個子集,包含100萬的影象集。

14、NUS-WIDE

Flickr中的27萬的影象集。

15、MSRA-MM

包含100萬的影象,23000視訊;微軟亞洲研究院出品,質量應該有保障。

.

HICO has images containing multiple objects and these objects have been tagged along with their relationships. The proposed problem is for algorithms to be able to dig out objects in an image and relationship between them after being trained on this dataset. I expect multiple papers to come out of this dataset in future.

.

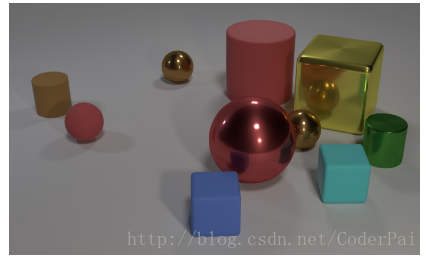

17、QA型影象資料庫:CLEVR: A Diagnostic Dataset for Compositional Language and Elementary Visual Reasoning

CLEVR is an attempt by Fei-Fei Li’s group, the same scientist who developed the revolutionary ImageNet dataset. It has objects and questions asked about those objects along with their answers specified by humans. The aim of the project is to develop machines with common sense about what they see. So for example, the machine should be able to find “an odd one out” in an image automatically. You can download the dataset here.

.

18、Driver Speed Dataset

A 200 Gb huge dataset, which is aimed to calculate speed of moving vehicles. Can be downloaded here.

.

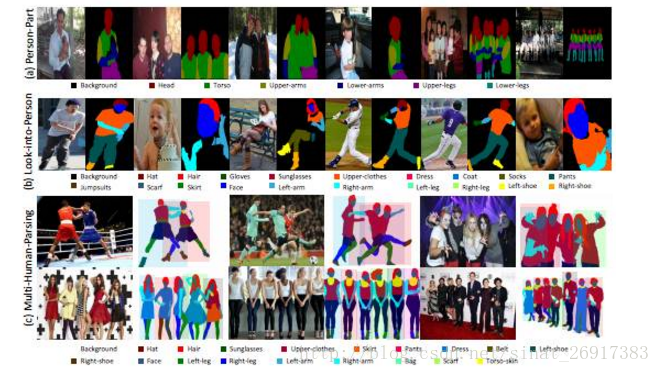

為了進一步推進人物解析研究,作者首創多人解析(MHP)資料集,每張影象均包含現實世界場景中的多個人物。 具體而言,MHP資料集的每張圖片包含2-16個人物不等,每個人物按照18個語義類別(背景除外)進行畫素級別的標註。此外,MHP影象中的人物有多種姿態、不同程度的遮擋以及多樣化的互動。為了解決所提出的多人解析這一難題,作者提出了一個新型的多人解析器 (MH-Parser)模型,在針對每個人物進行端到端解析的過程中,同時考慮全域性資訊與區域性資訊。實驗結果表明,這一模型遠優於簡單的“檢測+解析”方法,使得其作為一個穩定的基準,助推未來在真實場景中人物解析的相關研究。

.

20、300k動作標註視訊資料集

DeepMind 最新發布30萬 YouTube 視訊剪輯的 Kinetics 資料集,包含400類人類動作註釋,有助於視訊理解機器學習。

Kinetics 是一個大規模、高質量的 YouTube 視訊URL資料集,包含了各種各樣的人類動作標記。我們釋出 Kinetics 資料集的目的是助力機器學習社群推進視訊理解模型的研究。

Kinetics 資料集包含大約30萬個視訊剪輯,涵蓋400類人類動作,每類動作至少有400個視訊剪輯。每個剪輯時長約10秒,並被標記一個動作類別。所有剪輯都經過多輪人工註釋,每個剪輯都來自一個單獨的 YouTube 視訊。這些動作包含了廣泛的人類-物體互動的動作,例如演奏樂器,以及人類-人類互動的動作,例如握手和擁抱。

Kinetics 是 ActivityNet 組織的國際人類動作分類競賽(international human action classification competition)的基礎資料集。

.

21、MIT 新發布大型資料集 ADE20K:用於場景感知、語義理解等多種任務

譬如:

影象資料

綜合影象

Visual Genome 影象資料

Visual7w 影象資料

COCO 影象資料

SUFR 影象資料

ILSVRC 2014 訓練資料(ImageNet的一部分)

PASCAL Visual Object Classes 2012 影象資料

PASCAL Visual Object Classes 2011 影象資料

PASCAL Visual Object Classes 2010 影象資料

80 Million Tiny Image 影象資料【資料太大僅有介紹】

ImageNet【資料太大僅有介紹】

Google Open Images【資料太大僅有介紹】

場景影象

Street Scences 影象資料

Places2 場景影象資料

UCF Google Street View 影象資料

SUN 場景影象資料

The Celebrity in Places 影象資料

.

23、AVA: 5萬+視訊/80+動作/21萬+標籤的視訊行為標記資料集

google最新提供了一份5萬+視訊/80+動作/21萬+標籤的視訊行為標記資料集。

一、視訊動作標籤型別

stand (45790)

sit (30037)

talk to (e.g., self, a person, a group) (29020)

watch (a person) (25552)

listen to (a person) (21557)

carry/hold (an object) (18381)

walk (12765)

bend/bow (at the waist) (2592)

lie/sleep (1897)

dance (1406)

ride (e.g., a bike, a car, a horse) (1344)

run/jog (1146)

answer phone (1025)

watch (e.g., TV) (993)

grab (a person) (936)

smoke (860)

eat (828)

fight/hit (a person) (707)

sing to (e.g., self, a person, a group) (702)

read (698)

crouch/kneel (678)

touch (an object) (670)

hug (a person) (667)

martial art (624)

open (e.g., a window, a car door) (594)

play musical instrument (545)

give/serve (an object) to (a person) (473)

hand clap (470)

lift/pick up (452)

get up (439)

drink (410)

drive (e.g., a car, a truck) (383)

kiss (a person) (370)

put down (369)

write (340)

close (e.g., a door, a box) (334)

listen (e.g., to music) (290)

catch (an object) (281)

take (an object) from (a person) (257)

hand wave (241)

lift (a person) (201)

pull (an object) (193)

hand shake (179)

jump/leap (151)

dress/put on clothing (130)

push (another person) (122)

text on/look at a cellphone (115)

fall down (114)

throw (99)

sail boat (96)

work on a computer (94)

play with kids (70)

hit (an object) (67)

crawl (61)

enter (58)

take a photo (57)

climb (e.g., a mountain) (57)

push (an object) (56)

play with pets (52)

point to (an object) (45)

cut (43)

shoot (41)

dig (40)

press (38)

play board game (35)

swim (32)

cook (31)

clink glass (30)

fishing (27)

paint (25)

row boat (23)

extract (17)

stir (15)

chop (15)

brush teeth (14)

kick (a person) (13)

kick (an object) (10)

exit (9)

turn (e.g., a screwdriver) (8)

七、“稀有”實驗室

1、生物識別與安全技術研究中心

CASIA行為分析資料庫共有1446條視訊資料,是由室外環境下分佈在三個不同視角的攝像機拍攝而成,為行為分析提供實驗資料。資料分為單人行為和多人互動行為,單人行為包括走、跑、彎腰走、跳、下蹲、暈倒、徘徊和砸車,每類行為有24人蔘與拍攝,每人4次左右。多人互動行為有搶劫、打鬥、尾隨、趕上、碰頭、會合和超越,每兩人1次或2次。

- 1

該實驗室擁有的資料庫:虹膜資料庫,步態資料庫,人臉資料庫,指紋資料庫,掌紋資料庫,筆跡資料庫,行為分析資料庫

該實驗室研究成果:

近紅外的人臉身份識別技術和系統, 中遠距離人臉識別系統, 人臉檢測與跟蹤, 多目標遮擋跟蹤, 目標檢測、跟蹤與分類, 異常動作檢測, 人異常行為檢測與報警, 交通車輛計數演示, 主從攝像機跟蹤,

多攝像機資料融合(全景監控地圖), 交通擁堵檢測與報警, 車輛異常行為檢測與報警, 夜間跟蹤演示, 動態場景下的主動跟蹤, 視訊影象序列拼接, 人數統計, 視訊濃縮

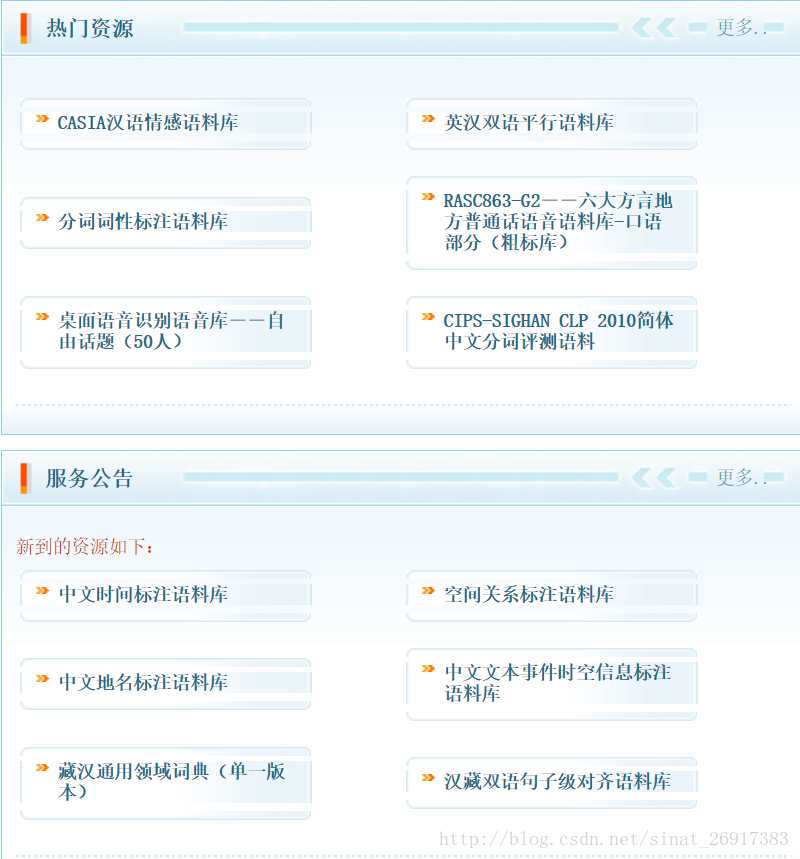

2、中文語言資源聯盟

中文語言資源聯盟,英文譯名Chinese Linguistic Data Consortium,縮寫為CLDC。 CLDC是由中國中文資訊學會語言資源建設和管理工作委員會發起,由中文語言(包括文字、語音、文字等)資源建設和管理領域的科技工作者自願組成的學術性、公益性、非盈利性的社會團體,其宗旨是團結中文語言資源建設領域的廣大科技工作者,建成代表中文資訊處理國際水平的、通用的中文語言語音資源庫。

當然,裡面的內容都是收費的,而且不便宜,不過畢竟是好東西~

3、中科院自動化研究所 模式識別國家重點實驗室

影象識別方向的技術有:

高清車牌及車標識別技術、不良圖片過濾、圖片檢索技術

5、中國科學技術大學,影象處理實驗室

http://image.ustc.edu.cn/project.html

國家自然基金重點專案:高解析度SAR影象目標認知模型及高效演算法

國家自然科學基金專案:星上原始超光譜影象稀疏編碼壓縮技術研究

973課題:稀疏微波成像資料壓縮及特徵理解

果然有錢!!

7、網頁版呈現各類模型的實現

八、中文文字語料庫

(一) 國家語委

現代漢語通用平衡語料庫現在重新開放網路查詢了。重開後的線上檢索速度更快,功能更強,同時提供檢索結果下載。現代漢語語料庫線上提供免費檢索的語料約2000萬字,為分詞和詞性標註語料。

網站現在還增加了一億字的古代漢語生語料,研究古代漢語的也可以去查詢和下載。同時,還提供了分詞、詞性標註軟體、詞頻統計、字頻統計軟體,基於國家語委語料庫的字頻詞頻統計結果和釋出的詞表等,以供學習研究語言文字的老師同學使用。

(二) 北京大學計算語言學研究所

《人民日報》標註語料庫中一半的語料(1998年上半年)共1300萬字已經通過《人民日報》新聞資訊中心公開提供許可使用權。其中一個月的語料(1998年1月)近200萬字在網際網路上公佈,供自由下載。

(三) 北京語言大學

百度開源的中文問答語料:

公開語料:

蒐集到的一些資料集如下,點選連結可以進入原始地址

The NUS SMS Corpus

包含中文和英文簡訊息語料,據說是世界最大公開的短訊息語料

ChatterBot中文基本聊天語料

ChatterBot聊天引擎提供的一點基本中文聊天語料,量很少,但質量比較高

Datasets for Natural Language Processing

這是他人收集的自然語言處理相關資料集,主要包含Question Answering,Dialogue Systems, Goal-Oriented Dialogue Systems三部分,都是英文文字。可以使用機器翻譯為中文,供中文對話使用

小黃雞

據傳這就是小黃雞的語料:xiaohuangji50w_fenciA.conv.zip (已分詞) 和 xiaohuangji50w_nofenci.conv.zip (未分詞)

保險行業語料庫

資料集分為兩個部分“問答語料”和“問答對語料”。問答語料是從原始英文資料翻譯過來,未經其他處理的。問答對語料是基於問答語料,又做了分詞和去標去停,新增label。所以,”問答對語料”可以直接對接機器學習任務。如果對於資料格式不滿意或者對分詞效果不滿意,可以直接對”問答語料”使用其他方法進行處理,獲得可以用於訓練模型的資料。

微博終結者爬蟲

這個專案致力於對抗微博的反爬蟲機制,集合眾人的力量把微博成千上萬的微博評論語料爬取下來並製作成一個開源的高質量中文對話語料,推動中文對話系統的研發。

github:https://github.com/jinfagang/weibo_terminater