HDFS常用Java API程式碼演示

1、 建立資料夾

2、 上傳檔案

3、 下載檔案

3、 下載檔案

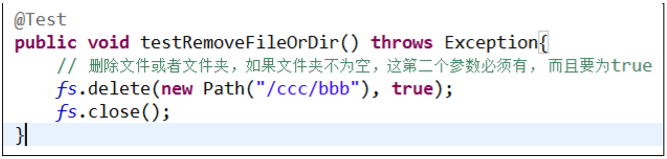

4、 刪除檔案或者資料夾

4、 刪除檔案或者資料夾

5、 重新命名檔案或者資料夾

5、 重新命名檔案或者資料夾

6、 檢視目錄資訊,只顯示該資料夾下的檔案資訊

6、 檢視目錄資訊,只顯示該資料夾下的檔案資訊  7、 檢視檔案及資料夾資訊

7、 檢視檔案及資料夾資訊

相關推薦

HDFS常用Java API程式碼演示

1、 建立資料夾 2、 上傳檔案 3、 下載檔案 4、 刪除檔案或者資料夾 5、 重新命名檔案或者資料夾 6、 檢視目錄資訊,只顯示該資料夾下的檔案資訊 7、 檢視檔案及資料夾資訊

掌握HDFS的Java API接口訪問

lock getpath println bsp paths bar 下載 param syntax HDFS設計的主要目的是對海量數據進行存儲,也就是說在其上能夠存儲很大量文件(可以存儲TB級的文件)。HDFS將這些文件分割之後,存儲在不同的DataNode上,

HBase 常用java api獲得客戶端,創建表,查詢,刪除

size 列族 war pen 需要 java pool 數據類型 init 1,前期準備 (1) 本文采用的hbase是采用三臺服務器搭建的集群,zookeeper也是相同服務器搭建的集群,集群ip分別是192.168.183.101; 192.168.183.102;

elasticsearch常用JAVA API 實例

tool actor tag 測試 實體類 sea isp nan del 1.引入dependency <dependency> <groupId>org.springframework.data</groupI

常用Java API 熟悉 方法 從記不得到忘不掉 java1.8.61為例

熟悉jDK自帶的常用API是十分有必要的 今天 2018/8/15 先來熟悉 最常用的 版本為 jdk 1.8.0_161 首先 明確一下 Java 到底是值傳遞還是引用傳遞? https://www.zhihu.com/question/31203609 也許這個知乎話題能夠解

HDFS的Java API( Java API封裝類)

修改 com eight oot font pat con for inpu HDFS的Java API Java API封裝類 package com.hadoop.utils; import org.apache.commons.lang.StringUtils;

[Hadoop 2] 常用 Java API 及應用例項

1 開啟 Eclipse,開始建立專案,選擇頂部選單 File->New->Java Project,建立名為 HadoopTest 專案,如下圖: 2 為專案載入所需要的 jar 包。 如何獲取 jar 包: Java API 所在的 jar 包都在已經

kafka系列五、kafka常用java API

引入maven包 <dependency> <groupId>org.apache.kafka</groupId> <artifactId>kafka_2.11</artifactId> <

hbase命令實踐與java api程式碼實踐

名稱空間(namespace): 預設為default名稱空間 list_namespace create_namespace ‘my_ns’ create ‘my_ns:my_table’,’fam’ exists ‘my_ns:my_table’

HDFS 使用Java api實現上傳/下載/刪除檔案

import java.io.IOException; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; publ

Hadoop --- 入門之HDFS的JAVA API操作

JAR準備: 將hadoop-2.8.0中share目錄下的jar包新增到工程中: common下的hadoop-common-2.8.0.jar common/lib下的所有jar hdfs下的hadoop-hdfs-2.8.0.jar hdfs/lib下的所有j

大資料(hadoop-HDFS的本地開發環境的配置與常見的HDFS的JAVA API)

HDFS的本地開發環境搭建 1:所需工具 1)hadoop2.7.3安裝包 2)hadoop-eclipse-plugin

常用 Java 靜態程式碼分析工具的分析與比較

簡介: 本文首先介紹了靜態程式碼分析的基本概念及主要技術,隨後分別介紹了現有 4 種主流 Java 靜態程式碼分析工具

hdfs常用api(java)

下載文件 lte tao rgs data open handler hostname 虛擬 1.下載文件到本地 public class HdfsUrlTest { static{ //註冊url 讓java程序識別hdfs的url URL.setURLStreamHan

【筆記】HDFS簡單API程式碼(Java)的使用

一、構造客戶端 //1. 客戶端載入配置檔案 Configuration conf= new Configuration(); //2.指定配置,設定副本數、指定塊大小等等 conf.set("dfs.replication", "1"); co

常用JAVA操作HDFS叢集的API開發

常用JAVA操作HDFS叢集的API開發 1.HDFS檔案上傳(測試副本數引數優先順序) 2.HDFS檔案下載 3.HDFS資料夾刪除 4.HDFS檔名更改 5. HDFS檔案詳情檢視 6.HDFS檔案和資料夾判斷 1.H

HDFS常用的Java Api詳解

一、使用Hadoop URL讀取資料 package hadoop; import java.io.InputStream; import java.net.URL; import org.apache.hadoop.fs.FsUrlStreamHandlerFactory; import org.

呼叫JAVA API對HDFS檔案進行檔案的讀寫、上傳下載、刪除等操作程式碼詳解

Hadoop檔案系統 基本的檔案系統命令操作, 通過hadoop fs -help可以獲取所有的命令的詳細幫助檔案。 Java抽象類org.apache.hadoop.fs.FileSystem定義了hadoop的一個檔案系統介面。該類是一個抽象類,通過以下兩種靜態工廠方

Elasticsearch5.0 Java Api(八) -- 常用DSL查詢

stack pub metrics get ddr 結果 dsl onclick bsp 測試常用的DSL組合查詢功能 1 package com.juyun.test; 2 3 import java.net.InetAddress;

HDFS Java API的使用舉例

lap tmp author company 守護 mapred err ips cond HDFS是Hadoop應用程序使用的主要分布式存儲。HDFS集群主要由管理文件系統元數據的NameNode和存儲實際數據的DataNodes組成,HDFS架構圖描述了NameNo