網路結構解讀之inception系列四:Inception V3

Inception V3根據前面兩篇結構的經驗和新設計的結構的實驗,總結了一套可借鑑的網路結構設計的原則。理解這些原則的背後隱藏的動機比單純知道這個操作更有意義。

Rethinking the Inception Architecture for Computer Vision

-

主題:如何高效的增大網路規模

通過分解卷積和正則實現高效計算

-

設計網路原則

1.避免表徵瓶頸。大部分時候,特徵大小應當緩慢變小,在變小的同時增加維度。(下采樣是減小資訊,而升維是增加資訊)

2.高維特徵更容易區域性處理,收斂更快。(高維易分)

3.空間聚合能通過低維嵌入達到無損。(concat前可以降維,效能損失接近無)

4.平衡寬度和深度。(寬度和深度的比例要合適)

以上原則或許是有意義的,但不能直接參照,是在不明確的時候下使用的。(相對來說可靠,但不是絕對的原則)

-

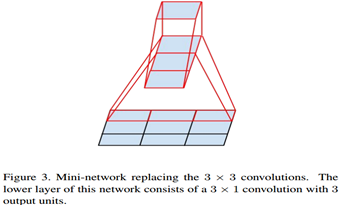

分解卷積

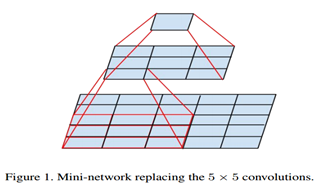

2個3*3代替1個5*5 減少28%的計算量。

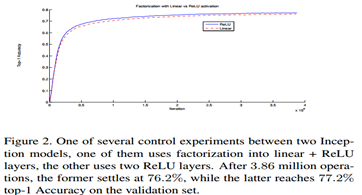

一個問題,第一個3*3後接線性啟用會不會比ReLU更好?(因為5*5是線性操作,而2個3*3去代替的話全程應當是線性操作)實驗結果,relu更優,作者猜測是因為網路能夠學習這種空間變化的增強(實驗證明這是資料增強)

-

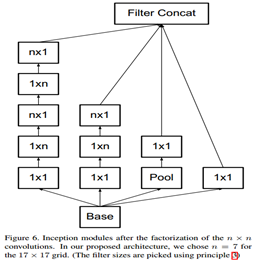

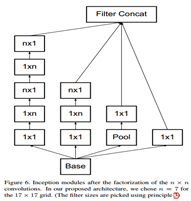

非對稱分解

3*3卷積分解2個2*2節省11%計算量,而分解成1*3和3*1節省33%

理論上,任何卷積都能分解成不對稱卷積,但實驗發現,在低層次效果不好,在12到20層加較好

-

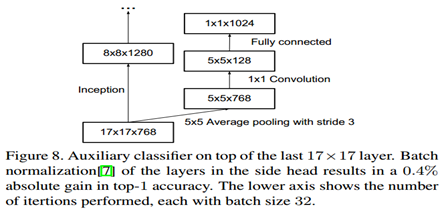

輔助分類器

經過實驗觀察,輔助分類器在訓練初期無明顯作用,接近訓練結束時效能開始超越,作者認為起到正則化作用。

-

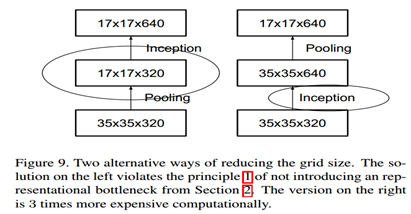

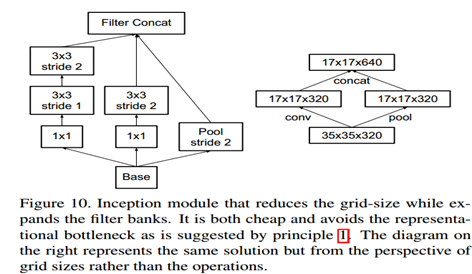

高效降解析度(下采樣)

按照準則1,在使用pooling進行下采樣前,啟用值要升維。

參照下圖,如果使用左邊的方式,違背準則1。如果使用右邊,計算量較大(V1是這種方式)

Inception Reduction Module

Inception Reduction Module

-

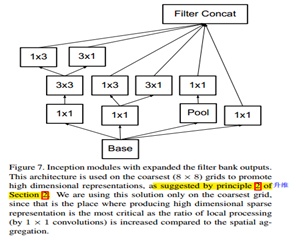

結構InceptionV2(V3去掉BN)

5*5分解卷積 非對稱卷積

基於原則2高維易分

-

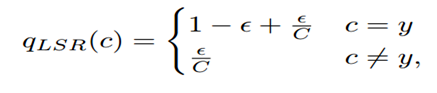

標籤平滑正則LSR ( label smoothing regularization )

作者認為硬標籤下softmaxloss會過擬合,改為soft label。

croos-entropy:![]()

![]()

最終損失:![]()

LSR:

最終損失:![]()

-

低解析度輸入實驗

-

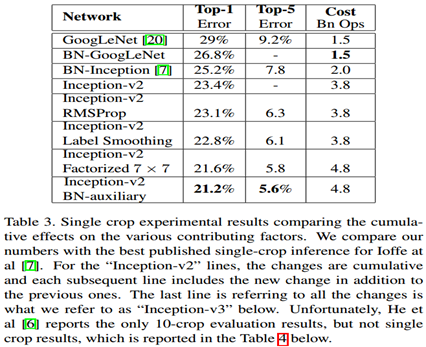

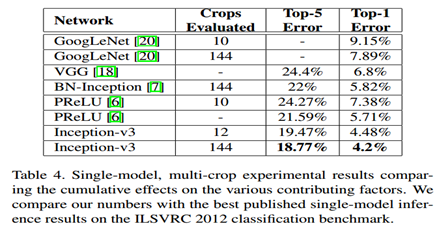

Inception對比實驗