presto叢集安裝並集合

環境 presto 版本 presto-server-0.203.tar.gz cdh CDH5.13

1.在Presto官網下載presto-server-0.203.tar.gz安裝包

2.解壓 壓縮包 解壓路徑為tar -zxvf presto-server-0.203.tar.gz -C /opt/cloudera/parcels/presto

3.為presto-server-0.205建立persto軟連結 # ln -s presto-server-0.203 presto

4…在/opt/cloudera/parcels/presto/bin/launcher檔案如下位置新增JAVA環境變數(本人1,8)

JAVA_HOME=/usr/java/jdk1.8.0_131 PATH=PATH

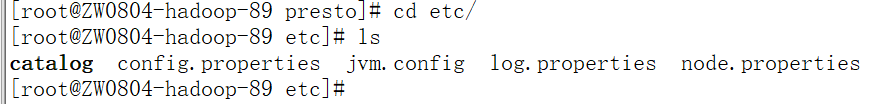

開啟 presto cd presto 新建 etc 配置檔案路徑 mkdir etc

本人選擇 Coordinator 和 Worker 在同一個節點方式部署

配置檔案為

其中 主節點 config 配置為 coordinator=true node-scheduler.include-coordinator=true http-server.http.port=10808 query.max-memory=32GB query.max-memory-per-node=16GB discovery-server.enabled=true discovery.uri=http://192.168.1.89:10808

jvm 配置為

-server -Xmx60G -XX:+UseConcMarkSweepGC -XX:+ExplicitGCInvokesConcurrent -XX:+CMSClassUnloadingEnabled -XX:+AggressiveOpts -XX:+HeapDumpOnOutOfMemoryError -XX:OnOutOfMemoryError=kill -9 %p -XX:ReservedCodeCacheSize=150M -Djava.library.path=/opt/cloudera/parcels/GPLEXTRAS-5.13.0-1.cdh5.13.0.p0.29/lib/hadoop-0.20-mapreduce/lib/native -DHADOOP_USER_NAME=hdfs

log 配置為

com.facebook.presto=INFO

node 配置為

node.environment=prestocluster node.id=presto-01 node.data-dir=/data0/presto

從幾點 node 和 config 有差異

config 為

coordinator=false http-server.http.port=10808 query.max-memory=32GB query.max-memory-per-node=16GB discovery.uri=http://192.168.1.89:10808

node 為

node.environment=prestocluster node.id=presto-02 node.data-dir=/data0/presto

其他從節點類似

所有節點在 catalog 下 配置hive.properties

配置為 connector.name=hive-hadoop2 hive.metastore.uri=thrift://192.168.1.96:9083 hive.config.resources=/etc/hive/conf/core-site.xml,/etc/hive/conf/hdfs-site.xml hive.allow-drop-table=false hive.allow-rename-table=false hive.allow-add-column=false hive.allow-rename-column=false

注意 其中各個配置含有路徑 都為本地 ,請確定本地路徑下存在如此的檔案

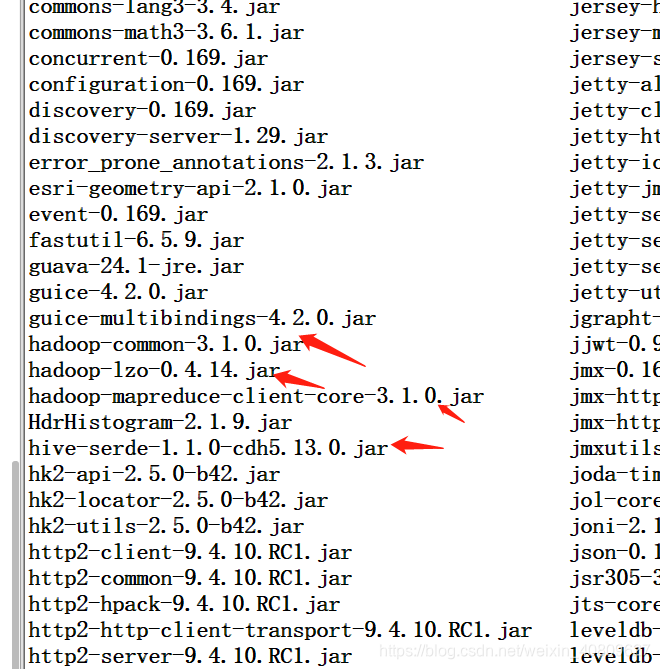

在每個節點的 presto 的lib 下 新增 下面的包 (根據cdh 版本)

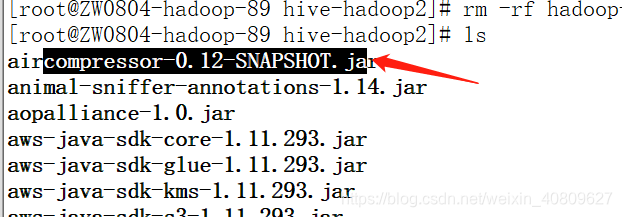

且在每個節點 修改 此包的版本為 一下

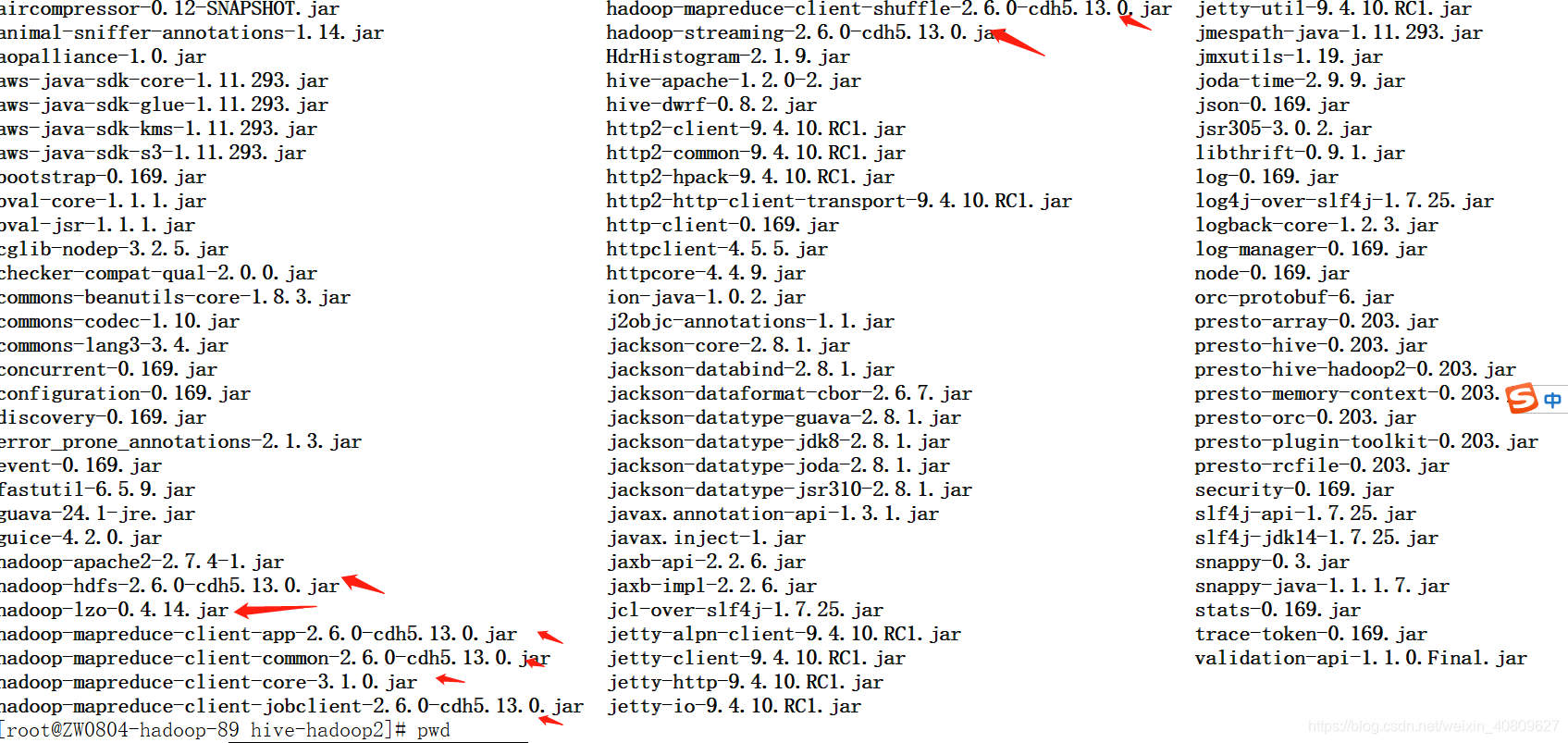

在每個節點 /presto/plugin/hive-hadoop2 下 新增 (根據自己cdh )