CentOS7.5 使用二進位制程式部署Kubernetes1.12.2(三)

一、安裝方式介紹

1、yum 安裝

目前CentOS官方已經把Kubernetes源放入到自己的預設 extras 倉庫裡面,使用 yum 安裝,好處是簡單,壞處也很明顯,需要官方更新 yum 源才能獲得最新版本的軟體,而所有軟體的依賴又不能自己指定,尤其是你的作業系統版本如果低的話,使用 yum 源安裝的 Kubernetes 的版本也會受到限制,通常會低於官方很多版本,我安裝的時候目前官方版本為1.12,而 yum 源中的版本為1.5.2。

請檢視博文:http://blog.51cto.com/wzlinux/2321767

2、二進位制安裝

使用二進位制檔案安裝,好處是可以安裝任意版本的 Kubernetes,對一些新版本新功能追求的同學比較合適,壞處是配置比較複雜,很多軟體包因為一些原因,我們在大陸是訪問不到的。

3、Kubeadm 安裝

kubeadm 是 Kubernetes 官方提供的用於快速安裝 Kubernetes 叢集的工具,伴隨Kubernetes每個版本的釋出都會同步更新,kubeadm會對叢集配置方面的一些實踐做調整,通過實驗 kubeadm 可以學習到 Kubernetes 官方在叢集配置上一些新的最佳實踐。

請檢視博文:http://blog.51cto.com/wzlinux/2322616

這裡我們選用第二種方式安裝。

二、環境準備

1、軟體版本

我們安裝的版本基本是目前最新的版本。

| 軟體 | 版本 |

|---|---|

| kubernetes | v1.12.2 |

| CentOS 7.5 | CentOS Linux release 7.5.1804 |

| Docker | v18.06 這是官方推薦的 |

| etcd | 3.3.10 |

| flannel | 0.10.0 |

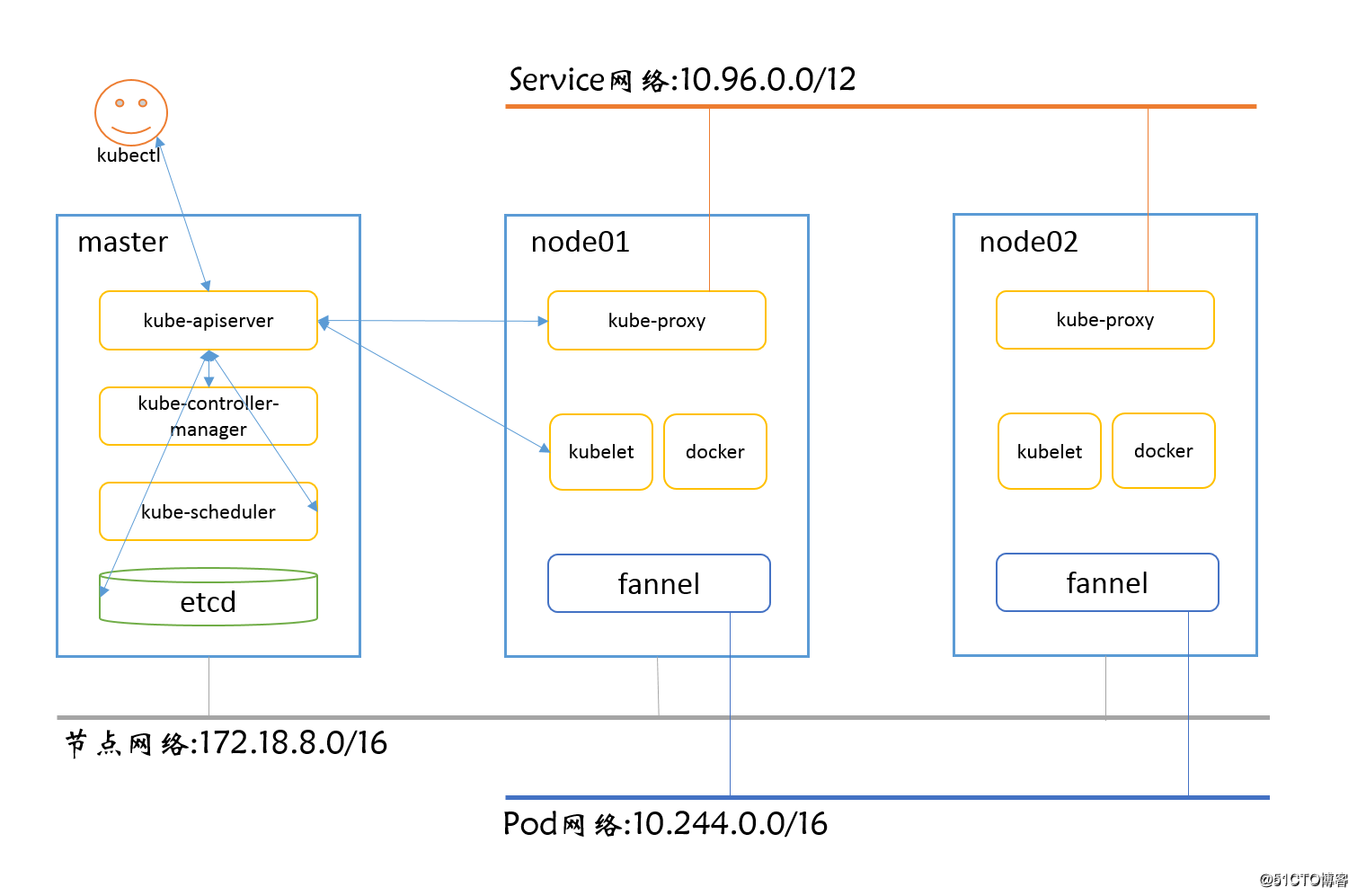

2、節點規劃

| IP | 角色 | 安裝軟體 |

|---|---|---|

| 172.18.8.200 | k8s master | etcd,kube-apiserver,kube-controller-manager,kube-scheduler,kubelet |

| 172.18.8.201 | k8s node01 | docker,kubelet,kube-proxy,flannel |

| 172.18.8.202 | k8s node02 | docker,kubelet,kube-proxy,flannel |

節點及網路規劃如下:

3、系統配置

關閉防火牆。

systemctl stop firewalld

systemctl disable firewalld配置/etc/hosts,新增如下內容。

172.18.8.200 master.wzlinux.com master

172.18.8.201 node01.wzlinux.com node01

172.18.8.202 node02.wzlinux.com node02關閉SELinux。

sed -i 's#SELINUX=enforcing#SELINUX=disabled#g' /etc/selinux/config

setenforce 0關閉swap。

swapoff -a

sed -i 's/.*swap.*/#&/' /etc/fstab4、二進位制軟體包下載

我們可以下載編譯好的二進位制檔案,也可以下載原始碼自己編譯,這裡只討論二進位制的安裝方式。在Kubernetes的Github CHANGELOG日誌中可以看到最新的版本號,也可以到Tag頁面中找到自己需要的版本,我下載的是 v1.12.2。

上傳我們下載的二進位制軟體包到各節點,並解壓在root家目錄,檢視目錄內容。

[[email protected] ~]# ll kubernetes/server/bin/

total 1821524

-rwxr-xr-x 1 root root 60859975 Oct 24 15:49 apiextensions-apiserver

-rwxr-xr-x 1 root root 142923436 Oct 24 15:49 cloud-controller-manager

-rw-r--r-- 1 root root 8 Oct 24 15:44 cloud-controller-manager.docker_tag

-rw-r--r-- 1 root root 144309760 Oct 24 15:44 cloud-controller-manager.tar

-rwxr-xr-x 1 root root 248021112 Oct 24 15:49 hyperkube

-rwxr-xr-x 1 root root 54042644 Oct 24 15:49 kubeadm

-rwxr-xr-x 1 root root 192781649 Oct 24 15:49 kube-apiserver

-rw-r--r-- 1 root root 8 Oct 24 15:44 kube-apiserver.docker_tag

-rw-r--r-- 1 root root 194167808 Oct 24 15:44 kube-apiserver.tar

-rwxr-xr-x 1 root root 162961401 Oct 24 15:49 kube-controller-manager

-rw-r--r-- 1 root root 8 Oct 24 15:44 kube-controller-manager.docker_tag

-rw-r--r-- 1 root root 164347392 Oct 24 15:44 kube-controller-manager.tar

-rwxr-xr-x 1 root root 57352138 Oct 24 15:49 kubectl

-rwxr-xr-x 1 root root 176648680 Oct 24 15:49 kubelet

-rwxr-xr-x 1 root root 50330867 Oct 24 15:49 kube-proxy

-rw-r--r-- 1 root root 8 Oct 24 15:44 kube-proxy.docker_tag

-rw-r--r-- 1 root root 98355200 Oct 24 15:44 kube-proxy.tar

-rwxr-xr-x 1 root root 57184656 Oct 24 15:49 kube-scheduler

-rw-r--r-- 1 root root 8 Oct 24 15:44 kube-scheduler.docker_tag

-rw-r--r-- 1 root root 58570752 Oct 24 15:44 kube-scheduler.tar

-rwxr-xr-x 1 root root 2330265 Oct 24 15:49 mounter這些包都是儲存在google的伺服器上面,因為眾所周知的原因,我們是無法訪問的,所以需要各位科學上網才可以獲取,不過我可以把我獲取的包傳到網盤分享給大家。

大家可以去下載使用。連結: https://pan.baidu.com/s/1Ut9VERgm55B4lmz0wjjzFQ 提取碼: mjem

三、安裝master

master節點需要安裝的服務有kube-apiserver,kube-controller-manager,kube-scheduler,所以我們先把需要的二進位制檔案放到環境變數。

cd /root/kubernetes/server/bin

cp kube-apiserver kube-controller-manager kube-scheduler kubectl /usr/local/bin/建立需要的目錄。

mkdir -p /var/lib/etcd

mkdir -p /etc/etcd/

mkdir /etc/kubernetes1、安裝etcd

因為所以的元件都是需要etcd儲存,所以我們第一安裝的就是etcd,如果不是為了新版本,為了方便可以使用yum安裝。

我這裡採用二進位制安裝方法,首先下載安裝包。

下載。

wget https://github.com/etcd-io/etcd/releases/download/v3.3.10/etcd-v3.3.10-linux-amd64.tar.gz解壓安裝。

tar xf etcd-v3.3.10-linux-amd64.tar.gz

cd etcd-v3.3.10-linux-amd64

cp etcd etcdctl /usr/local/bin/建立system啟動檔案etcd.service。

cat <<EOF > /usr/lib/systemd/system/etcd.service

[Unit]

Description=etcd.service

[Service]

Type=notify

TimeoutStartSec=0

Restart=always

WorkingDirectory=/var/lib/etcd

EnvironmentFile=-/etc/etcd/etcd.conf

ExecStart=/usr/local/bin/etcd

[Install]

WantedBy=multi-user.target

EOF建立配置檔案。

cat <<EOF >/etc/etcd/etcd.conf

ETCD_NAME=ETCD Server

ETCD_DATA_DIR="/var/lib/etcd/"

ETCD_LISTEN_CLIENT_URLS=http://0.0.0.0:2379

ETCD_ADVERTISE_CLIENT_URLS="http://172.18.8.200:2379"

EOF啟動etcd。

systemctl daemon-reload

systemctl start etcd.service

systemctl enable etcd.service檢視啟動狀態。

[[email protected] ~]# netstat -tlnp|grep etcd

tcp 0 0 127.0.0.1:2380 0.0.0.0:* LISTEN 1550/etcd

tcp6 0 0 :::2379 :::* LISTEN 1550/etcd

[[email protected] ~]# etcdctl cluster-health

member 8e9e05c52164694d is healthy: got healthy result from http://172.18.8.200:2379

cluster is healthy說明: etcd 會啟用兩個埠,其中2380 是叢集的通訊埠,2379是服務埠。如果是配置etcd叢集,則要修改配置檔案,設定監聽IP和埠。

2、安裝 kube-apiserver

建立啟動檔案/usr/lib/systemd/system/kube-apiserver.service,修改為如下內容:

[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=network.target

After=etcd.service

[Service]

EnvironmentFile=/etc/kubernetes/apiserver

ExecStart=/usr/local/bin/kube-apiserver \

$KUBE_ETCD_SERVERS \

$KUBE_BIND_ADDRESS \

$KUBE_API_PORT \

$KUBE_SERVICE_ADDRESSES \

$KUBE_ADMISSION_CONTROL \

$KUBE_API_ARGS

Restart=on-failure

Type=notify

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target建立目錄和配置檔案。

cat <<EOF > /etc/kubernetes/apiserver

KUBE_BIND_ADDRESS="--bind-address=0.0.0.0"

KUBE_API_PORT="--port=8080"

KUBE_ETCD_SERVERS="--etcd-servers=http://172.18.8.200:2379"

KUBE_SERVICE_ADDRESSES="--service-cluster-ip-range=10.96.0.0/12"

KUBE_ADMISSION_CONTROL="--admission-control=NamespaceLifecycle,NamespaceExists,LimitRanger,SecurityContextDeny,ResourceQuota"

KUBE_API_ARGS=""

EOF啟動服務。

systemctl daemon-reload

systemctl start kube-apiserver.service

systemctl enable kube-apiserver.service檢視啟動是否成功。

[[email protected] ~]# netstat -tnlp | grep kube

tcp6 0 0 :::6443 :::* LISTEN 11086/kube-apiserve

tcp6 0 0 :::8080 :::* LISTEN 11086/kube-apiserve kube-apiserver監聽在兩個埠,6443是https加密通訊方式,8080是http的通訊方式,我們這裡沒有配置證書選項,所以我們的通訊都是明文通訊,官方文件檢視。

3、安裝kube-controller-manager

建立啟動檔案/usr/lib/systemd/system/kube-controller-manager.service,新增如下內容:

[Unit]

Description=Kubernetes Controller Manager

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=kube-apiserver.service

Requires=kube-apiserver.service

[Service]

EnvironmentFile=-/etc/kubernetes/controller-manager

ExecStart=/usr/local/bin/kube-controller-manager \

$KUBE_MASTER \

$KUBE_CONTROLLER_MANAGER_ARGS

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target建立配置檔案controller-manager,IP根據自己的實際情況進行修改。

cat <<EOF > /etc/kubernetes/controller-manager

KUBE_MASTER="--master=http://172.18.8.200:8080"

KUBE_CONTROLLER_MANAGER_ARGS=""

EOF啟動服務。

systemctl daemon-reload

systemctl start kube-controller-manager.service

systemctl enable kube-controller-manager.service驗證服務狀態。

[[email protected] ~]# netstat -lntp | grep kube-controll

tcp6 0 0 :::10252 :::* LISTEN 11131/kube-controll

tcp6 0 0 :::10257 :::* LISTEN 11131/kube-controll 埠10257為https提供身份驗證和授權,10252為預設非加密埠,官方文件檢視。

4、安裝kube-scheduler

建立啟動檔案/usr/lib/systemd/system/kube-scheduler.service,新增如下內容:

[Unit]

Description=Kubernetes Scheduler Plugin

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=kube-apiserver.service

Requires=kube-apiserver.service

[Service]

EnvironmentFile=/etc/kubernetes/scheduler

ExecStart=/usr/local/bin/kube-scheduler \

$KUBE_MASTER \

$KUBE_SCHEDULER_ARGS

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target建立配置檔案/etc/kubernetes/scheduler。

cat <<EOF > /etc/kubernetes/scheduler

KUBE_MASTER="--master=http://172.18.8.200:8080"

KUBE_SCHEDULER_ARGS=""

EOF啟動服務。

systemctl daemon-reload

systemctl start kube-scheduler.service

systemctl enable kube-scheduler.service驗證服務狀態。

[[email protected] ~]# netstat -lntp | grep kube-schedule

tcp6 0 0 :::10251 :::* LISTEN 11178/kube-schedule 埠10251是非加密埠,https埠為10259。官方檔案檢視。

使用 kubectl 檢視狀態。

[[email protected] ~]# kubectl get cs

NAME STATUS MESSAGE ERROR

etcd-0 Healthy {"health":"true"}

controller-manager Healthy ok

scheduler Healthy ok 四、安裝node節點(node01為例)

1、環境準備

node節點需要安裝的服務有docker,kubelet,kube-prox,flannel,所以我們先把需要的二進位制檔案放到環境變數。

cd /root/kubernetes/server/bin/

cp kubelet kube-proxy /usr/local/bin/載入ipvs核心,使node節點kube-proxy支援ipvs代理規則。

modprobe ip_vs_rr

modprobe ip_vs_wrr

modprobe ip_vs_sh建立需要的目錄。

mkdir /var/lib/kubelet

mkdir /etc/kubernetes配置轉發引數。

cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system2、安裝docker-ce

我們使用推薦的版本18.06,此時docker官方的最新版本為18.09,所以我們需要配置官方yum源。

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -P /etc/yum.repos.d/yum list docker-ce.x86_64 --showduplicates |sort -r

yum install docker-ce-18.06.1.ce -y配置加速器。

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://hdi5v8p1.mirror.aliyuncs.com"]

}

EOF2、安裝 kube-proxy 服務

建立啟動檔案/usr/lib/systemd/system/kube-proxy.service,新增如下內容:

[Unit]

Description=Kubernetes Kube-Proxy Server

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=network.target

[Service]

EnvironmentFile=/etc/kubernetes/proxy

ExecStart=/usr/local/bin/kube-proxy \

$KUBE_MASTER \

$KUBE_PROXY_ARGS

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target建立需要的配置檔案,IP請根據自己的實際情況進行修改。

cat <<EOF > /etc/kubernetes/proxy

KUBE_MASTER="--master=http://172.18.8.200:8080"

KUBE_PROXY_ARGS=""

EOF啟動服務。

systemctl daemon-reload

systemctl start kube-proxy.service

systemctl enable kube-proxy.service檢視啟動狀態。

[[email protected] ~]# netstat -lntp | grep kube-proxy

tcp 0 0 127.0.0.1:10249 0.0.0.0:* LISTEN 12273/kube-proxy

tcp6 0 0 :::10256 :::* LISTEN 12273/kube-proxy 埠10256負責健康檢查,10249負責和server通訊,官方文件檢視。

3、安裝 kubelete 服務

建立啟動檔案/usr/lib/systemd/system/kubelet.service,新增如下內容:

[Unit]

Description=Kubernetes Kubelet Server

Documentation=https://github.com/GoogleCloudPlatform/kubernetes

After=docker.service

Requires=docker.service

[Service]

WorkingDirectory=/var/lib/kubelet

ExecStart=/usr/local/bin/kubelet --kubeconfig=/etc/kubernetes/kubeconfig.yaml

Restart=on-failure

[Install]

WantedBy=multi-user.target建立配置檔案kubeconfig.yaml,具體引數請根據自己的需求進行修改,新增如下內容:

cat <<EOF > /etc/kubernetes/kubeconfig.yaml

apiVersion: v1

kind: Config

users:

- name: kubelet

clusters:

- name: kubernetes

cluster:

server: http://172.18.8.200:8080

contexts:

- context:

cluster: kubernetes

user: kubelet

name: service-account-context

current-context: service-account-context

EOF啟動kubelet。

systemctl daemon-reload

systemctl start kubelet.service

systemctl enable kubelet.service檢視啟動情況。

[[email protected] ~]# netstat -tnlp | grep kubelet

tcp 0 0 127.0.0.1:43228 0.0.0.0:* LISTEN 12658/kubelet

tcp 0 0 127.0.0.1:10248 0.0.0.0:* LISTEN 12658/kubelet

tcp6 0 0 :::10250 :::* LISTEN 12658/kubelet

tcp6 0 0 :::10255 :::* LISTEN 12658/kubelet 配置官方文件請檢視。

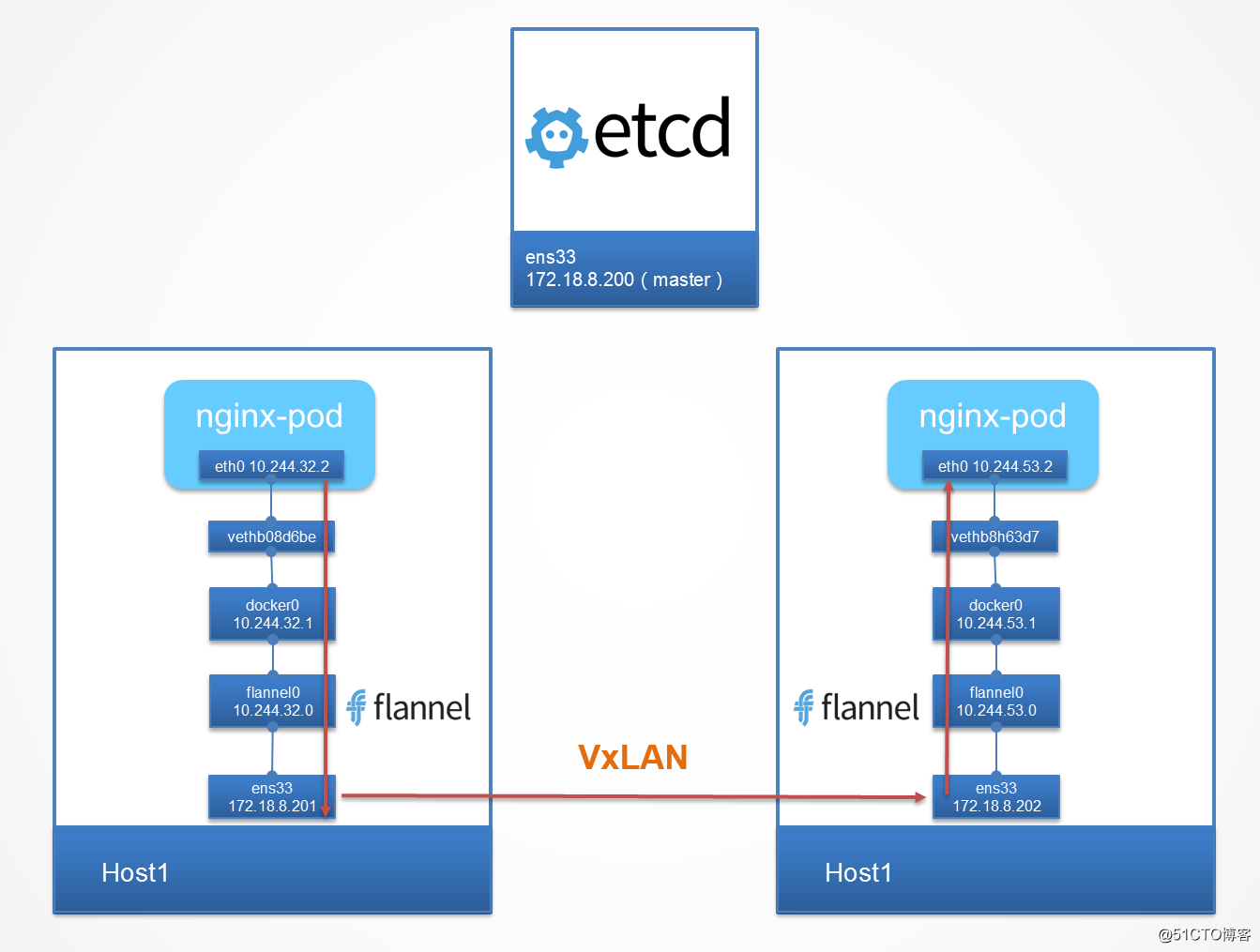

4、配置flannel網路(Pod使用)

我們之所以要單獨使用第三方的網路外掛來擴充套件k8s,主要原因是在使用docker的環境中,在每個node節點的docker0預設的網段都是172.17.0.0/16的網路。如果要實現不同宿主node上pod(這裡也可以理解為容器)互相通訊,就不能使用預設的docker0提供的網段,我們需要部署一個覆蓋網路,讓每個node節點的docker0網路都處於不同的網段,這樣,通過新增一些路由轉發策略,就能讓叢集中各個pod在同一個虛擬的網路中實現通訊。

從github官網下載最新版本。

wget https://github.com/coreos/flannel/releases/download/v0.10.0/flannel-v0.10.0-linux-amd64.tar.gz

tar xf flannel-v0.10.0-linux-amd64.tar.gz

cp flanneld /usr/local/bin/

cp mk-docker-opts.sh /usr/local/libexec/建立啟動檔案/usr/lib/systemd/system/flanneld.service,新增如下內容:

[Unit]

Description=Flanneld overlay address etcd agent

After=network.target

After=network-online.target

Wants=network-online.target

After=etcd.service

Before=docker.service

[Service]

Type=notify

EnvironmentFile=/etc/sysconfig/flanneld

EnvironmentFile=-/etc/sysconfig/docker-network

ExecStart=/usr/local/bin/flanneld \

$FLANNEL_ETCD_ENDPOINTS \

$FLANNEL_ETCD_PREFIX \

$FLANNEL_OPTIONS

ExecStartPost=/usr/local/libexec/mk-docker-opts.sh -d /run/flannel/docker

Restart=on-failure

[Install]

WantedBy=multi-user.target

RequiredBy=docker.service對上面的檔案做一下解釋:

- Flannel網路必須在宿主機網路能對外(其它node節點)正常通訊的情況下啟動才有意義,所以這裡定義

After=network.target - 只有當Flannel 網路啟動之後,才能建立一個與其它節點不會衝突的網路,而docker的網路需要和fannel 網路相同才能保證跨主機通訊,所以docker必須要在flannel網路建立後才能啟動,這裡定義

Before=docker.service

建立配置檔案/etc/sysconfig/flanneld,設定為如下內容:

cat <<EOF > /etc/sysconfig/flanneld

# Flanneld configuration options

# etcd url location. Point this to the server where etcd runs

FLANNEL_ETCD_ENDPOINTS="-etcd-endpoints=http://172.18.8.200:2379"

# etcd config key. This is the configuration key that flannel queries

# For address range assignment

FLANNEL_ETCD_PREFIX="-etcd-prefix=/atomic.io/network"

# Any additional options that you want to pass

FLANNEL_OPTIONS=""

EOF在master節點上為 falnnel 建立分配的網路。

[[email protected] ~]# etcdctl mk /atomic.io/network/config '{"Network": "10.244.0.0/16"}'在各node節點上啟動 flannel。

systemctl daemon-reload

systemctl start flanneld.service

systemctl enable flanneld.service檢查是否啟動好。

ps -ef |grep flanneld也可以使用自助安裝,官方建議的使用方法。

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

5、啟動docker

編輯檔案/usr/lib/systemd/system/docker.service,修改為如下內容,讓docker使用flannel網路。

[Unit]

Description=Docker Application Container Engine

Documentation=https://docs.docker.com

After=network-online.target firewalld.service flannel.service

Wants=network-online.target

Requires=flanneld.service

[Service]

Type=notify

EnvironmentFile=-/run/flannel/docker

ExecStart=/usr/bin/dockerd $DOCKER_OPTS

ExecReload=/bin/kill -s HUP $MAINPID

LimitNOFILE=infinity

LimitNPROC=infinity

LimitCORE=infinity

TimeoutStartSec=0

Delegate=yes

KillMode=process

Restart=on-failure

StartLimitBurst=3

StartLimitInterval=60s

[Install]

WantedBy=multi-user.target我們最後啟動docker服務。

systemctl daemon-reload

systemctl restart docker.service

systemctl enable docker.service我們可以看到docker0已經連線到flannel0,並且新增10.244.71.0/24的路由。

[[email protected] ~]# ip r

default via 172.18.8.1 dev ens33 proto static metric 100

10.244.0.0/16 dev flannel0 proto kernel scope link src 10.244.71.0

10.244.71.0/24 dev docker0 proto kernel scope link src 10.244.71.1

172.18.0.0/16 dev ens33 proto kernel scope link src 172.18.8.201 metric 100 五、master節點驗證

[[email protected] ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

node01.wzlinux.com Ready <none> 5m38s v1.12.2

node02.wzlinux.com Ready <none> 5m34s v1.12.2先執行幾個pod看一下。

kubectl run nginx --image=nginx --replicas=3檢視一下pod狀態,發現容器的狀態為ContainerCreating,使用kubectl describe pod POD_NAME發現在請求k8s.gcr.io/pause:3.1pod映象模板。

因為我們還沒有pod基礎設施映象k8s.gcr.io/pause:3.1,就是所有pod的模板,我們需要從gcr.io下載,但是這個地址我們國內是無法訪問的,我們可以使用間接的方法,在所有的node節點上,我們可以從阿里雲的映象下載,然後再tag成我們需要的映象。

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1 k8s.gcr.io/pause:3.1

docker image rm registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1問題解決之後我們再次檢視。

[[email protected] ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE

nginx-dbddb74b8-gzd6j 1/1 Running 0 2m11s 10.244.50.3 node02.wzlinux.com <none>

nginx-dbddb74b8-hmmll 1/1 Running 0 2m11s 10.244.50.2 node02.wzlinux.com <none>

nginx-dbddb74b8-lpkln 1/1 Running 0 2m11s 10.244.71.2 node01.wzlinux.com <none>當前的網路結構圖如下所示:

我們可以建立一個service,檢視其分配的IP。

[[email protected] ~]# kubectl expose deploy nginx --port=8888 --target-port=80

[[email protected] ~]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 51m

nginx ClusterIP 10.98.190.189 <none> 8888/TCP 7s至此,使用二進位制程式搭建的過程我們已經介紹完了。