小白對Alex net的理解

阿新 • • 發佈:2018-12-22

剛剛入門深度學習,看了很多部落格,還有吳恩達老師的視訊,對深度學習有了一點認識,現在就我自己的收穫,來分享一下對alexnet的理解,如果有不正確的理解,希望廣大網友可以幫忙指出,一起衝鴨,,,

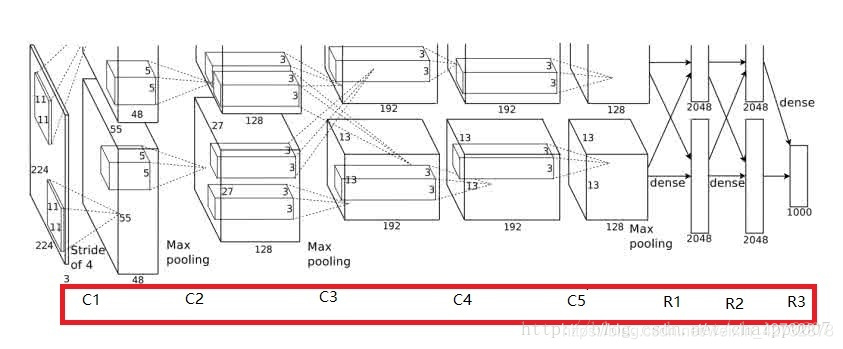

alexnet的結構

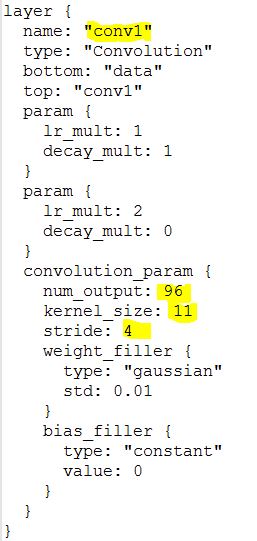

conv1

55* 55 *96

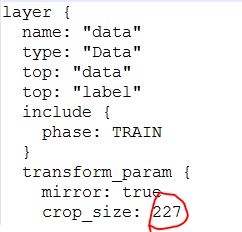

第一層輸入的影象是227* 227 * 3(實際上是224 * 224 * 3,經過填充之後變為227 * 227 * 3,3是通道數channel),使用了96個11 * 11的卷積核,stride即步長為4,卷積之後就會產生一個新的畫素,大小為:(227-11)/4+1=55,加上conv1有96個卷積核,所以卷積結果就為555596,因為是執行在兩個gpu上,所以分為兩組資料,55 * 55 * 48

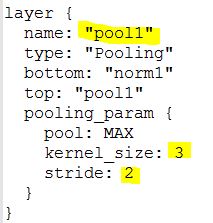

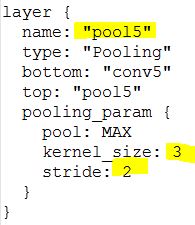

然後經過一個池化層pooling(也稱降採化處理):卷積核3,步長2,池化後的影象尺寸為:(55-3)/2+1=27,27 * 27 * 96。

最後一步:區域性響應歸一化LRN,但是我不太理解,

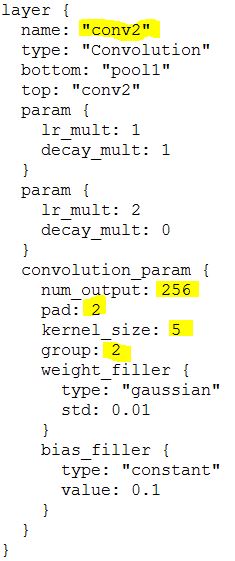

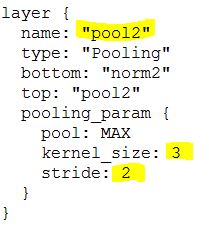

conv2

13* 13 *256

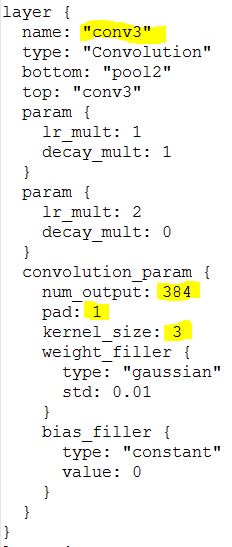

conv3

13* 13 *384

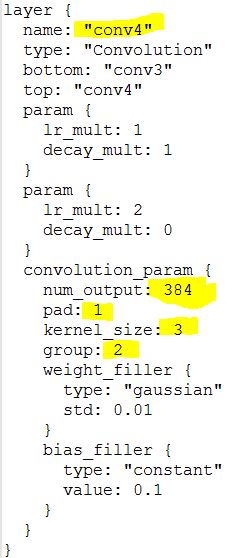

conv4

13* 13 *384

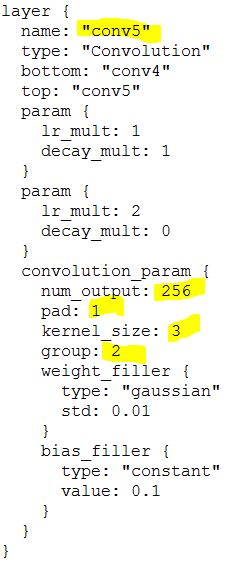

conv5

6* 6 *256

fc6

全連線層,使用4096個神經元,對256個6*6的特徵圖進行全連線,也就是將6 * 6大小的特徵圖進行卷積變成一個特徵點,然後進行加權平均,再進行dropout,隨即從4096丟掉一些節點資訊(值清0)

fc7

過程與fc6類似

fc8

至今不太理解

附上一張立體圖,很直觀

附上一張立體圖,很直觀