GPU狀態監測 nvidia-smi 命令詳解

阿新 • • 發佈:2018-12-24

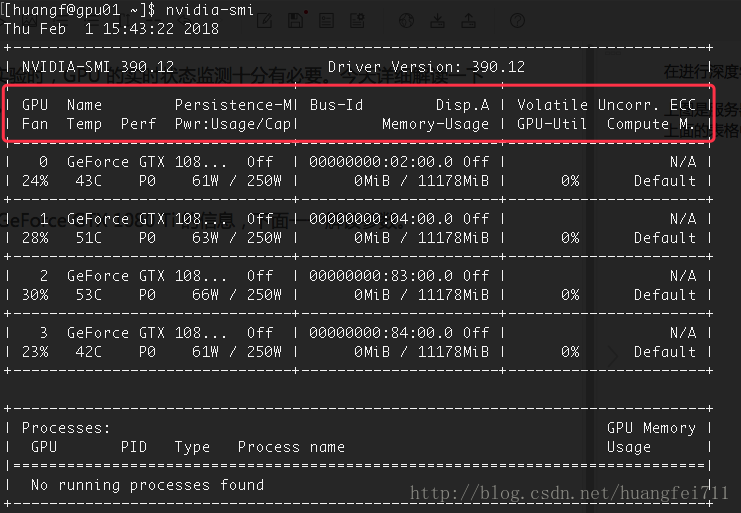

在進行深度學習實驗時,GPU 的實時狀態監測十分有必要。今天詳細解讀一下 nvidia-smi 命令。

上圖是伺服器上 GeForce GTX 1080 Ti 的資訊,下面一一解讀引數。

上面的表格中的紅框中的資訊與下面的四個框的資訊是一一對應的:

GPU:GPU 編號;

Name:GPU 型號;

Persistence-M:持續模式的狀態。持續模式雖然耗能大,但是在新的GPU應用啟動時,花費的時間更少,這裡顯示的是off的狀態;

Fan:風扇轉速,從0到100%之間變動;

Temp:溫度,單位是攝氏度;

Perf:效能狀態,從P0到P12,P0表示最大效能,P12表示狀態最小效能(即 GPU 未工作時為P0,達到最大工作限度時為P12)。

Pwr:Usage/Cap:能耗;

Memory Usage:視訊記憶體使用率;

Bus-Id:涉及GPU匯流排的東西,domain:bus:device.function;

Disp.A:Display Active,表示GPU的顯示是否初始化;

Volatile GPU-Util:浮動的GPU利用率;

Uncorr. ECC:Error Correcting Code,錯誤檢查與糾正;

Compute M:compute mode,計算模式。

下方的 Processes 表示每個程序對 GPU 的視訊記憶體使用率。

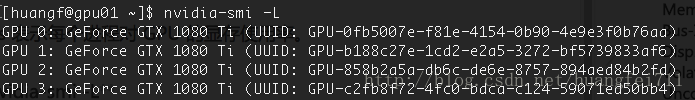

第二個命令:nvidia-smi -L

該命令用於列出所有可用的 NVIDIA 裝置資訊。