【Yaser S. Abu-Mostafa課件】從資料中學習——三個學習原則

本課件主要內容包括:

-

重複的主題:簡單假設

-

“奧卡姆剃刀”原則

-

第一個問題:“簡單”意味著什麼?

-

第二個問題:為什麼越簡單越好?

-

偏差

-

分佈函式匹配

-

重用資料集

-

兩種補救方法

完整課件下載地址:

http://page5.dfpan.com/fs/flcjd22102913639822/

更多精彩文章請關注微訊號:

相關推薦

【Yaser S. Abu-Mostafa課件】從資料中學習——三個學習原則

本課件主要內容包括: 重複的主題:簡單假設 “奧卡姆剃刀”原則 第一個問題:“簡單”意味著什麼? 第二個問題:為什麼越簡單越好? 偏差 分佈函式匹配 重用資料集 兩種補救方法 完整課件

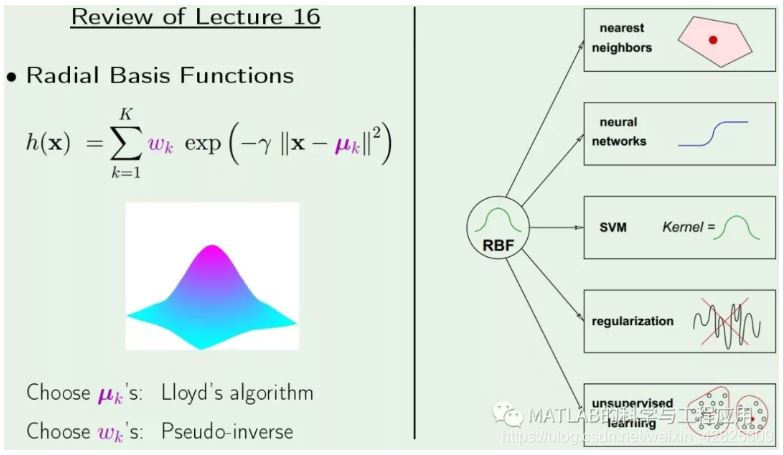

【Yaser S. Abu-Mostafa課件】從資料中學習——徑向基函式

本課件主要內容包括: 基本RBF模型 學習演算法 用於分類的RBF 與最近鄰方法的關係 K箇中心的RBF 中心選擇的問題 迭代演算法 Lloyd演算法 中心與支援向量 RBF網路

【Yaser S. Abu-Mostafa課件】從資料中學習——核方法

本課件主要包括: 廣義內積 處理技巧 多項式核 SVM的核公式 設計自己的核函式 兩種不可分型別的例子 誤差測量 拉格朗日乘子 支援向量的型別 完整課件下載地址: htt

【演算法-分治】從陣列中取出n個元素的所有組合(需要深入理解遞迴)

本文為轉載,原文章出處http://www.cnblogs.com/shuaiwhu/archive/2012/04/27/2473788.html 如陣列為{1, 2, 3, 4, 5, 6},那麼從它中取出3個元素的組合有哪些,取出4個元素的組合呢? 比如取3個元素

【Mark Schmidt課件】機器學習與資料探勘——特徵選擇

本課件的主要內容如下: 上次課程回顧:尋找“真實”模型 資訊準則 貝葉斯資訊準則 關於食物過敏 特徵選擇 全基因組關聯分析 “迴歸權重”方法 搜尋評分法 評分函式的選擇 “特徵數量”懲罰

【Mark Schmidt課件】機器學習與資料探勘——非線性迴歸

本課件主要內容包括: 魯棒迴歸 體育運動中的非線性級數 自適應計數/距離法 線性模型的侷限性 非線性特徵變換 一般多項式特徵(d = 1) 英文原文課件下載地址: http://page5.dfpan

【Mark Schmidt課件】機器學習與資料探勘——數值優化與梯度下降

本課件主要包括以下內容: 優化簡介 上次課程回顧:線性迴歸 大規模最小二乘 尋找區域性最小值的梯度下降法 二維梯度下降 存在奇異點的最小二乘 魯棒迴歸 基於L1-範數的迴歸 L1-範數的平滑近似

【Mark Schmidt課件】機器學習與資料探勘——正規方程組

本課件的主要內容包括: d維資料的梯度和臨界點 最小二乘偏導數 矩陣代數回顧 線性最小二乘 線性和二次梯度 正規方程組 最小二乘問題的不正確解 最小二乘解的非唯一性 凸函式 如何判斷函式的

【Mark Schmidt課件】機器學習與資料探勘——普通最小二乘

本課件主要內容包括: 有監督學習:迴歸 示例:依賴與解釋變數 數字標籤的處理 一維線性迴歸 最小二乘目標 微分函式最小化 最小二乘解 二維最小二乘 d維最小二乘 偏微分

【Mark Schmidt課件】機器學習與資料探勘——進一步討論線性分類器

本課件主要內容包括: 上次課程回顧:基於迴歸的分類方法 Hinge損失 Logistic損失 Logistic迴歸與SVMs “黑盒”分類器比較 最大餘量分類器 支援向量機 魯棒性與凸近似 非凸0-

【Mark Schmidt課件】機器學習與資料探勘——線性分類器

本課件主要內容包括: 上次課程回顧:L1正則化 組合特徵選擇 線性模型與最小二乘 梯度下降與誤差函式 正則化 辨識重要郵件 基於迴歸的二元分類? 一維判決邊界 二維判決邊界 感知器演算法

【Mark Schmidt課件】機器學習與資料探勘——多元分類

本課件主要內容: 上次課程回顧:隨機梯度 無限資料的隨機梯度 詞性標註POS POS特徵 多元線性分類 題外話:多標籤分類 多元SVMs 多元Logistic迴歸 題外話:Frobenius範數

【Mark Schmidt課件】機器學習與資料探勘——MLE與MAP

本課件的主要內容包括: 上次課程回顧:多元線性分類器 決策邊界形狀 識別重要電子郵件 Sigmoid函式 最大似然估計MLE 最小化負對數似然NLL 樸素貝葉斯的MLE 有監督學習的MLE Logi

【Mark Schmidt課件】機器學習與資料探勘——主元分析PCA

本課件主要內容包括: 上次課程回顧:MAP估計 人類 vs. 機器感知 隱因子模型 向量量化 向量量化 vs. PCA 主元分析PCA的應用 PCA目標函式 英文原文課件下載地址: h

【Mark Schmidt課件】機器學習與資料探勘——進一步討論PCA

本課件的主要內容包括: 機器學習工程師需要精通的10種演算法 上次課程回顧:隱因子模型 上次課程回顧:主元分析 上次課程回顧:PCA幾何描述 題外話:資料凝聚 PCA計算:交替最小化 PCA計算:預測 PCA

【Mark Schmidt課件】機器學習與資料探勘——稀疏矩陣分解

本課件主要內容包括: 上次課程回顧:基於正交/序貫基的PCA 人眼的顏色對立 顏色對立表示法 應用:人臉檢測 特徵臉 VQ vs. PCA vs. NMF 面部表示 非負最小二乘法 稀疏性與非負最小

【Mark Schmidt課件】機器學習與資料探勘——推薦系統

本課件主要內容: 上次課程回顧:隱因子模型 魯棒PCA 隱因子模型的變化形式 Netflix獎 協同過濾問題 協同過濾的矩陣分解 基於內容的濾波 vs. 協同濾波 混合方法 SVD特徵的隨機梯度

【Ian Goodfellow課件】梯度下降與神經網路代價函式的結構

本課件主要內容包括: 導數與二階導數 方向曲率 泰勒級數近似 臨界點 牛頓法 牛頓法失效的情況 為何不會收斂? 鞍點或區域性極小值更常見嗎? 為何優化過程如此之慢? 二維子空間視覺化

【Ian Goodfellow課件】深度學習中的正則化

本課件主要內容包括: 正則化定義 權值退化與約束優化 範數懲罰 資料集擴充 多工學習 學習曲線 稀疏表達 Dropout 切線傳播 完整課件下載地址: http:/

【Ian Goodfellow課件】深度前饋網路

本課件主要內容包括: 路線圖 XOR問題不是線性可分的 線性整流的啟用函式 網路示意圖 求解XOR問題 基於梯度的學習 條件分佈與交叉熵 混合密度輸出 隱藏單元 組成結構基礎 泛