用JAVA實現簡單爬蟲多執行緒抓取

阿新 • • 發佈:2018-12-31

在迴圈爬取得基礎上進行多執行緒爬蟲,本程式中使用的三個執行緒,執行緒為實現runnable介面,並使用物件鎖防止併發共同去訪問同一個物件。讓三個執行緒同時爬去同一個url並且得到的新的url不重複。

import java.io.*;

import java.net.*;

public class WebCrawler{

public static void main(String[] args){

runcrawler t1=new runcrawler();

runcrawler t2=new runcrawler();

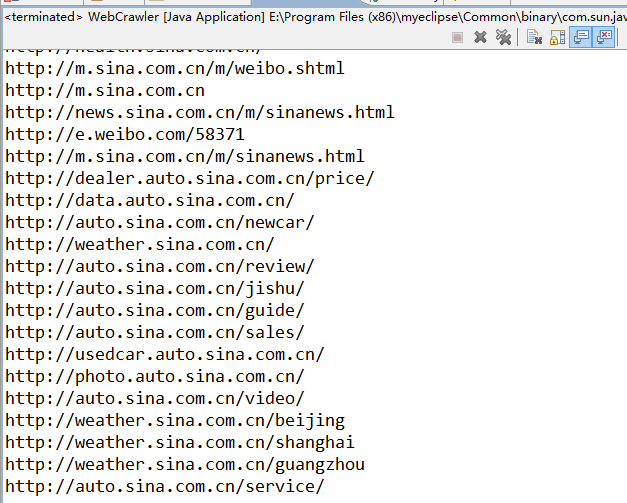

runcrawler t3=new 執行結果:

- 總結:

1.自己剛剛接觸爬蟲,感覺這程式雖然實現了,但是在效率上不是特別高,自己嵌套了三個迴圈以上,這樣在時間和空間上耗費比較多。

2.上一個寫的迴圈爬去的問題還是沒解決。