安裝Hadoop偽分散式踩過的坑

折騰了好幾天的問題,終於解決了。雖然這次遇到的問題沒在網路上找到答案,不過,解決問題的過程或多或少受到了網上一些答案的啟發。下面我將分享自己遇到的問題,並提供解決方法。

(一)、相關資料

http://hadoop.apache.org/docs/r1.0.4/cn/quickstart.html #官網指導

http://hadoop.apache.org/docs/r1.0.4/cn/hdfs_shell.html #shell命令

https://blog.csdn.net/jsutdoit/article/details/82120336 #指導部落格

https://blog.csdn.net/weixin_38070561/article/details/81289601 #使用python中的pyhdfs連線HDFS進行操作

(二)、遇到的問題

1、web端訪問正常,但是檢視檔案和上傳檔案都不行,點選下載檔案預設跳轉到:localhost:50075/XX/XX/ 在瀏覽器位址列將localhost替換成伺服器IP可以正常下載。

在網上查看了很多資料,改hdfs-site.xml,進入/etc/hosts新增主機名。。。無論改成什麼樣的主機名都不行。

想著,既然自動跳轉到localhost,那我就將localhost和伺服器IP繫結。新增一行 XX.XX.XX.XX(XX代指IP) localhost.改完之後儲存,重啟Hadoop。

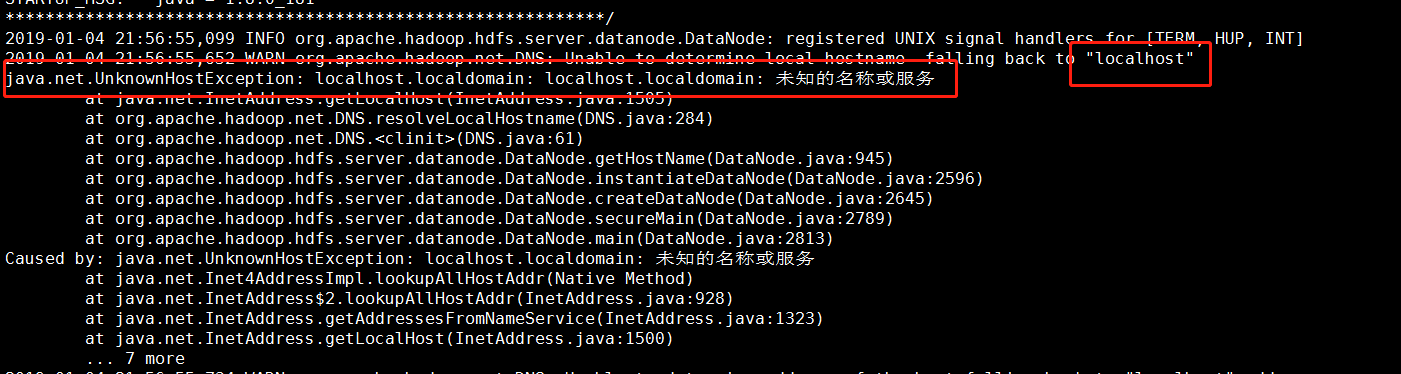

發現web端網頁不能開啟:http:XXX:50070打不開,檢視日誌檔案,發現報錯了。。。

根據日誌檔案可知是剛剛的主機名配置有問題。hadoop是取的這個“localhost.localdomain”,隨即我將localhost換成localhost.localdomain。儲存,重啟Hadoop。

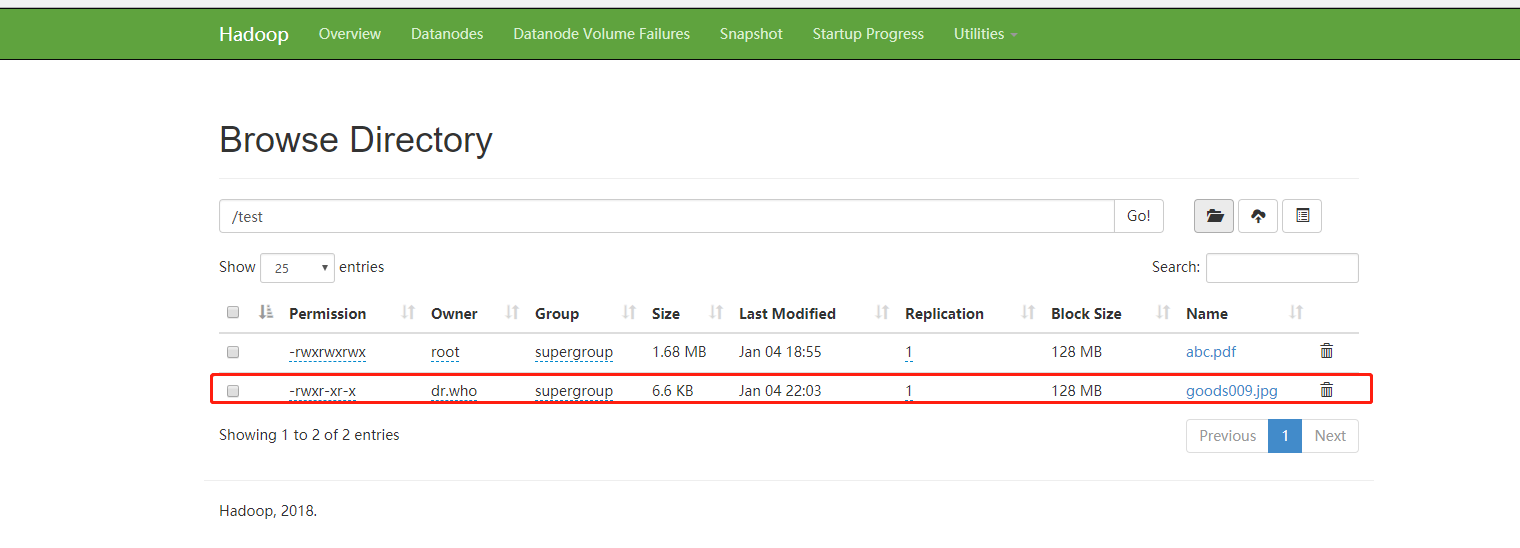

上傳下載都沒問題,大工告成。隨後我用pyhdfs連線,也可以實現上傳下載。啊。。。終於解開了心結。看似很小的一個問題,給我折騰了兩天。唉~