cdh整合kafka,spark2

阿新 • • 發佈:2019-01-09

參考文章:

http://blog.cloudera.com/blog/2016/09/apache-spark-2-0-beta-now-available-for-cdh/

https://www.cloudera.com/documentation/spark2/latest/topics/spark2_installing.html

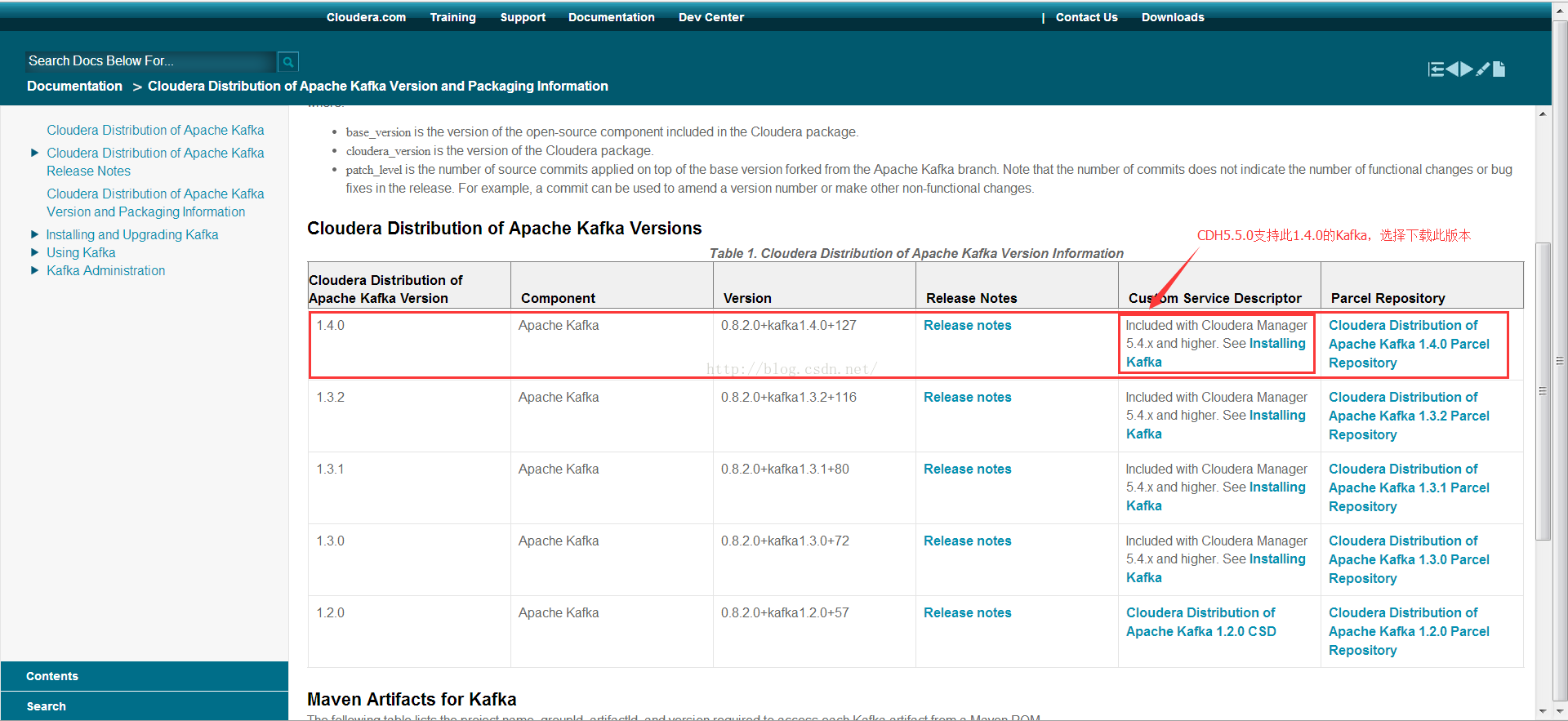

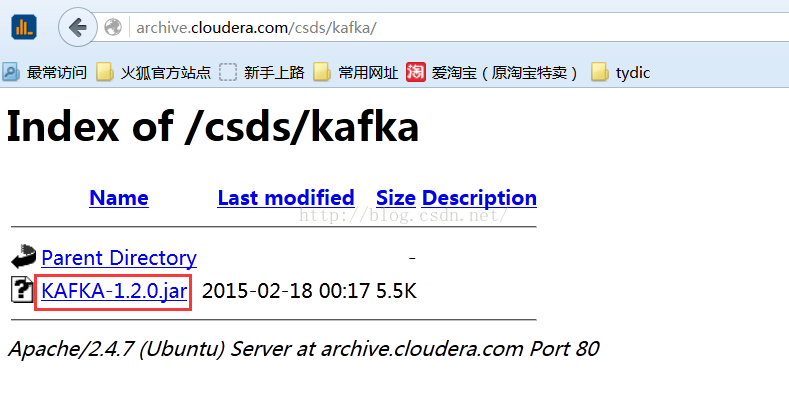

在CDH官網中關於Kafka的安裝和升級中已經說到,在CDH中,Kafka作為一個分散式的parcel,單獨出來作為parcel分發安裝包。只要我們把分離開的kafka的服務描述jar包和服務parcel包下載了,就可以實現完美集成了。

注意整合之前請閱讀官方文件,特別是版本支援方面。

整合過程,直接上圖:

Kafka安裝包準備:

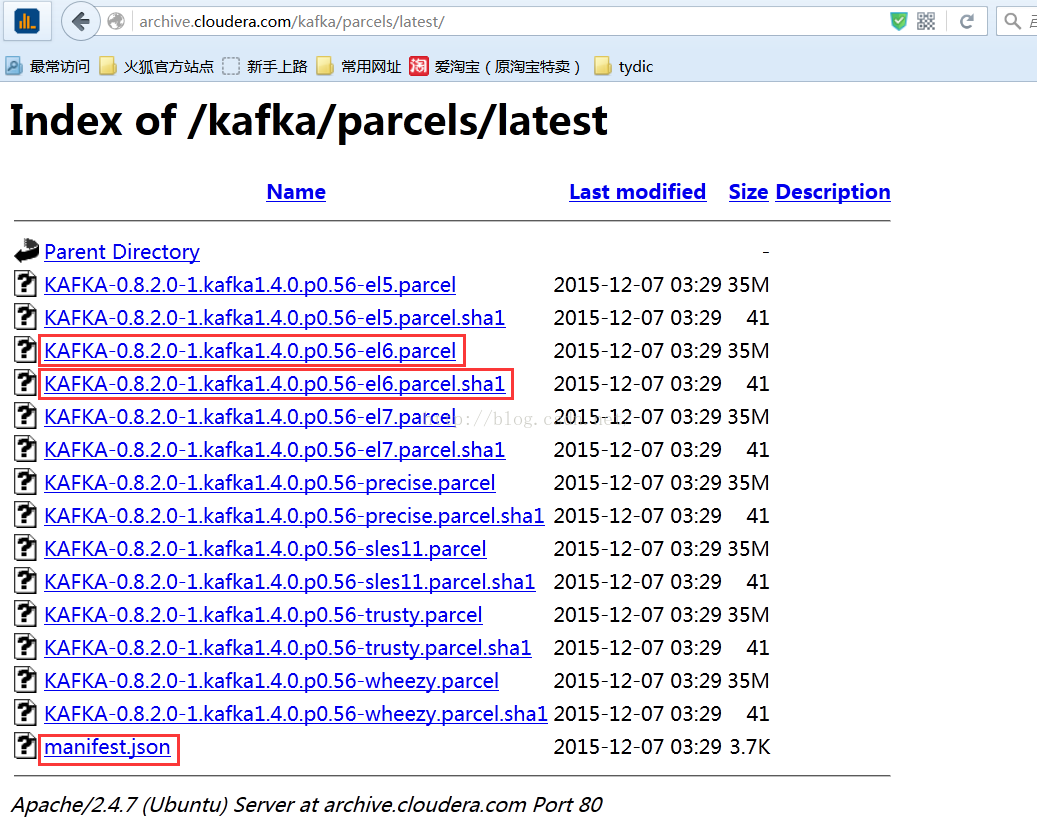

我們這裡centos6.7 x64的系統,注意下載對應的parcel包,如下圖所示

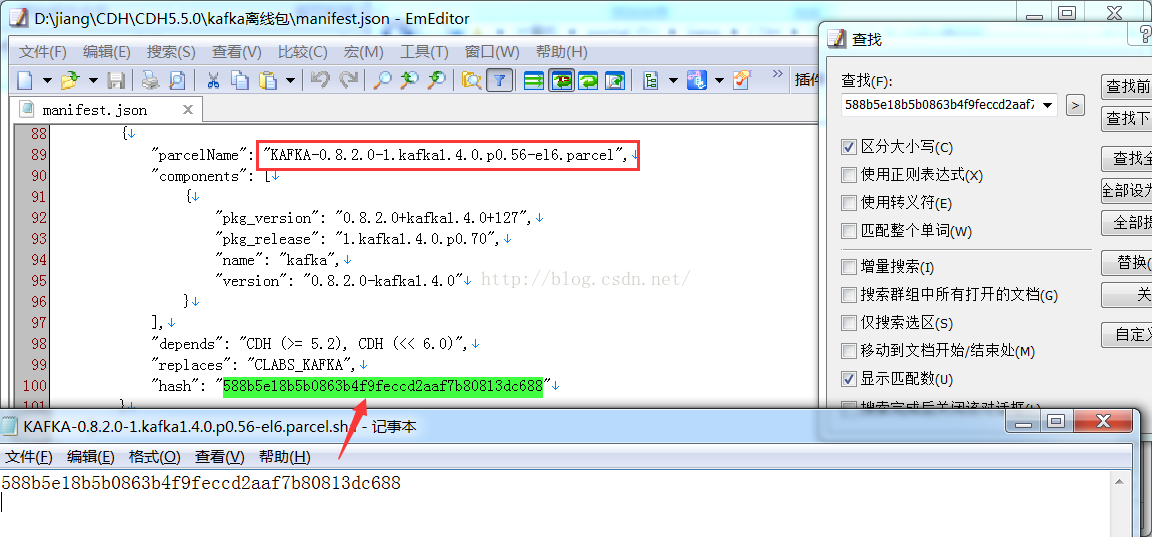

在此得注意hash值的匹配

CDH整合Kafka實現:

1、將原來Kafka的在CDH中刪除

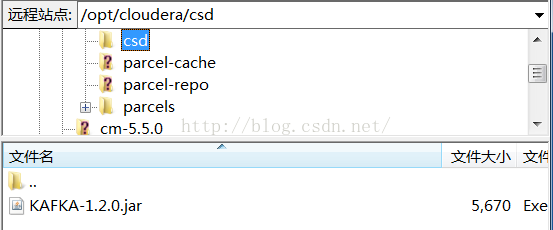

2、csd包放到cm安裝節點下的 /opt/cloudera/csd目錄下,如圖 :

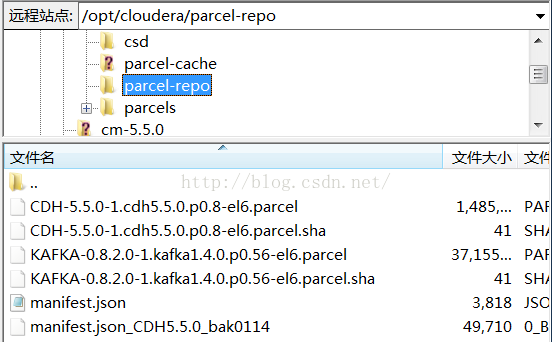

3、將parcel包放到cm安裝節點下的/opt/cloudera/parcel-repo目錄下,如圖:

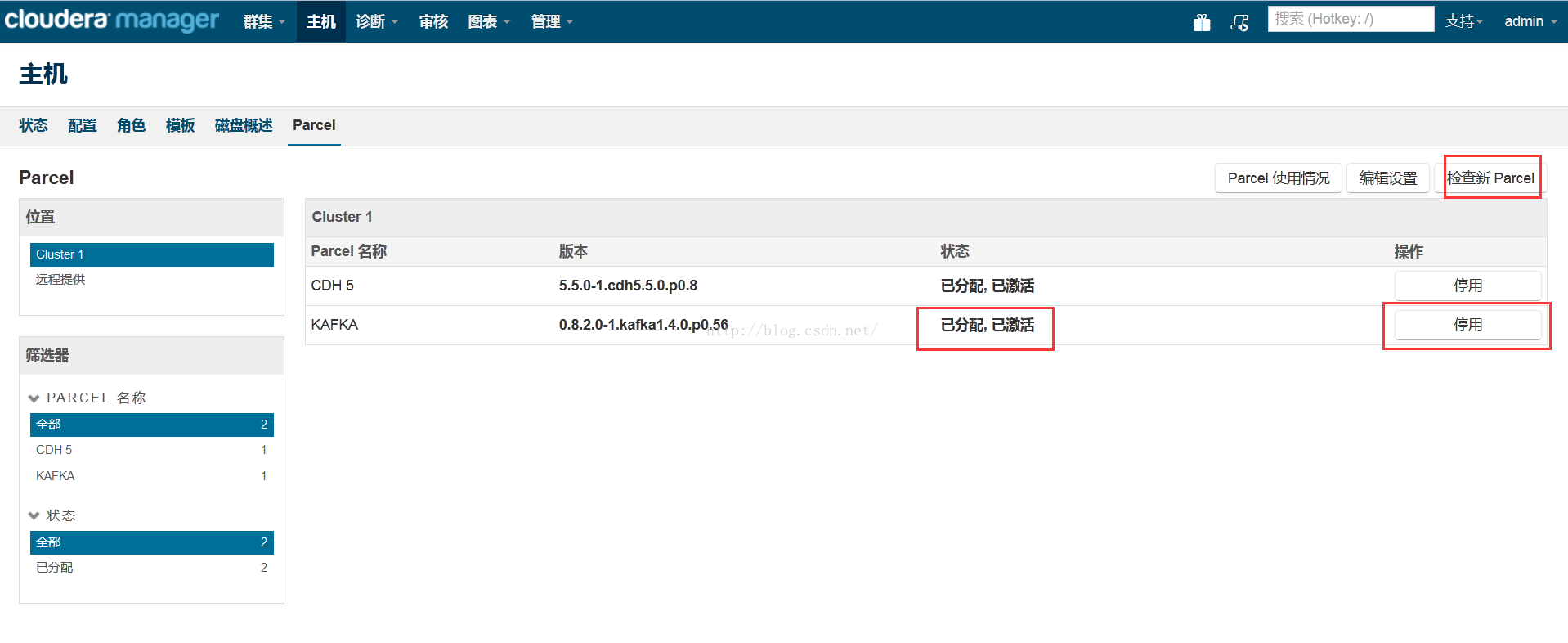

4、啟動cm服務,檢查更新parcel,分配並激活percel包,注意此處一定要啟用才能使用

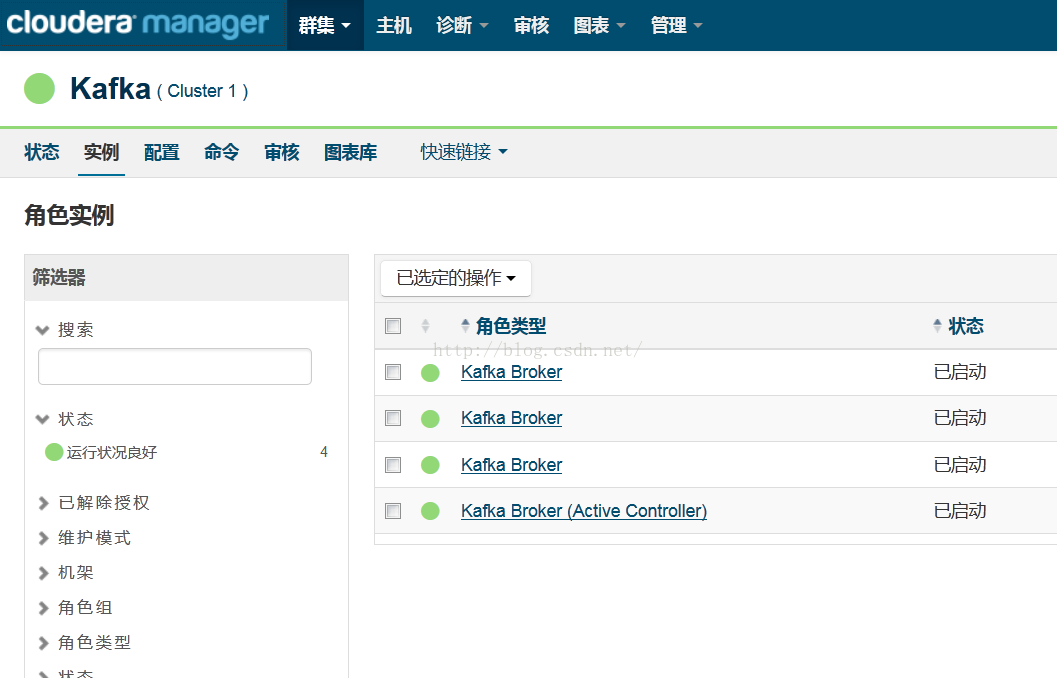

5、新增kafka服務和配置角色節點

6、啟動服務

安裝完成後需要在spark2的配置裡面指定kafka版本。