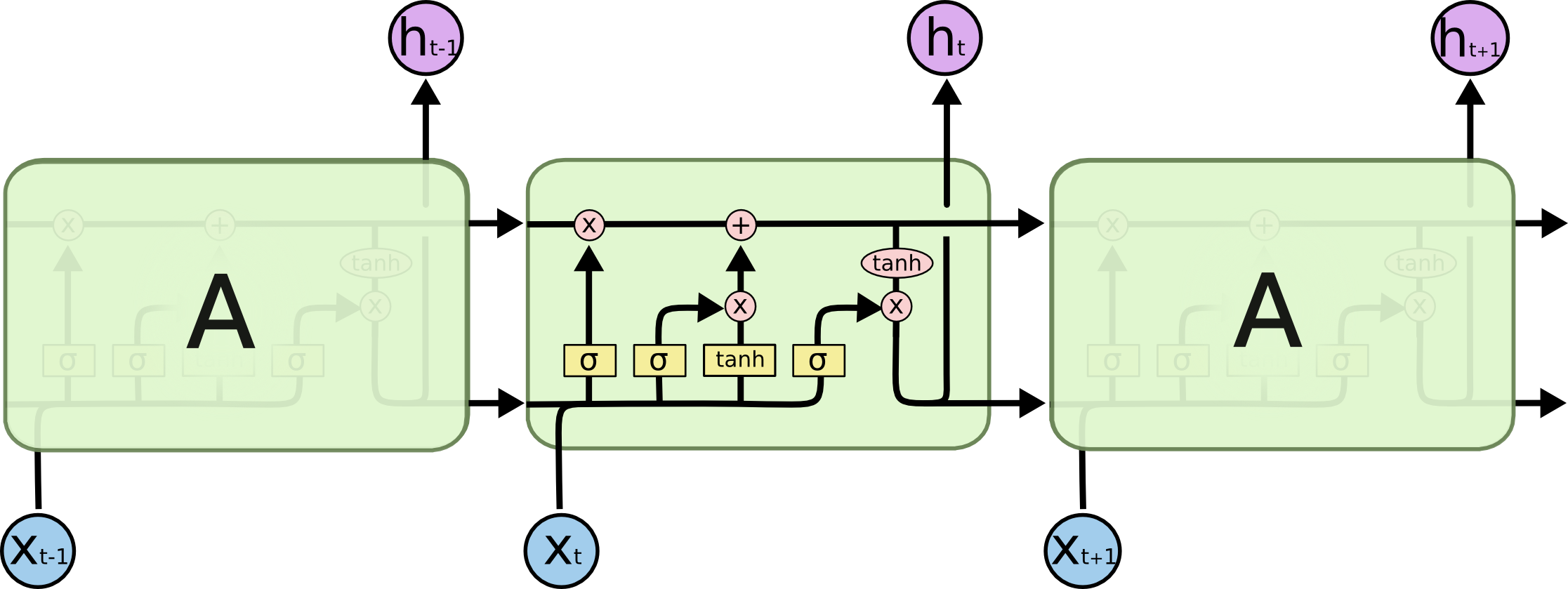

RNN隱藏層的兩種計算方法GRU和LSTM

本篇文章主要介紹兩種RNN的隱藏層資訊計算方法GRU(Gated Recurrent Units)和LSTM(Long-Short-Term-Memories),這兩種隱藏層的計算方法通過引入門(Gate) 的機制來解決RNN的梯度消失問題,從而學習到長距離依賴。

這裡說的隱藏層計算方法指的是如何計算下個時刻的隱藏層資訊,標準RNN中計算 方法是:

而LSTM和GRU可以理解為計算ht的另一種方法。

LSTM

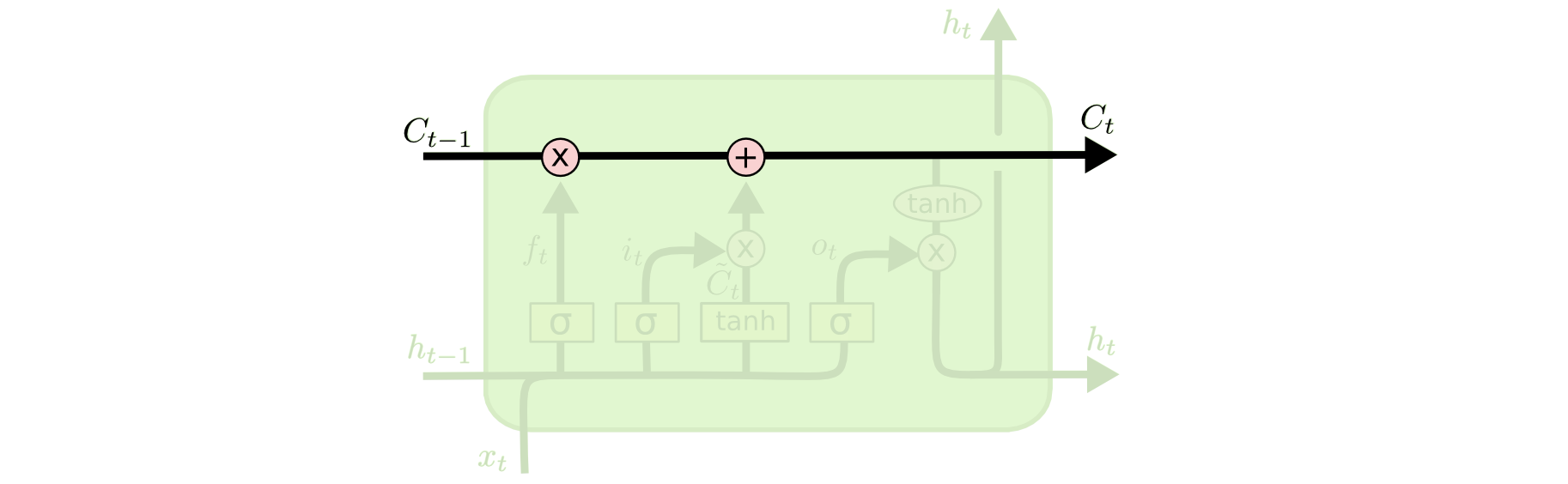

這篇文章詳細 地解釋了LSTM各個門的物理含義, 以及LSTM計算隱藏層的方法,這裡簡要的進行總結, 下圖是LSTM網路的示意圖,圖中各個符號的含義參考原文:

某個時刻LSTM計算隱藏層的方法參考下圖:

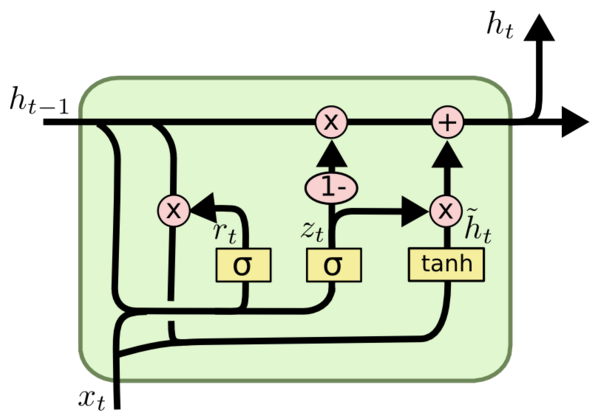

GRU

GRU可以看成是LSTM的變種,GRU把LSTM中的forget gate和input gate用update gate來替代。 把cell state和隱狀態htht進行合併,在計算當前時刻新資訊的方法和LSTM有所不同。 下圖是GRU更新htht的過程:

具體更新過程如下

相關推薦

RNN隱藏層的兩種計算方法GRU和LSTM

本篇文章主要介紹兩種RNN的隱藏層資訊計算方法GRU(Gated Recurrent Units)和LSTM(Long-Short-Term-Memories),這兩種隱藏層的計算方法通過引入門(Gate) 的機制來解決RNN的梯度消失問題,從而學習到長距離依賴。這裡說的隱藏

【C/C++程式碼練習11】1-1/2+1/3-1/4+...+1/n的兩種計算方法

方法一: #include <stdio.h> #include <math.h> int main(void) { int n; scanf("%d",

HR人力資源軟件考勤的兩種計算方法

基本上 exp 識別 分析 工作 都是 申請 延長 成考 說起考勤,最明顯的特點莫過於他靈活的規則。 每家企業基本上都各不相同,所以一直以來考勤的計算在勞動密集型企業都是件繁雜的差事。人力部門到月底往往要面對成千上萬的考勤明細記錄。因此現在企業一般都是采用軟件計算的方法。而

卡特蘭數的兩種計算方法

#include <stdio.h> #include <stdlib.h> #define MAXN 40 long long Catalan[MAXN

組合數的兩種計算方法(遞推,對數)

http://blog.csdn.net/Feynman1999/article/details/56679096 組合數 從m個不同元素中,任取n(n≤m)個元素併成一組,叫做從m個不同元素中取出n個元素的一個組合;所有可能的組合種數就是組合數。組合

pow函式(數學次方)在c語言的用法,兩種編寫方法例項( 計算1/1-1/2+1/3-1/4+1/5 …… + 1/99 - 1/100 的值)

關於c語言裡面pow函式,下面借鑑了某位博主的一篇文章: 標頭檔案:#include <math.h> pow() 函式用來求 x 的 y 次冪(次方),x、y及函式值都是double型 ,其原型為: double pow(double x, double y

文字超出加省略隱藏的兩種方法

第一種方法: .text{ overflow: hidden; text-overflow: ellipsis; //隱藏加省略號 display: -webkit-box; -webkit-box-orient: vertical; -webkit-line-

線程的兩種睡眠方法&ANR(進程/服務無響應)

時間 運行 睡眠 tro 執行 方法 如果 服務 一段 1 method1: try { 2 Thread.sleep(3000); 3 } catch (InterruptedException e) { 4

android縮放動畫的兩種實現方法

get odi omx rac tor Coding eight rpo odin 在android開發。我們會常常使用到縮放動畫,普通情況下縮放動畫有兩種實現方式。一種是直接通過java代碼去實現,第二種是通過配置文件實現動畫,以下是兩種動畫的基本是用法: Ja

mysql遠程連接失敗的兩種解決方法

mysql password upd leg .cn 權限 連接 每次 ddr ---恢復內容開始--- (這是轉載別人的,因為我覺得很有用,每次都是參考這個的第二種方法解決的,不管你聽不聽得到,先說聲謝謝!也記下來方便大家看看) mysql解決遠程不能訪問的二種方法,需要

【漏洞預警】CVE-2017-8464 震網三代漏洞復現(兩種利用方法)

art cal mage http test ip地址 get for oot 早在6月13日,微軟發布補丁修復編號為CVE-2017-8464的漏洞,本地用戶或遠程攻擊者可以利用該漏洞生成特制的快捷方式,並通過可移動設備或者遠程共享的方式導致遠程代碼執行,追溯到以前,NS

PPP的兩種配置方法(pap和chap)

pap chapPAP的配置R1上的配置[R1]int s4/0/0[R1-Serial4/0/0]ppp authentication-mode pap[R1-Serial4/0/0]q[R1]aaa[R1-aaa]local-user huawei password cipher 123456Info:

js實現菲波那切數列的兩種常用方法

res alert 定義 面向 div ret 如果 clas cti 菲波那切數列即:1 1 2 3 5 8......,後面的數字是前面兩個數字的和,並且第一個,第二個數字都是1,用js實現 的兩種方法,一種通過常用的遞歸調用,第二種不通過遞歸,而是通過強大的閉包實現。

BZOJ 2101 [Usaco2010 Dec]Treasure Chest 藏寶箱:區間dp 博弈【兩種表示方法】【壓維】

space print 而且 problem 所有 php 一條直線 題解 bzoj 題目鏈接:http://www.lydsy.com/JudgeOnline/problem.php?id=2101 題意: 共有n枚金幣,第i枚金幣的價值是w[i]。 把金幣排成一

MySQL數據庫root賬戶密碼忘記兩種處理方法(保有效)

mysql mysq 密碼忘記 方法1:1.停止MySQL服務# kill `cat /var/run/mysqld/mysqld.pid`或者# pkill mysqld2.創建一個密碼賦值語句的文本文件# vi mysql-init ALTER USER ‘root‘@‘localhost‘

Struts2中validate數據校驗的兩種常用方法

red 有一種 資源文件 業務 相同 dna erp wrong 顯示 本文主要介紹Struts2中validate數據校驗的兩種方法及Struts2常用校驗器. 1.Action中的validate()方法 Struts2提供了一個Validateable接口,這個接口

虛方法與兩種重寫方法的比較

直接 方法調用 可訪問性 err 方法 圖解 span 類型 ase 虛方法virtual..override: 1.派生類的方法和基類的方法有相同的簽名和返回類型。 2.基類的方法使用virtual標註。 3.派生類的方法使用override標註。 class MyBa

a超鏈接之返回頂部的兩種實現方法

html name remove 分享圖片 pla 位置 rem src position 1.通過css實現: 為頁面頂部如body或者自己設置的盒子等加上唯一id屬性 <body id="id"> .... <a href="#id">返回頂部

VLOOKUP函數返回錯誤值#N/A的兩種解決方法

ask 可能 html 截圖 沒有 class b- http 工資 來源:http://www.ittribalwo.com/article/3626.html 下面的截圖,根據左邊的工號查詢相應的工資。小夥伴的F2單元格公式是:=VLOOKUP(E2,$A$1:$C

Linux遺忘root密碼的其中兩種解決方法

.com sha 一個 需要 shadow ada 操作系統 分享 http 由於安全的需要,系統一般只有一個root用戶,因此若遺忘root用戶的登錄密碼,因此需要通過其他途徑進行修改密碼。1.通過單用戶模式(1)重啟系統,按任意鍵進入grub菜單。出現grub菜單時,按