深度學習筆記——why “deep”?

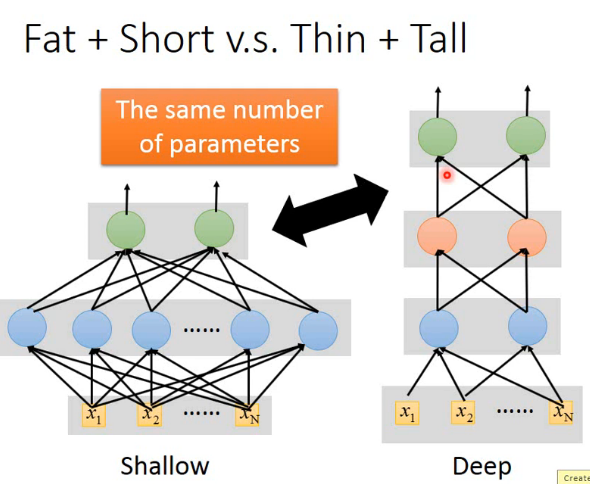

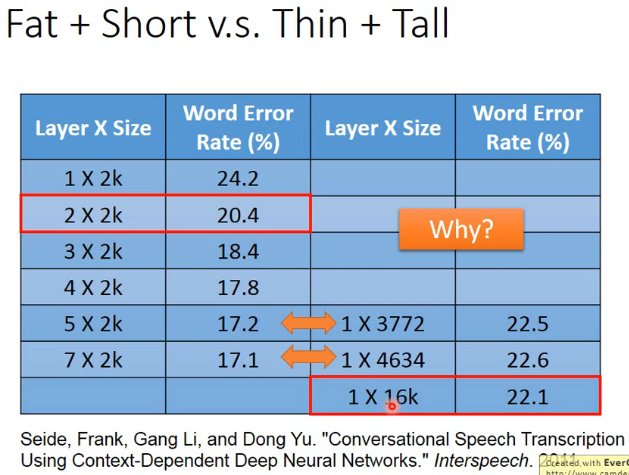

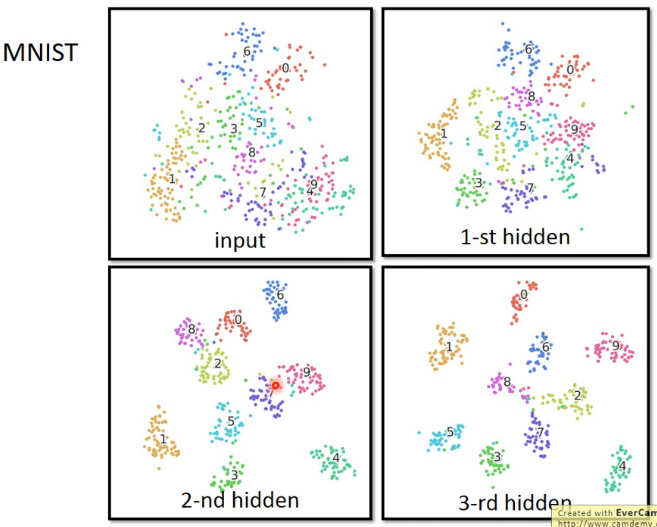

1、多層的學習效果往往比單層要好,即便引數的個數一樣

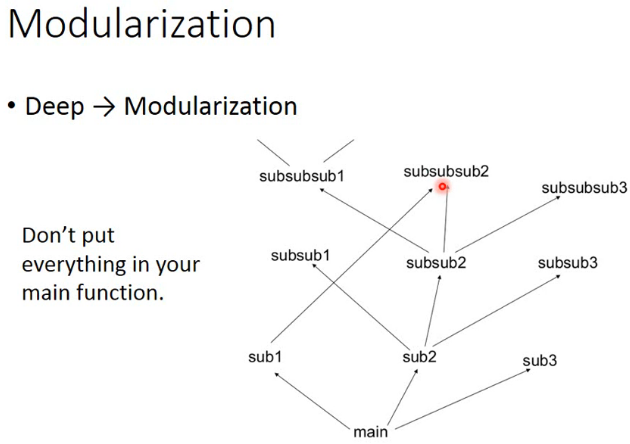

2、在用C語言進行結構化程式設計時,我們從來不會把大量的功能寫到一個函式裡面,而是寫很多函式同過函式呼叫實現目標。神經網路也類似,一個層可以看做一個函式實現了一個功能,多層結構更清晰,功能也更強大。

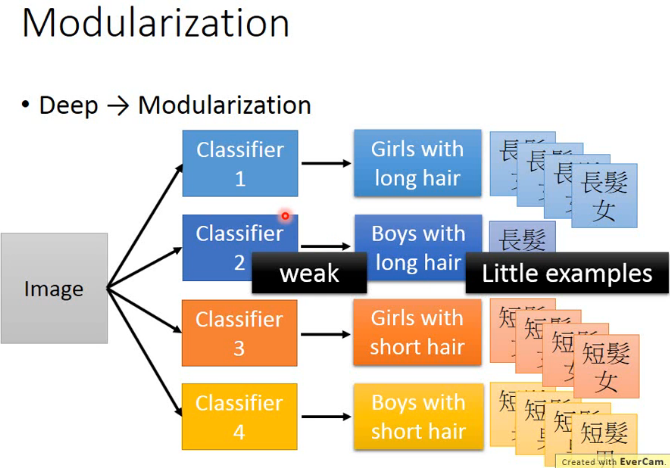

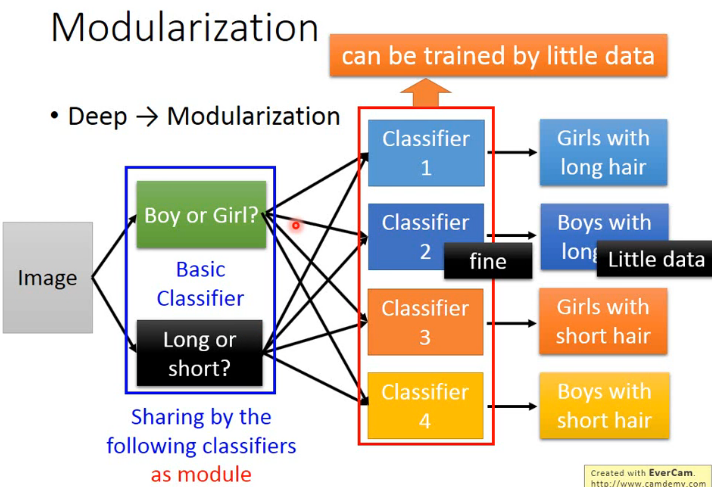

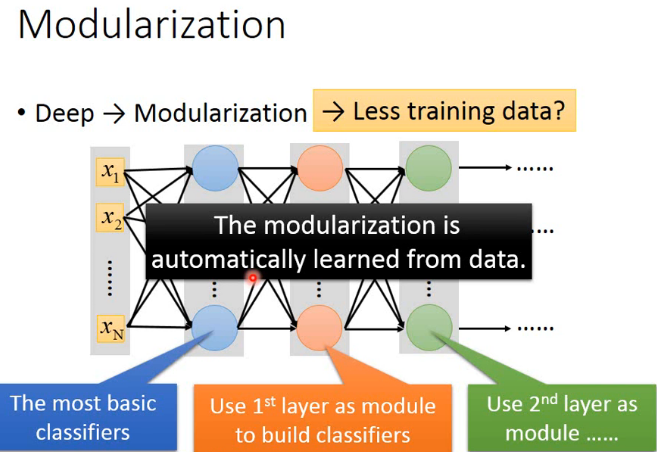

3、如下圖所示,如果只有一層的話就很難識別長頭髮男生,因為其樣本太少

增加一層實現識別性別的功能,在此基礎上進一步區分長髮和短髮,效果就好一些

因此,深層網路相比淺層網路需要更少的訓練資料(這一點與通常的大眾認知不同)。

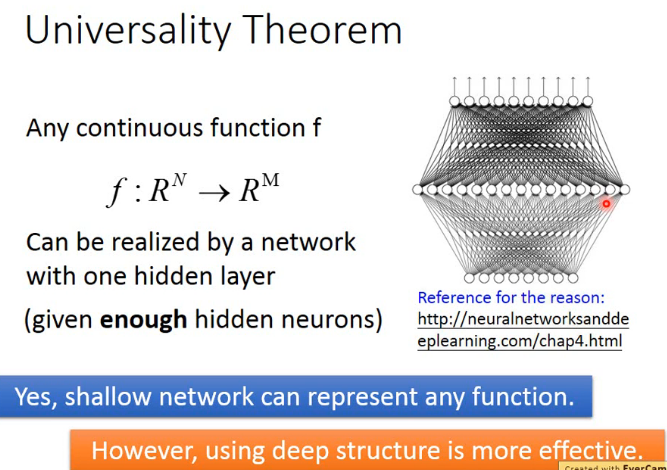

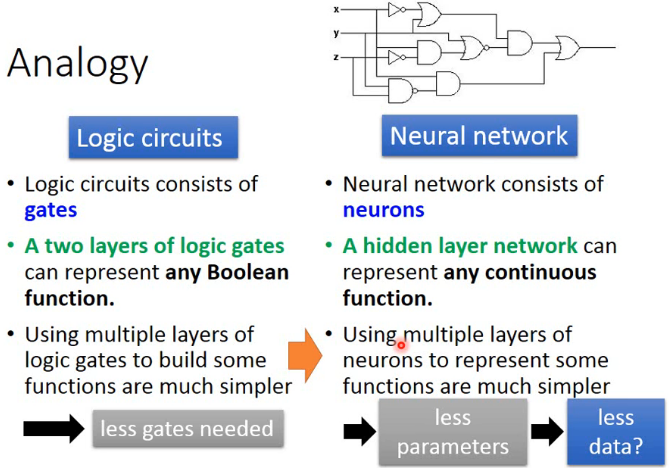

4、雖然一個只有一層隱含層的神經網路就可以模擬出任何連續函式,但事實上很少有人用這種簡單的網咯。因為,深度網咯更高效、更強大。

這一點類似於邏輯電路。一個兩層的邏輯電路可以實現任何布林函式,但是現實中的邏輯電路有很多層

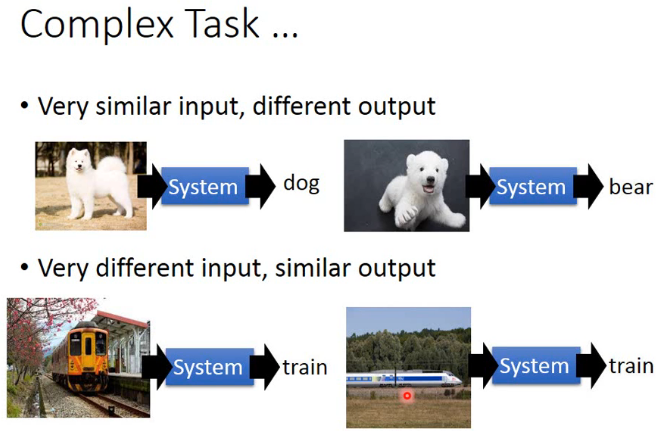

5、深度網咯可以完成更復雜的任務。比如:

再比如:

還有:

相關推薦

深度學習筆記——why “deep”?

1、多層的學習效果往往比單層要好,即便引數的個數一樣 2、在用C語言進行結構化程式設計時,我們從來不會把大量的功能寫到一個函式裡面,而是寫很多函式同過函式呼叫實現目標。神經網路也類似,一個層可以看做一個函式實現了一個功能,多層結構更清晰,功能也更強大。 3、如下圖所示

《深度學習》/《Deep Learning》——深度學習聖經的讀書筆記

學習方法 對著書看一遍,把理解的內容寫成筆記 看完一章後,看著筆記和書,把內容複習一下,把需要畫線的地方畫好並理解 逐層深入:這本書講解基礎概念講得不生動,但是高層次上有很多不錯的高瞻遠矚的見解,所以先看網文理解到基本的網路(如RNN-LSTM),然後看書深

Coursera deeplearning.ai 深度學習筆記1-4-Deep Neural Networks-深度神經網路原理推導與程式碼實現

在掌握了淺層神經網路演算法後,對深度神經網路進行學習。 1. 原理推導 1.1 深度神經網路表示 定義:L表示神經網路總層數,上標[l]代表第l層網路,n[l]代表第l層的節點數,a[l]

深度學習筆記(九)感受野計算

lds 時有 輸入 計算 ret name %d have imsi 1 感受野的概念 在卷積神經網絡中,感受野的定義是 卷積神經網絡每一層輸出的特征圖(feature map)上的像素點在原始圖像上映射的區域大小。一般感受野大小是目標大小的兩倍左右最合適!

最實用的深度學習教程 Practical Deep Learning For Coders (Kaggle 冠軍 Jeremy Howard 親授)

ted del src learning over attention wid multi 美國 Jeremy Howard 在業界可謂大名鼎鼎。他是大數據競賽平臺 Kaggle 的前主席和首席科學家。他本人還是 Kaggle 的冠軍選手。他是美國奇點大學(Singular

神經網絡和深度學習 筆記

ack 參數 一個 bsp 感知機 信號 叠代 前饋型神經網絡 pro 人工神經網絡(ann) 模擬的是 生物神經網絡(bnn) ann 一般也叫 前饋型神經網絡 : 各神經元只接受前一級輸入,並輸出到下一級,無反饋 應該也有反饋型神經網絡?? ann一般使用b

深度學習筆記

支持向量機 target 支持向量 支持 深度 區間 net cto www. 邏輯回歸(logistic sinmoid):將線性函數的輸出壓縮進區間(0,1)。 邏輯回歸 機器學習算法與Python實踐之(七)邏輯回歸(Logistic Regression) Co

吳恩達深度學習筆記(deeplearning.ai)之循環神經網絡(RNN)(一)

不同的 圖片 存在 最終 一個 har end markdown 輸入 1. RNN 首先思考這樣一個問題:在處理序列學習問題時,為什麽不使用標準的神經網絡(建立多個隱藏層得到最終的輸出)解決,而是提出了RNN這一新概念? 標準神經網絡如下圖所示: 標準神經網絡在解決序列

吳恩達深度學習筆記(deeplearning.ai)之循環神經網絡(RNN)(二)

blog 如何 這一 累加 soft 學習 測試 接下來 數據 導讀 本節內容介紹如何使用RNN訓練語言模型,並生成新的文本序列。 語言模型(Language model) 通過語言模型,我們可以計算某個特定句子出現的概率是多少,或者說該句子屬於真實句子的概率是多少。正式點

吳恩達深度學習筆記(deeplearning.ai)之循環神經網絡(RNN)(三)

崩潰 body 很難 mark 因此 梯度 處理方法 弊端 原理 1. 導讀 本節內容介紹普通RNN的弊端,從而引入各種變體RNN,主要講述GRU與LSTM的工作原理。 2. 普通RNN的弊端 在NLP中,句子內部以及句子之間可能存在很長的依賴關系(long-term d

深度學習筆記(03)- 啟動器

可能 啟動 ima 應用 無法 導航 程序 png 啟動器 ??啟動器,你一定不要錯過,因為你也無法錯過。對於一個小白來說,啟動器即陌生又熟悉,因為windows叫開始菜單。當你聽到開始菜單,基本上這一節不用學習了,如果你接觸過電腦一定不會陌生。不過老陌還是要整理一下筆記,

Andrew Ng 深度學習筆記-01-week3-課程

weight leak andrew ng random 有一個 function 分享圖片 範圍 hid 一、專業詞匯 a hidden layer of the neural network 神經網絡的隱藏層 a single hidden layer

吳恩達深度學習筆記 course2 week3 超參數調試,Batch Norm,和程序框架

etc 值範圍 操作 normal 可能 標準 通過 pan 範圍 1.Tuning Process 對超參數的一個調試處理 一般而言,在調試超參數的過程中,我們通常將學習率learning_rate看作是最重要的一個超參數,其次是動量梯度下降因子β(一般為0.9),

吳恩達深度學習筆記(七) —— Batch Normalization

學習 bat 中括號 和平 一個 內容 batch 可能 加權 主要內容: 一.Batch Norm簡介 二.歸一化網絡的激活函數 三.Batch Norm擬合進神經網絡 四.測試時的Batch Norm 一.Batch Norm簡介 1.在機器學習中,我們一般

吳恩達深度學習筆記(八) —— ResNets殘差網絡

con 一個 學習 ets str 帶來 圖片 梯度 就是 (好累……,明日在寫……) 主要內容: 一.殘差網絡簡介 二.identity block 和 convolutional block 一.殘差網絡簡介 1.深度神經網絡很大的一個優點就是能夠表示一個

深度學習筆記2(手寫字型)

1、下載手寫字型 網址【1】 2、下載程式碼 網址【2】 3、執行程式碼 直接執行就可以了 參考網址: 【1】MNIST資料集官方網址為:http://yann.lecun.com/exdb/mnist/&nbs

【深度學習筆記1】如何建立和確定模型正確性?如何優化模型?

近期看了吳恩達的一本書,關於如何建立和確定優化模型?裡面有個人認為需要學習的地方,故做筆記: 1.模型訓練一共有三個資料集:訓練集、開發集(驗證集)、測試集。開發集不能太小,通常在1000-10000,並且測試集屬於同一分佈;2.過擬合:訓練過程中開發集的準確率和測試集測試的準確率差別不大,若開發集比測試集

深度學習筆記——線性單元和梯度下降

程式碼參考了零基礎入門深度學習(2) - 線性單元和梯度下降這篇文章,我只對程式碼裡可能存在的一些小錯誤進行了更改。至於線性單元的原理以及程式碼裡不清楚的地方可以結合該文章理解,十分淺顯易懂。 from DL.perceptron import Perceptron # 定義啟用函式f f =

深度學習筆記——感知機

程式碼參考了零基礎入門深度學習(1) - 感知器這篇文章,我只對程式碼裡可能存在的一些小錯誤進行了更改。至於感知機的原理以及程式碼裡不清楚的地方可以結合該文章理解。 from functools import reduce class Perceptron: def __init_

深度學習筆記——卷積神經網路

程式碼參考了零基礎入門深度學習(4) - 卷積神經網路這篇文章,我只對程式碼裡可能存在的一些小錯誤進行了更改。至於卷積神經網路的原理以及程式碼裡不清楚的地方可以結合該文章理解,十分淺顯易懂。 import numpy as np from functools import reduce fro