帶你認識spark安裝包的目錄結構

其實啊,將spark的壓縮包解壓好,就已經是spark的最簡易安裝了。

其實啊,想說的是,只要將spark這壓縮包解壓好,就已經是spark的最簡易安裝了。

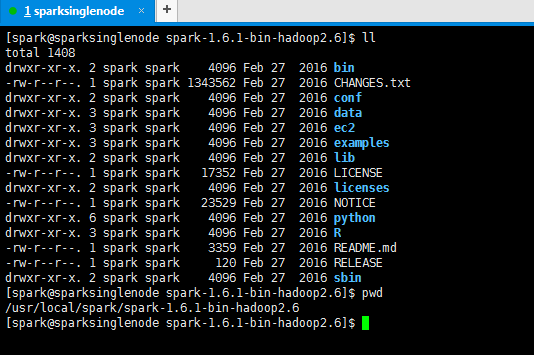

[[email protected] spark-1.6.1-bin-hadoop2.6]$ ll total 1408 drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 bin (可執行) -rw-r--r--. 1 spark spark 1343562 Feb 27 2016 CHANGES.txt drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 conf (配置檔案) drwxr-xr-x. 3 spark spark 4096 Feb 27 2016 data (例子裡用到的一些資料) drwxr-xr-x. 3 spark spark 4096 Feb 27 2016 ec2 drwxr-xr-x. 3 spark spark 4096 Feb 27 2016 examples (自帶的例子一些原始碼) drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 lib (jar包) -rw-r--r--. 1 spark spark 17352 Feb 27 2016 LICENSE drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 licenses -rw-r--r--. 1 spark spark 23529 Feb 27 2016 NOTICE drwxr-xr-x. 6 spark spark 4096 Feb 27 2016 python drwxr-xr-x. 3 spark spark 4096 Feb 27 2016 R -rw-r--r--. 1 spark spark 3359 Feb 27 2016 README.md (包含一些入門的spark說明) -rw-r--r--. 1 spark spark 120 Feb 27 2016 RELEASE drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 sbin (叢集啟停,因為spark有自帶的叢集環境) [[email protected] spark-1.6.1-bin-hadoop2.6]$ pwd /usr/local/spark/spark-1.6.1-bin-hadoop2.6 [[email protected] spark-1.6.1-bin-hadoop2.6]$

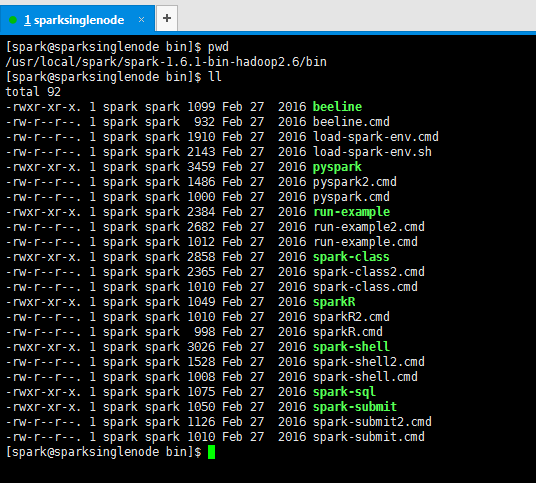

[[email protected] bin]$ pwd /usr/local/spark/spark-1.6.1-bin-hadoop2.6/bin [[email protected] bin]$ ll total 92 -rwxr-xr-x. 1 spark spark 1099 Feb 27 2016 beeline-rw-r--r--. 1 spark spark 932 Feb 27 2016 beeline.cmd -rw-r--r--. 1 spark spark 1910 Feb 27 2016 load-spark-env.cmd -rw-r--r--. 1 spark spark 2143 Feb 27 2016 load-spark-env.sh -rwxr-xr-x. 1 spark spark 3459 Feb 27 2016 pyspark -rw-r--r--. 1 spark spark 1486 Feb 27 2016 pyspark2.cmd -rw-r--r--. 1 spark spark 1000 Feb 27 2016 pyspark.cmd-rwxr-xr-x. 1 spark spark 2384 Feb 27 2016 run-example -rw-r--r--. 1 spark spark 2682 Feb 27 2016 run-example2.cmd -rw-r--r--. 1 spark spark 1012 Feb 27 2016 run-example.cmd -rwxr-xr-x. 1 spark spark 2858 Feb 27 2016 spark-class -rw-r--r--. 1 spark spark 2365 Feb 27 2016 spark-class2.cmd -rw-r--r--. 1 spark spark 1010 Feb 27 2016 spark-class.cmd -rwxr-xr-x. 1 spark spark 1049 Feb 27 2016 sparkR -rw-r--r--. 1 spark spark 1010 Feb 27 2016 sparkR2.cmd -rw-r--r--. 1 spark spark 998 Feb 27 2016 sparkR.cmd -rwxr-xr-x. 1 spark spark 3026 Feb 27 2016 spark-shell -rw-r--r--. 1 spark spark 1528 Feb 27 2016 spark-shell2.cmd -rw-r--r--. 1 spark spark 1008 Feb 27 2016 spark-shell.cmd -rwxr-xr-x. 1 spark spark 1075 Feb 27 2016 spark-sql -rwxr-xr-x. 1 spark spark 1050 Feb 27 2016 spark-submit -rw-r--r--. 1 spark spark 1126 Feb 27 2016 spark-submit2.cmd -rw-r--r--. 1 spark spark 1010 Feb 27 2016 spark-submit.cmd [[email protected] bin]$

拿bin目錄而言。比如

[[email protected] bin]$ pwd /usr/local/spark/spark-1.6.1-bin-hadoop2.6/bin [[email protected] bin]$ ./spark-shell log4j:WARN No appenders could be found for logger (org.apache.hadoop.metrics2.lib.MutableMetricsFactory). log4j:WARN Please initialize the log4j system properly. log4j:WARN See http://logging.apache.org/log4j/1.2/faq.html#noconfig for more info. Using Spark's repl log4j profile: org/apache/spark/log4j-defaults-repl.properties To adjust logging level use sc.setLogLevel("INFO") Welcome to ____ __ / __/__ ___ _____/ /__ _\ \/ _ \/ _ `/ __/ '_/ /___/ .__/\_,_/_/ /_/\_\ version 1.6.1 /_/ Using Scala version 2.10.5 (Java HotSpot(TM) 64-Bit Server VM, Java 1.8.0_60) Type in expressions to have them evaluated. Type :help for more information. Spark context available as sc. 17/03/24 04:37:19 WARN Connection: BoneCP specified but not present in CLASSPATH (or one of dependencies) 17/03/24 04:37:21 WARN Connection: BoneCP specified but not present in CLASSPATH (or one of dependencies) 17/03/24 04:37:36 WARN ObjectStore: Version information not found in metastore. hive.metastore.schema.verification is not enabled so recording the schema version 1.2.0 17/03/24 04:37:36 WARN ObjectStore: Failed to get database default, returning NoSuchObjectException 17/03/24 04:37:43 WARN Connection: BoneCP specified but not present in CLASSPATH (or one of dependencies) 17/03/24 04:37:43 WARN Connection: BoneCP specified but not present in CLASSPATH (or one of dependencies) 17/03/24 04:37:53 WARN ObjectStore: Version information not found in metastore. hive.metastore.schema.verification is not enabled so recording the schema version 1.2.0 17/03/24 04:37:53 WARN ObjectStore: Failed to get database default, returning NoSuchObjectException SQL context available as sqlContext. scala>

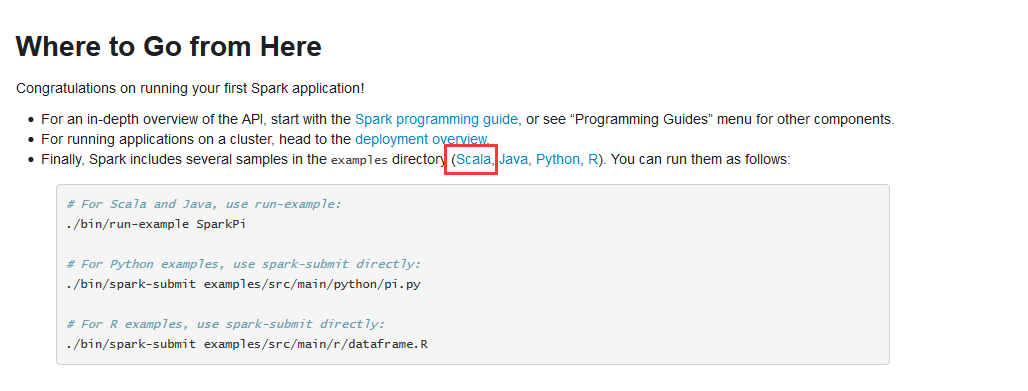

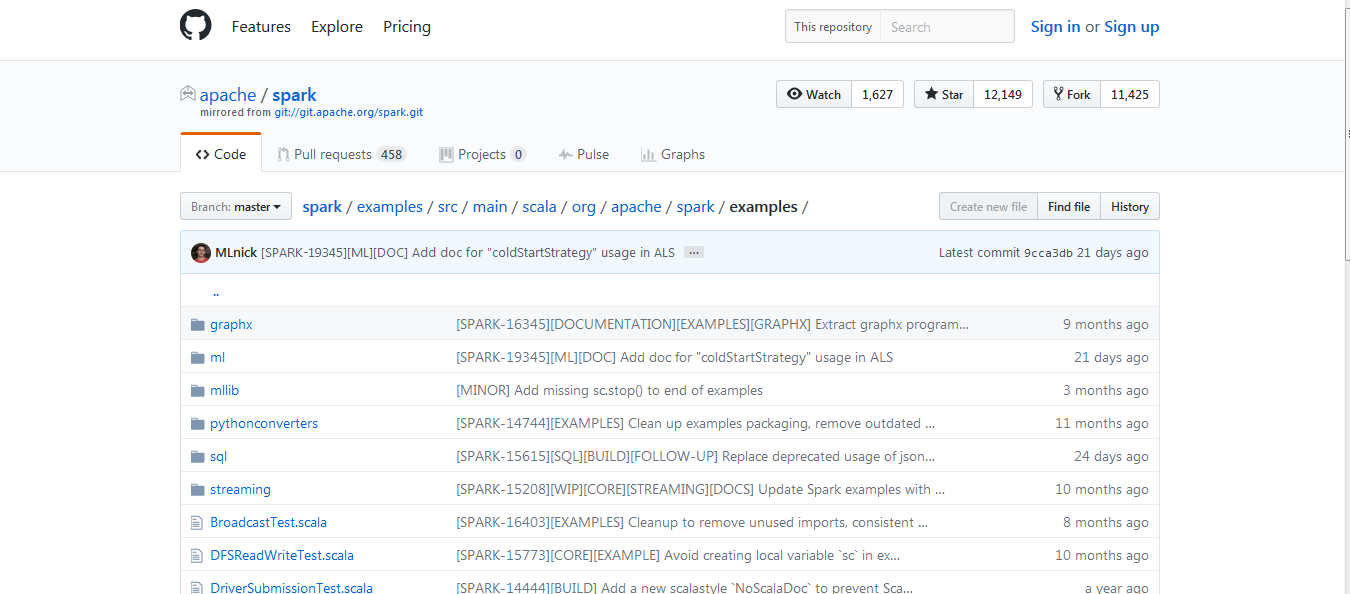

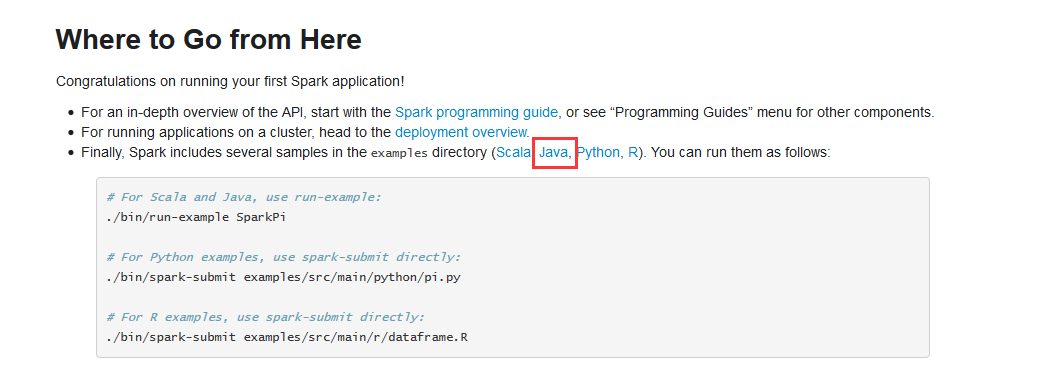

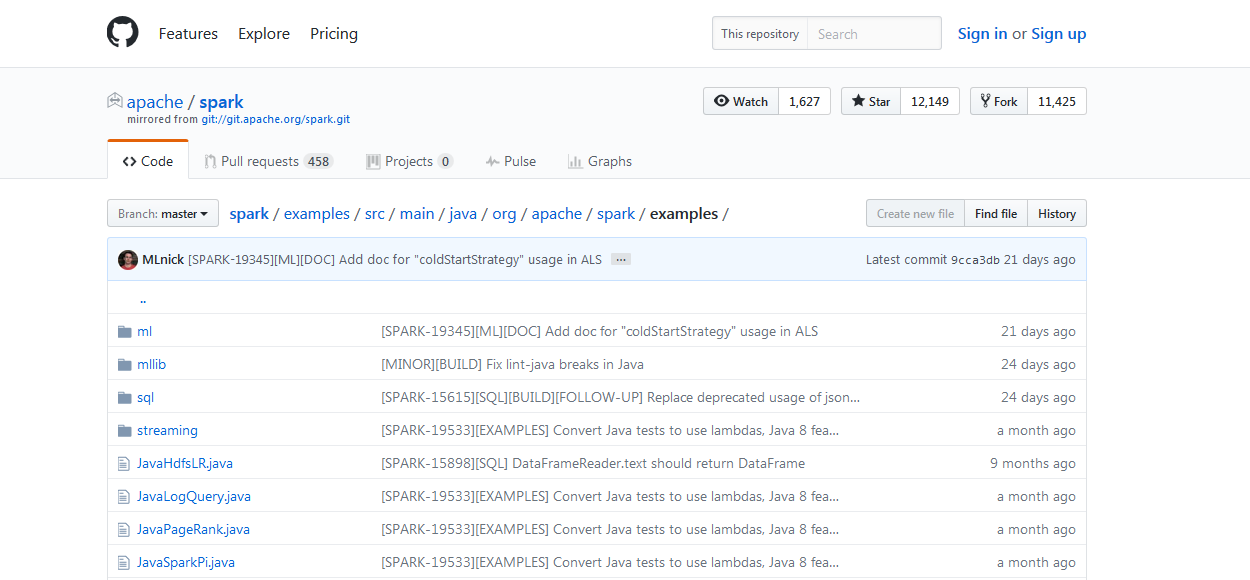

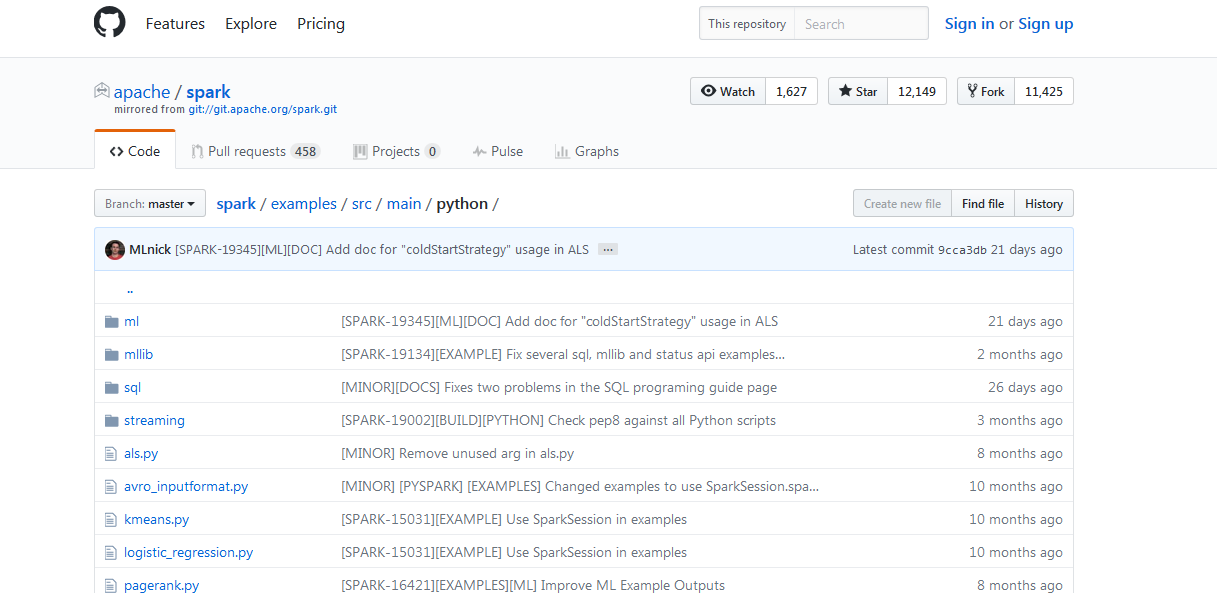

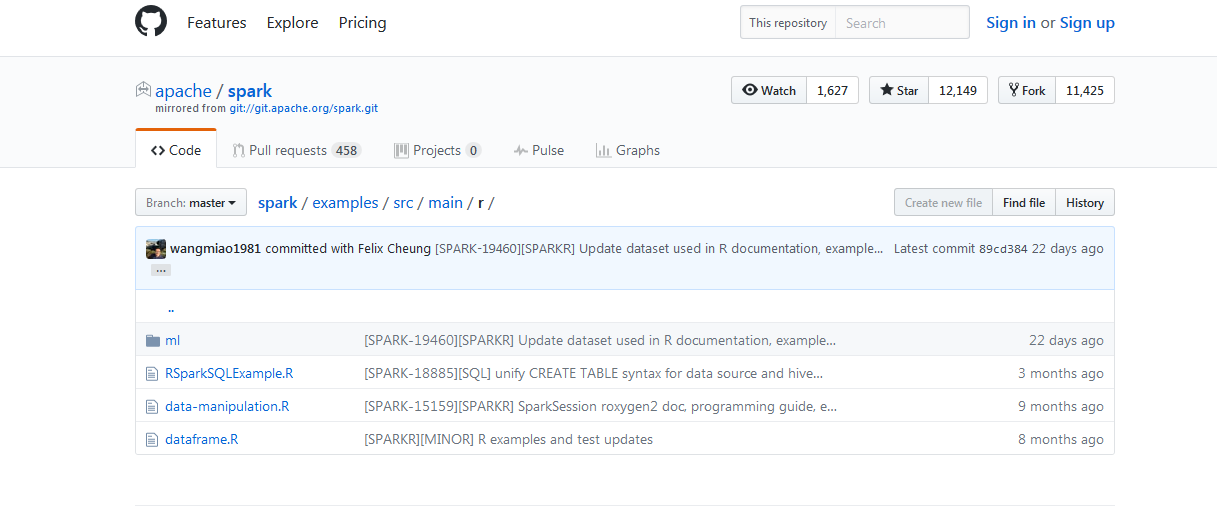

拿example而言,比如

例子,(官網給的)

http://spark.apache.org/docs/latest/quick-start.html

相關推薦

帶你認識spark安裝包的目錄結構

其實啊,將spark的壓縮包解壓好,就已經是spark的最簡易安裝了。 其實啊,想說的是,只要將spark這壓縮包解壓好,就已經是spark的最簡易安裝了。 [[email protected] spark-1.6.1-bin-hadoop2.6]$ ll t

帶你認識安裝Oozie所遇之坑

一、常見錯誤一 上傳 Oozie 目錄下的 yarn.tar.gz 檔案到 HDFS所遇之坑: 在oozie的根目錄下執行如此命令: bin/oozie-setup.sh sharelib create -fs hdfs://linux01:8020 -locallib oozie-

第五篇 scrapy安裝及目錄結構,啟動spider項目

allow nes 編寫 分析 res extension basic 依賴包 directory 實際上安裝scrapy框架時,需要安裝很多依賴包,因此建議用pip安裝,這裏我就直接使用pycharm的安裝功能直接搜索scrapy安裝好了。 然後進入虛擬環境創建一

老司機帶你認識IP一些基礎的知識

對與IP簡單的認識入門對IP得一個簡單認識ip地址 ip address 作用: 標識一個節點的網絡地址! 地址組成{點分十進制}:-一共分為32個二位進制-轉換為4個十位進制表示,以. 隔開 子網掩碼:是用來區分網絡位和主機位的 網關 是指一個網絡連接到另外一個網絡的關口 備用配置1專用的ip地址:1

004-ant design pro安裝、目錄結構、項目加載啟動

assets ocs win 領域 org 參考 des 布局 class 一、概述 1.1、腳手架概念 編程領域中的“腳手架(Scaffolding)”指的是能夠快速搭建項目“骨架”的一類工具。例如大多數的React

還有人不認識通訊詐騙,短信驗證碼帶你認識一下

col 手機號 jpg 數據庫 平臺 獲取 gsm信號 第三方服務 關鍵技術 首先進行一下自我介紹,短信驗證碼本碼。短信驗證碼:網站或者客戶端應用需要接入短信驗證碼(手機驗證碼)的功能,可以實現註冊用戶的手機號碼正確性校驗,確保用戶填寫的手機號碼的真實性。現在已經完全融入了

create-react-app腳手架的安裝和目錄結構介紹

img 初步了解 腳手架 快速搭建 每次 一次 cmd react 等等 1.對腳手架的初步了解 編程領域中的“腳手架”指的是能夠快速搭建項目“骨架”的一類工具,例如大多數的React項目都有src,public,webpack配置文件等等,而src目錄中又包含compon

帶你認識ButterKnife

原文連結:http://blog.csdn.net/donkor_/article/details/77879630 前言: ButterKnife是一個專注於Android系統的View注入框架,以前總是要寫很多findViewById來找到View物件,有了ButterKnife可以很輕鬆的

從D&G事件,帶你認識不靠譜的義大利!

從D&G事件,帶你認識不靠譜的義大利! 一. D&G大秀本將如期舉行,但其設計師卻對中國人肆無忌憚公然辱罵,引起了惡劣後果。 此事曝光後,迅速引爆網路,娛樂圈眾明星紛紛表態拒絕出席晚宴,迪麗熱巴和王俊凱終止與D&G合作。輿論一片譁然,紛紛喊出讓這個牌子滾出中國。

帶你認識Linux中的通配符

查看 inux process water 圖片 顯示 技術 pro 開頭 通配符是一種特殊語句,用來模糊搜索文件,當查找文件夾時,可以使用它來代替一個或多個真正的字符,它使得文件管理更加快速,便捷,大大的提升了工作效率。 常用的通配符有 * 、? 、[] 等(可通過m

帶你認識Oracle索引型別(精)

Oracle索引和MySQL索引是一個概念,都是為了提高資料庫查詢效率,例如字典的目錄,就是一種索引。不同的索引有不同的查詢效率,比如字典的目錄有以拼音首字母的,有偏旁部首的。當我們對所有索引型別有了瞭解之後,就可以針對性的寫出高效的SQL語句、建立最合適的索引。 那Oracle索引都有

一步一步教你認識Python閉包

在「python之禪」公眾號中曾經介紹過兩篇關於函式的文章,第一篇是 關於 Python 函式是第一類物件,第二篇是關於 Lambda 函式,今天來說說 Python 閉包。 什麼是閉包?閉包有什麼用?為什麼要用閉包?今天我們就帶著這3個問題來一步一步認識閉包。閉包和函式緊密聯絡在一起,介紹

NetSuite與SheKnows Media一起帶你認識“她力量”

品牌增長是所有行業的熱門話題,而實現這一目標的道路卻佈滿荊棘。 來自紐約的數字媒體公司SheKnows Media正以自己的步調走在這條路上,在逐步實現著自己革新出版業和激勵所有女性活出自我的目標。 作為女性生活方式數字媒體公司,SheKnows Media的使命是我們所有人都同意的使命

從零到一:帶你認識深度學習!

作者:Zied Haj-Yahia 翻譯:張玲 校對:丁楠雅 本文約2500字,建議閱讀15分鐘。 本文為你簡要介紹深度學習的基本構成、模型優化的幾種方式和模型訓練的一些最佳實踐。 一年多來,我在LinkedIn、Medium和Arxiv上閱讀了不少深度學習相

帶你認識Oracle索引型別

Oracle索引和MySQL索引是一個概念,都是為了提高資料庫查詢效率,例如字典的目錄,就是一種索引。不同的索引有不同的查詢效率,比如字典的目錄有以拼音首字母的,有偏旁部首的。當我們對所有索引型別有了瞭解之後,就可以針對性的寫出高效的SQL語句、建立最合適的索引

帶你走進Spark程式設計之Scala入門

寫在前邊的話: 1:什麼是Scala? Scala是一門多正規化的程式語言,類似於Java,並集成了面向物件程式設計和函數語言程式設計的各種特性,具體可參考知乎上的一個帖子 2:本篇部落格包含哪些內容? Scala中變數的宣告與函式定義 Sca

開啟Scrapy專案之旅之一:認識Scrapy專案的目錄結構

建立一個爬蟲專案,框架會自動: 1、生成一個同名專案資料夾 資料夾包括:同名子資料夾+scrapy.cfg檔案 2、同名子資料夾:核心程式碼 scrapy.cfg檔案:配置檔案 3、同名子資料夾: _init_py檔案:專案的初始化檔案,專案的初始化資訊。 items.py檔

一文帶你認識Java泛型基礎

Java泛型基礎 認識泛型 泛型是在JDK1.5之後增加的新功能. 泛型可以解決資料的安全性問題, 主要的原理是在類宣告的時候通過一個標識表示類中某個屬性的型別或者是某個方法的返回值及引數型別. 格式: 訪問許可權 class 類名稱<泛型, …

Android原始碼分析—帶你認識不一樣的AsyncTask(串並行)

前言 什麼是AsyncTask,相信搞過android開發的朋友們都不陌生。AsyncTask內部封裝了Thread和Handler,可以讓我們在後臺進行計算並且把計算的結果及時更新到UI上,而這些正是Thread+Handler所做的事情,沒錯,AsyncTask

Hadoop安裝包目錄下幾個比較重要的目錄及其作用

1、sbin目錄:存放啟動或停止hadoop相關服務的指令碼 2、bin目錄:存放對hadoop相關服務(HDFS,YARN)進行操作的指令碼 3、etc目錄:hadoop的配置檔案目錄,存放hadoop的配置檔案 4、share目錄:存放hadoop的依