Deep Learning, NLP, and Representations翻譯學習

基本資訊

主要內容

- 《深度學習,自然語言處理和表徵方法》

- keywords:neural networks, deep learning, representations, NLP, recursive neural networks

- 關鍵詞:神經網路,深度學習,表徵方法,自然語言處理,遞迴神經網路

簡介

- 深度神經網路在模式識別(pattern recognition),計算機視覺(computer vision),語音識別(voice recognition)任務上表現出色。

- 本文綜述深度神經網路應用在NLP上的成果

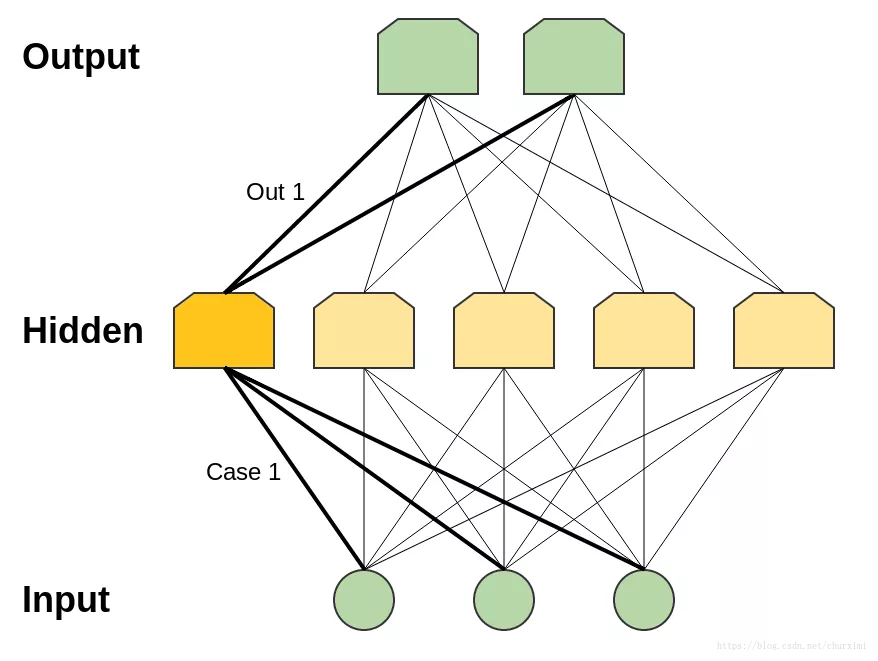

單隱層神經網路

- 單隱層神經網路(One Hidden Layer Neural Networks)

- 單隱層神經網路有一個普適性(universality):給予足夠的隱結點,它可以估算任何函式

- 本質上這個理論是正確的,因為隱層可以用來做查詢表(lookup table)

- 感知器網路(perceptron network)

- 一個感知器是一個非常簡單的神經元:它在超過某個閾值(threshold)時才會觸發

- 感知器網路的輸入和輸出都是二進位制的(0和1)

- 注意:可能的輸入個數是有限的

- 對於每個可能的輸入,可以在隱層中構建一個僅對該特定輸入才能觸發的神經元

然後就可以利用該神經元和輸出神經元之間的連線來控制該輸入下的輸出結果

備註1:如果有n個輸入神經元,則為所有可能的輸入構建case需要2^n個隱層神經元。不過實際中情況通常不會那麼糟糕:You can have cases that encompass multiple inputs. And you can have overlapping cases that add together to achieve the right input on their intersection.

- 普適性意味著一個網路能適應任何你給它的訓練資料,但這並不意味著它在插入新資料點時能表現得很理想。

- 所以普適性並不能解釋為什麼神經網路如此有效。

- 備註2:不僅感知器網路有普適性,多層感知器(sigmoid neurons)網路(及其他啟用函式)也具有普適性。

詞嵌入(Word Embeddings)

詞嵌入其實早在十多年前就由Bengio等人提出(2001,2003)

Bengio, Yoshua, et al. “A neural probabilistic language model.” Journal of machine learning research 3.Feb (2003): 1137-1155.

distributed representations for symbols則更早 (Hinton 1986)

- 詞嵌入是一個引數化函式(paramaterized function):將詞語對映成向量

- 一般這個引數化函式就是一個查詢表(lookup table)

- 通過任務訓練學習得到引數W,例如預測句子中下一個詞,或是預測5-gram是否成立

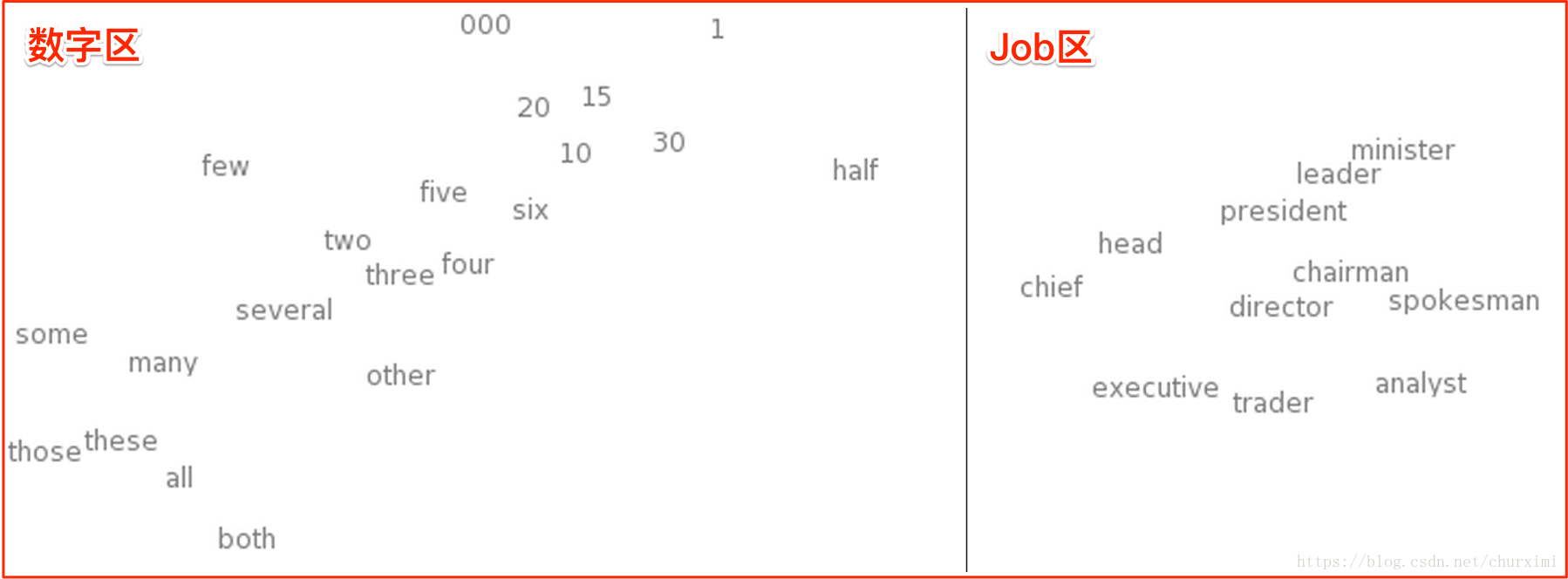

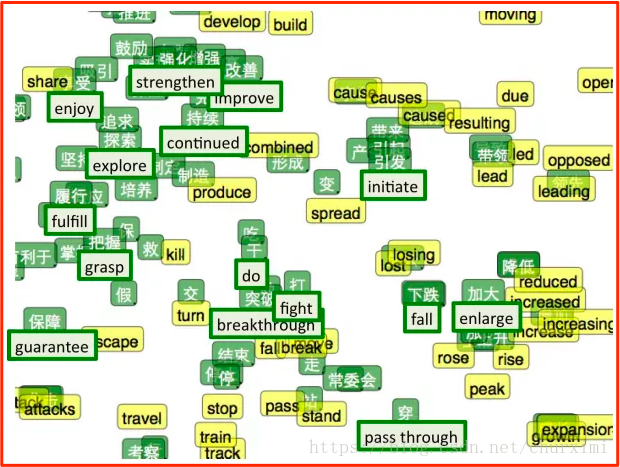

可以用t-SNE來對詞嵌入空間視覺化(t-SNE是一個高維資料視覺化技術)

意義相似的詞擁有相似的向量

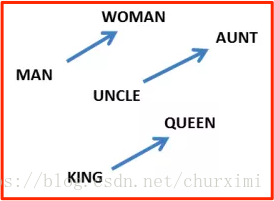

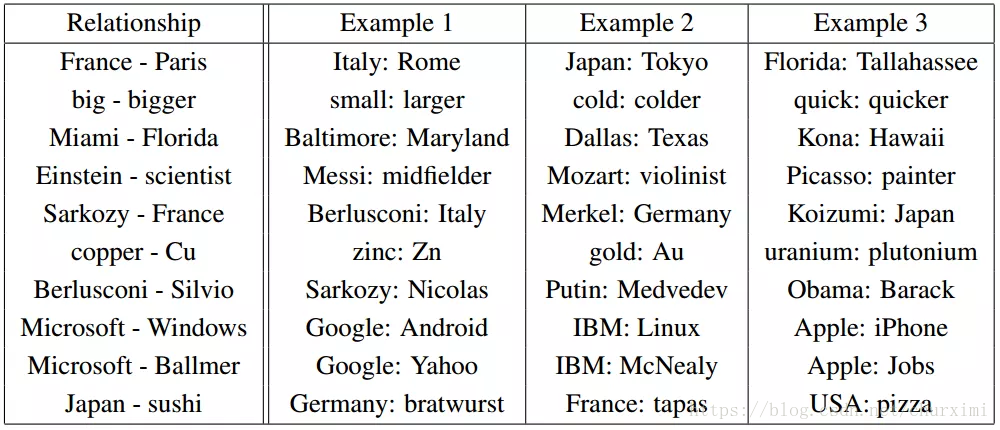

詞嵌入另一個屬性:單詞間的類比彷彿是被編碼在了單詞向量的區別中:

詞嵌入中的關係對:

神經網路能自動學習更好的資料表徵的方法

共同表徵(Shared Representations)

利用任務A學習到的單詞特徵表示應用到其他NLP任務中:

- 預訓練(pretraining)

- 遷移學習(transfer learning)

- 多工學習(multi-task learning)

雙語單詞嵌入:把漢語和英語嵌入到同一個空間去

Zou, Will Y., et al. “Bilingual word embeddings for phrase-based machine translation.” Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. 2013.

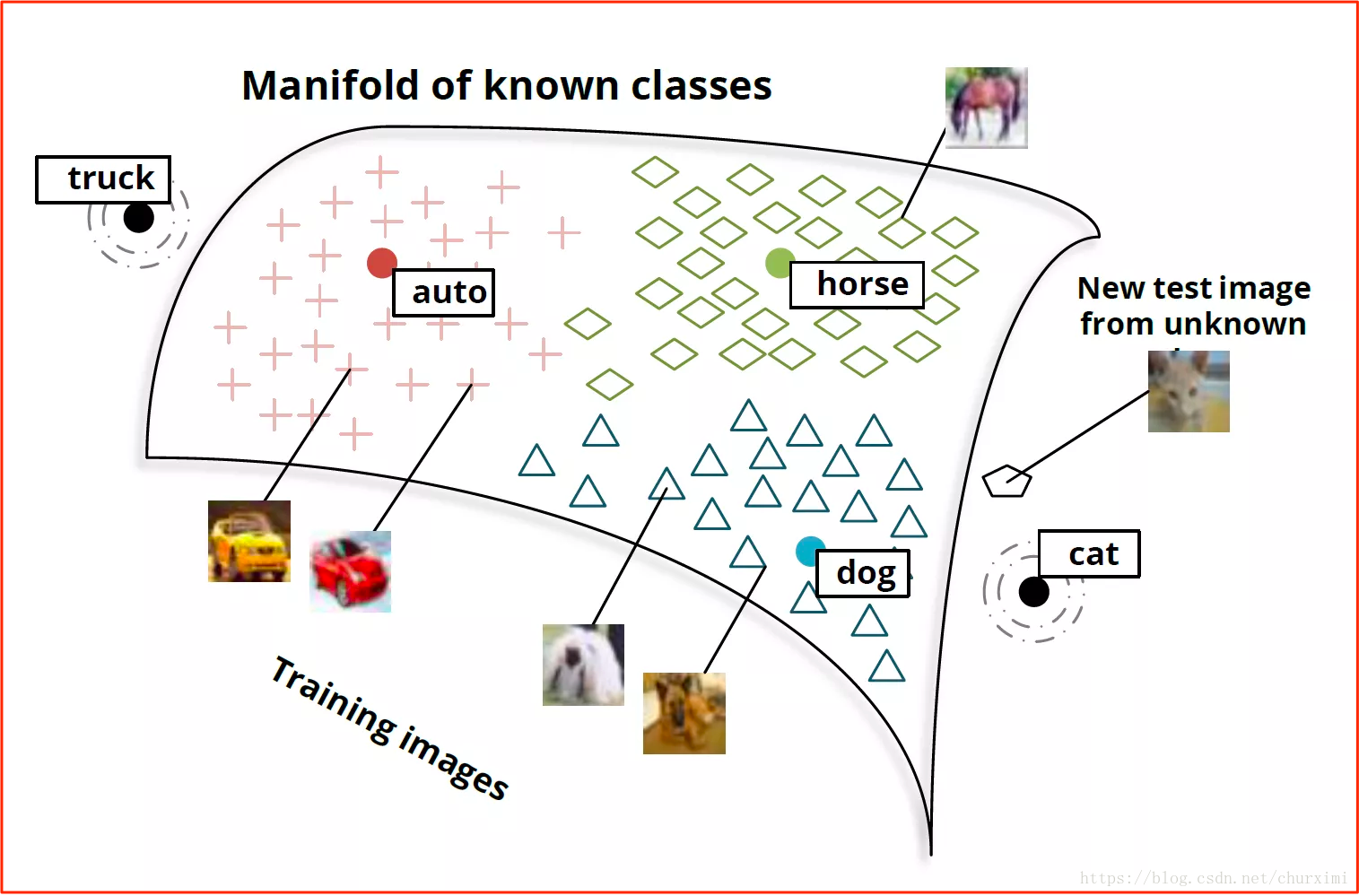

我們也可以學習把非常不同的幾種資料嵌入到同一個空間去

- 例如,把單詞和影象嵌入到同一個表徵下的模型

基本思路就是可以通過單詞嵌入輸出的向量來對影象進行分類:

- 狗的影象會被對映到“狗”的單詞向量附近

- 馬的影象會被對映到“馬”的單詞向量附近

- 汽車的影象會被對映到“汽車”的單詞向量附近

- 以此類推

遞迴神經網路(沒有細看)

- 遞迴神經網路(RNN)是兩種人工神經網路的總稱

- 一種是時間遞迴神經網路(recurrent neural network)

- 另一種是結構遞迴神經網路(recursive neural network)

- 時間遞迴神經網路的神經元間連線構成矩陣

- 結構遞迴神經網路利用相似的神經網路結構遞迴構造更為複雜的深度網路

- RNN一般指代時間遞迴神經網路

結論

- 在優化多層模型的過程中,更好的資料表徵方法會自動浮現出來

相關推薦

Deep Learning, NLP, and Representations翻譯學習

基本資訊 主要內容 《深度學習,自然語言處理和表徵方法》 keywords:neural networks, deep learning, representations, NLP, recursive neural networks 關鍵詞:神經

Neural Networks and Deep Learning 神經網路和深度學習

在http://neuralnetworksanddeeplearning.com/看到這篇文章。寫的簡單易懂。適合初學者學習,不過是英文的。 自己嘗試著一邊翻譯一邊學習。 第一章 使用神經網路識別手寫數字 人眼是世界上最奇妙的東西之一。有如下一串手寫數字: 大部

CMU Deep Learning 2018 by Bhiksha Raj 學習記錄(7)

sha res learning ksh https img radi des AR

CMU Deep Learning 2018 by Bhiksha Raj 學習記錄(10)

des 技術分享 nco .com ear mat etime nbsp this http://deeplearning.cs.cmu.edu/slides/lec11.recurrent.pdf

CMU Deep Learning 2018 by Bhiksha Raj 學習記錄(18)

技術 mis ati www. box side int watch ide https://www.youtube.com/watch?v=oiNFCbD_4Tk

CMU Deep Learning 2018 by Bhiksha Raj 學習記錄(20) Recitation 8: Attention

ng- inf mas nbsp 技術 master github tutorial IT http://deeplearning.cs.cmu.edu/recitations/rec8.attention.pdf

CMU Deep Learning 2018 by Bhiksha Raj 學習記錄(20) Lecture 20: Hopfield Networks 1

png call inf learning 分享 eight deep min 技術 symmetric version: called Hopfield Net

Deep Learning: The Big Picture 深度學習大局觀 Pluralsight課程中文字幕

Deep Learning: The Big Picture 中文字幕 深度學習大局觀 中文字幕Deep Learning: The Big Picture 深度學習是一種人工智慧,允許機器學習如何解決複雜的任務,而無需明確程式設計 在本課程中,深度學習:大圖,您將首先了解使用Te

Deep Learning: Theory and Experiments

<article> <script async="" src="//pagead2.googlesyndication.com/pagead/js/adsbygoogl

Deep learning基於theano的keras學習筆記-網路層

Deep learning基於theano的keras學習筆記-網路層 轉自 https://blog.csdn.net/zhili8866/article/details/53262114 1. 常用層 1.1 Dense層 keras.layers.core.Dense(outp

Learning Bitcoin and Other Cryptocurrencies 學習比特幣和其他加密貨幣 Lynda課程中文字幕

Learning Bitcoin and Other Cryptocurrencies 中文字幕 學習比特幣和其他加密貨幣 中文字幕Learning Bitcoin and Other Cryptocurrencies 比特幣是隻線上存在的一種貨幣形式 雖然它成為全球頭條新聞,但很

Deep Learning: The Big Picture 深度學習大局觀 Pluralsight課程中文字幕

Deep Learning: The Big Picture 中文字幕 深度學習大局觀 中文字幕Deep Learning: The Big Picture 深度學習是一種人工智慧,允許機器學習如何解決複雜的任務,而無需明確程式設計 在本課程中,深度學習:大圖

「Medical Image Analysis」Note on 3D Deep Learning (三維深度學習)

[1] 3D Deep Learning for Efficient and Robust Landmark Detection in Volumetric Data MICCAI 2015 [pap

Deep Learning回顧之基於深度學習的目標檢測

轉自:https://www.52ml.net/20287.html 引言 普通的深度學習監督演算法主要是用來做分類,如圖1(1)所示,分類的目標是要識別出圖中所示是一隻貓。而在ILSVRC(ImageNet Large Scale Visual Recognitio

[轉載]Deep Learning·NLP·Representation

原文地址:Mr.Scofield ----- csdn From RxNLP. Indexing: 〇、序一、DeepNLP的核心關鍵:語言表示(Representation)二、NLP詞的表示方法型別

【Person Re-ID】Person Re-Identification by Deep Learning Multi-Scale Representations

Introduction 本文主要的考慮是:目前所有re-id的方法,不管是不是基於CNN的,第一步都是將影象resize到統一大小然後再來提取特徵。這種做法會模糊掉影象在不同尺度上的顯著性特徵,因此作者認為這樣的方法不是最優的,本文提出了一種在多尺度上提

Deep Learning 15:RBM的學習

RBM是深度學習的核心,所以必須徹底清楚地理解RBM原理、推導及其訓練方法 1.讀學位論文“基於深度學習的人臉識別研究”: 對RBM、DBN的介紹比較詳細,可以作為基礎閱讀,再去讀英文論文。 2.RBM的推導: 講得非常清楚,第一重點推薦! 這個講很直白,感覺非常好!第二重點推薦,也不知道是

Deep Learning 18:DBM的學習及練習_讀論文“Deep Boltzmann Machines”的筆記

前言 論文“Deep Boltzmann Machines”是Geoffrey Hinton和他的大牛學生Ruslan Salakhutdinov在論文“Reducing the Dimensionality of Data with Neural Networks”合作後的又一次聯合發表的一篇

[deep learning]caffe cuda docker 深度學習的第一步

今天很高興,因為經過將近3天的努力,我的深度學習終於邁出了第一步,caffe docker 帶給我希望。 先需要做一下簡要的提醒,在安裝過程中,要時刻提醒自己注意版本的一致性(若不一致,會走很多彎路),包括nvidia driver cuda cudnn 和ca

Spark MLlib Deep Learning Convolution Neural Network (深度學習-卷積神經網路)3.3

3、Spark MLlib Deep Learning Convolution Neural Network(深度學習-卷積神經網路)3.3 第三章Convolution Neural Network (卷積神經網路) 3例項 3.1 測試資料 按照上例資料,或者新建圖片