卷積神經網路論文學習(Lecun1998)

Ⅰ.介紹

A.資料學習

自動機器學習可以歸納為 ,

, 是第p個輸入模式,W是學習權值,

是第p個輸入模式,W是學習權值, 是識別類標號。

是識別類標號。損失函式

,

, 理想輸出。

理想輸出。

實際上的最小化函式為

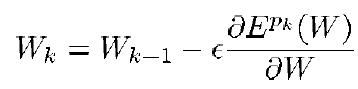

B.梯度學習演算法

隨機梯度下降:

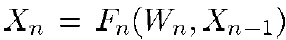

C.梯度反向傳播

將如此簡單的演算法應用到複雜的機器學習問題的原因:

1.實際上區域性最小解不會影響問題的實現。

2.簡單有效的計算梯度的演算法,如反向傳播。

3.將反向梯度應用到sigmoid單元能解決複雜的學習任務。

D.手寫體識別系統的學習問題

最難的一點不是識別一個字元,而是從一個句子或單詞中分割出一個個字元。這樣的技術已成為標準,叫HOS(Heuristic oversegmentation)。

在人工標籤中會遇到的一些問題,例如,將數字4的右邊部分識別為標籤1還是非字元?數字8的右邊是否應該識別為3?問題解決需要用到GTN(Graph transformer network)。E.全域性可訓練系統

要使系統能使用後向傳播來訓練,模型必須是可微分和連續的。

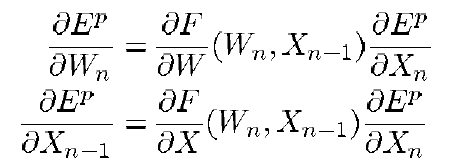

知道Ep對Xn的偏導,就能計算出Ep對W和Xn-1的偏導。

知道Ep對Xn的偏導,就能計算出Ep對W和Xn-1的偏導。

Ⅱ.卷積神經網路進行字元識別

使用傳統全連線神經網路進行字元識別的問題: 1.輸入圖片大,需要的隱藏層神經元多,所以要訓練的引數會很多,記憶體消耗大。無結構網路的主要缺點是無法學習到不變性特徵(不會因平移,扭曲等變換而變化的特徵)。儘管足夠大的全連線神經網路能學習不變性特徵,但會導致學習的權值在不同位置上出現相似的權值模式,同時學習這些權值需要很多訓練樣本。A.卷積網路

1.區域性感受野 提取區域性的初級視覺特徵(邊緣,端點,角落),可以組合不同初級特徵構成高階特徵。 2.權值共享 因為區域性影象的初級特徵檢測器對於整幅圖非常有用,所以利用這個知識,將圖片不同位置的感受野設定為具有相同權值的向量。可以減少訓練引數的數量,所以減少機器容量h。 3.時間空間下采樣 一旦特徵被提取出來,特徵的具體位置就變得沒那麼重要,只有幾個特徵的相對位置關係比較重要。特徵的精確位置不但與識別目標沒關,而且存在危害,因為不同的字元樣本的位置會不同。所以使用下采用可以使具體位置變得模糊,降低feature map的解析度,同時減少對平移扭曲變換的敏感度。相關推薦

卷積神經網路論文學習(Lecun1998)

Ⅰ.介紹 A.資料學習 自動機器學習可以歸納為,是第p個輸入模式,W是學習權值,是識別類標號。損失函式,理想輸出。 ,目標是最小化平均損失以及最小化,所以是個折中問題。其中,h是機器的有效容量(h

深度學習小白——卷積神經網路視覺化(二)

一、由卷積後的code得到原始影象 可以看出隨著卷積網路的進行,越來越多的資訊被扔掉了,能還原除的資訊也就越少。 二、Deep Dream google發明的起初是用來看神經網路各層在“看”什麼,後來因為得到的影象很具有藝術感,所以成為了一個藝術圖片生成器。 這是一

深度學習之卷積神經網路程式設計實現(二)

void conv_bprop(Layer *layer, Layer *prev_layer, bool *pconnection) { int index = 0; int size = prev_layer->map_w * prev_layer->map_h; // delta

深入淺出——搞懂卷積神經網路誤差分析(一)

第一部分 全連線網路的權值更新 卷積神經網路使用基於梯度的學習方法進行監督訓練,實踐中,一般使用隨機梯度下降(機器學習中幾種常見的梯度下降方式)的版本,對於每個訓練樣本均更新一次權值,誤差函式使用誤差平方和函式,誤差方式採用平方誤差代價函式。 注:本

《TensorFlow:實戰Google深度學習框架》——6.3 卷積神經網路常用結構(池化層)

池化層在兩個卷積層之間,可以有效的縮小矩陣的尺寸(也可以減小矩陣深度,但實踐中一般不會這樣使用),co。池從而減少最後全連線層中的引數。 池化層既可以加快計算速度也可以防止過度擬合問題的作用。 池化層也是通過一個類似過濾器結構完成的,計算方式有兩種: 最大池化層:採用最

利用tensorflow實現簡單的卷積神經網路——遷移學習小記(二)

一、什麼是神經網路(CNN) 卷積神經網路(Convolutional Neural Network,簡稱CNN),是一種前饋神經網路,人工神經元可以影響周圍單元,可以進行大型影象處理。卷積神經網路包括卷積層和池化層。卷積神經網路是受到生物思考方式的啟發的MLPs(多

Tensorflow 入門學習13.卷積神經網路原理3.(網路結構詳解)

本文學習內容來自《TensorFlow深度學習應用實踐》 從前面介紹的卷積運算的基本原理和概念,從本質上來說卷積神經網路就是將影象處理的二維離散卷積運算和神經網路相結合。這種卷積運算可以用於自動提取特徵,而卷積神經網路也主要應用於二維影象的識別。 卷積神經網路原

深度學習 --- 深度卷積神經網路詳解(AlexNet 網路詳解)

本篇將解釋另外一個卷積神經網路,該網路是Hinton率領的谷歌團隊(Alex Krizhevsky,Ilya Sutskever,Geoffrey E. Hinton)在2010年的ImageNet大賽獲得冠軍的一個神經網路,因此本節主要參考的論文也是這次大賽的論文即“Imag

深度學習(四)卷積神經網路入門學習(1)

卷積神經網路入門學(1)作者:hjimce卷積神經網路演算法是n年前就有的演算法,只是近年來因為深度學習相關演算法為多層網路的訓練提供了新方法,然後現在電腦的計算能力已非當年的那種計算水平,同時現在的訓練資料很多,於是神經網路的相關演算法又重新火了起來,因此卷積神經網路就又活

深度學習1——深度學習(四)卷積神經網路入門學習(1)

卷積神經網路入門學(1) 轉載自:hjimce的專欄 - 部落格頻道 - CSDN.NET 原文地址:http://blog.csdn.NET/hjimce/article/details/47323463 作者:hjimce 卷積

Tensorflow 入門學習12.卷積神經網路原理2.(池化)

本文學習內容來自《TensorFlow深度學習應用實踐》《深度學習》 池化的概念 卷積網路中一個典型層包含三級。在第一級中,這一層並行地計算多個卷積產生一組線性啟用響應。在第二級中,每一個線性啟用響應將會通過一個非線性的啟用函式,例如整流線性啟用函式。這一級有時

TensorFlow 高階之二 (卷積神經網路手寫字型識別)

一、資料集獲取 前言 在梯度下降和最優化部分用傳統的神經網路在MNIST資料集上得到了90%左右的準確率。結果其實並不太理想。 接下來,我們將使用卷積神經網路來得到一個準確率更高的模型,接近99%。卷積神經網路使用共享的卷積核對影象進行卷積操作,以提取影象深

tensorflow卷積神經網路例子學習筆記

tensorflow卷積神經網路例子 本文是對tensorflow教程中的cifar資料集卷積神經網路例子進行學習後的筆記,主要記錄了一些相關方法的使用。 模型輸入 模型的輸入包括input()、distorted_inputs等一些操作,分別

綜述卷積神經網路論文:從基礎技術到研究前景

卷積神經網路(CNN)在計算機視覺領域已經取得了前所未有的巨大成功,但我們目前對其效果顯著的原因

卷積神經網路(CNN)學習筆記2:舉例理解

下圖是一個經典的CNN結構,稱為LeNet-5網路 可以看出,CNN中主要有兩種型別的網路層,分別是卷積層和池化(Pooling)/取樣層(Subsampling)。卷積層的作用是提取影象的各種特徵;池化層的作用是對原始特徵訊號進行抽象,從而大幅度減少訓練引數,另外還可以

深度學習(DL)與卷積神經網路(CNN)學習筆記隨筆-01-CNN基礎知識點

神經認知機。 卷積神經網路是受生物靈感的多層感知機的變體。從Hubel和Wiesel的早期對貓的視覺皮層的研究工作中得出,視覺皮層包含一組複雜的細胞排列。這些細胞會對很小的子區域敏感,稱作

CNN卷積神經網路--反向傳播(2,前向傳播)

卷積層:卷積層的輸入要麼來源於輸入層,要麼來源於取樣層,如上圖紅色部分。卷積層的每一個map都有一個大小相同的卷積核,Toolbox裡面是5*5的卷積核。下面是一個示例,為了簡單起見,卷積核大小為2*2,上一層的特徵map大小為4*4,用這個卷積在圖片上滾一遍,得到一個一個(4-2+1)*(4-2+1)=3

深度學習(DL)與卷積神經網路(CNN)學習筆記隨筆-03-基於Python的LeNet之LR

0階張量叫標量(scarlar);1階張量叫向量(vector);2階張量叫矩陣(matrix) 本文主要內容:如何用python中的theano包實現最基礎的分類器–LR(Logistic Regression)。 一、模型

Tensorflow基礎:卷積神經網路遷移學習

ImageNet影象分類資料集中有120萬標註影象,所以才能將152層的ResNet的模型訓練到大約96.5%的正確率。在真實的應用中,很難收集到如此多的標註資料。即使可以收集到,也需要花費大量人力物力。而且即使有海量的訓練資料,要訓練一個複雜的卷積神經網路也需

卷積神經網路CNN-學習1

卷積神經網路CNN-學習1 十年磨一劍,霜刃未曾試。 簡介:卷積神經網路CNN學習。 CNN中文視訊學習連結:卷積神經網路工作原理視訊-中文版 CNN英語原文學習連結:卷積神經網路工作原理視訊-英文版 一、定義 卷積神