OpenCV亞畫素角點cornerSubPixel()原始碼分析

上一篇部落格中講到了goodFeatureToTrack()這個API函式能夠獲取影象中的強角點。但是獲取的角點座標是整數,但是通常情況下,角點的真實位置並不一定在整數畫素位置,因此為了獲取更為精確的角點位置座標,需要角點座標達到亞畫素(subPixel)精度。

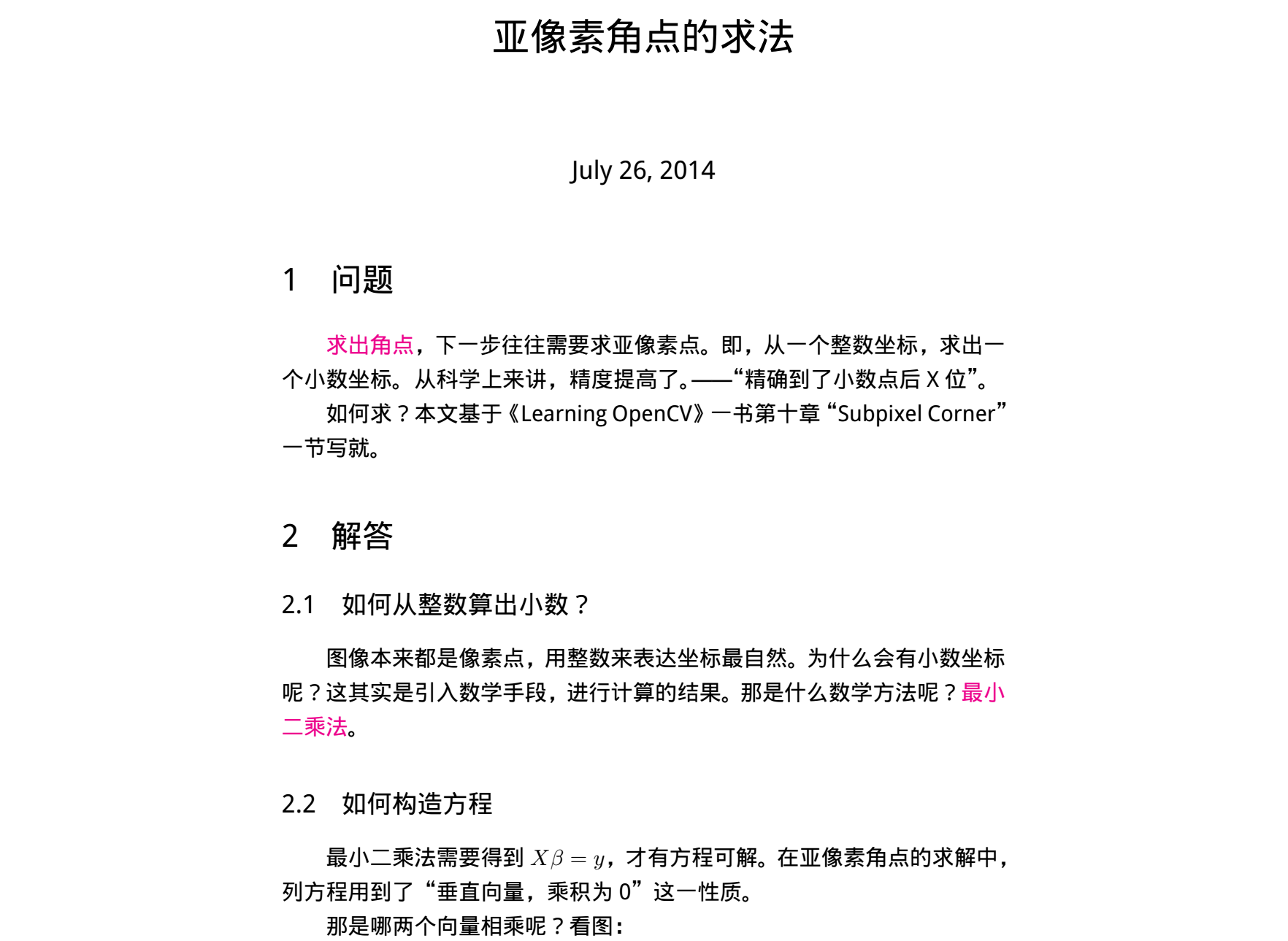

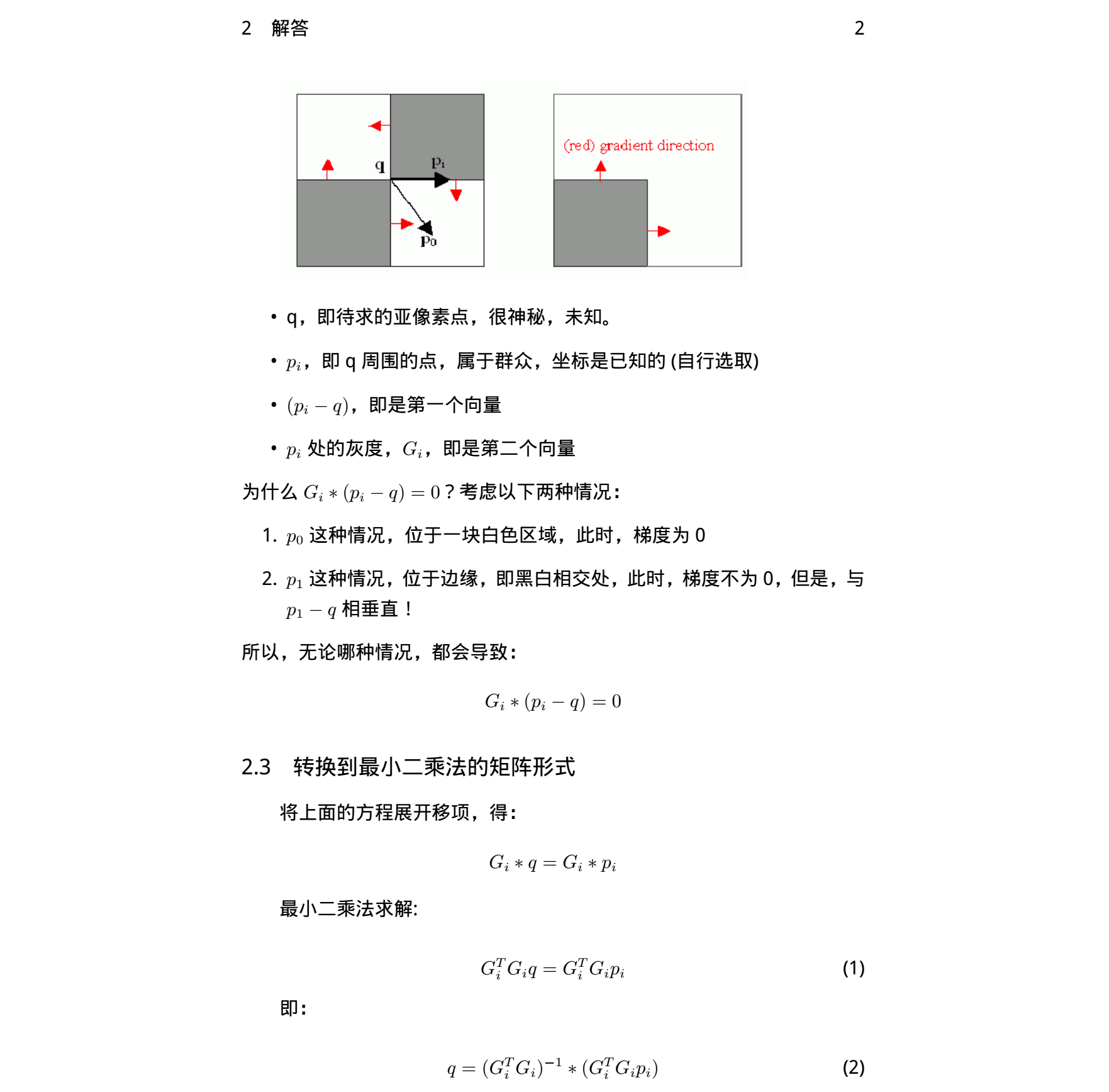

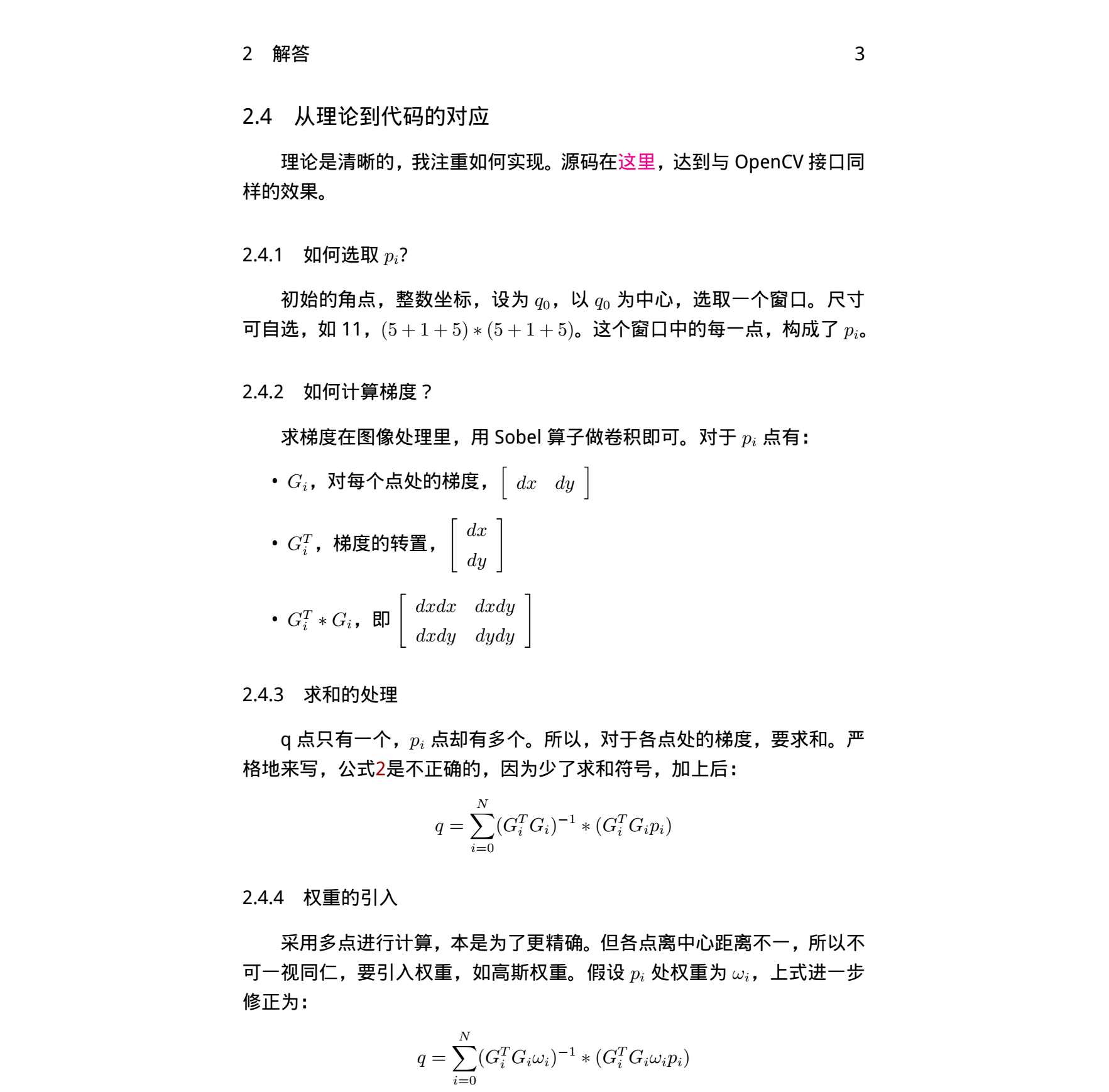

1. 求取亞畫素精度的原理

找到一篇講述原理非常清楚的文件

2. OpenCV原始碼分析

OpenCV中有cornerSubPixel()這個API函式用來針對初始的整數角點座標進行亞畫素精度的優化,該函式原型如下:

void cv::cornerSubPix( InputArray _image, InputOutputArray _corners, Size win, Size zeroZone, TermCriteria criteria )

_image為輸入的單通道影象;_corners為提取的初始整數角點(比如用goodFeatureToTrack提取的強角點);win為求取亞畫素角點的視窗大小,比如設定Size(11,11),需要注意的是11為半徑,則視窗大小為23x23;zeroZone是設定的“零區域”,在搜尋視窗內,設定的“零區域”內的值不會被累加,權重值為0。如果設定為Size(-1,-1),則表示沒有這樣的區域;critteria是條件閾值,包括迭代次數閾值和誤差精度閾值,一旦其中一項條件滿足設定的閾值,則停止迭代,獲得亞畫素角點。

這個API通過下面示例的語句進行呼叫:

cv::cornerSubPix(grayImg, pts, cv::Size(11, 11), cv::Size(-1, -1), cv::TermCriteria(CV_TERMCRIT_EPS + CV_TERMCRIT_ITER, 30, 0.1));

首先看criteria包含的兩個條件閾值在程式碼中是怎麼設定的。如下所示,最大迭代次數為100次,誤差精度為eps*eps,也就是0.1*0.1。

const int MAX_ITERS = 100; int win_w = win.width * 2 + 1, win_h = win.height * 2 + 1; int i, j, k; int max_iters = (criteria.type & CV_TERMCRIT_ITER) ? MIN(MAX(criteria.maxCount, 1), MAX_ITERS) : MAX_ITERS; double eps = (criteria.type & CV_TERMCRIT_EPS) ? MAX(criteria.epsilon, 0.) : 0; eps *= eps; // use square of error in comparsion operations

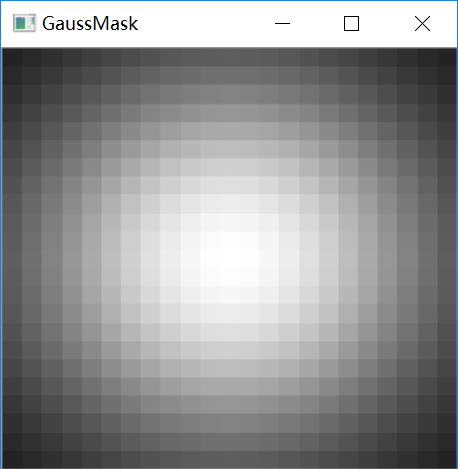

然後是高斯權重的計算,如下所示,視窗中心附近權重高,越往視窗邊界權重越小。如果設定的有“零區域”,則權重值設定為0。計算出的權重分佈如下圖:

Mat maskm(win_h, win_w, CV_32F), subpix_buf(win_h+2, win_w+2, CV_32F); float* mask = maskm.ptr<float>(); for( i = 0; i < win_h; i++ ) { float y = (float)(i - win.height)/win.height; float vy = std::exp(-y*y); for( j = 0; j < win_w; j++ ) { float x = (float)(j - win.width)/win.width; mask[i * win_w + j] = (float)(vy*std::exp(-x*x)); } } // make zero_zone if( zeroZone.width >= 0 && zeroZone.height >= 0 && zeroZone.width * 2 + 1 < win_w && zeroZone.height * 2 + 1 < win_h ) { for( i = win.height - zeroZone.height; i <= win.height + zeroZone.height; i++ ) { for( j = win.width - zeroZone.width; j <= win.width + zeroZone.width; j++ ) { mask[i * win_w + j] = 0; } } }

接下來就是針對每個初始角點,按照上述公式,逐個進行迭代求取亞畫素角點,程式碼如下。

① 程式碼中CI2為本次迭代獲取的亞畫素角點位置,CI為上次迭代獲取的亞畫素角點位置,CT是初始的整數角點位置。

② 每次迭代結束計算CI與CI2之間的歐式距離err,如果兩者之間的歐式距離err小於設定的閾值,或者迭代次數達到設定的閾值,則停止迭代。

③停止迭代後,需要再次判斷最終的亞畫素角點位置和初始整數角點之間的差異,如果差值大於設定視窗尺寸的一半,則說明最小二乘計算中收斂性不好,丟棄計算得到的亞畫素角點,仍然使用初始的整數角點。

// do optimization loop for all the points for( int pt_i = 0; pt_i < count; pt_i++ ) { Point2f cT = corners[pt_i], cI = cT; int iter = 0; double err = 0; do { Point2f cI2; double a = 0, b = 0, c = 0, bb1 = 0, bb2 = 0; getRectSubPix(src, Size(win_w+2, win_h+2), cI, subpix_buf, subpix_buf.type()); const float* subpix = &subpix_buf.at<float>(1,1); // process gradient for( i = 0, k = 0; i < win_h; i++, subpix += win_w + 2 ) { double py = i - win.height; for( j = 0; j < win_w; j++, k++ ) { double m = mask[k]; double tgx = subpix[j+1] - subpix[j-1]; double tgy = subpix[j+win_w+2] - subpix[j-win_w-2]; double gxx = tgx * tgx * m; double gxy = tgx * tgy * m; double gyy = tgy * tgy * m; double px = j - win.width; a += gxx; b += gxy; c += gyy; bb1 += gxx * px + gxy * py; bb2 += gxy * px + gyy * py; } } double det=a*c-b*b; if( fabs( det ) <= DBL_EPSILON*DBL_EPSILON ) break; // 2x2 matrix inversion double scale=1.0/det; cI2.x = (float)(cI.x + c*scale*bb1 - b*scale*bb2); cI2.y = (float)(cI.y - b*scale*bb1 + a*scale*bb2); err = (cI2.x - cI.x) * (cI2.x - cI.x) + (cI2.y - cI.y) * (cI2.y - cI.y); cI = cI2; if( cI.x < 0 || cI.x >= src.cols || cI.y < 0 || cI.y >= src.rows ) break; } while( ++iter < max_iters && err > eps ); // if new point is too far from initial, it means poor convergence. // leave initial point as the result if( fabs( cI.x - cT.x ) > win.width || fabs( cI.y - cT.y ) > win.height ) cI = cT; corners[pt_i] = cI; }

自己參照OpenCV原始碼寫了一個myCornerSubPix()介面函式以便加深理解,如下,僅供參考:

//獲取視窗內子影象

bool getSubImg(cv::Mat srcImg, cv::Point2f currPoint, cv::Mat &subImg) { int subH = subImg.rows; int subW = subImg.cols; int x = int(currPoint.x+0.5f); int y = int(currPoint.y+0.5f); int initx = x - subImg.cols / 2; int inity = y - subImg.rows / 2; if (initx < 0 || inity < 0 || (initx+subW)>=srcImg.cols || (inity+subH)>=srcImg.rows ) return false; cv::Rect imgROI(initx, inity, subW, subH); subImg = srcImg(imgROI).clone(); return true; }

//亞畫素角點提取 void myCornerSubPix(cv::Mat srcImg, vector<cv::Point2f> &pts, cv::Size winSize, cv::Size zeroZone, cv::TermCriteria criteria) {

//搜尋視窗大小 int winH = winSize.width * 2 + 1; int winW = winSize.height * 2 + 1; int winCnt = winH*winW;

//迭代閾值限制 int MAX_ITERS = 100; int max_iters = (criteria.type & CV_TERMCRIT_ITER) ? MIN(MAX(criteria.maxCount, 1), MAX_ITERS) : MAX_ITERS; double eps = (criteria.type & CV_TERMCRIT_EPS) ? MAX(criteria.epsilon, 0.) : 0; eps *= eps; // use square of error in comparsion operations //生成高斯權重 cv::Mat weightMask = cv::Mat(winH, winW, CV_32FC1); for (int i = 0; i < winH; i++) { for (int j = 0; j < winW; j++) { float wx = (float)(j - winSize.width) / winSize.width; float wy = (float)(i - winSize.height) / winSize.height; float vx = exp(-wx*wx); float vy = exp(-wy*wy); weightMask.at<float>(i, j) = (float)(vx*vy); } } //遍歷所有初始角點,依次迭代 for (int k = 0; k < pts.size(); k++) { double a, b, c, bb1, bb2; cv::Mat subImg = cv::Mat::zeros(winH+2, winW+2, CV_8UC1); cv::Point2f currPoint = pts[k]; cv::Point2f iterPoint = currPoint; int iterCnt = 0; double err = 0; //迭代 do { a = b = c = bb1 = bb2 = 0; //提取以當前點為中心的視窗子影象(為了方便求sobel微分,視窗各向四個方向擴充套件一行(列)畫素) if ( !getSubImg(srcImg, iterPoint, subImg)) break; uchar *pSubData = (uchar*)subImg.data+winW+3;

//如下計算參考上述推導公式,視窗內累加 for (int i = 0; i < winH; i ++) { for (int j = 0; j < winW; j++) {

//讀取高斯權重值 double m = weightMask.at<float>(i, j);

//sobel運算元求梯度 double sobelx = double(pSubData[i*(winW+2) + j + 1] - pSubData[i*(winW+2) + j - 1]); double sobely = double(pSubData[(i+1)*(winW+2) + j] - pSubData[(i - 1)*(winW+2) + j]); double gxx = sobelx*sobelx*m; double gxy = sobelx*sobely*m; double gyy = sobely*sobely*m; a += gxx; b += gxy; c += gyy; //鄰域畫素p的位置座標 double px = j - winSize.width; double py = i - winSize.height; bb1 += gxx*px + gxy*py; bb2 += gxy*px + gyy*py; } } double det = a*c - b*b; if (fabs(det) <= DBL_EPSILON*DBL_EPSILON) break; //求逆矩陣 double invA = c / det; double invC = a / det; double invB = -b / det; //角點新位置 cv::Point2f newPoint; newPoint.x = (float)(iterPoint.x + invA*bb1 + invB*bb2); newPoint.y = (float)(iterPoint.y + invB*bb1 + invC*bb2); //和上一次迭代之間的誤差 err = (newPoint.x - iterPoint.x)*(newPoint.x - iterPoint.x) + (newPoint.y - iterPoint.y)*(newPoint.y - iterPoint.y); //更新角點位置 iterPoint = newPoint; iterCnt++; if (iterPoint.x < 0 || iterPoint.x >= srcImg.cols || iterPoint.y < 0 || iterPoint.y >= srcImg.rows) break; } while (err > eps && iterCnt < max_iters); //判斷求得的亞畫素角點與初始角點之間的差異,即:最小二乘法的收斂性 if (fabs(iterPoint.x - currPoint.x) > winSize.width || fabs(iterPoint.y - currPoint.y) > winSize.height) iterPoint = currPoint; //儲存算出的亞畫素角點 pts[k] = iterPoint; } }

夜已深,結束。

相關推薦

OpenCV亞畫素角點cornerSubPixel()原始碼分析

上一篇部落格中講到了goodFeatureToTrack()這個API函式能夠獲取影象中的強角點。但是獲取的角點座標是整數,但是通常情況下,角點的真實位置並不一定在整數畫素位置,因此為了獲取更為精確的角點位置座標,需要角點座標達到亞畫素(subPixel)精度。 1. 求取亞畫素精度的原理 找到一篇講

cornerSubPixel亞畫素角點檢測原始碼分析(最小二乘法)

OpenCV的中有cornerSubPixel()這個API函式用來針對初始的整數角點座標進行亞畫素精度的優化,該函式原型如下: C++: void cornerSubPix(InputArray image, InputOutputArray corners, Siz

cv::cornerSubPix()亞畫素角點檢測

轉自https://blog.csdn.net/guduruyu/article/details/69537083 cv::goodFeaturesToTrack()提取到的角點只能達到畫素級別,在很多情況下並不能滿足實際的需求,這時,我們則需要使用cv::cornerSubPix()對檢測到的角點

opencv: 角點檢測原始碼分析;

以下6個函式是opencv有關角點檢測的函式 ConerHarris, cornoerMinEigenVal,CornorEigenValsAndVecs, preConerDetect, conerSubPix, goodFeaturesToTracks, 其中, 前三個都呼叫靜態函式cornerEigen

OpenCV角點檢測原始碼分析(Harris和ShiTomasi角點)

1 #include <opencv2\opencv.hpp> 2 #include <iostream> 3 #include <string> 4 5 using namespace std; 6 7 #define HARRIS

OpenCv-C++-亞畫素級別角點檢測(檢測子畫素中的corner的位置)

使用亞畫素級別角點檢測,返回角點的浮點數值,它的精度比整數畫素更準確。可以用cornerSubPix()函式將角點定位到子畫素,從而取得亞畫素級別的角點檢測效果。 使用函式: void cv::cornerSubPix ( InputArray image, InputOutputArray

opencv亞像素級角點檢測

調用 因此 像素 har mas 使用 精確 tom pix 一般角點檢測: harris cv::cornerHarris() shi-tomasi cv::goodFeaturesToTrack() 亞像素級角點檢測是在一般角點檢測基礎之上將檢測出的角點精確到亞像素

萌新學習手冊:亞畫素級別角點檢測

在現實應用中我們的角點往往並不是整數,所以為了提高我們尋找角點的精確程度,我們需要進行處理,一般有三種方法 1.插值方法 2.基於影象矩計算 3.圖線擬合(高斯曲面,多項式,橢圓曲面)其中高斯曲面最為常用 具體的使用過程就是我們先用Shi-Tomasi角點檢測 把角點

【OpenCV】OpenCV訪問畫素點的三種方式

環境配置 VS2013+OpenCV3.0+Win7(X64) 前言 OpenCV是影象處理最常用的庫之一。它提供了許多常用的影象處理演算法相關的函式,極大地方便了影象處理方法的開發,而影象處理最本質的就是對影象中畫素點的畫素值的運算。

OpenCV實現基於Zernike矩的亞畫素邊緣檢測

在做物體檢測時,由於成本和應用場合的限制,不能夠一味地增加相機的解析度,或者已經用了解析度很高的相機,但是視野範圍很大,仍然無法實現很高的精度,這時就要考慮亞畫素技術,亞畫素技術就是在兩個畫素點之間進行進一步的細分,從而得到亞畫素級別的邊緣點的座標(也就是float

OpenCV訪問畫素點的灰度值

1.Mat矩陣數值的儲存方式 這裡以指標的方式訪問影象素為例 (1)單通道 定義一個單通道影象: cv::Mat img_1 = (320, 640, CV_8UC1, Sca

opencv求畫素總數並進行篩選

vector<Vec4i> hierarchy; vector<vector<Point>> contours; findCont

OpenCV訪問畫素的三種方法

三種方法分別問: 指標訪問:void colorReduce_ptr(cv::Mat &inputImage, cv::Mat &outputImage, int div); 迭代器訪問:void colorReduce_iterator(cv::Mat &input

論文學習 + 論文寫作 | 最前沿的亞畫素運動補償 + 視訊超分辨:Detail-revealing Deep Video Super-resolution

目錄 O. Abstract I. Introduction II. Relative Work III. Sub-pixel Motion Compensation (SPMC) 摘抄本 0. Abstract 1. Introduction 2. Re

OpenCV操作畫素深入理解

在瞭解了影象的基礎知識和OpenCV的基礎知識和操作以後,接下來我們要做的就對畫素進行操作,我們知道了影象的本質就是一個矩陣,那麼一個矩陣中儲存了那麼多的畫素,我們如何來操作呢?下面通過幾個例子來看看畫素的操作。 這個是原圖,接下來的例子都是對這個圖片進行操作的。 訪問畫素出現雪花效果 我們需要有雪

OpenCv-C++-自定義角點檢測器(shi-tomashi自定義)

前面學過了自定義角點檢測器(Harris),現在學習tomasi自定義角點檢測,總體上來說tomasi的程式碼計算量比較harris少,具體步驟跟harris自定義角點檢測類似,主要少了"計算響應"(在部落格自定義角點檢測器(harris自定義)的程式碼註釋裡)的那一步,主要使用corner

OpenCv-C++-自定義角點檢測器(harris自定義)

學習了前面的harris角點檢測之後,現在利用harris原理來自定義角點檢測器,主要使用cornerEigenValsAndVecs()函式。 參考:https://blog.csdn.net/weixin_41695564/article/details/79979784 該函式引數解釋

OpenCv-C++-Shi-Tomasi角點檢測

這次的tomasi跟上次的harris比,兩者原理上很像,可以說tomasi是harris的進化版。個人覺得,如果做角點檢測的話,首選tomasi,因為它優化很好,響應速度比harris快。拖動TrackBar時,真的快如風,但使用harris時,有時還會崩掉。 tomasi基本原理如下:

OpenCV改變畫素顏色

Mat src=imread("image/color.jpg"); imshow("a",src); int i,j; int cPointR,cPointG,cPointB,cPoint;//currentPoint; for(i=1;i<src.rows;i

OpenCV入門:Harris角點檢測

Harris角點檢測 #include <opencv2/opencv.hpp> #include <opencv2/imgproc/imgproc.hpp> using namespace cv; /* Harris角點檢測:void cornerH