ELK + kafka 日誌方案

本文介紹使用ELK(elasticsearch、logstash、kibana) + kafka來搭建一個日誌系統。主要演示使用spring aop進行日誌收集,然後通過kafka將日誌傳送給logstash,logstash再將日誌寫入elasticsearch,這樣elasticsearch就有了日誌資料了,最後,則使用kibana將存放在elasticsearch中的日誌資料顯示出來,並且可以做實時的資料圖表分析等等。

為什麼用ELK

以前不用ELK的做法

最開始我些專案的時候,都習慣用log4j來把日誌寫到log檔案中,後來專案有了高可用的要求,我們就進行了分散式部署web,這樣我們還是用log4j這樣的方式來記錄log的話,那麼就有N臺機子的N個log目錄,這個時候查詢log起來非常麻煩,不知道問題使用者出錯log是寫在哪一臺伺服器上的,後來,想到一個辦法,乾脆把log直接寫到資料庫中去,這樣做,雖然解決了查詢異常資訊便利性的問題了,但存在兩個缺陷:

1,log記錄好多,表不夠用啊,又得分庫分表了,

2,連線db,如果是資料庫異常,那邊log就丟失了,那麼為了解決log丟失的問題,那麼還得先將log寫在本地,然後等db連通了後,再將log同步到db,這樣的處理辦法,感覺是越搞越複雜。

現在ELK的做法

好在現在有了ELK這樣的方案,可以解決以上存在的煩惱,首先是,使用elasticsearch來儲存日誌資訊,對一般系統來說可以理解為可以儲存無限條資料,因為elasticsearch有良好的擴充套件性,然後是有一個logstash,可以把理解為資料介面,為elasticsearch對接外面過來的log資料,它對接的渠道,有kafka,有log檔案,有redis等等,足夠相容N多log形式,最後還有一個部分就是kibana,它主要用來做資料展現,log那麼多資料都存放在elasticsearch中,我們得看看log是什麼樣子的吧,這個kibana就是為了讓我們看log資料的,但還有一個更重要的功能是,可以編輯N種圖表形式,什麼柱狀圖,折線圖等等,來對log資料進行直觀的展現。

ELK職能分工

-

logstash做日誌對接,接受應用系統的log,然後將其寫入到elasticsearch中,logstash可以支援N種log渠道,kafka渠道寫進來的、和log目錄對接的方式、也可以對reids中的log資料進行監控讀取,等等。

-

elasticsearch儲存日誌資料,方便的擴充套件特效,可以儲存足夠多的日誌資料。

-

kibana則是對存放在elasticsearch中的log資料進行:資料展現、報表展現,並且是實時的。

怎樣用ELK

首先說明一點,使用ELK是不需要開發的,只需要搭建環境使用即可。搭建環境,可以理解為,下載XX軟體,然後配置下XX埠啊,XX地址啊,XX日誌轉發規則啊等等,當配置完畢後,然後點選XX bat檔案,然後啟動。

Logstash配置

可以配置接入N多種log渠道,現狀我配置的只是接入kafka渠道。

配置檔案在\logstash-2.3.4\config目錄下

要配置的是如下兩個引數體:

-

input:資料來源。

-

output:資料儲存到哪裡。

input {

kafka {

zk_connect => "127.0.0.1:2181"

topic_id => "mylog_topic"

}

}

filter {

#Only matched data are send to output.

}

output {

#stdout{}

# For detail config for elasticsearch as output,

# See: https://www.elastic.co/guide/en/logstash/current/plugins-outputs-elasticsearch.html

elasticsearch {

action => "index" #The operation on ES

hosts => "127.0.0.1:9200" #ElasticSearch host, can be array.

index => "my_logs" #The index to write data to.

}

}

Elasticsearch配置

配置檔案在\elasticsearch-2.3.3\config目錄下的elasticsearch.yml,可以配置允許訪問的IP地址,埠等,但我這裡是採取預設配置。

Kibana配置

配置檔案在\kibana-4.5.4-windows\config目錄下的kibana.yml,可以配置允許訪問的IP地址,埠等,但我這裡是採取預設配置。

這裡有一個需要注意的配置,就是指定訪問elasticsearch的地址。我這裡是同一臺機子做測試,所以也是採取預設值了。

# The Elasticsearch instance to use for all your queries. # elasticsearch.url: "http://localhost:9200"

關於ELK的配置大致上,就這樣就可以了,當然其實還有N多配置項可供配置的,具體可以google。這裡就不展開說了。

具體的配置請下載執行環境,裡面有具體的配置。

和spring aop日誌對接

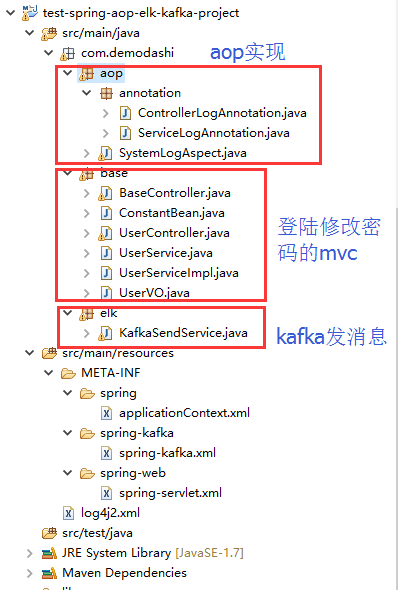

elk環境搭建完畢後,需要在應用系統做日誌的aop實現。

部分spring配置

<aop:aspectj-autoproxy /> <aop:aspectj-autoproxy proxy-target-class="true" /> <!-- 掃描web包,應用Spring的註解 --> <context:component-scan base-package="com.demodashi"> <context:include-filter type="annotation" expression="org.springframework.stereotype.Controller" /> <context:exclude-filter type="annotation" expression="javax.inject.Named" /> <context:exclude-filter type="annotation" expression="javax.inject.Inject" /> </context:component-scan>

部分java程式碼

package com.demodashi.aop.annotation;

import java.lang.annotation.*;

/**

*自定義註解 攔截service

*/

@Target({ElementType.PARAMETER, ElementType.METHOD})

@Retention(RetentionPolicy.RUNTIME)

@Documented

public @interface ServiceLogAnnotation {

String description() default "";

}package com.demodashi.aop.annotation;

import java.lang.annotation.*;

/**

*自定義註解 攔截Controller

*/

@Target({ElementType.PARAMETER, ElementType.METHOD})

@Retention(RetentionPolicy.RUNTIME)

@Documented

public @interface ControllerLogAnnotation {

String description() default "";

}程式碼截圖

日誌和kafka、和logstash、elasticsearch、kibana直接的關係

ELK,kafka、aop之間的關係

1、aop對日誌進行收集,然後通過kafka傳送出去,傳送的時候,指定了topic(在spring配置檔案中配置為 topic="mylog_topic")

2、logstash指定接手topic為 mylog_topic的kafka訊息(在config目錄下的配置檔案中,有一個input的配置)

3、然後logstash還定義了將接收到的kafka訊息,寫入到索引為my_logs的庫中(output中有定義)

4、再在kibana配置中,指定要連線那個elasticsearch(kibana.yml中有配置,預設為本機)

5、最後是訪問kibana,在kibana的控制檯中,設定要訪問elasticsearch中的哪個index。

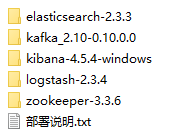

部署ELK + kafka環境

我本機的環境是jdk8.0,我記得測試的過程中,elasticsearch對jdk有特別的要求,必須是jdk7或者以上。

下載執行環境附件,並解壓後,看到如下:

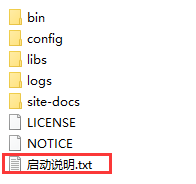

這些執行環境,在每個軟體裡面,都有具體的啟動說明,如kafka的目錄下,這樣:

按照啟動說明的命令來執行,即可啟動。

這裡需要說明一點,最先啟動,應該是zookeeper,然後才是其他的,其他幾個沒有嚴格區分啟動順序。

直接在window下面,同一臺機子啟動即可。除了kibana-4.5.4-windows外,其他幾個也是可以在linux下執行的。

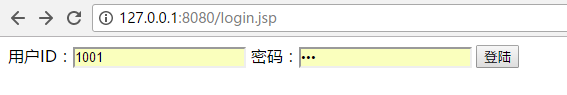

執行效果

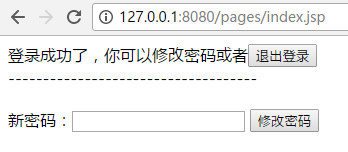

專案匯入到eclipse後,啟動,然後訪問如下地址:

使用者名稱為 1001 密碼為 123

登陸後能看到如下:

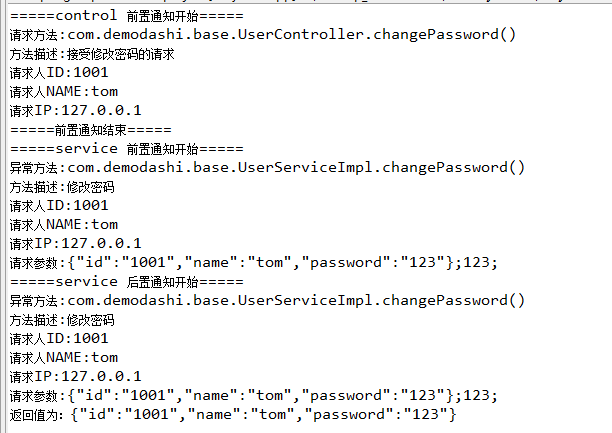

本例子是對修改密碼做了日誌攔截。所以修改密碼的動作,能看到列印如下資訊:

然後是觀察一下aop日誌攔截,是否被kafka傳送給logstash了,是否被寫入了elasticsearch了。

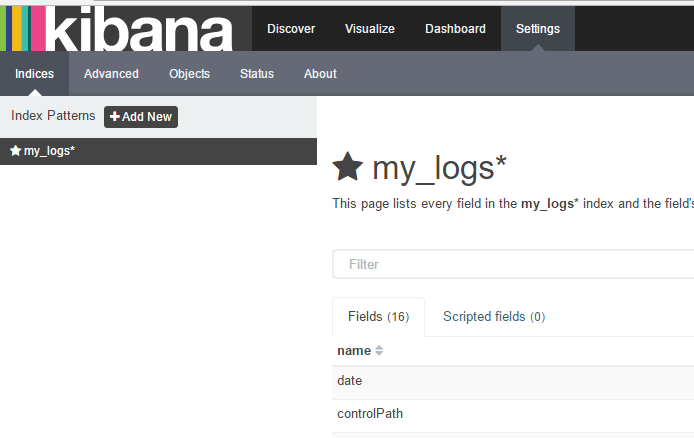

注意觀察我們定義的my_logs這個索引庫是否增加記錄了。

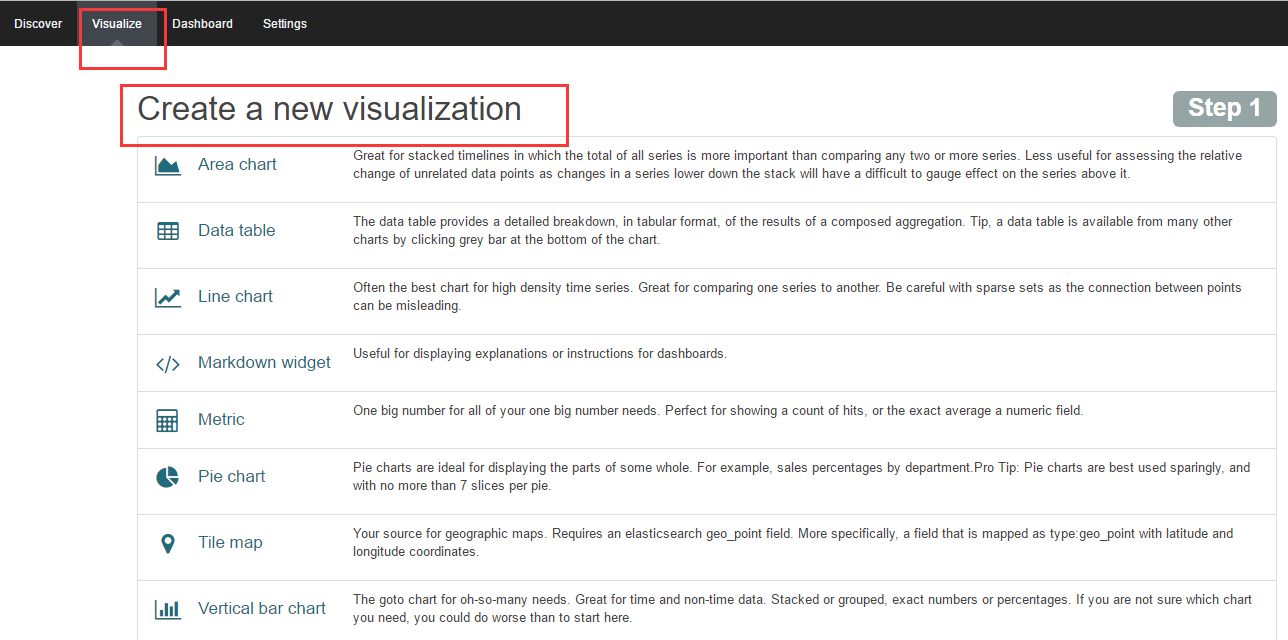

訪問kibana:

在輸入索引名稱後,再點選 create按鈕,即可得到如下介面:

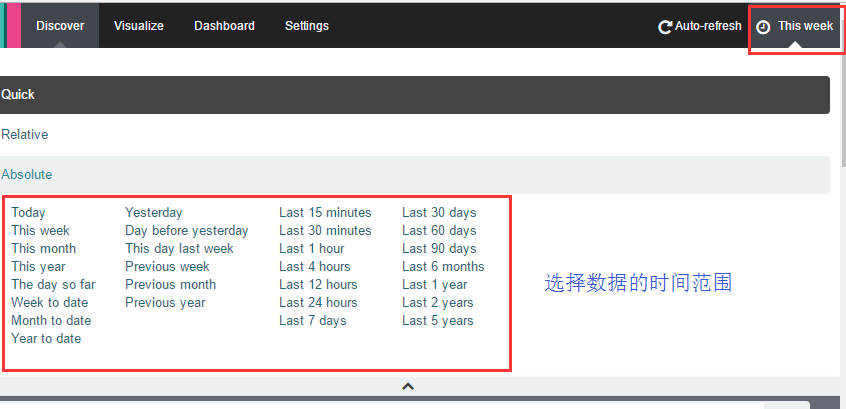

然後再點選Discover,介面如下:

如果你看不到資料,記得點選右上角的按鈕來選擇資料的時間範圍:

到這裡就完成了,日誌的AOP收集,日誌的流轉,並寫入到elasticsearch,並用kibana看資料。

當然kibana還有很重要的一個功能是資料分析圖表的配置,主要是通過嚮導來完成。

高可用實現

現在實現的是一個最基本的日誌收集,日誌傳輸,日誌儲存以及日誌展示的一條鏈路的功能,如果系統上線,還需要做一定的叢集,如kafka叢集,zookeeper叢集,還有elasticsearch叢集

注:本文著作權歸作者,由demo大師(http://www.demodashi.com)宣傳,拒絕轉載,轉載需要作者授權

相關推薦

ELK + kafka 日誌方案

本文介紹使用ELK(elasticsearch、logstash、kibana) + kafka來搭建一個日誌系統。主要演示使用spring aop進行日誌收集,然後通過kafka將日誌傳送給logstash,logstash再將日誌寫入elasticsearch,這樣elasticsearch就有了日誌

利用ELK+Kafka解決方案,搭建企業級實時日誌分析平臺

ELK是三款軟體的組合。是一整套完整的解決方案。分別是由Logstash(收集+分析)、ElasticSearch(搜尋+儲存)、Kibana(視覺化展示)三款軟體。ELK主要是為了在海量的日誌系統裡面實現分散式日誌資料集中式管理和查詢,便於監控以及排查故障。

MDCLog4j+ELK完美日誌方案

LoggerMDCFilter設定MDC引數 @WebFilter(filterName="log",urlPatterns={"/*"}) public class LoggerMDCFilter extends OncePerRequestFilter impleme

ELK+kafka日誌系統搭建-實戰

日誌主要包括系統日誌、應用程式日誌和安全日誌。系統運維和開發人員可以通過日誌瞭解伺服器軟硬體資訊、檢查配置過程中的錯誤及錯誤發生的原因。經常分析日誌可以瞭解伺服器的負荷,效能安全性,從而及時採取措施糾正錯誤。 通常,日誌被分散的儲存不同的裝置上。如果你管理數十上百臺伺服器,你還在使用依次登入每臺機器的

Spring Cloud ELK+kafka日誌分析平臺(二) 優化

Spring Cloud ELK+kafka日誌分析平臺(二)優化 一、概述 在筆者的上一篇部落格介紹了Spring Cloud ELK+kafka日誌分析平臺的搭建,http://xuyangyang.club/articles/2018/05/24/15

ELK搭建實時日誌分析平臺(elk+kafka+metricbeat)-搭建說明

elk搭建實時日誌分析平臺數據流向:metricbeat->kafka->logstash->elasticsearch->kibana.應用分布:主機應用備註192.168.30.121java version "1.8.0_144"zookeeper-3.4.10.tar.gzka

ELK搭建實時日誌分析平臺(elk+kafka+metricbeat)-KAFKA搭建

kafka搭建(elk+kafka+metricbeat)一、kafka搭建建立elk目錄:mkdir /usr/loca/elk安裝zookeeper:192.168.30.121:192.168.30.122:192.168.30.123:3. kafka安裝: a. 192.168.30.121

ELK實時日誌分析平臺(elk+kafka+metricbeat)-logstash(四)

elk-logstash搭建1. 安裝並測試: 2. 添加配置: 3. 啟動檢查:本文出自 “linux” 博客,請務必保留此出處http://1054054.blog.51cto.com/1044054/1968431ELK實時日誌分析平臺(elk+kafka+metricbeat)-logs

ELK+kafka收集 Nginx與tomcat日誌

思路 格式 site npr rip sna proto 是否 tables ELK日誌收集 ELK原理與介紹為什麽用到ELK:一般我們需要進行日誌分析場景:直接在日誌文件中 grep、awk 就可以獲得自己想要的信息。但在規模較大的場景中,此方法效率低下,面臨問題包括

Kafka+Zookeeper+Filebeat+ELK 搭建日誌收集系統

could not arch success div 名稱 fill pil ice oca ELK ELK目前主流的一種日誌系統,過多的就不多介紹了 Filebeat收集日誌,將收集的日誌輸出到kafka,避免網絡問題丟失信息 kafka接收到日誌消息後直接消費到Lo

windows下kafka+ELK的日誌系統

用到的軟體:zookeeper、kafka、logstash(6.3.2版本)、ES(6.3.2版本)、Kibana(6.3.2版本)。具體安裝步驟不在此說明,基本都是下載解壓,改一下配置檔案,即可使用。(以下所述均在Windows下)1、zookeeper:kafka中自帶zookeeper,可以不用裝zo

ELK+kafka構建日誌收集系統

背景: 最近線上上了ELK,但是隻用了一臺Redis在中間作為訊息佇列,以減輕前端es叢集的壓力,Redis的叢集解決方案暫時沒有接觸過,並且Redis作為訊息佇列並不是它的強項;所以最近將Redis換成了專業的訊息資訊釋出訂閱系統Kafka, Kafka的更多介紹大家可以看這裡: 傳

ELK-filebeat+kafka日誌收集

環境 centos6.9 ELK5.6 所有節點都是單點非叢集 filebeat:10.99.2.16 elk:10.99.2.17 kafka:10.99.2.23 官方文件 es安裝 yum安裝java環境和es: yum install el

elk+kafka 分散式日誌採集系統設計

Filebeat (每個微服務啟動一個)--->Kafka叢集--->Logstash(one)-->Elasticsearch叢集 一、資料流從檔案端到Kafka 叢集端,通過Filebeat 1.下載 Filebeat #cd /opt/filebeat

基於Heka+Flume+Kafka+ELK的日誌系統

前期準備 系統是centos6.6,64位機器。 所用軟體版本: Logstash:2.3.3 JDK:1.8.0_25 Elasticsearch:2.3.4 Kibana:4.5.2 Heka:0.10.0 Flume:1.7.0 Zookeeper:3.4

centos7搭建ELK Cluster日誌分析平臺(一)

場景 git centos7 beat images 下載地址 install posit src 應用場景:ELK實際上是三個工具的集合,ElasticSearch + Logstash + Kibana,這三個工具組合形成了一套實用、易用的監控架構, 很多公司

mysql 第三十六篇文章~mysql慢日誌方案解讀1

日誌 iges add 代碼 bytes 周期 缺省 port 同學 一 慢日誌的相關參數 long_query_time : 設定慢查詢的閥值,超出次設定值的SQL即被記錄到慢查詢日誌,缺省值為1s log_slow_queries :1/0

KAFKA日誌管理

kafka日誌管理kafka啟動後,會產生會多日誌,經常會將磁盤撐爆。所以kafka日誌清理很有必要log4j.properties該文件為kafka日誌管理的配置文件,位於$KAFKA_HOME/config/log4j.properties默認該配置文件中日誌存放路徑為$KAFKA_HOME/logs,可

Centos7下ELK+Redis日誌分析平臺的集群環境部署記錄

fire systemctl 系統 gpgcheck poc dt.jar 添加 大致 路徑 之前的文檔介紹了ELK的架構基礎知識,下面簡單記錄下ELK結合Redis搭建日誌分析平臺的集群環境部署過程,大致的架構如下: + Elasticsearch是一個分布式搜索分

簡單安裝ELK分析日誌及使用心得

ELKELK是由Elasticsearch、Logstash、Kibana三個組件組成的。Elasticsearch:是ELK的核心插件,是一個基於Lucene的搜索服務器,它提供一個分布式多用戶能力的全文搜索引擎,能夠達到實時搜索,穩定,可靠,快速,安裝方便。Elasticsearch服務會開啟兩個端口,9