修改kafka的分割槽和副本設定

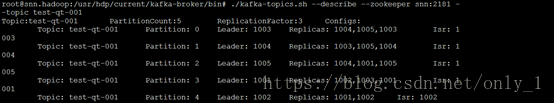

1. 檢視topic的描述

#./kafka-topics.sh --describe --zookeeper snn:2181 --topictest-qt-001

2. 執行

./kafka-reassign-partitions.sh --zookeeper snn:2181--reassignment-json-file partitions-to-move.json –execute

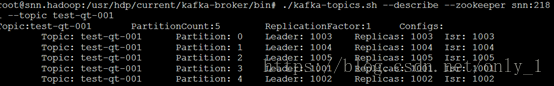

3. 檢視

./kafka-topics.sh --describe --zookeeper snn:2181 --topictest-qt-001