centos7 使用二進位制包搭建kubernetes 1.9.0叢集

kubernetes 發展速度非常,至少在目前來說是非常不錯的,很多大公司都在使用容器技術部署專案,而最近比較火的容器管理工具就是kubernetes了。

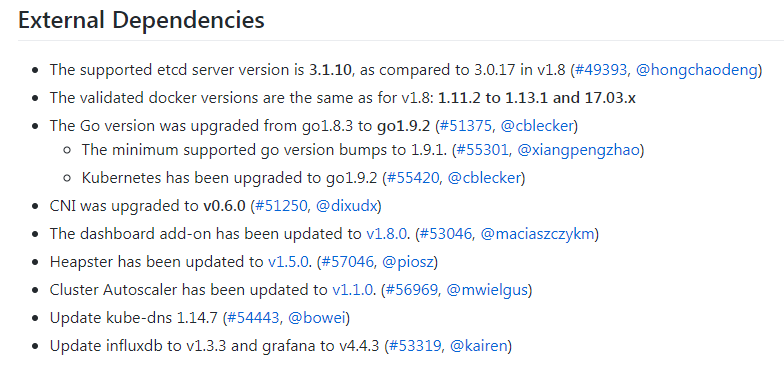

由於之前公司一直使用的還是yum安裝的v1.5.2,因為沒什麼大的需求就一直沒有更新到新版本,這次出來的1.9.0版本。聽說功能更強大,所以就自己機器上搭建一個小群集來測試。因為網上還沒有build好的rpm包,原本自己打算製作一個的,但是技術資訊有限暫時未能做出來。可是又很想使用新版本,所以直接在網官上下載一個二進位制的tar包來。

系統:CentOS Linux release 7.2.1511 (Core)

核心可以升級,如果不升級也可以執行,但是會在日誌裡有提示。

- ########################################################

- 節點名 主機名 IP地址

- etcd etcd 10.0.10.11

- k8s-master k8s-master 10.0.10.12

- k8s-node1 k8s-node1 10.0.10.13

- k8s-node2 k8s-node2 10.0.10.14

機器之間做好時間同步:

- yum install ntpd -y

- systemctl start ntpd

- systemctl enable ntpd

新增主機名IP地址的對應解析到/etc/hosts檔案:

- [[email protected] system]# tail -5 /etc/hosts

- 192.168.18.54 reg.docker.tb

- 10.0.10.11 etcd

- 10.0.10.12 k8s-master

- 10.0.10.13 k8s-node1

- 10.0.10.14 k8s-node2

並在Master節點上做一個ssh-key免密登陸,傳到每個節點上,和etcd機器。

軟體包下載地址:

etcd:https://github.com/coreos/etcd/releases/download/v3.2.11/etcd-v3.2.11-linux-amd64.tar.gz

kubernetes: https://codeload.github.com/kubernetes/kubernetes/tar.gz/v1.9.0

配置Etcd伺服器

- tar xf etcd-v3.2.11-linux-amd64.tar.gz

- cd etcd-v3.2.11-linux-amd64

- cp etcd etcdctl /usr/bin/

新增使用者和組,這裡的組ID和使用者ID可以不用指定

- [[email protected] system]# groupadd -g 990 etcd

- [[email protected] system]# useradd -s /sbin/nologin -M -c "etcd user" -u 991 etcd -g etcd

- [[email protected] system]# id etcd

- uid=991(etcd) gid=990(etcd) groups=990(etcd)

建立啟動檔案:/usr/lib/systemd/system/etcd.service

- [Unit]

- Description=Etcd Server

- After=network.target

- After=network-online.target

- Wants=network-online.target

- [Service]

- Type=notify

- WorkingDirectory=/var/lib/etcd/

- EnvironmentFile=-/etc/etcd/etcd.conf

- User=etcd

- # set GOMAXPROCS to number of processors

- ExecStart=/bin/bash -c "GOMAXPROCS=$(nproc) /usr/bin/etcd --name=\"${ETCD_NAME}\" --data-dir=\"${ETCD_DATA_DIR}\" --listen-client-urls=\"${ETCD_LISTEN_CLIENT_URLS}\""

- Restart=on-failure

- LimitNOFILE=65536

- [Install]

- WantedBy=multi-user.target

建立啟動檔案中用到的目錄,這個是根據rpm包的思路操作:

- mkdir -p /etc/etcd

- mkdir -p /var/lib/etcd

- chown -R etcd.etcd /var/lib/etcd

啟動服務,並檢查狀態:

- systemctl start etcd

- systemctl enable etcd

- #檢查健康狀態:

- [[email protected] system]# etcdctl -C http://etcd:2379 cluster-health

- member 8e9e05c52164694d is healthy: got healthy result from http://10.0.10.11:2379

- cluster is healthy

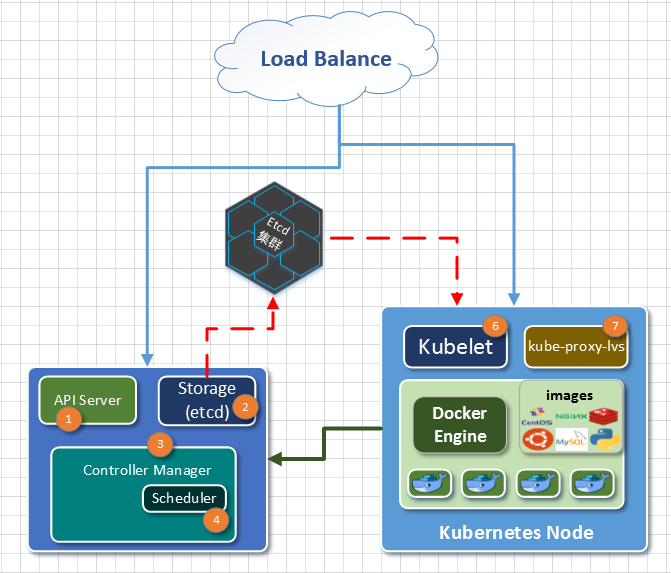

配置Master節點:

Master節點上只需要執行這幾個服務:apiserver、controller-manager、scheduler

直接解壓檔案並複製到系統路徑下,如果不這樣做就新增環境變數 。

- tar xf kubernetes-server-linux-amd64.tar.gz

- cd kubernetes/server/bin

- 複製執行檔案到/usr/bin目錄下:

- find ./ -perm 750|xargs chmod 755

- find ./ -perm 750|xargs -i cp {} /usr/bin/

查檢kubernetes版本:

- [[email protected] bin]# kubectl version

- Client Version: version.Info{Major:"1", Minor:"9", GitVersion:"v1.9.0", GitCommit:"925c127ec6b946659ad0fd596fa959be43f0cc05", GitTreeState:"clean", BuildDate:"2017-12-15T21:07:38Z", GoVersion:"go1.9.2", Compiler:"gc", Platform:"linux/amd64"}

- The connection to the server localhost:8080 was refused - did you specify the right host or port?

把下面幾個啟動檔案新增到系統以下目錄下:/usr/lib/systemd/system/

啟動檔案:kube-apiserver.service

- [Unit]

- Description=Kubernetes API Server

- Documentation=https://github.com/GoogleCloudPlatform/kubernetes

- After=network.target

- After=etcd.service

- [Service]

- EnvironmentFile=-/etc/kubernetes/config

- EnvironmentFile=-/etc/kubernetes/apiserver

- User=kube

- ExecStart=/usr/bin/kube-apiserver \

- $KUBE_LOGTOSTDERR \

- $KUBE_LOG_LEVEL \

- $KUBE_ETCD_SERVERS \

- $KUBE_API_ADDRESS \

- $KUBE_API_PORT \

- $KUBELET_PORT \

- $KUBE_ALLOW_PRIV \

- $KUBE_SERVICE_ADDRESSES \

- $KUBE_ADMISSION_CONTROL \

- $KUBE_API_ARGS

- Restart=on-failure

- Type=notify

- LimitNOFILE=65536

- [Install]

- WantedBy=multi-user.target

啟動檔案:kube-controller-manager.service

- kube-controller-manager.service

- [Unit]

- Description=Kubernetes Controller Manager

- Documentation=https://github.com/GoogleCloudPlatform/kubernetes

- [Service]

- EnvironmentFile=-/etc/kubernetes/config

- EnvironmentFile=-/etc/kubernetes/controller-manager

- User=kube

- ExecStart=/usr/bin/kube-controller-manager \

- $KUBE_LOGTOSTDERR \

- $KUBE_LOG_LEVEL \

- $KUBE_MASTER \

- $KUBE_CONTROLLER_MANAGER_ARGS

- Restart=on-failure

- LimitNOFILE=65536

- [Install]

- WantedBy=multi-user.target

啟動檔案:kube-scheduler.service

- [Unit]

- Description=Kubernetes Scheduler Plugin

- Documentation=https://github.com/GoogleCloudPlatform/kubernetes

- [Service]

- EnvironmentFile=-/etc/kubernetes/config

- EnvironmentFile=-/etc/kubernetes/scheduler

- User=kube

- ExecStart=/usr/bin/kube-scheduler \

- $KUBE_LOGTOSTDERR \

- $KUBE_LOG_LEVEL \

- $KUBE_MASTER \

- $KUBE_SCHEDULER_ARGS

- Restart=on-failure

- LimitNOFILE=65536

- [Install]

- WantedBy=multi-user.target

新增使用者和組:只要系統ID不存在的就可以了

- groupadd -g 992 kube

- useradd -s /sbin/nologin -M -c "kube user" -u 996 kube -g kube

建立相應的目錄,並授權許可權:

- mkdir -p /etc/kubernetes

- #mkdir -p /var/run/kubernetes

- mkdir -p /usr/libexec/kubernetes

- #chown -R kube.kube /var/run/kubernetes/ #被下面的方法替換了

- chown -R kube.kube /usr/libexec/kubernetes

2018-02-01補充:由於kube-apiserver啟動的時候會在/var/run/kubernetes下自動建立apiserver.crt 和apiserver.key兩個檔案,因為此目錄預設不存在的而上面手工建立後,Node節點重啟過系統 的話就要丟失,導致kube-apiserver啟動失敗,日誌如下:

- Feb 1 08:45:58 k8s-master kube-apiserver: error creating self-signed certificates: mkdir /var/run/kubernetes: permission denied

所以解決方法就是:進入/usr/lib/tmpfiles.d/建立一個配置檔案,這裡檔案會在系統啟動的時候自動執行。

- [[email protected] ~]# cd /usr/lib/tmpfiles.d/

- [[email protected] tmpfiles.d]# cat kubernetes.conf

- d /var/run/kubernetes 0755 kube kube -

啟動服務:

- for service in kube-apiserver kube-controller-manager kube-scheduler;do systemctl restart $service && systemctl enable $service ;done

Node節點安裝

node節點上跑的服務就這 幾個:kubelet,kube-proxy

直接把master上的幾個執行檔案傳到Node節點的/usr/bin目錄下:

- scp kube-proxy kubelet k8s-node1:/usr/bin/

- scp kube-proxy kubelet k8s-node2:/usr/bin/

新增使用者和組:只要系統不存在的就可以了

- groupadd -g 992 kube

- useradd -s /sbin/nologin -M -c "kube user" -u 996 kube -g kube

建立相應的目錄:

- mkdir -p /etc/kubernetes

- mkdir -p /var/run/kubernetes

- chown -R kube.kube /var/run/kubernetes/

- mkdir -p /var/lib/kubelet

- chown -R kube.kube /var/lib/kubelet

- mkdir -p /usr/libexec/kubernetes

- chown -R kube.kube /usr/libexec/kubernetes

新增啟動檔案:kubelet.service

- [Unit]

- Description=Kubernetes Kubelet Server

- Documentation=https://github.com/GoogleCloudPlatform/kubernetes

- After=docker.service

- Requires=docker.service

- [Service]

- WorkingDirectory=/var/lib/kubelet

- EnvironmentFile=-/etc/kubernetes/config

- EnvironmentFile=-/etc/kubernetes/kubelet

- ExecStart=/usr/bin/kubelet \

- $KUBE_LOGTOSTDERR \

- $KUBE_LOG_LEVEL \

- $KUBELET_API_SERVER \

- $KUBELET_ADDRESS \

- $KUBELET_PORT \

- $KUBELET_HOSTNAME \

- $KUBE_ALLOW_PRIV \

- $KUBELET_POD_INFRA_CONTAINER \

- $KUBELET_ARGS

- Restart=on-failure

- [Install]

- WantedBy=multi-user.target

新增啟動檔案:kube-proxy.service

- [Unit]

- Description=Kubernetes Kube-Proxy Server

- Documentation=https://github.com/GoogleCloudPlatform/kubernetes

- After=network.target

- [Service]

- EnvironmentFile=-/etc/kubernetes/config

- EnvironmentFile=-/etc/kubernetes/proxy

- ExecStart=/usr/bin/kube-proxy \

- $KUBE_LOGTOSTDERR \

- $KUBE_LOG_LEVEL \

- $KUBE_MASTER \

- $KUBE_PROXY_ARGS

- Restart=on-failure

- LimitNOFILE=65536

- [Install]

- WantedBy=multi-user.target

新增配置檔案到/etc/kubernetes目錄下:

config

- [[email protected] kubernetes]# egrep -v "^$|^#" config

- KUBE_LOGTOSTDERR="--logtostderr=true"

- KUBE_LOG_LEVEL="--v=0"

- KUBE_ALLOW_PRIV="--allow-privileged=false"

- KUBE_MASTER="--master=http://k8s-master:8080"

proxy,沒什麼內容,但是要檔案存在。

- [[email protected] kubernetes]# egrep -v "^$|^#" proxy

- KUBE_PROXY_ARGS=""

kubelet

- [[email protected] kubernetes]# egrep -v "^$|^#" kubelet

- KUBELET_HOSTNAME="--hostname-override=k8s-node2"

- KUBELET_POD_INFRA_CONTAINER="--pod-infra-container-image=reg.docker.tb/harbor/pod-infrastructure:latest"

- KUBELET_ARGS="--enable-server=true --enable-debugging-handlers=true --fail-s

- wap-on=false --kubeconfig=/var/lib/kubelet/kubeconfig"

這裡需要注意的,如果機器開啟了swap分割槽的話,kubernetes會無法啟動,需要關閉。

然後還要新增一個配置檔案,因為1.9.0在kubelet裡不再使用KUBELET_API_SERVER來跟API通訊,而是通過別一個yaml的配置來實現。

- [[email protected] kubernetes]# cat /var/lib/kubelet/kubeconfig

- apiVersion: v1

- kind: Config

- users:

- - name: kubelet

- clusters:

- - name: kubernetes

- cluster:

- server: http://k8s-master:8080

- contexts:

- - context:

- cluster: kubernetes

- user: kubelet

- name: service-account-context

- current-context: service-account-context

新增後注意授權,不然會報沒許可權:

- chown -R kube.kube /var/lib/kubelet/

Node節點上安裝docker-1.12.6

- 安裝epel源:

- rpm -Uvh https://dl.fedoraproject.org/pub/epel/epel-release-latest-7.noarch.rpm

- yum install docker -y

修改docker的配置檔案,加入私有倉庫:/etc/sysconfig/docker

- INSECURE_REGISTRY="--insecure-registry reg.docker.tb"

因為docker預設使用的

這裡只要修改docker跟kubernetes一樣即可。/usr/lib/systemd/system/docker.service

- --exec-opt native.cgroupdriver=cgroupfs \

啟動docker服務,登陸驗證:

- 啟動docker服務,登陸驗證:

- [[email protected] kubernetes]# docker login reg.docker.tb

- Username : upload

- Password:

- Login Succeeded

- [[email protected] kubernetes]# ll /root/.docker/config.json

- -rw------- 1 root root 154 Jan 30 17:29 /root/.docker/config.json

啟動kubelet 、kube-proxy服務

- for service in kube-proxy kubelet docker;do systemctl start $service && systemctl enable $service;done

Node節點上啟動時遇到的問題:

error: failed to run Kubelet: failed to create kubelet: misconfiguration: kubelet cgroup driver: "cgroupfs" is different from docker cgroup driver: "systemd"

解決方法就是使用上面的kubelet配置:

- Environment="KUBELET_KUBECONFIG_ARGS=--kubeconfig=/etc/kubernetes/kubelet.conf --require-kubeconfig=true --cgroup-driver=systemd"

這是因為docker 使用的cgroup-driver跟kubernetes的不一樣,所以就會報異常。

異常提示: factory.go:340] devicemapper filesystem stats will not be reported: RHEL/Centos 7.x kernel version 3.10.0-366 or later is required to use thin_ls - you have "3.10.0-327.el7.x86_64"

k8s 1.9.0版本在使用核心方面要求3.10.366以上,如果要升級核心可以使用以下方法:

rpm -Uvh http://www.elrepo.org/elrepo-release-7.0-2.el7.elrepo.noarch.rpm;yum --enablerepo=elrepo-kernel install kernel-lt-devel kernel-lt -y

安裝完後可以檢視是否預設為新的核心:- [[email protected] kubernetes]# egrep ^menu /etc/grub2.cfg|cut -f 2 -d \'

- CentOS Linux (4.4.113-1.el7.elrepo.x86_64) 7 (Core)

- CentOS Linux (3.10.0-327.el7.x86_64) 7 (Core)

- CentOS Linux (0-rescue-8a1328ef9a7247f09fe7bedb9a9d95c0) 7 (Core)

- grub2-set-default 'CentOS Linux (4.4.113-1.el7.elrepo.x86_64) 7 (Core)'

- 返回以下結果說明跟etcd的通訊正常:

- [[email protected] system]# kubectl get cs

- NAME STATUS MESSAGE ERROR

- scheduler Healthy ok

- controller-manager Healthy ok

- etcd-0 Healthy {"health": "true"}

- 返回以下結果說明兩個Node節點跟Master,etcd通訊正常,因為節點上的配置資訊資料都是儲存在etcd服務上的。

- [[email protected] system]# kubectl get node

- NAME STATUS ROLES AGE VERSION

- k8s-node1 Ready <none> 5h v1.9.0

- k8s-node2 Ready <none> 5h v1.9.0

- apiVersion: v1

- kind: ReplicationController

- metadata:

- name: nginx-rc

- spec:

- replicas: 2

- selector:

- app: nginx

- template:

- metadata:

- labels:

- app: nginx

- spec:

- containers:

- - name: nginx

- image: reg.docker.tb/harbor/nginx

- ports:

- - containerPort: 80

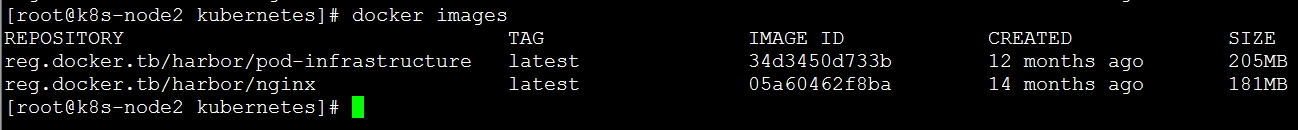

第一個就是pod基礎包,我把它下載回來並打上tag上傳到自己的倉庫裡了。

在master節點上可以看到剛才建立的rc共建立兩個容器,現在已經啟動了一個,因為我使用的筆記本走wifi比較慢。

第一個就是pod基礎包,我把它下載回來並打上tag上傳到自己的倉庫裡了。

在master節點上可以看到剛才建立的rc共建立兩個容器,現在已經啟動了一個,因為我使用的筆記本走wifi比較慢。

- [[email protected] yaml]# kubectl get po

- NAME READY STATUS RESTARTS AGE

- nginx-rc-74s85 1/1 Running 0 8m

- nginx-rc-kc5tx 0/1 ContainerCreating 0 8m

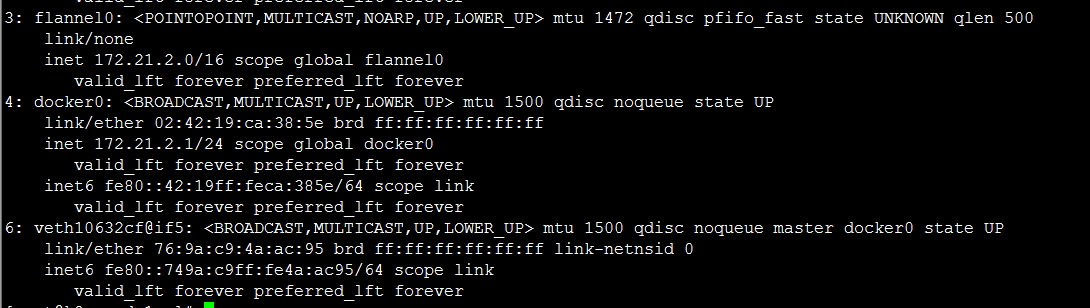

安裝flannel網路外掛

首先在etcd伺服器上新增一個網路配置,這個網路配置自己隨意只要在flannl的配置裡一樣即可。

- etcdctl set /atomic.io/network/config '{ "Network": "172.21.0.0/16" }'

為了 方便管理,在Master節點上也安裝上flannl外掛,就是除了這個etcd伺服器上不安裝,其它的都安裝上。

下載地址:https://github.com/coreos/flannel/releases/download/v0.9.0/flannel-v0.9.0-linux-amd64.tar.gz

- tar xf flannel-v0.9.0-linux-amd64.tar.gz

- 傳到每個機器上:

- scp flanneld k8s-node1:/usr/bin/

- scp flanneld k8s-node2:/usr/bin/

- #每個機器上建立一個目錄:

- mkdir -p /usr/libexec/flannel

- scp mk-docker-opts.sh k8s-node1:/usr/libexec/flannel

- scp mk-docker-opts.sh k8s-node2:/usr/libexec/flannel

新增一個啟動檔案:要看啟動檔案中的目錄,如果不存在就建立,並授權。

- [Unit]

- Description=Flanneld overlay address etcd agent

- After=network.target

- After=network-online.target

- Wants=network-online.target

- After=etcd.service

- Before=docker.service

- [Service]

- Type=notify

- EnvironmentFile=/etc/sysconfig/flanneld

- EnvironmentFile=-/etc/sysconfig/docker-network

- ExecStart=/usr/bin/flanneld-start $FLANNEL_OPTIONS

- ExecStartPost=/usr/libexec/flannel/mk-docker-opts.sh -k DOCKER_NETWORK_OPTIONS -d /run/flannel/docker

- Restart=on-failure

- [Install]

- WantedBy=multi-user.target

- RequiredBy=docker.service

還要手工添加個shell檔案:flanneld-start

- #!/bin/sh

- exec /usr/bin/flanneld \

- -etcd-endpoints=${FLANNEL_ETCD_ENDPOINTS:-${FLANNEL_ETCD}} \

- -etcd-prefix=${FLANNEL_ETCD_PREFIX:-${FLANNEL_ETCD_KEY}} \

- "[email protected]"

需要可執行許可權:

- chmod 755 /usr/bin/flanneld-start

然後啟動服務。

再嘗試一個下效果:新增一個srevice.yaml

- apiVersion: v1

- kind: Service

- metadata:

- name: nginx-service

- spec:

- type: NodePort

- ports:

- - port: 8000

- targetPort: 80

- protocol: TCP

- selector:

- app: nginx

這裡可以看到type型別為NodePort,就是這個31603埠會在每個容器執行的宿主機上對映一個對外的埠,通過宿主機IP和埠即可訪問上面建立的nginx服務。

- [[email protected] yaml]# kubectl get service

- NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

- kubernetes ClusterIP 10.254.0.1 <none> 443/TCP 1d

- nginx-service NodePort 10.254.72.166 <none> 8000:31603/TCP 37m

- [[email protected] yaml]# kubectl get po -o wide

- NAME READY STATUS RESTARTS AGE IP NODE

- nginx-rc-r6cnh 1/1 Running 0 45m 172.21.8.2 k8s-node2

- nginx-rc-wp2hk 1/1 Running 0 45m 172.21.2.2 k8s-node1

而CLUSTER-IP就是叢集的IP入口,但是它只允許有容器執行在叢集內的宿主機連線。

相關推薦

centos7 使用二進位制包搭建kubernetes 1.9.0叢集

kubernetes 發展速度非常,至少在目前來說是非常不錯的,很多大公司都在使用容器技術部署專案,而最近比較火的容器管理工具就是kubernetes了。 由於之前公司一直使用的還是yum安裝的v1.5.2,因為沒什麼大的需求就一直沒有更新到新版本,這次出來的1.9.0版本

Kubernetes 1.9.0 alpha.1 版本釋出_Kubernetes中文社群

在2天前,Kubernetes社群同時釋出了兩個版本的kubernetes,1.8.0 rc.1版本和 1.9.0-alpha.1 版本,k8s 1.9.0 也是首次釋出,從 v1.8.0-alpha.3 版本以來更新完善了眾多功能,共提交了279次。相關更新如下: 使用cluster/k

Kubernetes | 學習教程 (一)Kubernetes 1.9.0 離線安裝教程

為了讓產品在迎來業務量爆發式增長前完成應對措施,在瀏覽無數的資料後,決定將服務逐漸進行容器化,最終能達到容器叢集的效果。而容器叢集的解決方案中,kubernetes(簡稱k8s)看起來是個可行的方案。我目前的理解是,k8s就是docker容器叢集的一個管理系統,有很多實用功能

使用Kubeadm搭建Kubernetes(1.12.2)叢集

Kubeadm是Kubernetes官方提供的用於快速安裝Kubernetes叢集的工具,伴隨Kubernetes每個版本的釋出都會同步更新,在2018年將進入GA狀態,說明離生產環境中使用的距離越來越近了。 使用Kubeadm搭建Kubernetes叢集本來是件很簡單的事,但由於眾所周知的原因,在中國大陸

K8S 1.9.0二進制包部署(三)

無法 emc mod tps -o cal text tor amd 4、k8s node#############kubelet cp kubelet /usr/bin/chmod 755 /usr/bin/kubeletmkdir -p /app/kubernetes/

K8S 1.9.0二進制包部署(五)

alt ces map ima config -c tex sta ffffff 6、dashboard v1.8.0在kubernetes目錄下有src的壓縮包,解壓後在cluster/addons/dashboard 下有5個文件dashboard-controller

K8S 1.9.0二進制包部署(四)

ble forward term ecs core bus des usr ets 5、flannel cp flanneld /usr/bin/chmod 755 /usr/bin/flanneldmkdir -p /app/flannel/conf/ vi /usr/l

ubuntu18.04 flink-1.9.0 Standalone叢集搭建

叢集規劃 Master JobManager Standby JobManager Task Manager Zookeeper flink01 √ √ flink02 √ √ flink03 √ √ √ flink04 √ √ √ 前置準備 克隆4臺虛擬機器

k8s 1.9.0-手動安裝-2

none working ole pac value kill swap port sch 1 下載etcd新版 https://github.com/coreos/etcd/releases 直接下載k8s的二進制包 https://github.com/kubernet

Kubernetes 1.9集群使用traefik發布服務

k8s rbac traefik deployment 在前文中介紹了在kubernetes 1.5.2集群環境中使用traefik進行服務發布。Traefik采用daemonset方式部署,連接api-server走的是http協議,也未配置rbac。本文將介紹在k8s 1.9版本中使用de

Kubadem方式安裝Kubernetes(1.10.0)集群

k8s 部署 背景 kubernetes已經是現有的docker容器管理工具中必學的一個架構了,相對與swarm來說,它的架構更重,組件和配置也更復雜,當然了,提供的功能也更加強大。在這裏,k8s的基本概念和架構就不描述了,網上有很多的資料可供參考。 在技術的驅使下,我們公司也不可

Kubernetes 1.10.0離線安裝

mkfs.ext4 _for amd64 fir fdisk -l chown 部分 strong get 講述如何通過離線的方式安裝Kubernetes,主要用於對Kubernetes的研究學習,不建議在生產環境使用,安裝包獲取地址: 鏈接:https://

centos7使用kubeadm安裝kubernetes 1.11版本多主高可用

ips refresh www ember issues abi dash iyu let centos7使用kubeadm安裝kubernetes 1.11版本多主高可用 [TOC] kubernetes介紹要學習一個新的東西,先了解它是什麽,熟悉基本概念會有很大幫助。以

使用 kubeadm 安裝部署 kubernetes 1.9-部署heapster插件

master aml con inf uber kubectl net raw 重新 1.先到外網下載好鏡像倒進各個節點 2.下載yaml文件和創建應用 mkdir -p ~/k8s/heapster cd ~/k8s/heapster wget https://raw.

Windows 10 下載CUDA9.2 + cuDNNv7.2.1 + tensorflow-gpu 1.9.0

CUDA安裝 根據官網描述在下載CUDA之前請確保: GPU型號相容 支援的Windows版本 支援的Microsoft Visual Studio版本 cuda下載地址:http://developer.nvidia.com/cuda-downloa

轉 centos7使用kubeadm安裝kubernetes 1.12版本

最近在學習go 模板語法 還是有點小忙 ! 感覺寫這種 kuberadm 搭建 kubernetes 還是有點水 好吧 可能我太高調了 前前後後搭過四 五次了 ! kuber

《從0到1學習Flink》—— Mac 上搭建 Flink 1.6.0 環境並構建執行簡單程式入門

準備工作 1、安裝檢視 Java 的版本號,推薦使用 Java 8。 安裝 Flink 2、在 Mac OS X 上安裝 Flink 是非常方便的。推薦通過 homebrew 來安裝。 brew install apache-flink 複製程式碼 3、檢查安裝: flink --

centos7.5版本安裝nginx.1.14.0時需要安裝的依賴

這是我所使用的linux版本7.5的,建議大家在虛擬機器中安裝好linux之後快照備份一下 安裝好系統後想要安裝lnmp環境,先安裝nginx 我下的nginx的tar包是nginx-1.14.0這個版本 參考朋友寫的nginx原始碼安裝文章安裝nginx https://no

【原始碼】魔方模擬器與求解器version 1.9.0.0

本程式能夠產生一個任意尺寸的隨機打亂的立方體,可以通過手動操作或者由計算機求解進行魔方復原。 This program allows you to generate arandomly scramble cube of arbitrary dimension which can t

centos7使用kubeadm安裝kubernetes 1.11版本多主高可用_Kubernetes中文社群

大佬,你好,照著這個方法搭建的成功後,卻無法使用heapster監控,部署後報錯heapster容器報錯 I0816 10:04:59.743015 1 heapster.go:72] /heapster –source=kubernetes:https://kubernetes.default