自從會了Python在群裏鬥圖就沒輸過,Python批量下載表情包!

導語

最近圖慌,於是隨便寫了個表情包批量下載的腳本,沒什麽技術含量,純娛樂性質。

讓我們愉快地開始吧~

開發工具

Python版本:3.6.4

相關模塊:

requests模塊;

fake_useragent模塊;

以及一些Python自帶的模塊。

環境搭建

安裝Python並添加到環境變量,pip安裝需要的相關模塊即可。

原理簡介

爬的站長之家的表情包,鏈接:

http://sc.chinaz.com/biaoqing/index.html

非常好爬,思路也很簡單:

① 獲得表情包所在地址;

② 根據表情包所在地址,獲得表情所在地址;

③ 根據表情所在地址下載表情。

具體實現過程詳見相關文件中的源代碼。

或許很多人都發現了,爬蟲相關的文章我都是輕描淡寫地說下主要思路然後讓大家自己看源碼的,一方面是我懶得寫,另一方面是爬蟲代碼的存活時間不長,換句話說就是你花了很多時間寫的文章過幾個月甚至過幾天可能就“沒用”了。

不過今天我打算隨手總結一下普通的反爬蟲機制有哪些內容:

(1)驗證碼

(2)Header檢驗

即檢查HTTP請求的Headers信息,一般包括:

User-Agent(UA);Referer;Cookies等。

User-Agent:

當前用戶使用的客戶端種類和版本;

Referer:

請求是從哪裏來的;

Cookie:

有時候網站會檢測Cookie中session_id的使用次數,顯然當次數過多時,當前用戶會被認為是爬蟲。

(3)IP請求速度檢驗

當某個IP的請求速度過快時,就會觸發該網站的反爬機制。

(4)動態加載

ajax動態加載網頁內容。

That‘s all.

運行截圖

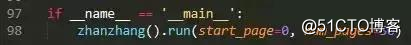

指定爬取的範圍:

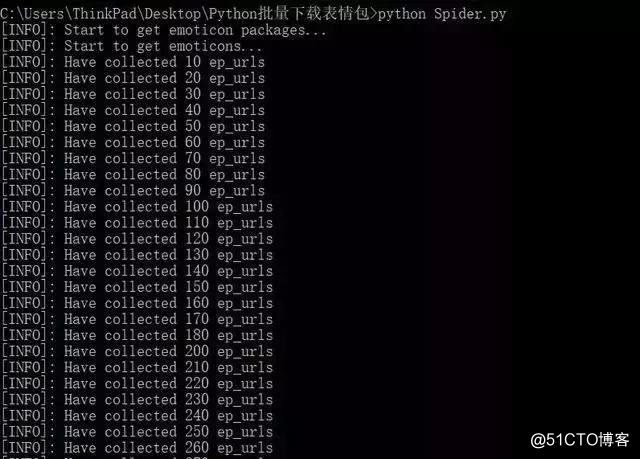

在cmd窗口運行"Spider.py"文件即可。

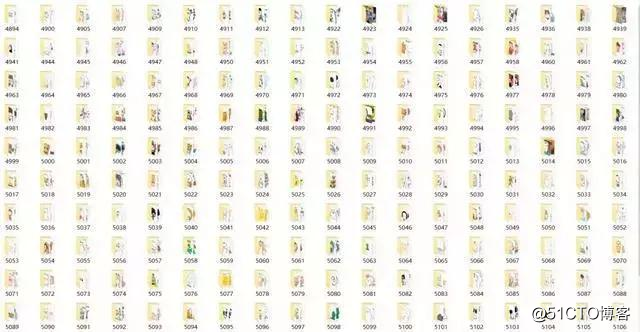

效果截圖:

好了,如果你跟我一樣都喜歡python,想成為一名優秀的程序員,也在學習python的道路上奔跑,歡迎你加入python學習群:839383765 群內每天都會分享最新業內資料,分享python免費課程,共同交流學習,讓學習變(編)成(程)一種習慣!

自從會了Python在群裏鬥圖就沒輸過,Python批量下載表情包!