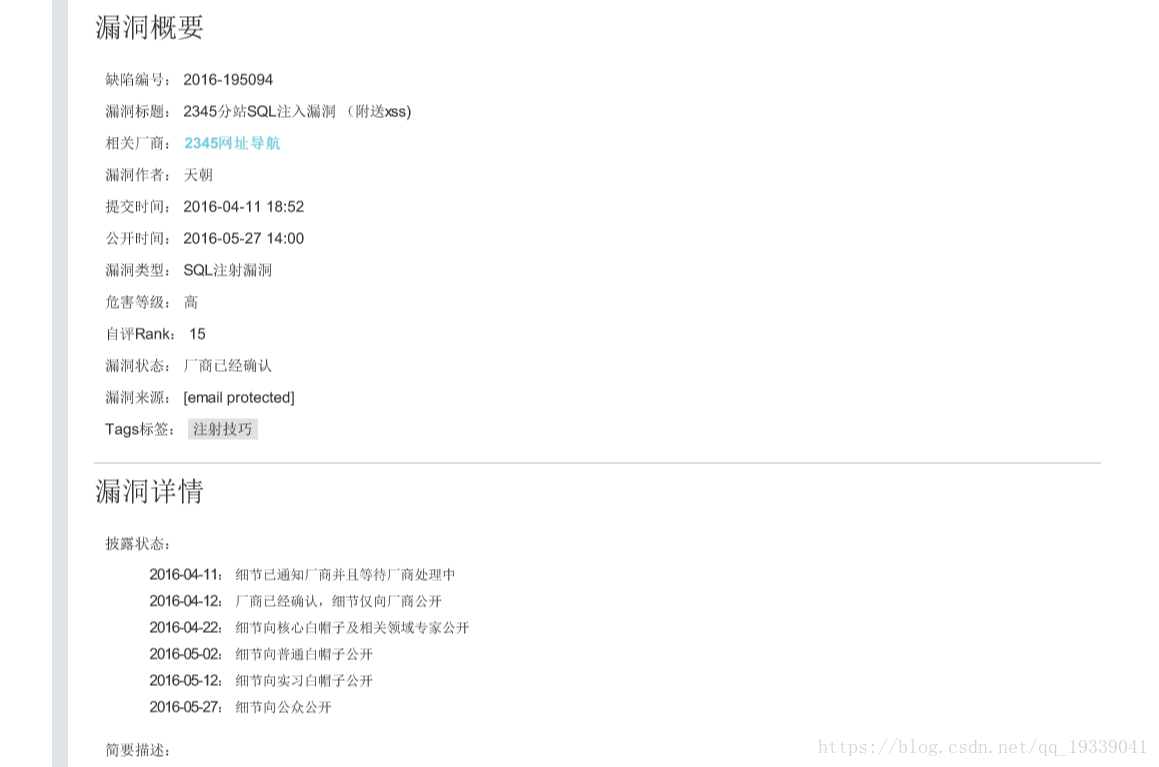

爬取某網站的所有烏雲漏洞文章,儲存為pdf檔案

阿新 • • 發佈:2019-01-29

鼎鼎大名的烏雲,存在了6年左右,就停擺了,真是可惜。。。

這是從某個網站看到的烏雲文章,爬取儲存下來以作學習使用

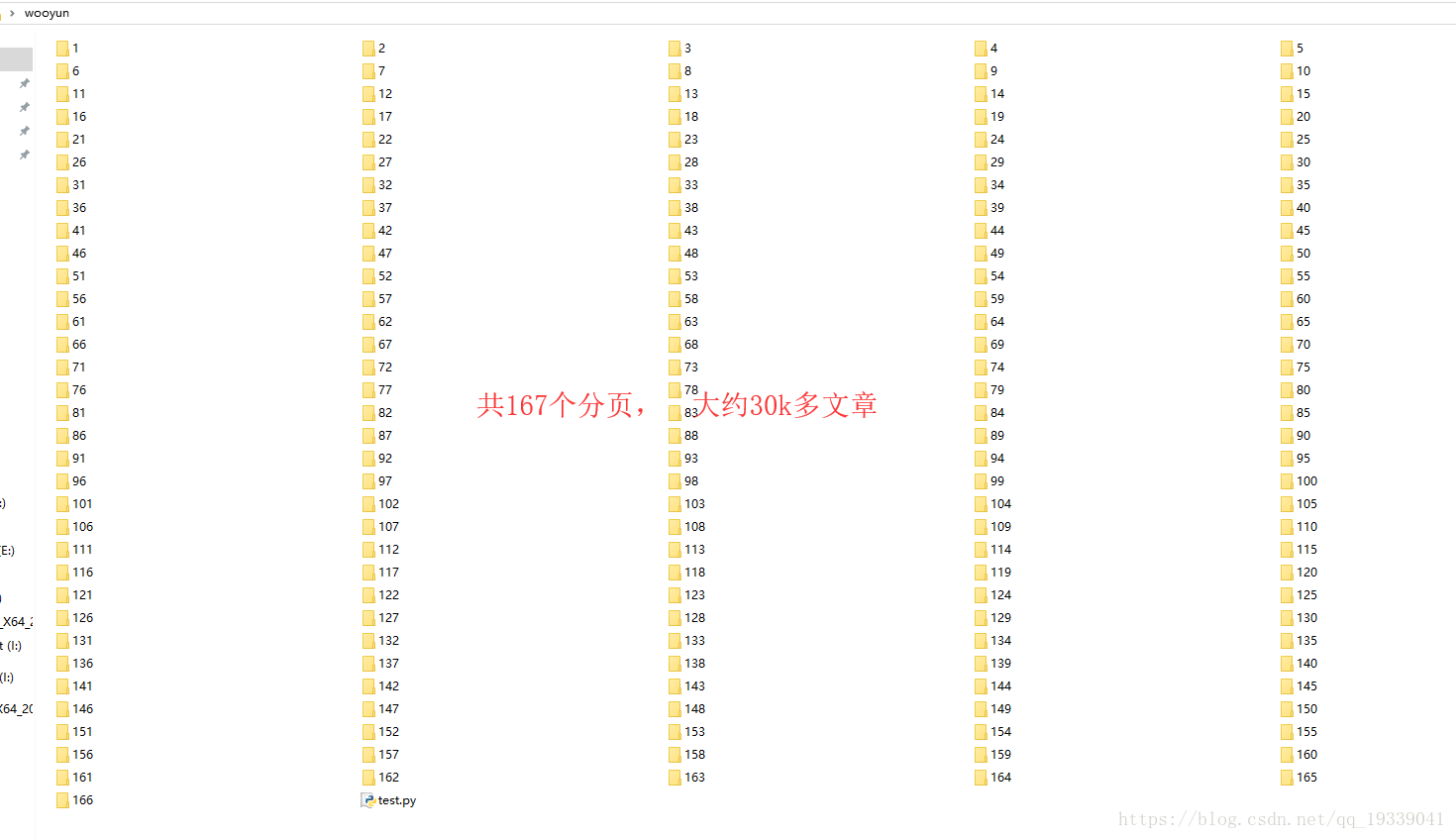

建立一個資料夾wooyun,把下面的程式碼儲存到一個檔案如test.py,放在該檔案裡面

# -*- coding: utf-8 -*-

import urllib2

import pdfkit

from lxml import etree

import time

import random

import os

import shutil

def modify_filename(file1,file2,filename,m):

'''

更改檔名函式

如有多個同名檔案,自動在檔名末尾加上數字,從2開始。

方法遞迴

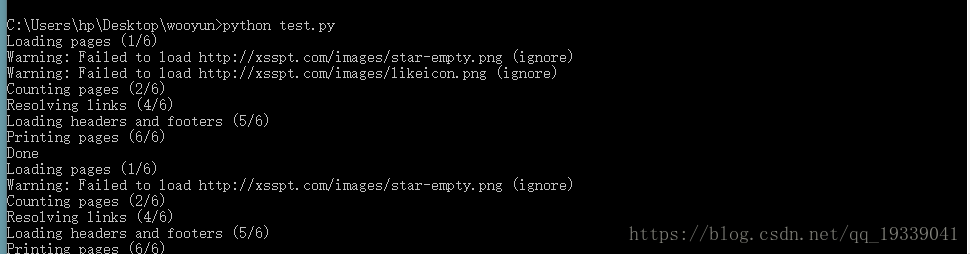

''' 結果如下: