Hadoop上傳檔案到hdfs中

阿新 • • 發佈:2019-01-30

hadoop常見指令:

hdfs dfs -copyFromLocal /local/data /hdfs/data:將本地檔案上傳到 hdfs 上(原路徑只能是一個檔案)

hdfs dfs -put /tmp/ /hdfs/ :和 copyFromLocal 區別是,put 原路徑可以是資料夾等

hadoop fs -ls / :檢視根目錄檔案

hadoop fs -ls /tmp/data:檢視/tmp/data目錄

hadoop fs -cat /tmp/a.txt :檢視 a.txt,與 -text 一樣

hadoop fs -mkdir dir:建立目錄dir

hadoop fs -rmr dir:刪除目錄dir

出現 Call From master to localhost:9000 failed on connection exception…..的錯誤:

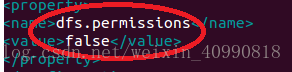

原因沒有開啟許可權:修改 /hadoop/etc/hadoop/hdfs.site.xml

找到dfs.permissions屬性修改為false(預設為true)OK了

出現hdfs.DFSClient: DataStreamer Exception的問題:

原因:在進行namenode格式化時多次造成那麼spaceID不一致。

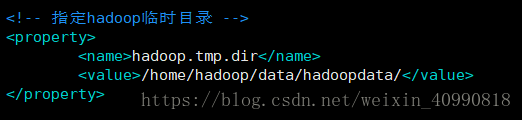

1.刪除core.site.xml中臨時檔案指定的目錄

2.重新進行格式化

hadoop name -formate

3.啟動叢集

start-all.sh

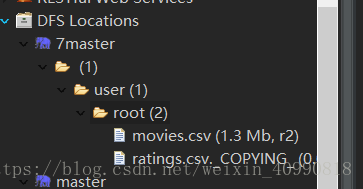

4.創造目錄

hadoop fs -mkdir /user

hadoop fs -mkdir /user/root

5上傳檔案

hdfs dfs -put movie.csv /user/root/