DL學習筆記【22】增強學習(Reinforcement Learning)

阿新 • • 發佈:2019-01-30

據說瞭解增強學習首先要了解馬爾可夫性

馬爾可夫性

在已知目前狀態(現在)的條件下,它未來的演變(將來)不依賴於它以往的演變 (過去 )

馬爾可夫過程按照其狀態和時間引數是否連續或者離散分為三種:

- 時間和狀態都離散的叫做馬爾科夫鏈

- 時間和狀態都是連續的叫做馬爾科夫過程

- 時間連續,狀態離散的叫做連續時間的馬爾科夫鏈。

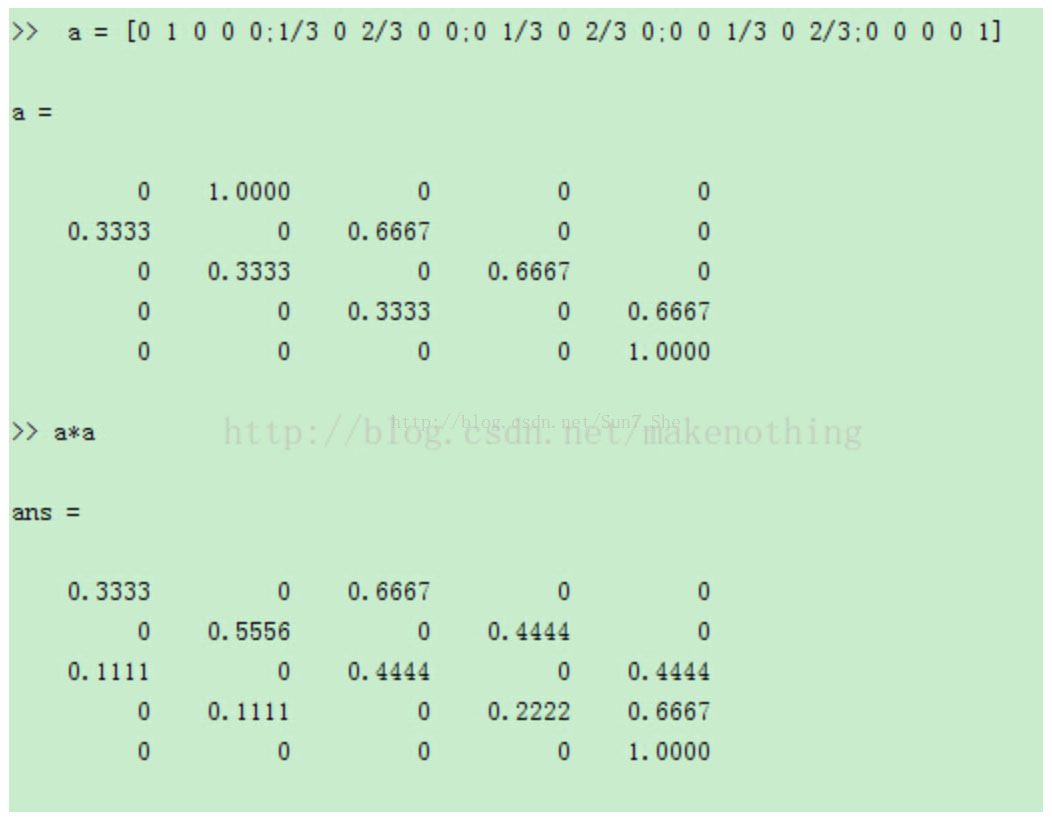

N步轉移概率矩陣:

P(n)=P(n-1)P(1)=P(n-2)P(1)P(1)=......=P(1)^n

從一個狀態經過n步到達其他狀態的概率可以表示為矩陣形式,例如:

隱馬爾可夫模型

三個骰子,分別為4面6面8面,根據1~8序列(可見狀態),可以推測出使用的骰子序列(隱含序列)。

- 直接相乘 —求產生序列的最大概率

- 破解骰子序列,從第一個開始算,找最大概率的,然後算第二個,依次向後(這是向前演算法),根據最後一個狀態,依次推出前邊的(這是向後演算法)—用於計算產生這個序列的所有可能情況的概率和

- 維特比演算法 —用於計算產生可見狀態的最有可能的隱含狀態序列

- Baum-Welch 演算法 —太複雜,沒看

增強學習

下邊兩個教程很棒,先記錄一下,自己的理解之後會補上。

epsilon greed

http://blog.csdn.net/zjq2008wd/article/details/52860654

Q演算法

http://blog.csdn.net/zjq2008wd/article/details/52767692

神經網路和增強學習

http://www.cnblogs.com/Leo_wl/p/5852010.html